通知设置 新通知

tushare 中的ts.get_stock_basics() 函数总是超时 返回不到结果的原因

李魔佛 发表了文章 • 0 个评论 • 18023 次浏览 • 2017-04-17 18:30

ts.get_stock_basics()

不过经常会出现: self.base=ts.get_stock_basics()

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out这样的问题。

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:pip install tushare --upgrade

查看全部

import tushare as ts

ts.get_stock_basics()

不过经常会出现:

self.base=ts.get_stock_basics()这样的问题。

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:

pip install tushare --upgrade

中国各个省份/直辖市拥有的上市公司数目 附python代码

李魔佛 发表了文章 • 0 个评论 • 6360 次浏览 • 2017-04-16 02:25

下面通过代码来统计这个数据, 其实很简单,用python只需几行代码就能够实现

def count_area():

base=ts.get_stock_basics()

count=base['area'].value_counts()

#这一句的意思,就是获取所有股票的上市地区的数据,然后计算出现的次数

print count

print type(count)

得出的是以下的数据:

浙江 360

江苏 337

北京 289

广东 267

上海 251

深圳 242

山东 176

福建 116

四川 110

安徽 98

湖北 95

湖南 91

河南 76

辽宁 75

河北 54

新疆 50

天津 46

陕西 46

重庆 45

吉林 42

山西 38

江西 37

广西 36

黑龙江 35

云南 32

甘肃 31

海南 29

内蒙 25

贵州 23

西藏 14

宁夏 12

青海 11

从数据来看,数量最多的是江浙一带(因为深圳从广东省的数据中分离出去了)。

这个也从正面反映每个地方的经济繁荣程度。 查看全部

下面通过代码来统计这个数据, 其实很简单,用python只需几行代码就能够实现

def count_area():

base=ts.get_stock_basics()

count=base['area'].value_counts()

#这一句的意思,就是获取所有股票的上市地区的数据,然后计算出现的次数

print count

print type(count)

得出的是以下的数据:

浙江 360

江苏 337

北京 289

广东 267

上海 251

深圳 242

山东 176

福建 116

四川 110

安徽 98

湖北 95

湖南 91

河南 76

辽宁 75

河北 54

新疆 50

天津 46

陕西 46

重庆 45

吉林 42

山西 38

江西 37

广西 36

黑龙江 35

云南 32

甘肃 31

海南 29

内蒙 25

贵州 23

西藏 14

宁夏 12

青海 11

从数据来看,数量最多的是江浙一带(因为深圳从广东省的数据中分离出去了)。

这个也从正面反映每个地方的经济繁荣程度。

mac os x python安装matplotlib 库 出错: Operation not permitted

低调的哥哥 发表了文章 • 0 个评论 • 8507 次浏览 • 2017-04-15 23:19

The directory '/Users/rocky/Library/Caches/pip/http' or its parent directory is not owned by the current user and the cache has been disabled. Please check the permissions and owner of that directory. If executing pip with sudo, you may want sudo's -H flag.

The directory '/Users/rocky/Library/Caches/pip' or its parent directory is not owned by the current user and caching wheels has been disabled. check the permissions and owner of that directory. If executing pip with sudo, you may want sudo's -H flag.

Requirement already satisfied: matplotlib in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python

Requirement already satisfied: numpy>=1.5 in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Requirement already satisfied: python-dateutil in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Collecting tornado (from matplotlib)

Downloading tornado-4.4.3.tar.gz (463kB)

100% |████████████████████████████████| 471kB 84kB/s

Requirement already satisfied: pyparsing>=1.5.6 in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Collecting nose (from matplotlib)

Downloading nose-1.3.7-py2-none-any.whl (154kB)

100% |████████████████████████████████| 163kB 75kB/s

Collecting singledispatch (from tornado->matplotlib)

Downloading singledispatch-3.4.0.3-py2.py3-none-any.whl

Collecting certifi (from tornado->matplotlib)

Downloading certifi-2017.1.23-py2.py3-none-any.whl (382kB)

100% |████████████████████████████████| 389kB 105kB/s

Collecting backports_abc>=0.4 (from tornado->matplotlib)

Downloading backports_abc-0.5-py2.py3-none-any.whl

Requirement already satisfied: six in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from singledispatch->tornado->matplotlib)

Installing collected packages: singledispatch, certifi, backports-abc, tornado, nose

Running setup.py install for tornado ... done

Exception:

Traceback (most recent call last):

File "/Library/Python/2.7/site-packages/pip/basecommand.py", line 215, in main

status = self.run(options, args)

File "/Library/Python/2.7/site-packages/pip/commands/install.py", line 342, in run

prefix=options.prefix_path,

File "/Library/Python/2.7/site-packages/pip/req/req_set.py", line 784, in install

**kwargs

File "/Library/Python/2.7/site-packages/pip/req/req_install.py", line 851, in install

self.move_wheel_files(self.source_dir, root=root, prefix=prefix)

File "/Library/Python/2.7/site-packages/pip/req/req_install.py", line 1064, in move_wheel_files

isolated=self.isolated,

File "/Library/Python/2.7/site-packages/pip/wheel.py", line 377, in move_wheel_files

clobber(source, dest, False, fixer=fixer, filter=filter)

File "/Library/Python/2.7/site-packages/pip/wheel.py", line 316, in clobber

ensure_dir(destdir)

File "/Library/Python/2.7/site-packages/pip/utils/__init__.py", line 83, in ensure_dir

os.makedirs(path)

File "/System/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/os.py", line 150, in makedirs

makedirs(head, mode)

File "/System/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/os.py", line 157, in makedirs

mkdir(name, mode)

OSError: [Errno 1] Operation not permitted: '/System/Library/Frameworks/Python.framework/Versions/2.7/man'

分析了原因后,以为权限不够,所以就把这个目录:

/Users/rocky/Library/Caches/pip/

做了提权: sudo /Users/rocky/Library/Caches/pip/

然后重新运行sudo pip install matplotlib

然后没有上面提示的错误。 然后在主程序中继续运行,结果还是出现:matplotlib模块没找到。

删除后重装,问题依然存在。

于是尝试用easy_install 安装, sudo easy_install matplotlib

等待了大概10多分钟,居然安装成功了。 因为下载的服务器比较慢,所以等待的时间就有点长了。

查看全部

Password:

The directory '/Users/rocky/Library/Caches/pip/http' or its parent directory is not owned by the current user and the cache has been disabled. Please check the permissions and owner of that directory. If executing pip with sudo, you may want sudo's -H flag.

The directory '/Users/rocky/Library/Caches/pip' or its parent directory is not owned by the current user and caching wheels has been disabled. check the permissions and owner of that directory. If executing pip with sudo, you may want sudo's -H flag.

Requirement already satisfied: matplotlib in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python

Requirement already satisfied: numpy>=1.5 in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Requirement already satisfied: python-dateutil in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Collecting tornado (from matplotlib)

Downloading tornado-4.4.3.tar.gz (463kB)

100% |████████████████████████████████| 471kB 84kB/s

Requirement already satisfied: pyparsing>=1.5.6 in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from matplotlib)

Collecting nose (from matplotlib)

Downloading nose-1.3.7-py2-none-any.whl (154kB)

100% |████████████████████████████████| 163kB 75kB/s

Collecting singledispatch (from tornado->matplotlib)

Downloading singledispatch-3.4.0.3-py2.py3-none-any.whl

Collecting certifi (from tornado->matplotlib)

Downloading certifi-2017.1.23-py2.py3-none-any.whl (382kB)

100% |████████████████████████████████| 389kB 105kB/s

Collecting backports_abc>=0.4 (from tornado->matplotlib)

Downloading backports_abc-0.5-py2.py3-none-any.whl

Requirement already satisfied: six in /System/Library/Frameworks/Python.framework/Versions/2.7/Extras/lib/python (from singledispatch->tornado->matplotlib)

Installing collected packages: singledispatch, certifi, backports-abc, tornado, nose

Running setup.py install for tornado ... done

Exception:

Traceback (most recent call last):

File "/Library/Python/2.7/site-packages/pip/basecommand.py", line 215, in main

status = self.run(options, args)

File "/Library/Python/2.7/site-packages/pip/commands/install.py", line 342, in run

prefix=options.prefix_path,

File "/Library/Python/2.7/site-packages/pip/req/req_set.py", line 784, in install

**kwargs

File "/Library/Python/2.7/site-packages/pip/req/req_install.py", line 851, in install

self.move_wheel_files(self.source_dir, root=root, prefix=prefix)

File "/Library/Python/2.7/site-packages/pip/req/req_install.py", line 1064, in move_wheel_files

isolated=self.isolated,

File "/Library/Python/2.7/site-packages/pip/wheel.py", line 377, in move_wheel_files

clobber(source, dest, False, fixer=fixer, filter=filter)

File "/Library/Python/2.7/site-packages/pip/wheel.py", line 316, in clobber

ensure_dir(destdir)

File "/Library/Python/2.7/site-packages/pip/utils/__init__.py", line 83, in ensure_dir

os.makedirs(path)

File "/System/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/os.py", line 150, in makedirs

makedirs(head, mode)

File "/System/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/os.py", line 157, in makedirs

mkdir(name, mode)

OSError: [Errno 1] Operation not permitted: '/System/Library/Frameworks/Python.framework/Versions/2.7/man'

分析了原因后,以为权限不够,所以就把这个目录:

/Users/rocky/Library/Caches/pip/

做了提权: sudo /Users/rocky/Library/Caches/pip/

然后重新运行sudo pip install matplotlib

然后没有上面提示的错误。 然后在主程序中继续运行,结果还是出现:matplotlib模块没找到。

删除后重装,问题依然存在。

于是尝试用easy_install 安装, sudo easy_install matplotlib

等待了大概10多分钟,居然安装成功了。 因为下载的服务器比较慢,所以等待的时间就有点长了。

sqlite 删除数据库中重复的行

李魔佛 发表了文章 • 0 个评论 • 4754 次浏览 • 2017-03-21 18:34

本人SQL连入门都算不上,只能用到就去查相关的函数。

经过2个小时的不懈尝试,终于结合网上各种版本的删除数据重复行(网上太多坑呀 )

写出满足自己需求的sql语句

cmd='delete from STRATEGY where rowid not in (select max(rowid) from STRATEGY group by 代码);'

就是上面的这一句语句。

下面来简单说明一下,如果是DBA大牛请忽略。

首先表名字是STRATEGY,里面记录了一些股票,买入的原因,买入时间,股票名字和代码,当前股票的价格。当前的盈亏状态。

如果一天爬取同样的数据几次,机会自动追加到db数据中。 会造成大量的重复数据。

首先从后面往前递推

select max(rowid) from STRATEGY group by 代码

这个语句 选择出来一些rowid, rowid是你创建数据库的时候默认就生产了,因为我在前面生成这个数据库的时候没有设置ID,或者index。 suo所以数据库默认用的是rowid,类似于行号。从第一行开始 rowid=1

上面就是 STRATEGY按照“代码”列进行排序, 因为有相同的,max(rowid)

查看全部

本人SQL连入门都算不上,只能用到就去查相关的函数。

经过2个小时的不懈尝试,终于结合网上各种版本的删除数据重复行(网上太多坑呀 )

写出满足自己需求的sql语句

cmd='delete from STRATEGY where rowid not in (select max(rowid) from STRATEGY group by 代码);'

就是上面的这一句语句。

下面来简单说明一下,如果是DBA大牛请忽略。

首先表名字是STRATEGY,里面记录了一些股票,买入的原因,买入时间,股票名字和代码,当前股票的价格。当前的盈亏状态。

如果一天爬取同样的数据几次,机会自动追加到db数据中。 会造成大量的重复数据。

首先从后面往前递推

select max(rowid) from STRATEGY group by 代码

这个语句 选择出来一些rowid, rowid是你创建数据库的时候默认就生产了,因为我在前面生成这个数据库的时候没有设置ID,或者index。 suo所以数据库默认用的是rowid,类似于行号。从第一行开始 rowid=1

上面就是 STRATEGY按照“代码”列进行排序, 因为有相同的,max(rowid)

《利用python进行数据分析》 学习笔记

李魔佛 发表了文章 • 0 个评论 • 5001 次浏览 • 2017-01-09 00:31

pandas的数组是没有逗号的 ['a' 'b' 'c' 'd' 'e']

r=Series([1,3,5,7,9],index=['A','B','C','D','E'])

print r

print r.index

r.reindex(['B','C''D','E','A'])

重新按照index进行排序

print r[['A','D']] #需要用两个中括号 才能正确地引用你说需要的值

字典操作:

print ‘A' in r

返回的是True或者False

可以用字典直接生成 Series

dict={"Username":"Rocky","Sex":"Male","Country":"China","Langauge":"Chinese"}

t=Series(dict)

print t

t.isnull()

判断是否为空

Series 的index可以随时就修改

t.index = ["AAA","DDD","DD","DE"]

DataFrame

默认会给你0,1,2,3,4 的index和columns

创建方法:

data = {'state': ['Ohio', 'Ohio', 'Ohio', 'Nevada', 'Nevada'], 'year': [2000, 2001, 2002, 2001, 2002],'pop': [1.5, 1.7, 3.6, 2.4, 2.9]}

df=pd.DataFrame(data)

print df

访问一整列的方法:

print df['year']

print df.year

修改整列 df[’year‘]= 2017

或者使用 Series 来赋值

为不存在的列赋值会创建出一个新列。关 键字del用于删除列

根据列 重新索引

col=["year','states','pop']

df.reindex(colunms=col)

这时会重新按照列进行索引。

当然也可以同时进行索引。

df[df>5]=0

将df中大于5的元素清零

用于行操作时,需要用ix,这也是一种重新索引的方法。

获取某一行:

df.irow(x)

获取某一列:

df.icol(x)

上面的x都是整数,按照实际的行列进行获取

修改某一个值:

df.ix[3, 'a'] = 88

排序:

sort_index() 按照字母表排序,或者 数字大小, 日期

如果想要按照列进行排列, sort_index(axis=1) 默认按照index 也就是行标进行排序。

按照某一列排序 sort_values(by="a"), 如果需要按照多列 就 使用 sort_values(by=['a','b']

文件读取与存储/数据库

pd.read_table(文件名,sep=",") 以,为分隔符读取数据。 如果文件没有标题栏,可以使用header=None来制定,就是columns的值为空。 或者手动制定一个 names=xxx

如果要制定index为某列,可以index_col=“xx”

skiprow 可以帮助跳过第几行。

合并操作:

合并列

pd.merge(df1,df2)

merge重复的的值。 默认做的是交集: inner, 并集是outer, pd.merge(df1,df2,how=outer)

df1.join(df2)

行合并:

df.append(df2[:2]) index 不会变,df的值也不变,返回的值才是append之后的值

pd.concat( [ df1, df2 ] )

index重新排序。 注意格式

排序 df.groupby("Weather") #按照某一列进行排序

weather_group=df.groupby("Weather")

返回一个列表元组: for name, group in weather_group:

weather_group.first() 返回每一组分组中第一行

weather_group.last() 返回第一组分组中的最后一行

多行排序: df.groupby(['A','B'])

记住数据是Series还是DataFrame的 !

从csv文件读入,设置index 用 pd.read_csv(filename, index_col="XXXXX")

或者new_df= df.set_index('XXXX')

利用python进行数据分析

PDF电子书完整版 百度网盘下载

http://pan.baidu.com/s/1pLm7hAb

密码:pvi4

查看全部

pandas的数组是没有逗号的 ['a' 'b' 'c' 'd' 'e']

r=Series([1,3,5,7,9],index=['A','B','C','D','E'])

print r

print r.index

r.reindex(['B','C''D','E','A'])

重新按照index进行排序

print r[['A','D']] #需要用两个中括号 才能正确地引用你说需要的值

字典操作:

print ‘A' in r

返回的是True或者False

可以用字典直接生成 Series

dict={"Username":"Rocky","Sex":"Male","Country":"China","Langauge":"Chinese"}

t=Series(dict)

print t

t.isnull()

判断是否为空

Series 的index可以随时就修改

t.index = ["AAA","DDD","DD","DE"]

DataFrame

默认会给你0,1,2,3,4 的index和columns

创建方法:

data = {'state': ['Ohio', 'Ohio', 'Ohio', 'Nevada', 'Nevada'], 'year': [2000, 2001, 2002, 2001, 2002],'pop': [1.5, 1.7, 3.6, 2.4, 2.9]}

df=pd.DataFrame(data)

print df

访问一整列的方法:

print df['year']

print df.year

修改整列 df[’year‘]= 2017

或者使用 Series 来赋值

为不存在的列赋值会创建出一个新列。关 键字del用于删除列

根据列 重新索引

col=["year','states','pop']

df.reindex(colunms=col)

这时会重新按照列进行索引。

当然也可以同时进行索引。

df[df>5]=0

将df中大于5的元素清零

用于行操作时,需要用ix,这也是一种重新索引的方法。

获取某一行:

df.irow(x)

获取某一列:

df.icol(x)

上面的x都是整数,按照实际的行列进行获取

修改某一个值:

df.ix[3, 'a'] = 88

排序:

sort_index() 按照字母表排序,或者 数字大小, 日期

如果想要按照列进行排列, sort_index(axis=1) 默认按照index 也就是行标进行排序。

按照某一列排序 sort_values(by="a"), 如果需要按照多列 就 使用 sort_values(by=['a','b']

文件读取与存储/数据库

pd.read_table(文件名,sep=",") 以,为分隔符读取数据。 如果文件没有标题栏,可以使用header=None来制定,就是columns的值为空。 或者手动制定一个 names=xxx

如果要制定index为某列,可以index_col=“xx”

skiprow 可以帮助跳过第几行。

合并操作:

合并列

pd.merge(df1,df2)

merge重复的的值。 默认做的是交集: inner, 并集是outer, pd.merge(df1,df2,how=outer)

df1.join(df2)

行合并:

df.append(df2[:2]) index 不会变,df的值也不变,返回的值才是append之后的值

pd.concat( [ df1, df2 ] )

index重新排序。 注意格式

排序 df.groupby("Weather") #按照某一列进行排序

weather_group=df.groupby("Weather")

返回一个列表元组: for name, group in weather_group:

weather_group.first() 返回每一组分组中第一行

weather_group.last() 返回第一组分组中的最后一行

多行排序: df.groupby(['A','B'])

记住数据是Series还是DataFrame的 !

从csv文件读入,设置index 用 pd.read_csv(filename, index_col="XXXXX")

或者new_df= df.set_index('XXXX')

利用python进行数据分析

PDF电子书完整版 百度网盘下载

http://pan.baidu.com/s/1pLm7hAb

密码:pvi4

dataframe按照条件删除行

李魔佛 发表了文章 • 0 个评论 • 10724 次浏览 • 2016-09-22 01:51

filename=self.today+'.xls'

filename=os.path.join(os.getcwd(),filename)

if not os.path.exists(filename):

self.df_today_all=ts.get_today_all()

#过滤停牌的

self.df_today_all.drop(self.df_today_all[self.df_today_all['turnoverratio']==0].index,inplace=True)

#实测可用,删除的方法

#n1=self.df_today_all[self.df_today_all['turnoverratio']==0]

#n2=self.df_today_all.drop(n1.index)

#print n2

print self.df_today_all

self.df_today_all.to_excel(filename)

else:

self.df_today_all=pd.read_excel(filename)

print self.df_today_all 查看全部

filename=self.today+'.xls'

filename=os.path.join(os.getcwd(),filename)

if not os.path.exists(filename):

self.df_today_all=ts.get_today_all()

#过滤停牌的

self.df_today_all.drop(self.df_today_all[self.df_today_all['turnoverratio']==0].index,inplace=True)

#实测可用,删除的方法

#n1=self.df_today_all[self.df_today_all['turnoverratio']==0]

#n2=self.df_today_all.drop(n1.index)

#print n2

print self.df_today_all

self.df_today_all.to_excel(filename)

else:

self.df_today_all=pd.read_excel(filename)

print self.df_today_all

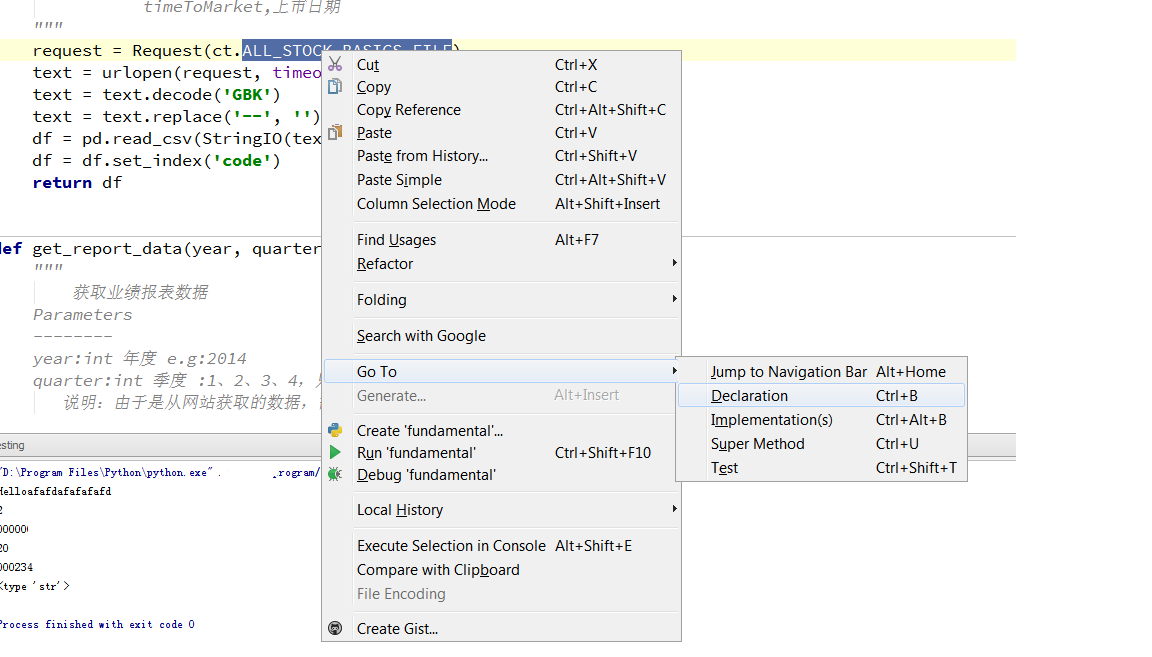

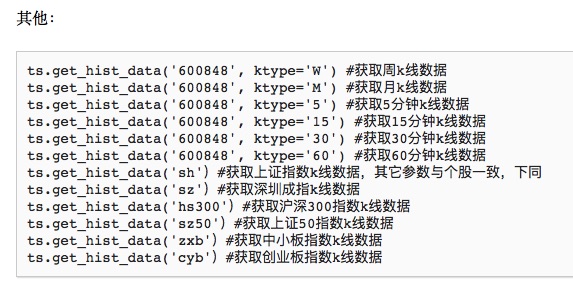

tushare 源码分析 之 fundamental.py

李魔佛 发表了文章 • 0 个评论 • 14573 次浏览 • 2016-07-22 08:56

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

import tushare as ts那么我们来看看get_stock_basics函数的实现。

df=ts.get_stock_basics()

def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。

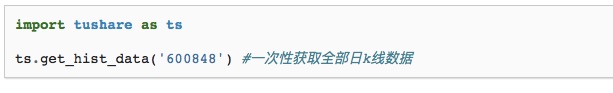

30天学会量化交易模型 Day02

李魔佛 发表了文章 • 0 个评论 • 20944 次浏览 • 2016-05-17 16:30

30天学会量化交易模型 Day01

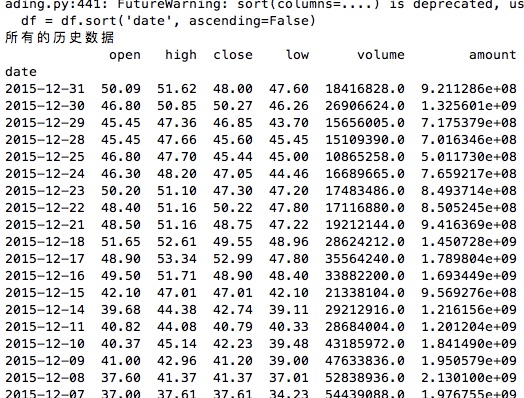

接着上一篇,如果已经掌握了pandas数据类型的各种使用,就可以进入tushare数据的抓取环节。

tushare安装教程:

pip install tushare #最傻瓜且最快的安装方式

使用方法:

说明:

获取个股历史交易数据(包括均线数据),可以通过参数设置获取日k线、周k线、月k线,以及5分钟、15分钟、30分钟和60分钟k线数据。本接口只能获取近3年的日线数据,适合搭配均线数据进行选股和分析,如果需要全部历史数据,请调用下一个接口get_h_data()。

参数说明:

code:股票代码,即6位数字代码,或者指数代码(sh=上证指数 sz=深圳成指 hs300=沪深300指数 sz50=上证50 zxb=中小板 cyb=创业板)

start:开始日期,格式YYYY-MM-DD

end:结束日期,格式YYYY-MM-DD

ktype:数据类型,D=日k线 W=周 M=月 5=5分钟 15=15分钟 30=30分钟 60=60分钟,默认为D

retry_count:当网络异常后重试次数,默认为3

pause:重试时停顿秒数,默认为0

返回值说明:

date:日期

open:开盘价

high:最高价

close:收盘价

low:最低价

volume:成交量

price_change:价格变动

p_change:涨跌幅

ma5:5日均价

ma10:10日均价

ma20:20日均价

v_ma5:5日均量

v_ma10:10日均量

v_ma20:20日均量

turnover:换手率[注:指数无此项]

如果要获取所有的历史数据,可以使用 ts.get_h_data(股票代码,开始日期,结束日期) 即可。

ts.get_hist_data('600848',start='2015-01-05',end='2015-01-09')

其它的一些参数:

接着学习数据的存储:

首先来扫一下盲: csv和excel的区别:

excel中后缀为csv和xls,二者区别如下:

1、xls 文件就是Microsoft excel电子表格的文件格式。

2、csv是最通用的一种文件格式,它可以非常容易地被导入各种PC表格及数据库中。 此文件,一行即为数据表的一行。生成数据表字段用半角逗号隔开。

csv是文本文件,用记事本就能打开,XLS是二进制的文件只有用EXCEL才能打

csv文件是以逗号为分隔符号,将各字段列分离出的一种ASCII文件。

csv(*.csv) 文件格式只能保存活动工作表中的单元格所显示的文本和数值。工作表中所有的数据行和字符都将保存。

数据列以逗号分隔,每一行数据都以回车符结束。如果单元格中包含逗号,则该单元格中的内容以双引号引起。

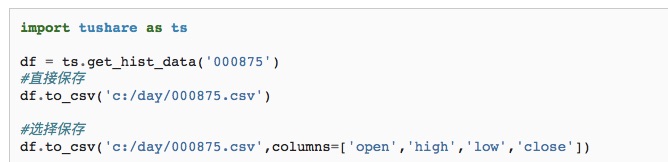

保存为csv格式

############################

获取股市市场的基本信息:

stock_info=ts.get_stock_basics()

包含了

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

获取所有股市的代码:

stock_info=ts.get_stock_basics()

def get_all_stock_id():

#获取所有股票代码

for i in stock_info.index:

print i

下一篇:30天学会量化交易模型 Day03

链接:http://30daydo.com/article/15

查看全部

30天学会量化交易模型 Day01

接着上一篇,如果已经掌握了pandas数据类型的各种使用,就可以进入tushare数据的抓取环节。

tushare安装教程:

pip install tushare #最傻瓜且最快的安装方式

使用方法:

说明:

获取个股历史交易数据(包括均线数据),可以通过参数设置获取日k线、周k线、月k线,以及5分钟、15分钟、30分钟和60分钟k线数据。本接口只能获取近3年的日线数据,适合搭配均线数据进行选股和分析,如果需要全部历史数据,请调用下一个接口get_h_data()。

参数说明:

code:股票代码,即6位数字代码,或者指数代码(sh=上证指数 sz=深圳成指 hs300=沪深300指数 sz50=上证50 zxb=中小板 cyb=创业板)

start:开始日期,格式YYYY-MM-DD

end:结束日期,格式YYYY-MM-DD

ktype:数据类型,D=日k线 W=周 M=月 5=5分钟 15=15分钟 30=30分钟 60=60分钟,默认为D

retry_count:当网络异常后重试次数,默认为3

pause:重试时停顿秒数,默认为0

返回值说明:

date:日期

open:开盘价

high:最高价

close:收盘价

low:最低价

volume:成交量

price_change:价格变动

p_change:涨跌幅

ma5:5日均价

ma10:10日均价

ma20:20日均价

v_ma5:5日均量

v_ma10:10日均量

v_ma20:20日均量

turnover:换手率[注:指数无此项]

如果要获取所有的历史数据,可以使用 ts.get_h_data(股票代码,开始日期,结束日期) 即可。

ts.get_hist_data('600848',start='2015-01-05',end='2015-01-09')

其它的一些参数:

接着学习数据的存储:

首先来扫一下盲: csv和excel的区别:

excel中后缀为csv和xls,二者区别如下:

1、xls 文件就是Microsoft excel电子表格的文件格式。

2、csv是最通用的一种文件格式,它可以非常容易地被导入各种PC表格及数据库中。 此文件,一行即为数据表的一行。生成数据表字段用半角逗号隔开。

csv是文本文件,用记事本就能打开,XLS是二进制的文件只有用EXCEL才能打

csv文件是以逗号为分隔符号,将各字段列分离出的一种ASCII文件。

csv(*.csv) 文件格式只能保存活动工作表中的单元格所显示的文本和数值。工作表中所有的数据行和字符都将保存。

数据列以逗号分隔,每一行数据都以回车符结束。如果单元格中包含逗号,则该单元格中的内容以双引号引起。

保存为csv格式

############################

获取股市市场的基本信息:

stock_info=ts.get_stock_basics()

包含了

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

获取所有股市的代码:

stock_info=ts.get_stock_basics()

def get_all_stock_id():

#获取所有股票代码

for i in stock_info.index:

print i

下一篇:30天学会量化交易模型 Day03

链接:http://30daydo.com/article/15