tushare

tushare 中的ts.get_stock_basics() 函数总是超时 返回不到结果的原因

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 19131 次浏览 • 2017-04-17 18:30

调用的方法:import tushare as ts

ts.get_stock_basics()

不过经常会出现: self.base=ts.get_stock_basics()

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out这样的问题。

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:pip install tushare --upgrade

查看全部

ts.get_stock_basics()

不过经常会出现: self.base=ts.get_stock_basics()

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out这样的问题。

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:pip install tushare --upgrade

查看全部

调用的方法:

不过经常会出现:

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:

import tushare as ts

ts.get_stock_basics()

不过经常会出现:

self.base=ts.get_stock_basics()这样的问题。

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:

pip install tushare --upgrade

tushare 源码分析 之 fundamental.py

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 16046 次浏览 • 2016-07-22 08:56

python的tushare用来做数据分析是一个不错的工具。

下面来具体看看里面的一些具体的函数是怎么实现的。

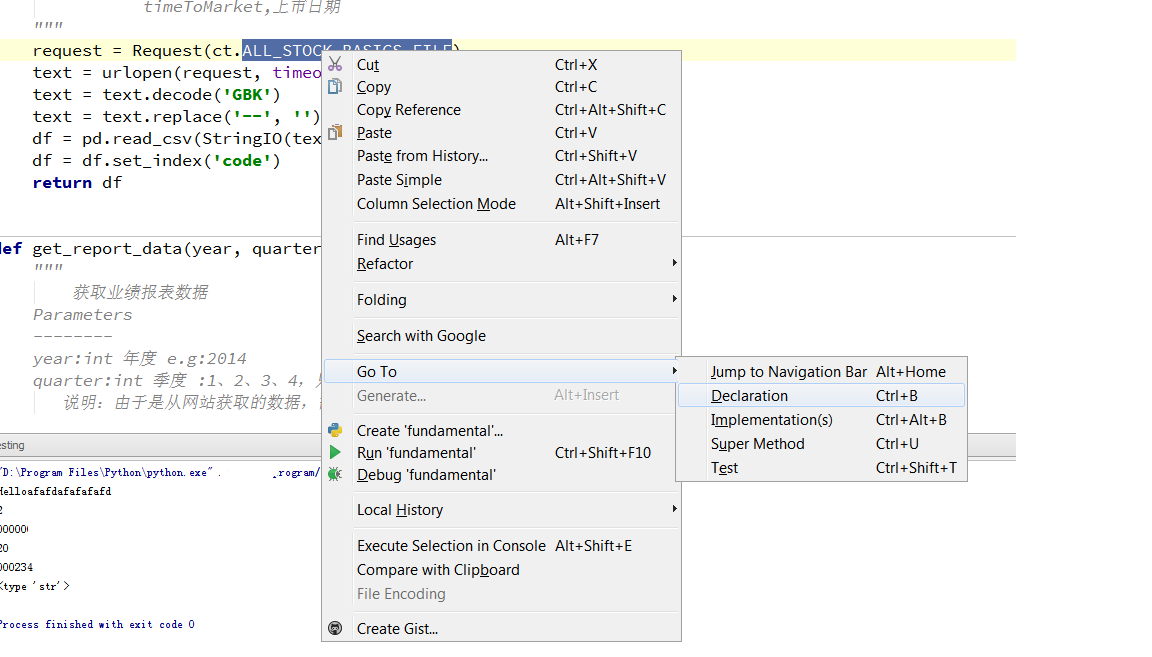

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

python的tushare用来做数据分析是一个不错的工具。

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

import tushare as ts那么我们来看看get_stock_basics函数的实现。

df=ts.get_stock_basics()

def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。

tushare 中的ts.get_stock_basics() 函数总是超时 返回不到结果的原因

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 19131 次浏览 • 2017-04-17 18:30

调用的方法:import tushare as ts

ts.get_stock_basics()

不过经常会出现: self.base=ts.get_stock_basics()

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out这样的问题。

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:pip install tushare --upgrade

查看全部

ts.get_stock_basics()

不过经常会出现: self.base=ts.get_stock_basics()

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out这样的问题。

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:pip install tushare --upgrade

查看全部

调用的方法:

不过经常会出现:

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:

import tushare as ts

ts.get_stock_basics()

不过经常会出现:

self.base=ts.get_stock_basics()这样的问题。

File "C:\Python27\lib\site-packages\tushare\stock\fundamental.py", line 44, in get_stock_basics

text = urlopen(request, timeout=10).read()

File "C:\Python27\lib\socket.py", line 351, in read

data = self._sock.recv(rbufsize)

File "C:\Python27\lib\httplib.py", line 567, in read

s = self.fp.read(amt)

File "C:\Python27\lib\socket.py", line 380, in read

data = self._sock.recv(left)

socket.timeout: timed out

这个是因为tushare的作者把get_stock_basics()的信息文件保存在他自己的服务器。

这一点可以翻看源码就知道。 地址为: http://218.244.146.57/static/all.csv

估计作者用的一般的服务器,所以一旦数据请求多了,你的IP也被服务器当做是DDOS攻击,屏蔽掉你的请求了。

所以如果你平时需要频繁调用这个函数,不如把这个文件下载到本地,然后使用函数 df=pd.read_csv('all.csv')

来得到你想要数据,这样一来,程序不会因为经常超时而中断,而且本地读取文件的数据很快。 这样会节约不少的时间。

在最新的tushare这个问题得到了解决。已经换一个数据源了。

PS:好多小问题都可以通过更新最新的tushare版本来得到解决。

升级命令:

pip install tushare --upgrade

tushare 源码分析 之 fundamental.py

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 16046 次浏览 • 2016-07-22 08:56

python的tushare用来做数据分析是一个不错的工具。

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

python的tushare用来做数据分析是一个不错的工具。

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

import tushare as ts那么我们来看看get_stock_basics函数的实现。

df=ts.get_stock_basics()

def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。