python爬虫

知识星球获取文章链接与数据

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 2929 次浏览 • 2022-03-21 20:15

既然官方不提供这个功能,只能自己使用爬虫手段获取了,额。

既然官方不提供这个功能,只能自己使用爬虫手段获取了,额。

如何使用控制台将动态加载数据刷新出来啊????

python • 低调的哥哥 回复了问题 • 2 人关注 • 1 个回复 • 3748 次浏览 • 2021-08-11 02:06

为什么登录成功但是爬取不到其他数据

python爬虫 • 低调的哥哥 回复了问题 • 2 人关注 • 1 个回复 • 3877 次浏览 • 2021-08-04 01:17

韦世东 python3网络爬虫宝典 勘误

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 3677 次浏览 • 2021-05-21 20:06

1. 时间差是正数才是过期

2. 获取权限那里,permission = args[0].permission

不能后面再用get

P222:

写入mongodb后,原来的数据会被加入一个_id,值为OjectId,该值是无法被json dumps为string,

所以需要手工把ObjectId 转为str,或者del message['_id'] 将这个键去除。

查看全部

1. 时间差是正数才是过期

2. 获取权限那里,permission = args[0].permission

不能后面再用get

P222:

写入mongodb后,原来的数据会被加入一个_id,值为OjectId,该值是无法被json dumps为string,

所以需要手工把ObjectId 转为str,或者del message['_id'] 将这个键去除。

茅台抢购程序 京东 苏宁

python • 李魔佛 发表了文章 • 0 个评论 • 13091 次浏览 • 2021-01-05 22:34

运行环境 windows,linux,mac,python3+

京东小白分查询:

https://plus.m.jd.com/rights/windControl

分太低的就不要参与了,毕竟概率会小很多

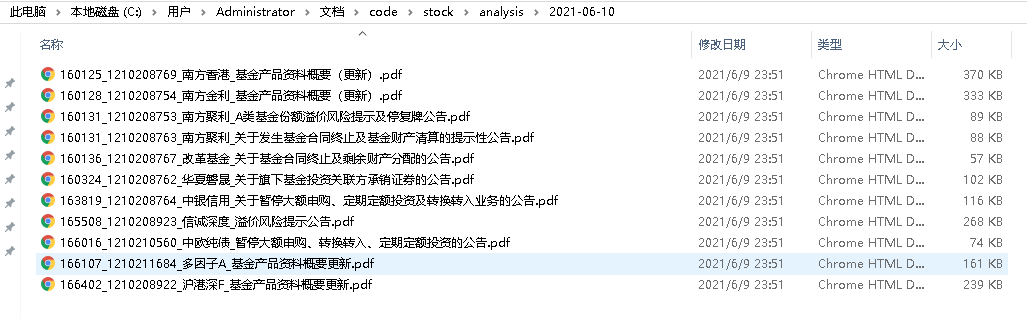

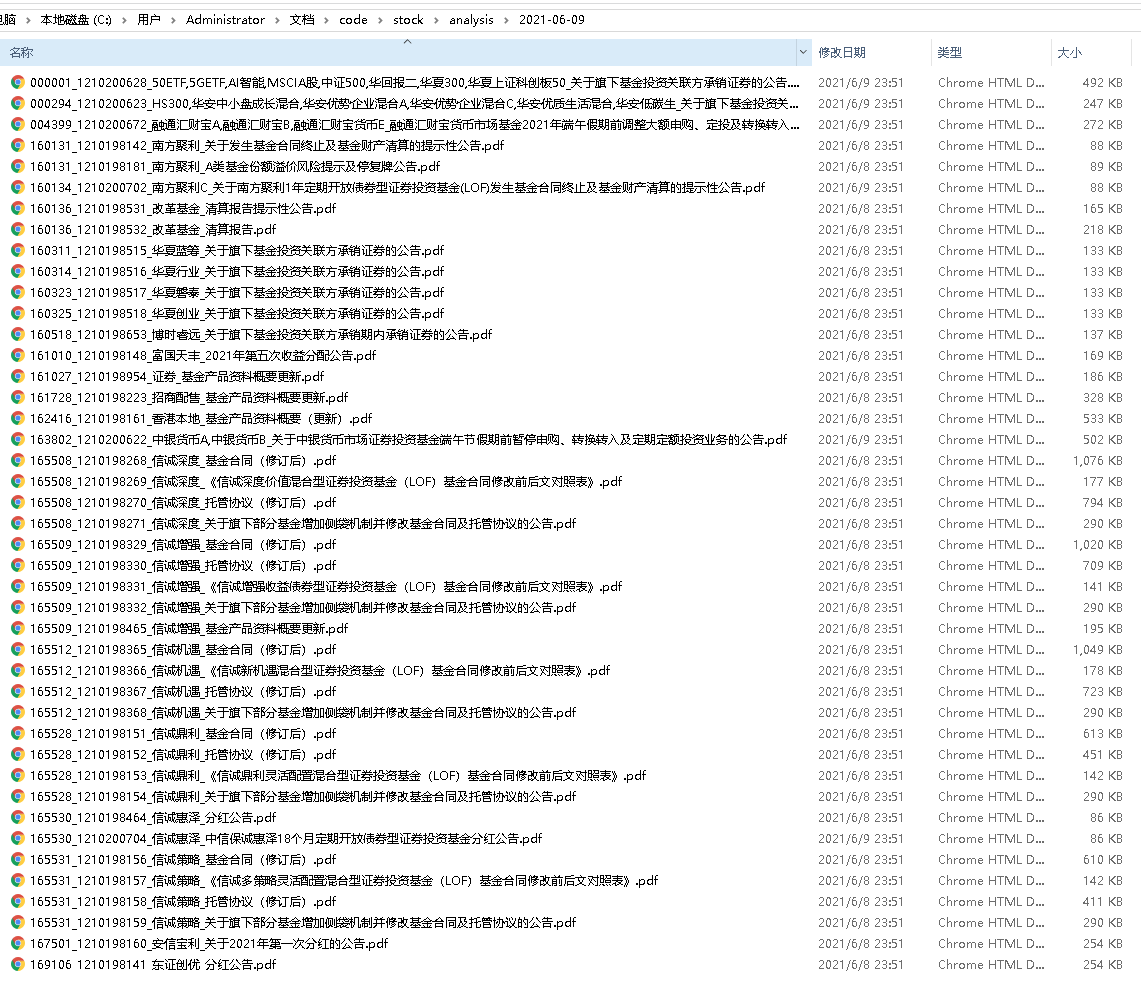

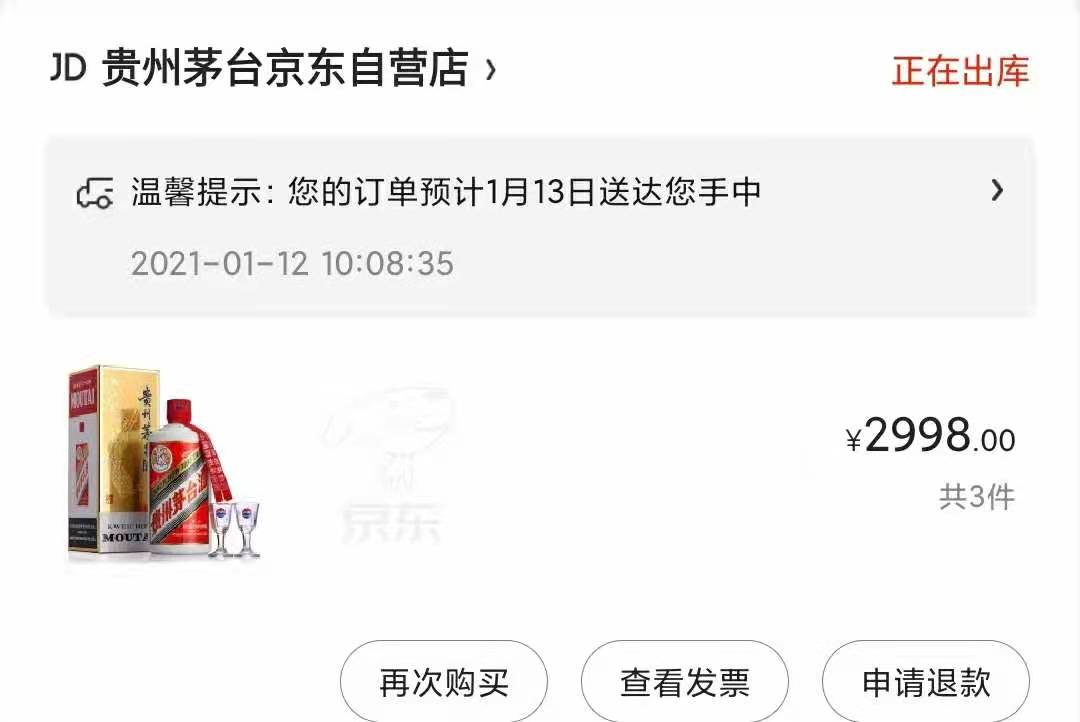

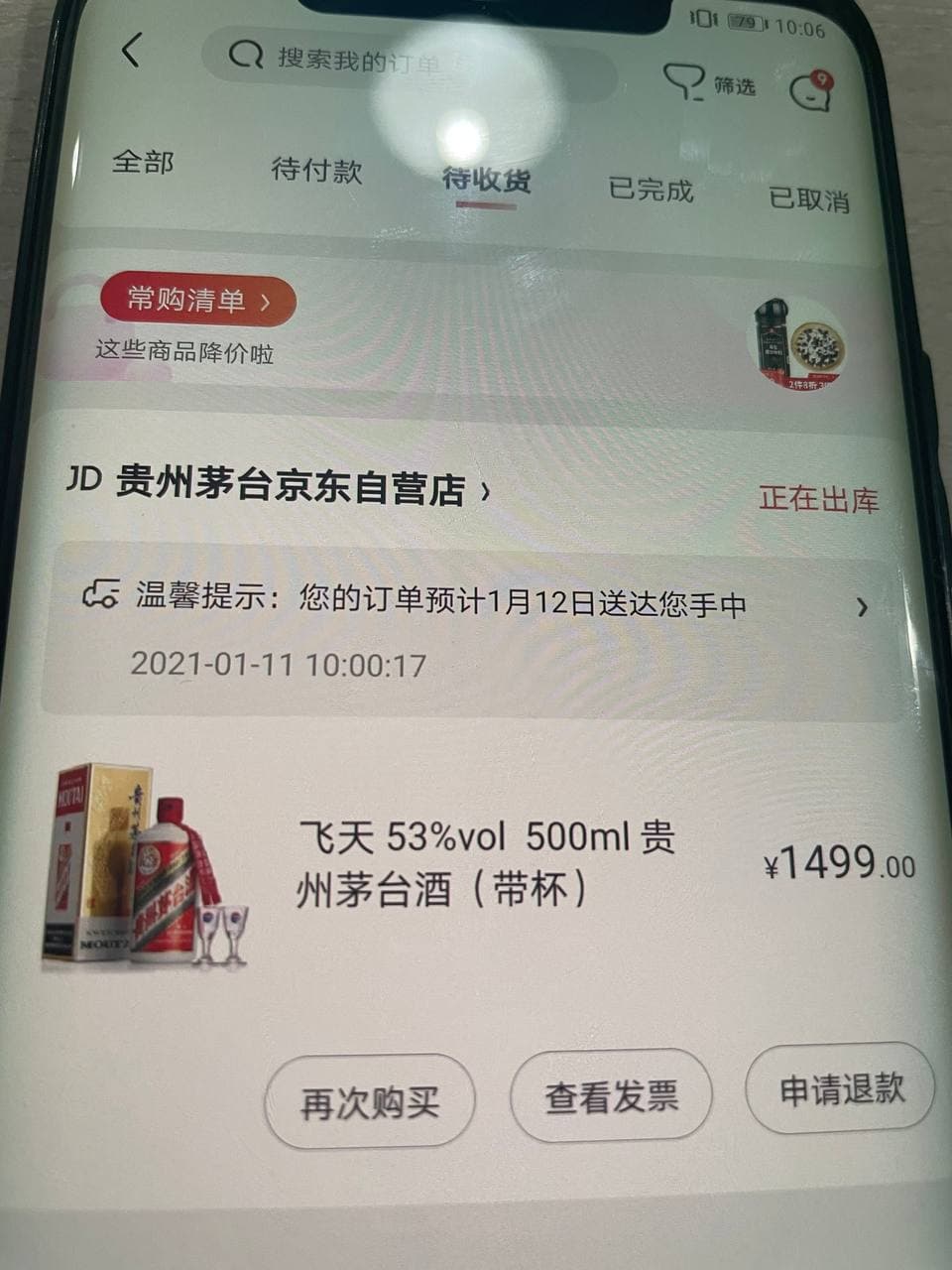

############ 2021-01-13 更新 ======

最新的用Go重写的,搞了几瓶

苏宁家的:

============= 2021-01-11 更新 ============

感觉苏宁的抢购是耍猴的,那个按钮基本处于不可点状态,所以就放弃了,感觉官方就是没放多少量,加上苏宁公司过往的尿性,所以洗洗睡了

main.pyimport sys

from maotai.jd_spider_requests import ProdectPurchase

if __name__ == '__main__':

tip = """

功能列表:

1.预约商品

2.秒杀抢购商品

"""

print(tip)

product = ProdectPurchase()

choice_function = input('请选择:')

if choice_function == '1':

product.reserve()

elif choice_function == '2':

product.seckill_by_proc_pool()

else:

print('没有此功能')

sys.exit(1)

jd_spider_requests.pyimport random

import time

import requests

import functools

import json

import os

import pickle

from lxml import etree

from error.exception import SKException

from maotai.jd_logger import logger

from maotai.timer import Timer

from maotai.config import global_config

from concurrent.futures import ProcessPoolExecutor

from helper.jd_helper import (

parse_json,

send_wechat,

wait_some_time,

response_status,

save_image,

open_image

)

class SpiderSession:

"""

Session相关操作

"""

def __init__(self):

self.cookies_dir_path = "./cookies/"

self.user_agent = global_config.getRaw('config', 'DEFAULT_USER_AGENT')

self.session = self._init_session()

def _init_session(self):

session = requests.session()

session.headers = self.get_headers()

return session

def get_headers(self):

return {"User-Agent": self.user_agent,

"Accept": "text/html,application/xhtml+xml,application/xml;"

"q=0.9,image/webp,image/apng,*/*;"

"q=0.8,application/signed-exchange;"

"v=b3",

"Connection": "keep-alive"}

def get_user_agent(self):

return self.user_agent

def get_session(self):

"""

获取当前Session

:return:

"""

return self.session

def get_cookies(self):

"""

获取当前Cookies

:return:

"""

return self.get_session().cookies

def set_cookies(self, cookies):

self.session.cookies.update(cookies)

def load_cookies_from_local(self):

"""

从本地加载Cookie

:return:

"""

cookies_file = ''

if not os.path.exists(self.cookies_dir_path):

return False

for name in os.listdir(self.cookies_dir_path):

if name.endswith(".cookies"):

cookies_file = '{}{}'.format(self.cookies_dir_path, name)

break

if cookies_file == '':

return False

with open(cookies_file, 'rb') as f:

local_cookies = pickle.load(f)

self.set_cookies(local_cookies)

def save_cookies_to_local(self, cookie_file_name):

"""

保存Cookie到本地

:param cookie_file_name: 存放Cookie的文件名称

:return:

"""

cookies_file = '{}{}.cookies'.format(self.cookies_dir_path, cookie_file_name)

directory = os.path.dirname(cookies_file)

if not os.path.exists(directory):

os.makedirs(directory)

with open(cookies_file, 'wb') as f:

pickle.dump(self.get_cookies(), f)

class QrLogin:

"""

扫码登录

"""

def __init__(self, spider_session: SpiderSession):

"""

初始化扫码登录

大致流程:

1、访问登录二维码页面,获取Token

2、使用Token获取票据

3、校验票据

:param spider_session:

"""

self.qrcode_img_file = 'qr_code.png'

self.spider_session = spider_session

self.session = self.spider_session.get_session()

self.is_login = False

self.refresh_login_status()

def refresh_login_status(self):

"""

刷新是否登录状态

:return:

"""

self.is_login = self._validate_cookies()

def _validate_cookies(self):

"""

验证cookies是否有效(是否登陆)

通过访问用户订单列表页进行判断:若未登录,将会重定向到登陆页面。

:return: cookies是否有效 True/False

"""

url = 'https://order.jd.com/center/list.action'

payload = {

'rid': str(int(time.time() * 1000)),

}

try:

resp = self.session.get(url=url, params=payload, allow_redirects=False)

if resp.status_code == requests.codes.OK:

return True

except Exception as e:

logger.error("验证cookies是否有效发生异常", e)

return False

def _get_login_page(self):

"""

获取PC端登录页面

阻塞,更新cookies

:return:

"""

url = "https://passport.jd.com/new/login.aspx"

page = self.session.get(url, headers=self.spider_session.get_headers())

return page

def _get_qrcode(self):

"""

缓存并展示登录二维码

:return:

"""

url = 'https://qr.m.jd.com/show'

payload = {

'appid': 133,

'size': 147,

't': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/new/login.aspx',

}

resp = self.session.get(url=url, headers=headers, params=payload)

if not response_status(resp):

logger.info('获取二维码失败')

return False

save_image(resp, self.qrcode_img_file)

logger.info('二维码获取成功,请打开京东APP扫描')

open_image(self.qrcode_img_file)

return True

def _get_qrcode_ticket(self):

"""

通过 token 获取票据 ticket

:return:

"""

url = 'https://qr.m.jd.com/check'

payload = {

'appid': '133',

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'token': self.session.cookies.get('wlfstk_smdl'), # 从cookies获取值

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/new/login.aspx',

}

resp = self.session.get(url=url, headers=headers, params=payload)

if not response_status(resp):

logger.error('获取二维码扫描结果异常')

return False

resp_json = parse_json(resp.text)

if resp_json['code'] != 200:

logger.info('Code: %s, Message: %s', resp_json['code'], resp_json['msg'])

return None

else:

logger.info('已完成手机客户端确认')

return resp_json['ticket']

def _validate_qrcode_ticket(self, ticket):

"""

通过已获取的票据进行校验

:param ticket: 已获取的票据

:return:

"""

url = 'https://passport.jd.com/uc/qrCodeTicketValidation'

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/uc/login?ltype=logout',

}

resp = self.session.get(url=url, headers=headers, params={'t': ticket})

if not response_status(resp):

return False

resp_json = json.loads(resp.text)

if resp_json['returnCode'] == 0:

return True

else:

logger.info(resp_json)

return False

def login_by_qrcode(self):

"""

二维码登陆

:return:

"""

self._get_login_page() # 更新cookies

# download QR code

if not self._get_qrcode():

raise SKException('二维码下载失败')

# get QR code ticket

ticket = None

retry_times = 85

for _ in range(retry_times):

# 重试 拿到ticket

ticket = self._get_qrcode_ticket()

if ticket:

break

time.sleep(2)

else:

raise SKException('二维码过期,请重新获取扫描')

# validate QR code ticket

if not self._validate_qrcode_ticket(ticket):

raise SKException('二维码信息校验失败')

self.refresh_login_status()

logger.info('二维码登录成功')

class ProdectPurchase(object):

def __init__(self):

self.spider_session = SpiderSession()

self.spider_session.load_cookies_from_local()

# 共享一个session

self.qrlogin = QrLogin(self.spider_session)

# 初始化信息

self.sku_id = global_config.getRaw('config', 'sku_id')

self.seckill_num = global_config.getRaw('config', 'seckill_num')

self.work_count = global_config.getRaw('config','process_num')

self.seckill_init_info = dict()

self.seckill_url = dict()

self.seckill_order_data = dict()

self.timers = Timer()

self.session = self.spider_session.get_session()

self.user_agent = self.spider_session.user_agent

self.nick_name = None

def login_by_qrcode(self):

"""

二维码登陆

:return:

"""

if self.qrlogin.is_login:

logger.info('登录成功')

return

self.qrlogin.login_by_qrcode()

if self.qrlogin.is_login:

self.nick_name = self.get_username()

self.spider_session.save_cookies_to_local(self.nick_name)

else:

raise SKException("二维码登录失败!")

def check_login(func):

"""

用户登陆态校验装饰器。若用户未登陆,则调用扫码登陆

"""

@functools.wraps(func)

def new_func(self, *args, **kwargs):

if not self.qrlogin.is_login:

logger.info("{0} 需登陆后调用,开始扫码登陆".format(func.__name__))

self.login_by_qrcode()

return func(self, *args, **kwargs)

return new_func

@check_login

def reserve(self):

"""

预约

"""

self._reserve()

@check_login

def seckill(self):

"""

抢购

"""

self._seckill()

@check_login

def seckill_by_proc_pool(self):

"""

多进程进行抢购

work_count:进程数量

"""

with ProcessPoolExecutor() as pool:

for i in range(self.work_count):

pool.submit(self.seckill)

def _reserve(self):

"""

预约

"""

while True:

try:

self.make_reserve()

break

except Exception as e:

logger.info('预约发生异常!', e)

wait_some_time()

def _seckill(self):

"""

抢购

"""

while True:

try:

self.request_seckill_url()

while True:

self.request_seckill_checkout_page()

self.submit_seckill_order()

except Exception as e:

logger.info('抢购发生异常,稍后继续执行!', e)

wait_some_time()

def make_reserve(self):

"""商品预约"""

logger.info('商品名称:{}'.format(self.get_sku_title()))

url = 'https://yushou.jd.com/youshouinfo.action?'

payload = {

'callback': 'fetchJSON',

'sku': self.sku_id,

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

resp = self.session.get(url=url, params=payload, headers=headers)

resp_json = parse_json(resp.text)

reserve_url = resp_json.get('url')

# self.timers.start()

while True:

try:

self.session.get(url='https:' + reserve_url)

logger.info('预约成功,已获得抢购资格 / 您已成功预约过了,无需重复预约')

if global_config.getRaw('messenger', 'enable') == 'true':

success_message = "预约成功,已获得抢购资格 / 您已成功预约过了,无需重复预约"

send_wechat(success_message)

break

except Exception as e:

logger.error('预约失败正在重试...')

def get_username(self):

"""获取用户信息"""

url = 'https://passport.jd.com/user/petName/getUserInfoForMiniJd.action'

payload = {

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Referer': 'https://order.jd.com/center/list.action',

}

resp = self.session.get(url=url, params=payload, headers=headers)

try_count = 5

while not resp.text.startswith("jQuery"):

try_count = try_count - 1

if try_count > 0:

resp = self.session.get(url=url, params=payload, headers=headers)

else:

break

wait_some_time()

# 响应中包含了许多用户信息,现在在其中返回昵称

# jQuery2381773({"imgUrl":"//storage.360buyimg.com/i.imageUpload/xxx.jpg","lastLoginTime":"","nickName":"xxx","plusStatus":"0","realName":"xxx","userLevel":x,"userScoreVO":{"accountScore":xx,"activityScore":xx,"consumptionScore":xxxxx,"default":false,"financeScore":xxx,"pin":"xxx","riskScore":x,"totalScore":xxxxx}})

return parse_json(resp.text).get('nickName')

def get_sku_title(self):

"""获取商品名称"""

url = 'https://item.jd.com/{}.html'.format(global_config.getRaw('config', 'sku_id'))

resp = self.session.get(url).content

x_data = etree.HTML(resp)

sku_title = x_data.xpath('/html/head/title/text()')

return sku_title[0]

def get_seckill_url(self):

"""获取商品的抢购链接

点击"抢购"按钮后,会有两次302跳转,最后到达订单结算页面

这里返回第一次跳转后的页面url,作为商品的抢购链接

:return: 商品的抢购链接

"""

url = 'https://itemko.jd.com/itemShowBtn'

payload = {

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'skuId': self.sku_id,

'from': 'pc',

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Host': 'itemko.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

while True:

resp = self.session.get(url=url, headers=headers, params=payload)

resp_json = parse_json(resp.text)

if resp_json.get('url'):

# https://divide.jd.com/user_rou ... %3Dpc

router_url = 'https:' + resp_json.get('url')

# https://marathon.jd.com/captch ... %3Dpc

seckill_url = router_url.replace(

'divide', 'marathon').replace(

'user_routing', 'captcha.html')

logger.info("抢购链接获取成功: %s", seckill_url)

return seckill_url

else:

logger.info("抢购链接获取失败,稍后自动重试")

wait_some_time()

def request_seckill_url(self):

"""访问商品的抢购链接(用于设置cookie等"""

logger.info('用户:{}'.format(self.get_username()))

logger.info('商品名称:{}'.format(self.get_sku_title()))

self.timers.start() # 阻塞

self.seckill_url[self.sku_id] = self.get_seckill_url()

logger.info('访问商品的抢购连接...')

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

self.session.get(

url=self.seckill_url.get(

self.sku_id),

headers=headers,

allow_redirects=False)

def request_seckill_checkout_page(self):

"""访问抢购订单结算页面"""

logger.info('访问抢购订单结算页面...')

url = 'https://marathon.jd.com/seckill/seckill.action'

payload = {

'skuId': self.sku_id,

'num': self.seckill_num,

'rid': int(time.time())

}

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

self.session.get(url=url, params=payload, headers=headers, allow_redirects=False)

def _get_seckill_init_info(self):

"""获取秒杀初始化信息(包括:地址,发票,token)

:return: 初始化信息组成的dict

"""

logger.info('获取秒杀初始化信息...')

url = 'https://marathon.jd.com/seckillnew/orderService/pc/init.action'

data = {

'sku': self.sku_id,

'num': self.seckill_num,

'isModifyAddress': 'false',

}

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

}

resp = self.session.post(url=url, data=data, headers=headers)

resp_json = None

try:

resp_json = parse_json(resp.text)

except Exception:

raise SKException('抢购失败,返回信息:{}'.format(resp.text[0: 128]))

return resp_json

def _get_seckill_order_data(self):

"""生成提交抢购订单所需的请求体参数

:return: 请求体参数组成的dict

"""

logger.info('生成提交抢购订单所需参数...')

# 获取用户秒杀初始化信息

self.seckill_init_info[self.sku_id] = self._get_seckill_init_info()

init_info = self.seckill_init_info.get(self.sku_id)

default_address = init_info['addressList'][0] # 默认地址dict

invoice_info = init_info.get('invoiceInfo', {}) # 默认发票信息dict, 有可能不返回

token = init_info['token']

data = {

'skuId': self.sku_id,

'num': self.seckill_num,

'addressId': default_address['id'],

'yuShou': 'true',

'isModifyAddress': 'false',

'name': default_address['name'],

'provinceId': default_address['provinceId'],

'cityId': default_address['cityId'],

'countyId': default_address['countyId'],

'townId': default_address['townId'],

'addressDetail': default_address['addressDetail'],

'mobile': default_address['mobile'],

'mobileKey': default_address['mobileKey'],

'email': default_address.get('email', ''),

'postCode': '',

'invoiceTitle': invoice_info.get('invoiceTitle', -1),

'invoiceCompanyName': '',

'invoiceContent': invoice_info.get('invoiceContentType', 1),

'invoiceTaxpayerNO': '',

'invoiceEmail': '',

'invoicePhone': invoice_info.get('invoicePhone', ''),

'invoicePhoneKey': invoice_info.get('invoicePhoneKey', ''),

'invoice': 'true' if invoice_info else 'false',

'password': global_config.get('account', 'payment_pwd'),

'codTimeType': 3,

'paymentType': 4,

'areaCode': '',

'overseas': 0,

'phone': '',

'eid': global_config.getRaw('config', 'eid'),

'fp': global_config.getRaw('config', 'fp'),

'token': token,

'pru': ''

}

return data

def submit_seckill_order(self):

"""提交抢购(秒杀)订单

:return: 抢购结果 True/False

"""

url = 'https://marathon.jd.com/seckillnew/orderService/pc/submitOrder.action'

payload = {

'skuId': self.sku_id,

}

try:

self.seckill_order_data[self.sku_id] = self._get_seckill_order_data()

except Exception as e:

logger.info('抢购失败,无法获取生成订单的基本信息,接口返回:【{}】'.format(str(e)))

return False

logger.info('提交抢购订单...')

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://marathon.jd.com/seckill/seckill.action?skuId={0}&num={1}&rid={2}'.format(

self.sku_id, self.seckill_num, int(time.time())),

}

resp = self.session.post(

url=url,

params=payload,

data=self.seckill_order_data.get(

self.sku_id),

headers=headers)

resp_json = None

try:

resp_json = parse_json(resp.text)

except Exception as e:

logger.info('抢购失败,返回信息:{}'.format(resp.text[0: 128]))

return False

# 返回信息

# 抢购失败:

# {'errorMessage': '很遗憾没有抢到,再接再厉哦。', 'orderId': 0, 'resultCode': 60074, 'skuId': 0, 'success': False}

# {'errorMessage': '抱歉,您提交过快,请稍后再提交订单!', 'orderId': 0, 'resultCode': 60017, 'skuId': 0, 'success': False}

# {'errorMessage': '系统正在开小差,请重试~~', 'orderId': 0, 'resultCode': 90013, 'skuId': 0, 'success': False}

# 抢购成功:

# {"appUrl":"xxxxx","orderId":820227xxxxx,"pcUrl":"xxxxx","resultCode":0,"skuId":0,"success":true,"totalMoney":"xxxxx"}

if resp_json.get('success'):

order_id = resp_json.get('orderId')

total_money = resp_json.get('totalMoney')

pay_url = 'https:' + resp_json.get('pcUrl')

logger.info('抢购成功,订单号:{}, 总价:{}, 电脑端付款链接:{}'.format(order_id, total_money, pay_url))

if global_config.getRaw('messenger', 'enable') == 'true':

success_message = "抢购成功,订单号:{}, 总价:{}, 电脑端付款链接:{}".format(order_id, total_money, pay_url)

send_wechat(success_message)

return True

else:

logger.info('抢购失败,返回信息:{}'.format(resp_json))

if global_config.getRaw('messenger', 'enable') == 'true':

error_message = '抢购失败,返回信息:{}'.format(resp_json)

send_wechat(error_message)

return False

苏宁脚本目前在测试途中,需要继续调试。

原创文章,

转载请注明:http://30daydo.com/article/44129

欢迎关注公众号:

可转债量化分析

查看全部

运行环境 windows,linux,mac,python3+

京东小白分查询:

https://plus.m.jd.com/rights/windControl

分太低的就不要参与了,毕竟概率会小很多

############ 2021-01-13 更新 ======

最新的用Go重写的,搞了几瓶

苏宁家的:

============= 2021-01-11 更新 ============

感觉苏宁的抢购是耍猴的,那个按钮基本处于不可点状态,所以就放弃了,感觉官方就是没放多少量,加上苏宁公司过往的尿性,所以洗洗睡了

main.py

import sys

from maotai.jd_spider_requests import ProdectPurchase

if __name__ == '__main__':

tip = """

功能列表:

1.预约商品

2.秒杀抢购商品

"""

print(tip)

product = ProdectPurchase()

choice_function = input('请选择:')

if choice_function == '1':

product.reserve()

elif choice_function == '2':

product.seckill_by_proc_pool()

else:

print('没有此功能')

sys.exit(1)

jd_spider_requests.py

import random

import time

import requests

import functools

import json

import os

import pickle

from lxml import etree

from error.exception import SKException

from maotai.jd_logger import logger

from maotai.timer import Timer

from maotai.config import global_config

from concurrent.futures import ProcessPoolExecutor

from helper.jd_helper import (

parse_json,

send_wechat,

wait_some_time,

response_status,

save_image,

open_image

)

class SpiderSession:

"""

Session相关操作

"""

def __init__(self):

self.cookies_dir_path = "./cookies/"

self.user_agent = global_config.getRaw('config', 'DEFAULT_USER_AGENT')

self.session = self._init_session()

def _init_session(self):

session = requests.session()

session.headers = self.get_headers()

return session

def get_headers(self):

return {"User-Agent": self.user_agent,

"Accept": "text/html,application/xhtml+xml,application/xml;"

"q=0.9,image/webp,image/apng,*/*;"

"q=0.8,application/signed-exchange;"

"v=b3",

"Connection": "keep-alive"}

def get_user_agent(self):

return self.user_agent

def get_session(self):

"""

获取当前Session

:return:

"""

return self.session

def get_cookies(self):

"""

获取当前Cookies

:return:

"""

return self.get_session().cookies

def set_cookies(self, cookies):

self.session.cookies.update(cookies)

def load_cookies_from_local(self):

"""

从本地加载Cookie

:return:

"""

cookies_file = ''

if not os.path.exists(self.cookies_dir_path):

return False

for name in os.listdir(self.cookies_dir_path):

if name.endswith(".cookies"):

cookies_file = '{}{}'.format(self.cookies_dir_path, name)

break

if cookies_file == '':

return False

with open(cookies_file, 'rb') as f:

local_cookies = pickle.load(f)

self.set_cookies(local_cookies)

def save_cookies_to_local(self, cookie_file_name):

"""

保存Cookie到本地

:param cookie_file_name: 存放Cookie的文件名称

:return:

"""

cookies_file = '{}{}.cookies'.format(self.cookies_dir_path, cookie_file_name)

directory = os.path.dirname(cookies_file)

if not os.path.exists(directory):

os.makedirs(directory)

with open(cookies_file, 'wb') as f:

pickle.dump(self.get_cookies(), f)

class QrLogin:

"""

扫码登录

"""

def __init__(self, spider_session: SpiderSession):

"""

初始化扫码登录

大致流程:

1、访问登录二维码页面,获取Token

2、使用Token获取票据

3、校验票据

:param spider_session:

"""

self.qrcode_img_file = 'qr_code.png'

self.spider_session = spider_session

self.session = self.spider_session.get_session()

self.is_login = False

self.refresh_login_status()

def refresh_login_status(self):

"""

刷新是否登录状态

:return:

"""

self.is_login = self._validate_cookies()

def _validate_cookies(self):

"""

验证cookies是否有效(是否登陆)

通过访问用户订单列表页进行判断:若未登录,将会重定向到登陆页面。

:return: cookies是否有效 True/False

"""

url = 'https://order.jd.com/center/list.action'

payload = {

'rid': str(int(time.time() * 1000)),

}

try:

resp = self.session.get(url=url, params=payload, allow_redirects=False)

if resp.status_code == requests.codes.OK:

return True

except Exception as e:

logger.error("验证cookies是否有效发生异常", e)

return False

def _get_login_page(self):

"""

获取PC端登录页面

阻塞,更新cookies

:return:

"""

url = "https://passport.jd.com/new/login.aspx"

page = self.session.get(url, headers=self.spider_session.get_headers())

return page

def _get_qrcode(self):

"""

缓存并展示登录二维码

:return:

"""

url = 'https://qr.m.jd.com/show'

payload = {

'appid': 133,

'size': 147,

't': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/new/login.aspx',

}

resp = self.session.get(url=url, headers=headers, params=payload)

if not response_status(resp):

logger.info('获取二维码失败')

return False

save_image(resp, self.qrcode_img_file)

logger.info('二维码获取成功,请打开京东APP扫描')

open_image(self.qrcode_img_file)

return True

def _get_qrcode_ticket(self):

"""

通过 token 获取票据 ticket

:return:

"""

url = 'https://qr.m.jd.com/check'

payload = {

'appid': '133',

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'token': self.session.cookies.get('wlfstk_smdl'), # 从cookies获取值

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/new/login.aspx',

}

resp = self.session.get(url=url, headers=headers, params=payload)

if not response_status(resp):

logger.error('获取二维码扫描结果异常')

return False

resp_json = parse_json(resp.text)

if resp_json['code'] != 200:

logger.info('Code: %s, Message: %s', resp_json['code'], resp_json['msg'])

return None

else:

logger.info('已完成手机客户端确认')

return resp_json['ticket']

def _validate_qrcode_ticket(self, ticket):

"""

通过已获取的票据进行校验

:param ticket: 已获取的票据

:return:

"""

url = 'https://passport.jd.com/uc/qrCodeTicketValidation'

headers = {

'User-Agent': self.spider_session.get_user_agent(),

'Referer': 'https://passport.jd.com/uc/login?ltype=logout',

}

resp = self.session.get(url=url, headers=headers, params={'t': ticket})

if not response_status(resp):

return False

resp_json = json.loads(resp.text)

if resp_json['returnCode'] == 0:

return True

else:

logger.info(resp_json)

return False

def login_by_qrcode(self):

"""

二维码登陆

:return:

"""

self._get_login_page() # 更新cookies

# download QR code

if not self._get_qrcode():

raise SKException('二维码下载失败')

# get QR code ticket

ticket = None

retry_times = 85

for _ in range(retry_times):

# 重试 拿到ticket

ticket = self._get_qrcode_ticket()

if ticket:

break

time.sleep(2)

else:

raise SKException('二维码过期,请重新获取扫描')

# validate QR code ticket

if not self._validate_qrcode_ticket(ticket):

raise SKException('二维码信息校验失败')

self.refresh_login_status()

logger.info('二维码登录成功')

class ProdectPurchase(object):

def __init__(self):

self.spider_session = SpiderSession()

self.spider_session.load_cookies_from_local()

# 共享一个session

self.qrlogin = QrLogin(self.spider_session)

# 初始化信息

self.sku_id = global_config.getRaw('config', 'sku_id')

self.seckill_num = global_config.getRaw('config', 'seckill_num')

self.work_count = global_config.getRaw('config','process_num')

self.seckill_init_info = dict()

self.seckill_url = dict()

self.seckill_order_data = dict()

self.timers = Timer()

self.session = self.spider_session.get_session()

self.user_agent = self.spider_session.user_agent

self.nick_name = None

def login_by_qrcode(self):

"""

二维码登陆

:return:

"""

if self.qrlogin.is_login:

logger.info('登录成功')

return

self.qrlogin.login_by_qrcode()

if self.qrlogin.is_login:

self.nick_name = self.get_username()

self.spider_session.save_cookies_to_local(self.nick_name)

else:

raise SKException("二维码登录失败!")

def check_login(func):

"""

用户登陆态校验装饰器。若用户未登陆,则调用扫码登陆

"""

@functools.wraps(func)

def new_func(self, *args, **kwargs):

if not self.qrlogin.is_login:

logger.info("{0} 需登陆后调用,开始扫码登陆".format(func.__name__))

self.login_by_qrcode()

return func(self, *args, **kwargs)

return new_func

@check_login

def reserve(self):

"""

预约

"""

self._reserve()

@check_login

def seckill(self):

"""

抢购

"""

self._seckill()

@check_login

def seckill_by_proc_pool(self):

"""

多进程进行抢购

work_count:进程数量

"""

with ProcessPoolExecutor() as pool:

for i in range(self.work_count):

pool.submit(self.seckill)

def _reserve(self):

"""

预约

"""

while True:

try:

self.make_reserve()

break

except Exception as e:

logger.info('预约发生异常!', e)

wait_some_time()

def _seckill(self):

"""

抢购

"""

while True:

try:

self.request_seckill_url()

while True:

self.request_seckill_checkout_page()

self.submit_seckill_order()

except Exception as e:

logger.info('抢购发生异常,稍后继续执行!', e)

wait_some_time()

def make_reserve(self):

"""商品预约"""

logger.info('商品名称:{}'.format(self.get_sku_title()))

url = 'https://yushou.jd.com/youshouinfo.action?'

payload = {

'callback': 'fetchJSON',

'sku': self.sku_id,

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

resp = self.session.get(url=url, params=payload, headers=headers)

resp_json = parse_json(resp.text)

reserve_url = resp_json.get('url')

# self.timers.start()

while True:

try:

self.session.get(url='https:' + reserve_url)

logger.info('预约成功,已获得抢购资格 / 您已成功预约过了,无需重复预约')

if global_config.getRaw('messenger', 'enable') == 'true':

success_message = "预约成功,已获得抢购资格 / 您已成功预约过了,无需重复预约"

send_wechat(success_message)

break

except Exception as e:

logger.error('预约失败正在重试...')

def get_username(self):

"""获取用户信息"""

url = 'https://passport.jd.com/user/petName/getUserInfoForMiniJd.action'

payload = {

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Referer': 'https://order.jd.com/center/list.action',

}

resp = self.session.get(url=url, params=payload, headers=headers)

try_count = 5

while not resp.text.startswith("jQuery"):

try_count = try_count - 1

if try_count > 0:

resp = self.session.get(url=url, params=payload, headers=headers)

else:

break

wait_some_time()

# 响应中包含了许多用户信息,现在在其中返回昵称

# jQuery2381773({"imgUrl":"//storage.360buyimg.com/i.imageUpload/xxx.jpg","lastLoginTime":"","nickName":"xxx","plusStatus":"0","realName":"xxx","userLevel":x,"userScoreVO":{"accountScore":xx,"activityScore":xx,"consumptionScore":xxxxx,"default":false,"financeScore":xxx,"pin":"xxx","riskScore":x,"totalScore":xxxxx}})

return parse_json(resp.text).get('nickName')

def get_sku_title(self):

"""获取商品名称"""

url = 'https://item.jd.com/{}.html'.format(global_config.getRaw('config', 'sku_id'))

resp = self.session.get(url).content

x_data = etree.HTML(resp)

sku_title = x_data.xpath('/html/head/title/text()')

return sku_title[0]

def get_seckill_url(self):

"""获取商品的抢购链接

点击"抢购"按钮后,会有两次302跳转,最后到达订单结算页面

这里返回第一次跳转后的页面url,作为商品的抢购链接

:return: 商品的抢购链接

"""

url = 'https://itemko.jd.com/itemShowBtn'

payload = {

'callback': 'jQuery{}'.format(random.randint(1000000, 9999999)),

'skuId': self.sku_id,

'from': 'pc',

'_': str(int(time.time() * 1000)),

}

headers = {

'User-Agent': self.user_agent,

'Host': 'itemko.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

while True:

resp = self.session.get(url=url, headers=headers, params=payload)

resp_json = parse_json(resp.text)

if resp_json.get('url'):

# https://divide.jd.com/user_rou ... %3Dpc

router_url = 'https:' + resp_json.get('url')

# https://marathon.jd.com/captch ... %3Dpc

seckill_url = router_url.replace(

'divide', 'marathon').replace(

'user_routing', 'captcha.html')

logger.info("抢购链接获取成功: %s", seckill_url)

return seckill_url

else:

logger.info("抢购链接获取失败,稍后自动重试")

wait_some_time()

def request_seckill_url(self):

"""访问商品的抢购链接(用于设置cookie等"""

logger.info('用户:{}'.format(self.get_username()))

logger.info('商品名称:{}'.format(self.get_sku_title()))

self.timers.start() # 阻塞

self.seckill_url[self.sku_id] = self.get_seckill_url()

logger.info('访问商品的抢购连接...')

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

self.session.get(

url=self.seckill_url.get(

self.sku_id),

headers=headers,

allow_redirects=False)

def request_seckill_checkout_page(self):

"""访问抢购订单结算页面"""

logger.info('访问抢购订单结算页面...')

url = 'https://marathon.jd.com/seckill/seckill.action'

payload = {

'skuId': self.sku_id,

'num': self.seckill_num,

'rid': int(time.time())

}

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://item.jd.com/{}.html'.format(self.sku_id),

}

self.session.get(url=url, params=payload, headers=headers, allow_redirects=False)

def _get_seckill_init_info(self):

"""获取秒杀初始化信息(包括:地址,发票,token)

:return: 初始化信息组成的dict

"""

logger.info('获取秒杀初始化信息...')

url = 'https://marathon.jd.com/seckillnew/orderService/pc/init.action'

data = {

'sku': self.sku_id,

'num': self.seckill_num,

'isModifyAddress': 'false',

}

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

}

resp = self.session.post(url=url, data=data, headers=headers)

resp_json = None

try:

resp_json = parse_json(resp.text)

except Exception:

raise SKException('抢购失败,返回信息:{}'.format(resp.text[0: 128]))

return resp_json

def _get_seckill_order_data(self):

"""生成提交抢购订单所需的请求体参数

:return: 请求体参数组成的dict

"""

logger.info('生成提交抢购订单所需参数...')

# 获取用户秒杀初始化信息

self.seckill_init_info[self.sku_id] = self._get_seckill_init_info()

init_info = self.seckill_init_info.get(self.sku_id)

default_address = init_info['addressList'][0] # 默认地址dict

invoice_info = init_info.get('invoiceInfo', {}) # 默认发票信息dict, 有可能不返回

token = init_info['token']

data = {

'skuId': self.sku_id,

'num': self.seckill_num,

'addressId': default_address['id'],

'yuShou': 'true',

'isModifyAddress': 'false',

'name': default_address['name'],

'provinceId': default_address['provinceId'],

'cityId': default_address['cityId'],

'countyId': default_address['countyId'],

'townId': default_address['townId'],

'addressDetail': default_address['addressDetail'],

'mobile': default_address['mobile'],

'mobileKey': default_address['mobileKey'],

'email': default_address.get('email', ''),

'postCode': '',

'invoiceTitle': invoice_info.get('invoiceTitle', -1),

'invoiceCompanyName': '',

'invoiceContent': invoice_info.get('invoiceContentType', 1),

'invoiceTaxpayerNO': '',

'invoiceEmail': '',

'invoicePhone': invoice_info.get('invoicePhone', ''),

'invoicePhoneKey': invoice_info.get('invoicePhoneKey', ''),

'invoice': 'true' if invoice_info else 'false',

'password': global_config.get('account', 'payment_pwd'),

'codTimeType': 3,

'paymentType': 4,

'areaCode': '',

'overseas': 0,

'phone': '',

'eid': global_config.getRaw('config', 'eid'),

'fp': global_config.getRaw('config', 'fp'),

'token': token,

'pru': ''

}

return data

def submit_seckill_order(self):

"""提交抢购(秒杀)订单

:return: 抢购结果 True/False

"""

url = 'https://marathon.jd.com/seckillnew/orderService/pc/submitOrder.action'

payload = {

'skuId': self.sku_id,

}

try:

self.seckill_order_data[self.sku_id] = self._get_seckill_order_data()

except Exception as e:

logger.info('抢购失败,无法获取生成订单的基本信息,接口返回:【{}】'.format(str(e)))

return False

logger.info('提交抢购订单...')

headers = {

'User-Agent': self.user_agent,

'Host': 'marathon.jd.com',

'Referer': 'https://marathon.jd.com/seckill/seckill.action?skuId={0}&num={1}&rid={2}'.format(

self.sku_id, self.seckill_num, int(time.time())),

}

resp = self.session.post(

url=url,

params=payload,

data=self.seckill_order_data.get(

self.sku_id),

headers=headers)

resp_json = None

try:

resp_json = parse_json(resp.text)

except Exception as e:

logger.info('抢购失败,返回信息:{}'.format(resp.text[0: 128]))

return False

# 返回信息

# 抢购失败:

# {'errorMessage': '很遗憾没有抢到,再接再厉哦。', 'orderId': 0, 'resultCode': 60074, 'skuId': 0, 'success': False}

# {'errorMessage': '抱歉,您提交过快,请稍后再提交订单!', 'orderId': 0, 'resultCode': 60017, 'skuId': 0, 'success': False}

# {'errorMessage': '系统正在开小差,请重试~~', 'orderId': 0, 'resultCode': 90013, 'skuId': 0, 'success': False}

# 抢购成功:

# {"appUrl":"xxxxx","orderId":820227xxxxx,"pcUrl":"xxxxx","resultCode":0,"skuId":0,"success":true,"totalMoney":"xxxxx"}

if resp_json.get('success'):

order_id = resp_json.get('orderId')

total_money = resp_json.get('totalMoney')

pay_url = 'https:' + resp_json.get('pcUrl')

logger.info('抢购成功,订单号:{}, 总价:{}, 电脑端付款链接:{}'.format(order_id, total_money, pay_url))

if global_config.getRaw('messenger', 'enable') == 'true':

success_message = "抢购成功,订单号:{}, 总价:{}, 电脑端付款链接:{}".format(order_id, total_money, pay_url)

send_wechat(success_message)

return True

else:

logger.info('抢购失败,返回信息:{}'.format(resp_json))

if global_config.getRaw('messenger', 'enable') == 'true':

error_message = '抢购失败,返回信息:{}'.format(resp_json)

send_wechat(error_message)

return False

苏宁脚本目前在测试途中,需要继续调试。

原创文章,

转载请注明:http://30daydo.com/article/44129

欢迎关注公众号:

可转债量化分析

不用一行代码 下载雪球嘉年华视频

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 4830 次浏览 • 2020-12-09 14:43

听说今年着重分享一些观念,抱着好奇心,就打算下载几部来看看。

雪球网站很简单,只要找到下载链接就可以下载了。

第一步。打开一个视频播放的页面,比如大金链的

11737544 粉丝主会场 | 巅峰对谈:金牛双子星主动VS量化

https://xueqiu.com/video/5285890810945319765

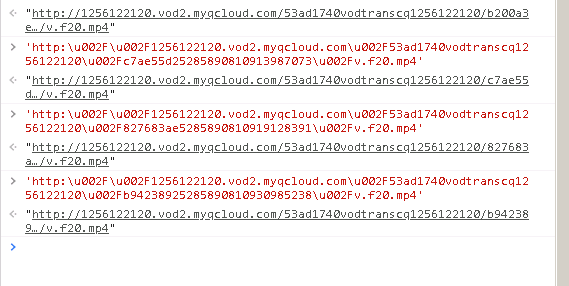

右键,查看源码,然后在源码里面试着查找 mp4,flv,webp等流媒体字样。

在这里找到一个了:

但是这个视频下载地址有很多转义字符:http:\u002F\u002F1256122120.vod2.myqcloud.com\u002F53ad1740vodtranscq1256122120\u002F17ebe5145285890810945319765\u002Fv.f20.mp4

直接在浏览器是无法直接打开的。

可以直接替换\u002f 为一个斜杠 \ 就可以了。

如果嫌麻烦,可以在浏览器里面,按下F12,在console页面里面输入上面的地址,前后加个双引号,然后回车,就可以得到完整的地址了。

原创文章,转载请注明出处

http://30daydo.com/article/44119

查看全部

听说今年着重分享一些观念,抱着好奇心,就打算下载几部来看看。

雪球网站很简单,只要找到下载链接就可以下载了。

第一步。打开一个视频播放的页面,比如大金链的

11737544 粉丝主会场 | 巅峰对谈:金牛双子星主动VS量化

https://xueqiu.com/video/5285890810945319765

右键,查看源码,然后在源码里面试着查找 mp4,flv,webp等流媒体字样。

在这里找到一个了:

但是这个视频下载地址有很多转义字符:

http:\u002F\u002F1256122120.vod2.myqcloud.com\u002F53ad1740vodtranscq1256122120\u002F17ebe5145285890810945319765\u002Fv.f20.mp4

直接在浏览器是无法直接打开的。

可以直接替换\u002f 为一个斜杠 \ 就可以了。

如果嫌麻烦,可以在浏览器里面,按下F12,在console页面里面输入上面的地址,前后加个双引号,然后回车,就可以得到完整的地址了。

原创文章,转载请注明出处

http://30daydo.com/article/44119

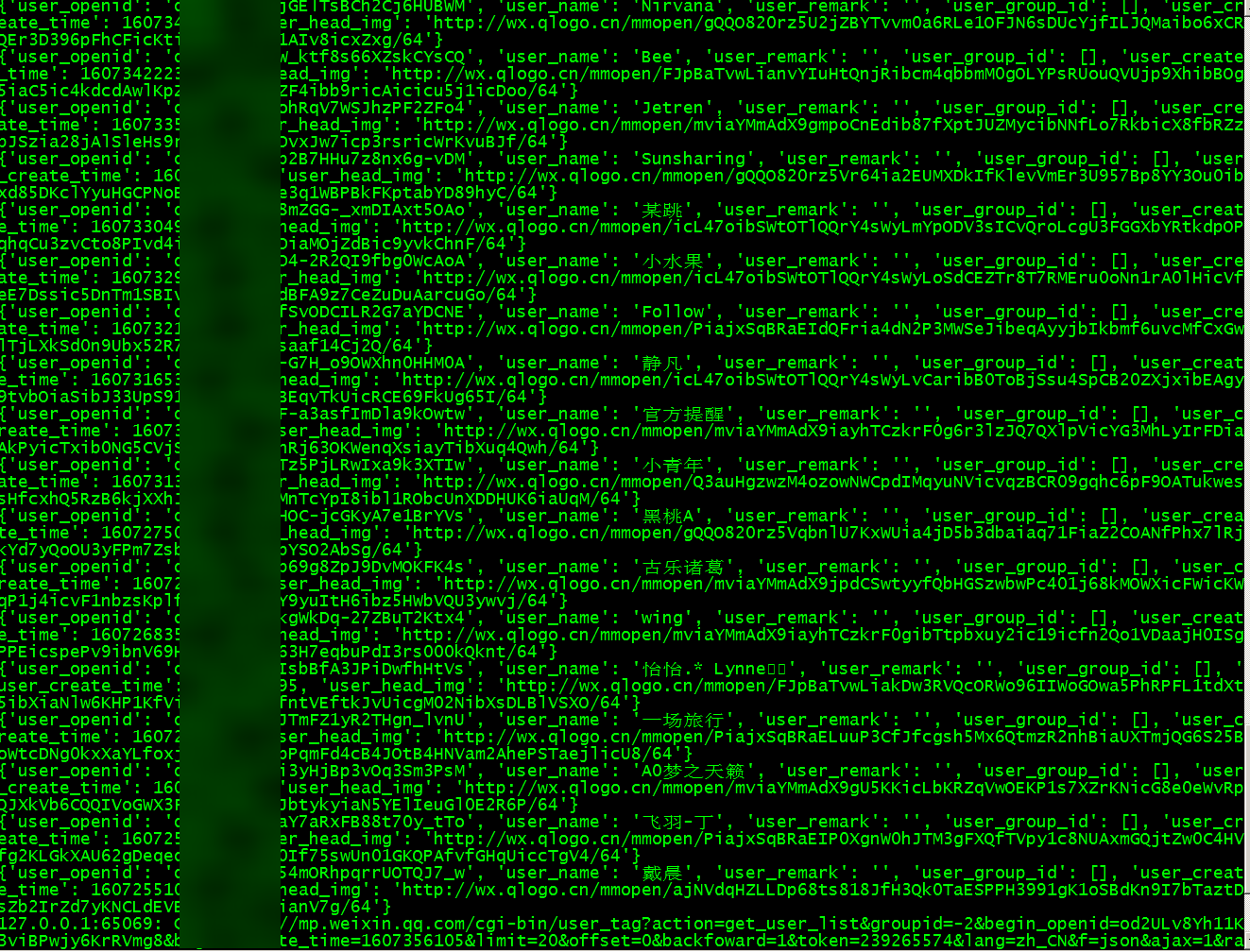

监控公众号取消关注的粉丝

闲聊 • 李魔佛 发表了文章 • 0 个评论 • 3573 次浏览 • 2020-12-08 23:48

上面是获取到全部粉丝的数据,原理是直接利用mitmproxy抓包,监听到指定url数据后,把数据导出到文件就可以了。

如果需要教程和代码,可以私聊。(哦,网站关闭了注册了,那就公众号留言吧) 查看全部

简单快速下载知乎视频

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 6178 次浏览 • 2020-11-29 23:03

1. 打开视频前按F12

2. 播放视频

3. 查看F12的网络选项

4. 找到 https://vdn3.vzuu.com 的url

5. 对应的整个url链接就是视频的真实下载地址。把url复制到浏览器打开,然后右键另存为本地视频就可以了

查看全部

1. 打开视频前按F12

2. 播放视频

3. 查看F12的网络选项

4. 找到 https://vdn3.vzuu.com 的url

5. 对应的整个url链接就是视频的真实下载地址。把url复制到浏览器打开,然后右键另存为本地视频就可以了

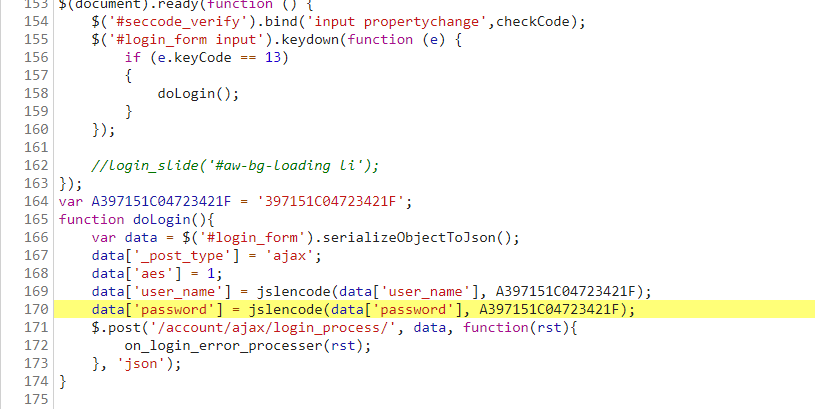

集思录用户名密码JS加密流程解密 【JS加密破解教程一】

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 6204 次浏览 • 2020-11-27 17:26

而且提交的内容每次都固定,第一种最傻的方式就是每次提交就把加密的用户名和密码提交上去。

当然,对于有钻研的读者,可能想看看其具体的加密方式。

那么就按照流程,通过断点与搜索,找到其加密方法。

首先在上面的截图中很明显就知道,这个字符加密应该是aes,因为它的提交字段中aes:1

按F12,走完整个登录流程。

然后搜索password字样的地方。

在index.html首页中找到一处:

然后在该password的地方打个断点,然后跳转到jslencode 的地方。

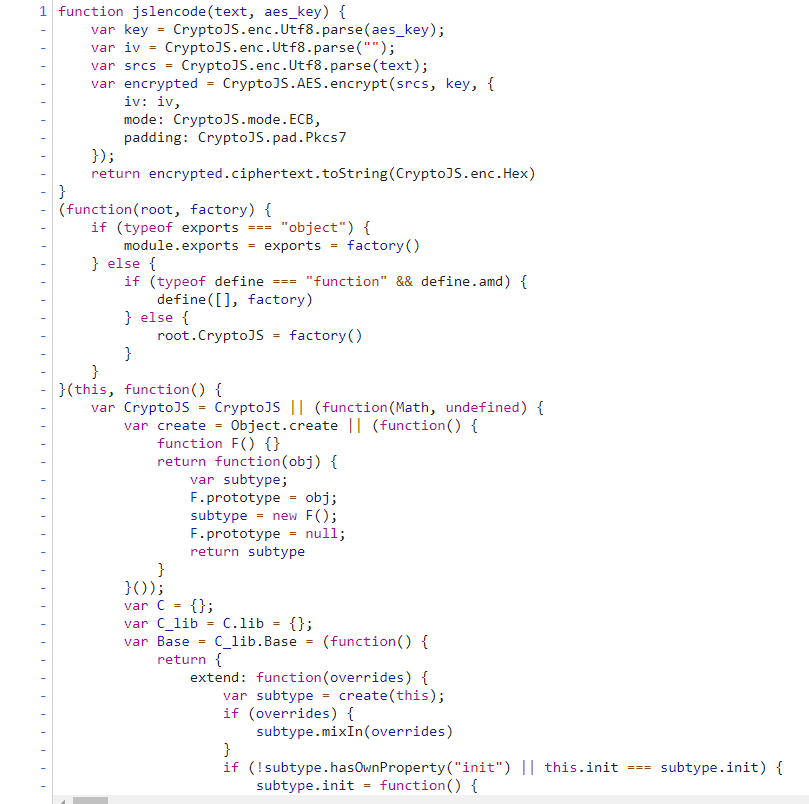

跳转到的地方是这里。

然后我们浏览一下这个JS页面,尝试把整个JS代码抠出来。

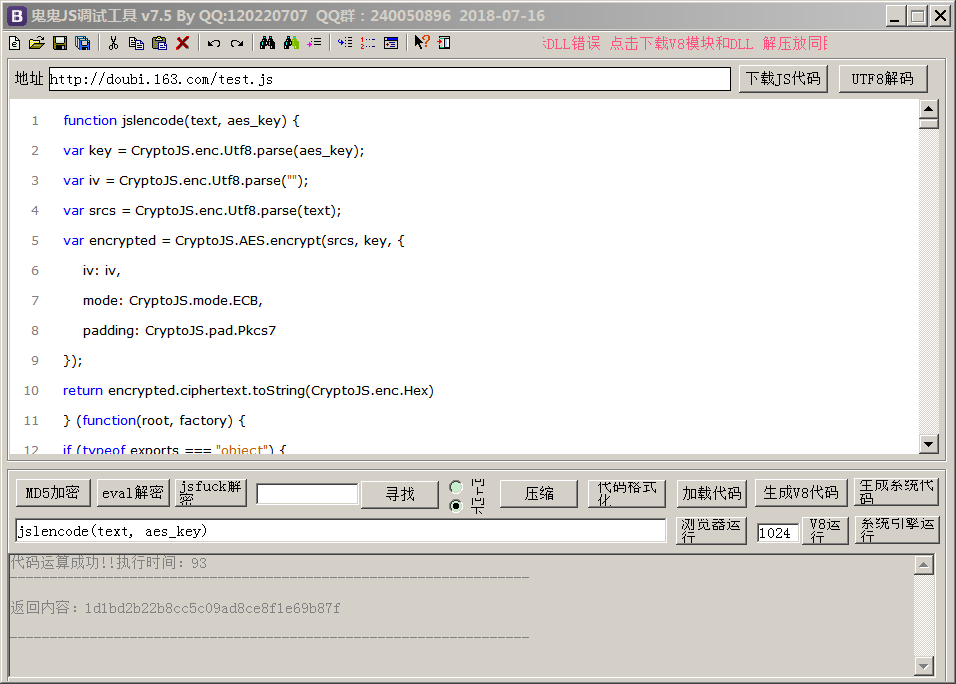

放到我们的调试软件中,比较常用的是鬼鬼JS调试器。(有需要的可以关注wx公众号下载:回复 鬼鬼JS 即可)

这个调试器的好处是,可以很方便格式化JS代码,然后输入你要调试的字符,然后点击运行,可以当场拿到结果,等到结果ok了的话,就可以用python 的pyexecjs执行。

先点击代码格式化,然后在输入框里找到函数的入口:

jslencode(text, aes_key),好了,现在就把我们的密码 XXXXXX,和aes_key 放进去就可以了。

aes_key 在之前的index.html就能找到。var A397151C04723421F = '397151C04723421F';

function doLogin(){

var data = $('#login_form').serializeObjectToJson();

data['_post_type'] = 'ajax';

data['aes'] = 1;

data['user_name'] = jslencode(data['user_name'], A397151C04723421F);

data['password'] = jslencode(data['password'], A397151C04723421F);

$.post('/account/ajax/login_process/', data, function(rst){

on_login_error_processer(rst);

}, 'json');

var A397151C04723421F = '397151C04723421F';

jslencode(‘jisilupassword’, '397151C04723421F')

右下角有个系统引擎运行。

得到结果:

1d1bd2b22b8cc5c09ad8ce8f1e69b87f

对比一下第一张图里面的的post请求,发现是一样的。那么现在的JS解密就成功了一大半了。 接着我们就写python代码执行这段JS脚本。

尝试直接把JS放到一个文件,然后编写python代码# -*- coding: utf-8 -*-

# @Time : 2020/11/27 12:15

# @File : js_executor.py

# @Author : Rocky C@www.30daydo.com

import execjs

def main():

encode_user = ctx.call('jslencode', user, key)

encode_password = ctx.call('jslencode', password, key)

print(encode_user)

print(encode_password)

if __name__ == '__main__':

main()

然后发现报错: 说CryptoJS没有定义,那么我们看看代码。(function(root, factory) {

if (typeof exports === "object") {

module.exports = exports = factory()

} else {

if (typeof define === "function" && define.amd) {

define(, factory)

} else {

root.CryptoJS = factory()

}

}

}(this, function() {

var CryptoJS = CryptoJS || (function(Math, undefined) {

var create = Object.create || (function() {

发现这一行此时CryptoJS的定义

var CryptoJS = CryptoJS || (function(Math, undefined) { var create = Object.create || (function() {

那么我们把这一行上面的全部删除。最后的调试后,能够执行的JS代码如下,并保存为 集思录.js 文件,调用上面的python文件。

集思录.jsvar CryptoJS = CryptoJS || (function(Math, undefined) {

var create = Object.create || (function() {

function F() {}

return function(obj) {

var subtype;

F.prototype = obj;

subtype = new F();

F.prototype = null;

return subtype

}

}());

var C = {};

var C_lib = C.lib = {};

var Base = C_lib.Base = (function() {

下面的就跟上面的一模一样了:

源文件地址:https://www.jisilu.cn/static/js/crypto-js-3.3.0-min.js然后python运行后得到加密后的aes数据。

对比一下鬼鬼JS调试器的结果,一样的。

OK,手工。

这里汇聚了平时整理的JS破解工作流,大家可以参考参考。

https://github.com/Rockyzsu/JS-Reverse

原创文章,转载请注明出处:

http://30daydo.com/article/44109

喜欢的朋友可以加入星球探讨: 查看全部

而且提交的内容每次都固定,第一种最傻的方式就是每次提交就把加密的用户名和密码提交上去。

当然,对于有钻研的读者,可能想看看其具体的加密方式。

那么就按照流程,通过断点与搜索,找到其加密方法。

首先在上面的截图中很明显就知道,这个字符加密应该是aes,因为它的提交字段中aes:1

按F12,走完整个登录流程。

然后搜索password字样的地方。

在index.html首页中找到一处:

然后在该password的地方打个断点,然后跳转到jslencode 的地方。

跳转到的地方是这里。

然后我们浏览一下这个JS页面,尝试把整个JS代码抠出来。

放到我们的调试软件中,比较常用的是鬼鬼JS调试器。(有需要的可以关注wx公众号下载:回复 鬼鬼JS 即可)

这个调试器的好处是,可以很方便格式化JS代码,然后输入你要调试的字符,然后点击运行,可以当场拿到结果,等到结果ok了的话,就可以用python 的pyexecjs执行。

先点击代码格式化,然后在输入框里找到函数的入口:

jslencode(text, aes_key),好了,现在就把我们的密码 XXXXXX,和aes_key 放进去就可以了。

aes_key 在之前的index.html就能找到。

var A397151C04723421F = '397151C04723421F';

function doLogin(){

var data = $('#login_form').serializeObjectToJson();

data['_post_type'] = 'ajax';

data['aes'] = 1;

data['user_name'] = jslencode(data['user_name'], A397151C04723421F);

data['password'] = jslencode(data['password'], A397151C04723421F);

$.post('/account/ajax/login_process/', data, function(rst){

on_login_error_processer(rst);

}, 'json');

var A397151C04723421F = '397151C04723421F';

jslencode(‘jisilupassword’, '397151C04723421F')

右下角有个系统引擎运行。

得到结果:

1d1bd2b22b8cc5c09ad8ce8f1e69b87f

对比一下第一张图里面的的post请求,发现是一样的。那么现在的JS解密就成功了一大半了。 接着我们就写python代码执行这段JS脚本。

尝试直接把JS放到一个文件,然后编写python代码

# -*- coding: utf-8 -*-

# @Time : 2020/11/27 12:15

# @File : js_executor.py

# @Author : Rocky C@www.30daydo.com

import execjs

def main():

encode_user = ctx.call('jslencode', user, key)

encode_password = ctx.call('jslencode', password, key)

print(encode_user)

print(encode_password)

if __name__ == '__main__':

main()

然后发现报错: 说CryptoJS没有定义,那么我们看看代码。

(function(root, factory) {

if (typeof exports === "object") {

module.exports = exports = factory()

} else {

if (typeof define === "function" && define.amd) {

define(, factory)

} else {

root.CryptoJS = factory()

}

}

}(this, function() {

var CryptoJS = CryptoJS || (function(Math, undefined) {

var create = Object.create || (function() {发现这一行此时CryptoJS的定义

var CryptoJS = CryptoJS || (function(Math, undefined) { var create = Object.create || (function() {

那么我们把这一行上面的全部删除。最后的调试后,能够执行的JS代码如下,并保存为 集思录.js 文件,调用上面的python文件。

集思录.js

var CryptoJS = CryptoJS || (function(Math, undefined) {

var create = Object.create || (function() {

function F() {}

return function(obj) {

var subtype;

F.prototype = obj;

subtype = new F();

F.prototype = null;

return subtype

}

}());

var C = {};

var C_lib = C.lib = {};

var Base = C_lib.Base = (function() {

下面的就跟上面的一模一样了:源文件地址:

https://www.jisilu.cn/static/js/crypto-js-3.3.0-min.js然后python运行后得到加密后的aes数据。

对比一下鬼鬼JS调试器的结果,一样的。

OK,手工。

这里汇聚了平时整理的JS破解工作流,大家可以参考参考。

https://github.com/Rockyzsu/JS-Reverse

原创文章,转载请注明出处:

http://30daydo.com/article/44109

喜欢的朋友可以加入星球探讨:

免费代理ip与收费的代理ip

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 4343 次浏览 • 2020-10-30 18:00

曾经有尝试过使用免费的代理ip来搭建代理池,可是免费的代理ip不仅资源少,而且可用率、高匿性、速度等都极差,每次使用都需要借助第三方软件进行检查是否可用,严重影响效率,根本满足不了任务的需求。

收费的代理ip与免费的代理ip差距非常大,不仅拥有海量的ip资源,可用率、高匿性、速度都是极好。操作简单工作效率既然提高上去了。经过多家的测试,最终选择了性价比最高的万变ip。高质量的优质代理ip才可以真正用来防止爬虫被封锁,如果使用普通代理,爬虫的真实IP还是会暴露。新获取一批新IP 查看全部

曾经有尝试过使用免费的代理ip来搭建代理池,可是免费的代理ip不仅资源少,而且可用率、高匿性、速度等都极差,每次使用都需要借助第三方软件进行检查是否可用,严重影响效率,根本满足不了任务的需求。

收费的代理ip与免费的代理ip差距非常大,不仅拥有海量的ip资源,可用率、高匿性、速度都是极好。操作简单工作效率既然提高上去了。经过多家的测试,最终选择了性价比最高的万变ip。高质量的优质代理ip才可以真正用来防止爬虫被封锁,如果使用普通代理,爬虫的真实IP还是会暴露。新获取一批新IP

Python爬虫学习者需要注意什么?

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 4221 次浏览 • 2020-10-28 17:14

最常见的解决方法就是使用大量的ip,就是借着代理ip保证IP被封时有替换IP可用,永远保持着续航能力。这里推荐51代理ip,作为一家提供代理IP的专业服务商,万变ip代理拥有强大的技术团队运营维护,全高匿系统所产生的高匿ip不仅安全稳定、而且速度快, 以及与爬虫用户多年来合作的宝贵经验,是Python爬虫首选代理IP。

Python是一种全栈计算机程序设计语言,全栈,顾名思义,应用范围广。你可能听说过很多编程语言,例如C语言,Java语言等,众所周知,这些语言都非常难学,更别说景桐使用了。而python不一样,比如完成一个Web服务,C语言要写1000行代码,Java要写100行,而python可能只要写20行。对!这就是差距!目前由于python“简单易懂”,已逐步成为网络爬虫主流语言。

在初学python爬虫时,很多程序员会被一些“小问题”阻碍脚步,为避免大家再次犯同样的错误,加快学习进程,在爬取网站信息时一定要使用大量代理IP。好用的代理IP服务商,

高效率的爬虫工作离不开ip代理的支持,这就是ip代理越来越受欢迎的原因!收藏举报投诉 查看全部

最常见的解决方法就是使用大量的ip,就是借着代理ip保证IP被封时有替换IP可用,永远保持着续航能力。这里推荐51代理ip,作为一家提供代理IP的专业服务商,万变ip代理拥有强大的技术团队运营维护,全高匿系统所产生的高匿ip不仅安全稳定、而且速度快, 以及与爬虫用户多年来合作的宝贵经验,是Python爬虫首选代理IP。

Python是一种全栈计算机程序设计语言,全栈,顾名思义,应用范围广。你可能听说过很多编程语言,例如C语言,Java语言等,众所周知,这些语言都非常难学,更别说景桐使用了。而python不一样,比如完成一个Web服务,C语言要写1000行代码,Java要写100行,而python可能只要写20行。对!这就是差距!目前由于python“简单易懂”,已逐步成为网络爬虫主流语言。

在初学python爬虫时,很多程序员会被一些“小问题”阻碍脚步,为避免大家再次犯同样的错误,加快学习进程,在爬取网站信息时一定要使用大量代理IP。好用的代理IP服务商,

高效率的爬虫工作离不开ip代理的支持,这就是ip代理越来越受欢迎的原因!收藏举报投诉

Python爬虫虎牙平台主播的图片代码

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 4231 次浏览 • 2020-10-27 17:55

代码如下:

import urllib.request

import re

import os

# 全局变量用来记录图片的编号

gl_z = 0

def down_img(url1):

"""下载图片"""

# 处理图片链接,拼接http:

url = "https:" + re.sub(r"\?", "", url1)

global gl_z

print(url)

# 请求链接

response = urllib.request.urlopen(url)

# 读取内容

data = response.read()

# 切片取出图片名称

file_name = url[url.rfind('/') + 1:]

# 生成列表

a = [x for x in range(10000)]

# 打开文件用以写入

file = open(os.path.join("photo3", "img" + file_name + str(a[gl_z]) + ".jpg"), "wb")

file.write(data)

# 关闭文件

file.close()

# 编号加1

gl_z += 1

if __name__ == '__main__':

# 要抓去信息的网址

home = """http://www.huya.com/g/xingxiu"""

# 模拟请求头

headers = {

"Host": "www.huya.com",

"User-Agent": "agent信息"

}

# 构造好请求对象 将请求提交到服务器 获取的响应就是到首页的html代码

request = urllib.request.Request(url=home, headers=headers)

response = urllib.request.urlopen(request)

# 读取抓到的内容并解码

html_data = response.read().decode()

"""huyaimg.msstatic.com/avatar/1054/db/6590aa9bcf98e12e5d809d371e46cc_180_135.jpg

"""

# 使用正则 从首页中 提取出所有的图片链接

img_list = re.findall(r"//huyaimg\.msstatic\.com.+\.jpg\?", html_data)

print(img_list)

# 取出每张图片进行下载

for img_url in img_list:

print(img_url)

down_img(img_url) 查看全部

代码如下:

import urllib.request

import re

import os

# 全局变量用来记录图片的编号

gl_z = 0

def down_img(url1):

"""下载图片"""

# 处理图片链接,拼接http:

url = "https:" + re.sub(r"\?", "", url1)

global gl_z

print(url)

# 请求链接

response = urllib.request.urlopen(url)

# 读取内容

data = response.read()

# 切片取出图片名称

file_name = url[url.rfind('/') + 1:]

# 生成列表

a = [x for x in range(10000)]

# 打开文件用以写入

file = open(os.path.join("photo3", "img" + file_name + str(a[gl_z]) + ".jpg"), "wb")

file.write(data)

# 关闭文件

file.close()

# 编号加1

gl_z += 1

if __name__ == '__main__':

# 要抓去信息的网址

home = """http://www.huya.com/g/xingxiu"""

# 模拟请求头

headers = {

"Host": "www.huya.com",

"User-Agent": "agent信息"

}

# 构造好请求对象 将请求提交到服务器 获取的响应就是到首页的html代码

request = urllib.request.Request(url=home, headers=headers)

response = urllib.request.urlopen(request)

# 读取抓到的内容并解码

html_data = response.read().decode()

"""huyaimg.msstatic.com/avatar/1054/db/6590aa9bcf98e12e5d809d371e46cc_180_135.jpg

"""

# 使用正则 从首页中 提取出所有的图片链接

img_list = re.findall(r"//huyaimg\.msstatic\.com.+\.jpg\?", html_data)

print(img_list)

# 取出每张图片进行下载

for img_url in img_list:

print(img_url)

down_img(img_url)

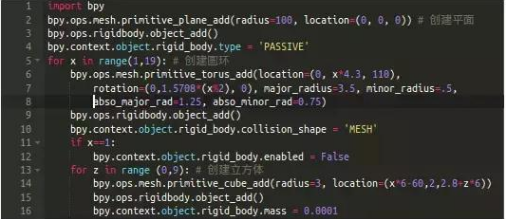

python打造3D撞球小游戏

python • wanbainip 发表了文章 • 0 个评论 • 4107 次浏览 • 2020-10-26 15:52

我们需要三组刚体(当您在Blender的对象上打开一个刚体的属性时,Blender将模拟与其它刚体的碰撞):

1.平面

第2行代码创建了一个简单的平面,立方体将放置在该平面上。为了防止它因重力而坠落,我们将其设为“受体”第4行代码。

2. 圆环

第11-12行将第一个圆环的"Enabled"属性设置为false,防止由于重力而坠落。这样它就固定在那牵住整个链条。

3. 立方体

因为z循环第13行嵌套在x循环[第5行]中,我们将得到一个18X10的立方体组成的墙。 查看全部

Python爬虫基本框架

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 3994 次浏览 • 2020-10-25 18:01

1. 爬虫调度器负责统筹其他四个模块协调工作。

2. URL管理器负责管理URL链接,包括已爬取的链接和未爬取的链接。

3. HTML下载器用于从URL管理器中获取未爬取的链接并下载其HTML网页。

4. HTML解析器用于解析HTML下载器下载的HTML网页,获取URL链接交给URL管理器,提取要获取的数据交给数据存储器。

5. 数据存储器用于将HTML解析器解析出来的数据存储到数据库或文件。 查看全部

1. 爬虫调度器负责统筹其他四个模块协调工作。

2. URL管理器负责管理URL链接,包括已爬取的链接和未爬取的链接。

3. HTML下载器用于从URL管理器中获取未爬取的链接并下载其HTML网页。

4. HTML解析器用于解析HTML下载器下载的HTML网页,获取URL链接交给URL管理器,提取要获取的数据交给数据存储器。

5. 数据存储器用于将HTML解析器解析出来的数据存储到数据库或文件。

Python爬虫如何防止ip被封?

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 4092 次浏览 • 2020-10-24 10:22

第一种:降低访问的速度,我们可以使用 time模块中的sleep,使程序每运行一次后就睡眠1s,这样可以很有效的降低ip被封机率,但是效率效果不是很高,一般是用于量小的采集任务。

第二种:使用类似万变ip代理这样的优质换ip软件,这也是爬虫工作者最常用的手段之一,通过代理ip来伪装我们的ip,隐藏本地真实的ip地址,让目标服务器无法识别是相同ip发出的请求,这样就很有效的防止ip被封。突破了ip的限制,采集数据的任务就会顺利,工作效率自然会提高!

查看全部

第一种:降低访问的速度,我们可以使用 time模块中的sleep,使程序每运行一次后就睡眠1s,这样可以很有效的降低ip被封机率,但是效率效果不是很高,一般是用于量小的采集任务。

第二种:使用类似万变ip代理这样的优质换ip软件,这也是爬虫工作者最常用的手段之一,通过代理ip来伪装我们的ip,隐藏本地真实的ip地址,让目标服务器无法识别是相同ip发出的请求,这样就很有效的防止ip被封。突破了ip的限制,采集数据的任务就会顺利,工作效率自然会提高!

python爬取网页中的超链接地址,获取到的跟浏览器中显示的不一样

python爬虫 • acker 回复了问题 • 2 人关注 • 2 个回复 • 5790 次浏览 • 2020-09-25 16:55

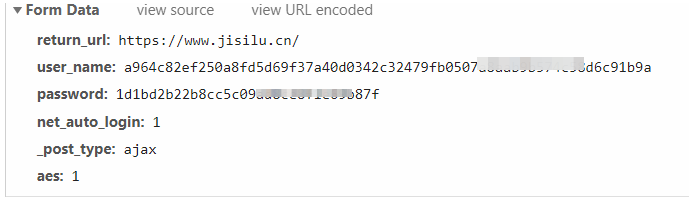

python asyncio aiohttp motor异步爬虫例子 定时抓取bilibili首页热度网红

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 4946 次浏览 • 2020-09-22 22:35

AsyncIOMotorClient(connect_uri)

motor连接带用户名和密码的方法和pymongo一致。

connect_uri = f'mongodb://{user}:{password}@{host}:{port}'# -*- coding: utf-8 -*-

# website: http://30daydo.com

# @Time : 2020/9/22 10:07

# @File : bilibili_hot_anchor.py

# 异步爬取首页与列表

import asyncio

import datetime

import aiohttp

import re

import time

from motor.motor_asyncio import AsyncIOMotorClient

from parsel import Selector

from settings import _json_data

SLEEP = 60 * 10

INFO = _json_data['mongo']['arm']

host = INFO['host']

port = INFO['port']

user = INFO['user']

password = INFO['password']

connect_uri = f'mongodb://{user}:{password}@{host}:{port}'

client = AsyncIOMotorClient(connect_uri)

db = client['db_parker']

home_url = 'https://www.bilibili.com/ranking'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:57.0) Gecko/20100101 Firefox/57.0',

'Accept-Language': 'zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2'}

def convertor(number_str):

'''

将小数点的万变为整数

:param number_str:

:return:

'''

number = re.search('(\d+\.+\d+)', number_str)

if number:

number = float(number.group(1))

if re.search('万', number_str):

number = int(number * 10000)

else:

number = 0

return number

async def home_page():

async with aiohttp.ClientSession() as session:

while True:

start = time.time()

async with session.get(url=home_url, headers=headers) as response:

html = await response.text()

resp = Selector(text=html)

items = resp.xpath('//ul[@class="rank-list"]/li')

for item in items:

json_data = {}

number = item.xpath('.//div[@class="num"]/text()').extract_first()

info = item.xpath('.//div[@class="info"][1]')

title = info.xpath('.//a/text()').extract_first()

detail_url = info.xpath('.//a/@href').extract_first()

play_number = info.xpath('.//div[@class="detail"]/span[1]/text()').extract_first()

viewing_number = info.xpath('.//div[@class="detail"]/span[2]/text()').extract_first()

json_data['number'] = int(number)

json_data['title'] = title

json_data['play_number'] = convertor(play_number)

json_data['viewing_number'] = convertor(viewing_number)

json_data['url'] = detail_url

task = asyncio.create_task(detail_list(session, detail_url, json_data))

# await detail_url()

end = time.time()

print(f'time used {end-start}')

await asyncio.sleep(SLEEP) # 暂停10分钟

print(f'sleep for {SLEEP}')

async def detail_list(session, url, json_data):

async with session.get(url, headers=headers) as response:

response = await response.text()

await parse_detail(response, json_data)

async def parse_detail(html, json_data=None):

resp = Selector(text=html)

info = resp.xpath('//div[@id="v_desc"]/div[@class="info open"]/text()').extract_first()

if not info:

info = '这个家伙很懒'

json_data['info'] = info.strip()

current = datetime.datetime.now()

json_data['crawltime'] = current

await db['bilibili'].update_one({'url': json_data['url']}, {'$set': json_data}, True, True)

loop = asyncio.get_event_loop()

loop.run_until_complete(home_page())

爬取的数据图:

原创文章,转载请注明:http://30daydo.com/article/605

需要源码,可私信。

查看全部

AsyncIOMotorClient(connect_uri)

motor连接带用户名和密码的方法和pymongo一致。

connect_uri = f'mongodb://{user}:{password}@{host}:{port}'

# -*- coding: utf-8 -*-

# website: http://30daydo.com

# @Time : 2020/9/22 10:07

# @File : bilibili_hot_anchor.py

# 异步爬取首页与列表

import asyncio

import datetime

import aiohttp

import re

import time

from motor.motor_asyncio import AsyncIOMotorClient

from parsel import Selector

from settings import _json_data

SLEEP = 60 * 10

INFO = _json_data['mongo']['arm']

host = INFO['host']

port = INFO['port']

user = INFO['user']

password = INFO['password']

connect_uri = f'mongodb://{user}:{password}@{host}:{port}'

client = AsyncIOMotorClient(connect_uri)

db = client['db_parker']

home_url = 'https://www.bilibili.com/ranking'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:57.0) Gecko/20100101 Firefox/57.0',

'Accept-Language': 'zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2'}

def convertor(number_str):

'''

将小数点的万变为整数

:param number_str:

:return:

'''

number = re.search('(\d+\.+\d+)', number_str)

if number:

number = float(number.group(1))

if re.search('万', number_str):

number = int(number * 10000)

else:

number = 0

return number

async def home_page():

async with aiohttp.ClientSession() as session:

while True:

start = time.time()

async with session.get(url=home_url, headers=headers) as response:

html = await response.text()

resp = Selector(text=html)

items = resp.xpath('//ul[@class="rank-list"]/li')

for item in items:

json_data = {}

number = item.xpath('.//div[@class="num"]/text()').extract_first()

info = item.xpath('.//div[@class="info"][1]')

title = info.xpath('.//a/text()').extract_first()

detail_url = info.xpath('.//a/@href').extract_first()

play_number = info.xpath('.//div[@class="detail"]/span[1]/text()').extract_first()

viewing_number = info.xpath('.//div[@class="detail"]/span[2]/text()').extract_first()

json_data['number'] = int(number)

json_data['title'] = title

json_data['play_number'] = convertor(play_number)

json_data['viewing_number'] = convertor(viewing_number)

json_data['url'] = detail_url

task = asyncio.create_task(detail_list(session, detail_url, json_data))

# await detail_url()

end = time.time()

print(f'time used {end-start}')

await asyncio.sleep(SLEEP) # 暂停10分钟

print(f'sleep for {SLEEP}')

async def detail_list(session, url, json_data):

async with session.get(url, headers=headers) as response:

response = await response.text()

await parse_detail(response, json_data)

async def parse_detail(html, json_data=None):

resp = Selector(text=html)

info = resp.xpath('//div[@id="v_desc"]/div[@class="info open"]/text()').extract_first()

if not info:

info = '这个家伙很懒'

json_data['info'] = info.strip()

current = datetime.datetime.now()

json_data['crawltime'] = current

await db['bilibili'].update_one({'url': json_data['url']}, {'$set': json_data}, True, True)

loop = asyncio.get_event_loop()

loop.run_until_complete(home_page())

爬取的数据图:

原创文章,转载请注明:http://30daydo.com/article/605

需要源码,可私信。

请问各位用scrapy和redis方法爬取不到数据的问题(可悬赏),求大佬看下,感激不尽

python爬虫 • 李魔佛 回复了问题 • 2 人关注 • 1 个回复 • 10299 次浏览 • 2020-04-16 22:16

requests请求返回的json格式为bytes乱码

python爬虫 • 李魔佛 回复了问题 • 2 人关注 • 1 个回复 • 6783 次浏览 • 2020-02-16 23:35

scrapy在settings中定义变量不能包含小写!

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 3923 次浏览 • 2019-11-16 16:39

比如定义了一个叫 Redis_host = '192.168.1.1',的值

然后在spider中,如果你调用self.settings.get('Redis_host')

那么返回值是 None。

如果用REDIS_HOST定义,那么就可以正确返回它的值。

如果你一定要用小写,也有其他方法可正常调用。

先导入settings文件

fromt xxxx import setttings # xxx为项目名

host = settings.Redis_host # 直接导入一个文件的形式来调用是可以的 查看全部

比如定义了一个叫 Redis_host = '192.168.1.1',的值

然后在spider中,如果你调用self.settings.get('Redis_host')

那么返回值是 None。

如果用REDIS_HOST定义,那么就可以正确返回它的值。

如果你一定要用小写,也有其他方法可正常调用。

先导入settings文件

fromt xxxx import setttings # xxx为项目名

host = settings.Redis_host # 直接导入一个文件的形式来调用是可以的

etree.strip_tags的用法

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 5284 次浏览 • 2019-10-24 11:24

它把参数中的标签从源htmlelement中删除,并且把里面的标签文本给合并进来。

举个例子:from lxml.html import etree

from lxml.html import fromstring, HtmlElement

test_html = '''<p><span>hello</span><span>world</span></p>'''

test_element = fromstring(test_html)

etree.strip_tags(test_element,'span') # 清除span标签

etree.tostring(test_element)

因为上述操作直接应用于test_element上的,所以test_element的值已经被修改了。

所以现在test_element 的值是

b'<p>helloworld</p>'

原创文章,转载请注明出处

http://30daydo.com/article/553

查看全部

它把参数中的标签从源htmlelement中删除,并且把里面的标签文本给合并进来。

举个例子:

from lxml.html import etree

from lxml.html import fromstring, HtmlElement

test_html = '''<p><span>hello</span><span>world</span></p>'''

test_element = fromstring(test_html)

etree.strip_tags(test_element,'span') # 清除span标签

etree.tostring(test_element)

因为上述操作直接应用于test_element上的,所以test_element的值已经被修改了。

所以现在test_element 的值是

b'<p>helloworld</p>'

原创文章,转载请注明出处

http://30daydo.com/article/553

aiohttp异步下载图片

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 5748 次浏览 • 2019-09-16 17:14

headers={'User-Agent':'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'}

async def getPage(num):

async with aiohttp.ClientSession() as session:

async with session.get(url.format(num),headers=headers) as resp:

if resp.status==200:

f= await aiofiles.open('{}.jpg'.format(num),mode='wb')

await f.write(await resp.read())

await f.close()

loop = asyncio.get_event_loop()

tasks = [getPage(i) for i in range(5)]

loop.run_until_complete(asyncio.wait(tasks))

原创文章,

转载请注明出处:

http://30daydo.com/article/537

查看全部

url = 'http://xyhz.huizhou.gov.cn/static/js/common/jigsaw/images/{}.jpg'

headers={'User-Agent':'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'}

async def getPage(num):

async with aiohttp.ClientSession() as session:

async with session.get(url.format(num),headers=headers) as resp:

if resp.status==200:

f= await aiofiles.open('{}.jpg'.format(num),mode='wb')

await f.write(await resp.read())

await f.close()

loop = asyncio.get_event_loop()

tasks = [getPage(i) for i in range(5)]

loop.run_until_complete(asyncio.wait(tasks))原创文章,

转载请注明出处:

http://30daydo.com/article/537

scrapy源码分析<一>:入口函数以及是如何运行

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 10237 次浏览 • 2019-08-31 10:47

下面我们从源码分析一下scrapy执行的流程:

执行scrapy crawl 命令时,调用的是Command类class Command(ScrapyCommand):

requires_project = True

def syntax(self):

return '[options]'

def short_desc(self):

return 'Runs all of the spiders - My Defined'

def run(self,args,opts):

print('==================')

print(type(self.crawler_process))

spider_list = self.crawler_process.spiders.list() # 找到爬虫类

for name in spider_list:

print('=================')

print(name)

self.crawler_process.crawl(name,**opts.__dict__)

self.crawler_process.start()

然后我们去看看crawler_process,这个是来自ScrapyCommand,而ScrapyCommand又是CrawlerProcess的子类,而CrawlerProcess又是CrawlerRunner的子类

在CrawlerRunner构造函数里面主要作用就是这个 def __init__(self, settings=None):

if isinstance(settings, dict) or settings is None:

settings = Settings(settings)

self.settings = settings

self.spider_loader = _get_spider_loader(settings) # 构造爬虫

self._crawlers = set()

self._active = set()

self.bootstrap_failed = False

1. 加载配置文件def _get_spider_loader(settings):

cls_path = settings.get('SPIDER_LOADER_CLASS')

# settings文件没有定义SPIDER_LOADER_CLASS,所以这里获取到的是系统的默认配置文件,

# 默认配置文件在接下来的代码块A

# SPIDER_LOADER_CLASS = 'scrapy.spiderloader.SpiderLoader'

loader_cls = load_object(cls_path)

# 这个函数就是根据路径转为类对象,也就是上面crapy.spiderloader.SpiderLoader 这个

# 字符串变成一个类对象

# 具体的load_object 对象代码见下面代码块B

return loader_cls.from_settings(settings.frozencopy())

默认配置文件defautl_settting.py# 代码块A

#......省略若干

SCHEDULER = 'scrapy.core.scheduler.Scheduler'

SCHEDULER_DISK_QUEUE = 'scrapy.squeues.PickleLifoDiskQueue'

SCHEDULER_MEMORY_QUEUE = 'scrapy.squeues.LifoMemoryQueue'

SCHEDULER_PRIORITY_QUEUE = 'scrapy.pqueues.ScrapyPriorityQueue'

SPIDER_LOADER_CLASS = 'scrapy.spiderloader.SpiderLoader' 就是这个值

SPIDER_LOADER_WARN_ONLY = False

SPIDER_MIDDLEWARES = {}

load_object的实现# 代码块B 为了方便,我把异常处理的去除

from importlib import import_module #导入第三方库

def load_object(path):

dot = path.rindex('.')

module, name = path[:dot], path[dot+1:]

# 上面把路径分为基本路径+模块名

mod = import_module(module)

obj = getattr(mod, name)

# 获取模块里面那个值

return obj

测试代码:In [33]: mod = import_module(module)

In [34]: mod

Out[34]: <module 'scrapy.spiderloader' from '/home/xda/anaconda3/lib/python3.7/site-packages/scrapy/spiderloader.py'>

In [35]: getattr(mod,name)

Out[35]: scrapy.spiderloader.SpiderLoader

In [36]: obj = getattr(mod,name)

In [37]: obj

Out[37]: scrapy.spiderloader.SpiderLoader

In [38]: type(obj)

Out[38]: type

在代码块A中,loader_cls是SpiderLoader,最后返回的的是SpiderLoader.from_settings(settings.frozencopy())

接下来看看SpiderLoader.from_settings, def from_settings(cls, settings):

return cls(settings)

返回类对象自己,所以直接看__init__函数即可class SpiderLoader(object):

"""

SpiderLoader is a class which locates and loads spiders

in a Scrapy project.

"""

def __init__(self, settings):

self.spider_modules = settings.getlist('SPIDER_MODULES')

# 获得settting中的模块名字,创建scrapy的时候就默认帮你生成了

# 你可以看看你的settings文件里面的内容就可以找到这个值,是一个list

self.warn_only = settings.getbool('SPIDER_LOADER_WARN_ONLY')

self._spiders = {}

self._found = defaultdict(list)

self._load_all_spiders() # 加载所有爬虫

核心就是这个_load_all_spiders:

走起:def _load_all_spiders(self):

for name in self.spider_modules:

for module in walk_modules(name): # 这个遍历文件夹里面的文件,然后再转化为类对象,

# 保存到字典:self._spiders = {}

self._load_spiders(module) # 模块变成spider

self._check_name_duplicates() # 去重,如果名字一样就异常

接下来看看_load_spiders

核心就是下面的。def iter_spider_classes(module):

from scrapy.spiders import Spider

for obj in six.itervalues(vars(module)): # 找到模块里面的变量,然后迭代出来

if inspect.isclass(obj) and \

issubclass(obj, Spider) and \

obj.__module__ == module.__name__ and \

getattr(obj, 'name', None): # 有name属性,继承于Spider

yield obj

这个obj就是我们平时写的spider类了。

原来分析了这么多,才找到了我们平时写的爬虫类

待续。。。。

原创文章

转载请注明出处

http://30daydo.com/article/530

查看全部

下面我们从源码分析一下scrapy执行的流程:

执行scrapy crawl 命令时,调用的是Command类

class Command(ScrapyCommand):

requires_project = True

def syntax(self):

return '[options]'

def short_desc(self):

return 'Runs all of the spiders - My Defined'

def run(self,args,opts):

print('==================')

print(type(self.crawler_process))

spider_list = self.crawler_process.spiders.list() # 找到爬虫类

for name in spider_list:

print('=================')

print(name)

self.crawler_process.crawl(name,**opts.__dict__)

self.crawler_process.start()

然后我们去看看crawler_process,这个是来自ScrapyCommand,而ScrapyCommand又是CrawlerProcess的子类,而CrawlerProcess又是CrawlerRunner的子类

在CrawlerRunner构造函数里面主要作用就是这个

def __init__(self, settings=None):

if isinstance(settings, dict) or settings is None:

settings = Settings(settings)

self.settings = settings

self.spider_loader = _get_spider_loader(settings) # 构造爬虫

self._crawlers = set()

self._active = set()

self.bootstrap_failed = False

1. 加载配置文件

def _get_spider_loader(settings):

cls_path = settings.get('SPIDER_LOADER_CLASS')

# settings文件没有定义SPIDER_LOADER_CLASS,所以这里获取到的是系统的默认配置文件,

# 默认配置文件在接下来的代码块A

# SPIDER_LOADER_CLASS = 'scrapy.spiderloader.SpiderLoader'

loader_cls = load_object(cls_path)

# 这个函数就是根据路径转为类对象,也就是上面crapy.spiderloader.SpiderLoader 这个

# 字符串变成一个类对象

# 具体的load_object 对象代码见下面代码块B

return loader_cls.from_settings(settings.frozencopy())

默认配置文件defautl_settting.py

# 代码块A

#......省略若干

SCHEDULER = 'scrapy.core.scheduler.Scheduler'

SCHEDULER_DISK_QUEUE = 'scrapy.squeues.PickleLifoDiskQueue'

SCHEDULER_MEMORY_QUEUE = 'scrapy.squeues.LifoMemoryQueue'

SCHEDULER_PRIORITY_QUEUE = 'scrapy.pqueues.ScrapyPriorityQueue'

SPIDER_LOADER_CLASS = 'scrapy.spiderloader.SpiderLoader' 就是这个值

SPIDER_LOADER_WARN_ONLY = False

SPIDER_MIDDLEWARES = {}

load_object的实现

# 代码块B 为了方便,我把异常处理的去除

from importlib import import_module #导入第三方库

def load_object(path):

dot = path.rindex('.')

module, name = path[:dot], path[dot+1:]

# 上面把路径分为基本路径+模块名

mod = import_module(module)

obj = getattr(mod, name)

# 获取模块里面那个值

return obj

测试代码:

In [33]: mod = import_module(module)

In [34]: mod

Out[34]: <module 'scrapy.spiderloader' from '/home/xda/anaconda3/lib/python3.7/site-packages/scrapy/spiderloader.py'>

In [35]: getattr(mod,name)

Out[35]: scrapy.spiderloader.SpiderLoader

In [36]: obj = getattr(mod,name)

In [37]: obj

Out[37]: scrapy.spiderloader.SpiderLoader

In [38]: type(obj)

Out[38]: type

在代码块A中,loader_cls是SpiderLoader,最后返回的的是SpiderLoader.from_settings(settings.frozencopy())

接下来看看SpiderLoader.from_settings,

def from_settings(cls, settings):

return cls(settings)

返回类对象自己,所以直接看__init__函数即可

class SpiderLoader(object):

"""

SpiderLoader is a class which locates and loads spiders

in a Scrapy project.

"""

def __init__(self, settings):

self.spider_modules = settings.getlist('SPIDER_MODULES')

# 获得settting中的模块名字,创建scrapy的时候就默认帮你生成了

# 你可以看看你的settings文件里面的内容就可以找到这个值,是一个list

self.warn_only = settings.getbool('SPIDER_LOADER_WARN_ONLY')

self._spiders = {}

self._found = defaultdict(list)

self._load_all_spiders() # 加载所有爬虫

核心就是这个_load_all_spiders:

走起:

def _load_all_spiders(self):

for name in self.spider_modules:

for module in walk_modules(name): # 这个遍历文件夹里面的文件,然后再转化为类对象,

# 保存到字典:self._spiders = {}

self._load_spiders(module) # 模块变成spider

self._check_name_duplicates() # 去重,如果名字一样就异常

接下来看看_load_spiders

核心就是下面的。

def iter_spider_classes(module):

from scrapy.spiders import Spider

for obj in six.itervalues(vars(module)): # 找到模块里面的变量,然后迭代出来

if inspect.isclass(obj) and \

issubclass(obj, Spider) and \

obj.__module__ == module.__name__ and \

getattr(obj, 'name', None): # 有name属性,继承于Spider

yield obj

这个obj就是我们平时写的spider类了。

原来分析了这么多,才找到了我们平时写的爬虫类

待续。。。。

原创文章

转载请注明出处

http://30daydo.com/article/530

scrapy-rabbitmq 不支持python3 [修改源码使它支持]

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 4072 次浏览 • 2019-07-17 17:24

在python3上运行的收会报错。

需要修改以下地方:

待续。。

在python3上运行的收会报错。

需要修改以下地方:

待续。。

scrapy rabbitmq 分布式爬虫

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 7030 次浏览 • 2019-07-17 16:59

rabbitmq是个不错的消息队列服务,可以配合scrapy作为消息队列.

下面是一个简单的demo:import re

import requests

import scrapy

from scrapy import Request

from rabbit_spider import settings

from scrapy.log import logger

import json

from rabbit_spider.items import RabbitSpiderItem

import datetime

from scrapy.selector import Selector

import pika

# from scrapy_rabbitmq.spiders import RabbitMQMixin

# from scrapy.contrib.spiders import CrawlSpider

class Website(scrapy.Spider):

name = "rabbit"

def start_requests(self):

headers = {'Accept': '*/*',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'en-US,en;q=0.9,zh-CN;q=0.8,zh;q=0.7',

'Host': '36kr.com',

'Referer': 'https://36kr.com/information/web_news',

'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.108 Safari/537.36'

}

url = 'https://36kr.com/information/web_news'

yield Request(url=url,

headers=headers)

def parse(self, response):

credentials = pika.PlainCredentials('admin', 'admin')

connection = pika.BlockingConnection(pika.ConnectionParameters('192.168.1.101', 5672, '/', credentials))

channel = connection.channel()

channel.exchange_declare(exchange='direct_log', exchange_type='direct')

result = channel.queue_declare(exclusive=True, queue='')

queue_name = result.method.queue

# print(queue_name)

# infos = sys.argv[1:] if len(sys.argv)>1 else ['info']

info = 'info'

# 绑定多个值

channel.queue_bind(

exchange='direct_log',

routing_key=info,

queue=queue_name

)

print('start to receive [{}]'.format(info))

channel.basic_consume(

on_message_callback=self.callback_func,

queue=queue_name,

auto_ack=True,

)

channel.start_consuming()

def callback_func(self, ch, method, properties, body):

print(body)

启动spider:from scrapy import cmdline

cmdline.execute('scrapy crawl rabbit'.split())

然后往rabbitmq里面推送数据:import pika

import settings

credentials = pika.PlainCredentials('admin','admin')

connection = pika.BlockingConnection(pika.ConnectionParameters('192.168.1.101',5672,'/',credentials))

channel = connection.channel()

channel.exchange_declare(exchange='direct_log',exchange_type='direct') # fanout 就是组播

routing_key = 'info'

message='https://36kr.com/pp/api/aggregation-entity?type=web_latest_article&b_id=59499&per_page=30'

channel.basic_publish(

exchange='direct_log',

routing_key=routing_key,

body=message

)

print('sending message {}'.format(message))

connection.close()

推送数据后,scrapy会马上接受到队里里面的数据。

注意不能在start_requests里面写等待队列的命令,因为start_requests函数需要返回一个生成器,否则程序会报错。

待续。。。

###### 2019-08-29 更新 ###################

发现一个坑,就是rabbitMQ在接受到数据后,无法在回调函数里面使用yield生成器。

查看全部

rabbitmq是个不错的消息队列服务,可以配合scrapy作为消息队列.

下面是一个简单的demo:

import re

import requests

import scrapy

from scrapy import Request

from rabbit_spider import settings

from scrapy.log import logger

import json

from rabbit_spider.items import RabbitSpiderItem

import datetime

from scrapy.selector import Selector

import pika

# from scrapy_rabbitmq.spiders import RabbitMQMixin

# from scrapy.contrib.spiders import CrawlSpider

class Website(scrapy.Spider):

name = "rabbit"

def start_requests(self):

headers = {'Accept': '*/*',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'en-US,en;q=0.9,zh-CN;q=0.8,zh;q=0.7',

'Host': '36kr.com',

'Referer': 'https://36kr.com/information/web_news',

'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.108 Safari/537.36'

}

url = 'https://36kr.com/information/web_news'

yield Request(url=url,

headers=headers)

def parse(self, response):

credentials = pika.PlainCredentials('admin', 'admin')

connection = pika.BlockingConnection(pika.ConnectionParameters('192.168.1.101', 5672, '/', credentials))

channel = connection.channel()

channel.exchange_declare(exchange='direct_log', exchange_type='direct')

result = channel.queue_declare(exclusive=True, queue='')

queue_name = result.method.queue

# print(queue_name)

# infos = sys.argv[1:] if len(sys.argv)>1 else ['info']

info = 'info'

# 绑定多个值

channel.queue_bind(

exchange='direct_log',

routing_key=info,

queue=queue_name

)

print('start to receive [{}]'.format(info))

channel.basic_consume(

on_message_callback=self.callback_func,

queue=queue_name,

auto_ack=True,

)

channel.start_consuming()

def callback_func(self, ch, method, properties, body):

print(body)

启动spider:

from scrapy import cmdline

cmdline.execute('scrapy crawl rabbit'.split())

然后往rabbitmq里面推送数据: