python

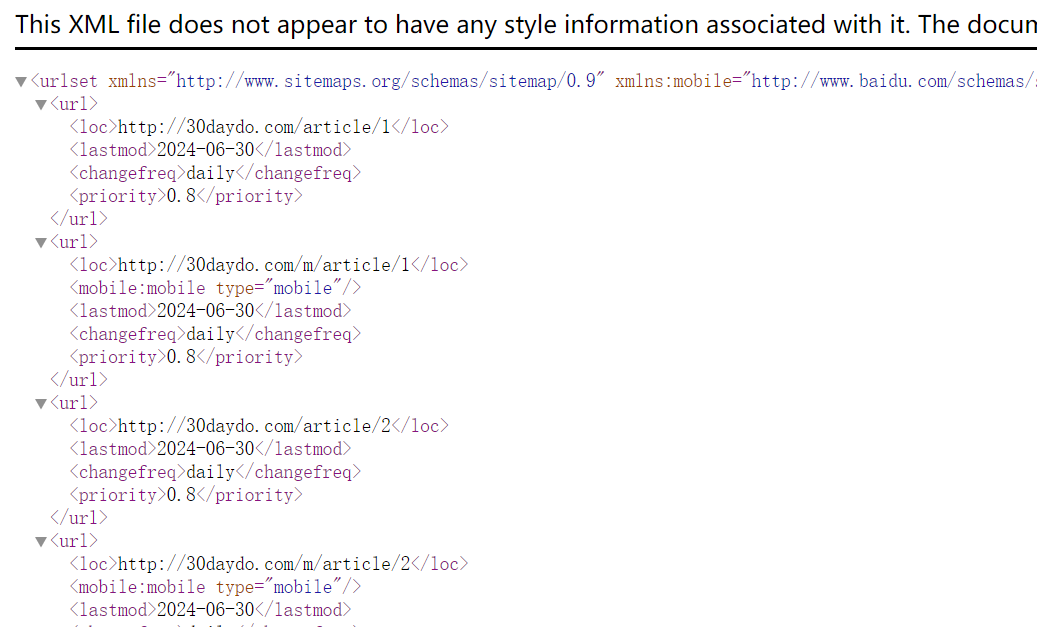

python自动生成网站sitemap.xml 代码

python • 李魔佛 发表了文章 • 0 个评论 • 2305 次浏览 • 2024-06-30 13:32

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9" xmlns:mobile="http://www.baidu.com/schemas/s ... gt%3B

<url>

<loc>http://30daydo.com/article/1</loc>

<mobile:mobile type="mobile"/>

<lastmod>2024-06-30</lastmod>

<changefreq>daily</changefreq>

<priority>0.8</priority>

</url>

</urlset>

然后我们要做的就是拿到我们页面上所有的链接地址,填充到这里:

<url>

<loc>http://30daydo.com/article/1</loc>

<mobile:mobile type="mobile"/>

<lastmod>2024-06-30</lastmod>

<changefreq>daily</changefreq>

<priority>0.8</priority>

</url>

只需要替换上面的http://30daydo.com/article/1 地址就可以了。这个你跟你的完整url规律生成,或者从数据库读取就好了。

然后生成一个文件,自动复制到文章目录就可以了。

完整源码:

https://github.com/Rockyzsu/sitemap_generator

欢迎star,有问题留言。

查看全部

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9" xmlns:mobile="http://www.baidu.com/schemas/s ... gt%3B

<url>

<loc>http://30daydo.com/article/1</loc>

<mobile:mobile type="mobile"/>

<lastmod>2024-06-30</lastmod>

<changefreq>daily</changefreq>

<priority>0.8</priority>

</url>

</urlset>

然后我们要做的就是拿到我们页面上所有的链接地址,填充到这里:

<url>

<loc>http://30daydo.com/article/1</loc>

<mobile:mobile type="mobile"/>

<lastmod>2024-06-30</lastmod>

<changefreq>daily</changefreq>

<priority>0.8</priority>

</url>

只需要替换上面的http://30daydo.com/article/1 地址就可以了。这个你跟你的完整url规律生成,或者从数据库读取就好了。

然后生成一个文件,自动复制到文章目录就可以了。

完整源码:

https://github.com/Rockyzsu/sitemap_generator

欢迎star,有问题留言。

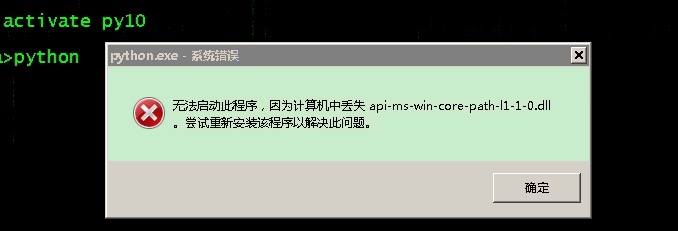

anaconda安装python报错 缺少:api-ms-win-core-path-l1-1-0.dll

python • 马化云 发表了文章 • 0 个评论 • 3336 次浏览 • 2023-03-30 18:16

少了dll文件。

于是学网上(csdn)的方法进行修复,把缺的dll下载下来复制到system32的目录。

但是后面还是报错。

Python path configuration:

PYTHONHOME = (not set)

PYTHONPATH = (not set)

program name = 'python'

isolated = 0

environment = 1

user site = 1

import site = 1

sys._base_executable = '\u0158\x06'

sys.base_prefix = '.'

sys.base_exec_prefix = '.'

sys.executable = '\u0158\x06'

sys.prefix = '.'

sys.exec_prefix = '.'

sys.path = [

'C:\\anaconda\\python38.zip',

'.\\DLLs',

'.\\lib',

'',

]

Fatal Python error: init_fs_encoding: failed to get the Python codec of the filesystem encodin

Python runtime state: core initialized

ModuleNotFoundError: No module named 'encodings'

Current thread 0x000013a8 (most recent call first):

后面才发现,win7的机子只能安装python3.8以下的版本,高版本会报错。

查看全部

少了dll文件。

于是学网上(csdn)的方法进行修复,把缺的dll下载下来复制到system32的目录。

但是后面还是报错。

Python path configuration:

PYTHONHOME = (not set)

PYTHONPATH = (not set)

program name = 'python'

isolated = 0

environment = 1

user site = 1

import site = 1

sys._base_executable = '\u0158\x06'

sys.base_prefix = '.'

sys.base_exec_prefix = '.'

sys.executable = '\u0158\x06'

sys.prefix = '.'

sys.exec_prefix = '.'

sys.path = [

'C:\\anaconda\\python38.zip',

'.\\DLLs',

'.\\lib',

'',

]

Fatal Python error: init_fs_encoding: failed to get the Python codec of the filesystem encodin

Python runtime state: core initialized

ModuleNotFoundError: No module named 'encodings'

Current thread 0x000013a8 (most recent call first):

后面才发现,win7的机子只能安装python3.8以下的版本,高版本会报错。

python父类如何判断子类时候实现了某个方法或者属性赋值

python • 李魔佛 发表了文章 • 0 个评论 • 2518 次浏览 • 2022-12-04 10:47

看看下面的例子 class Parent:

def __init__(self):

self.name='parent'

self.age=10

def run(self):

if hasattr(self,'get_salary'):

print('has func')

print(self.get_salary())

class Child(Parent):

def __init__(self):

# self.name='child'

Parent.__init__(self)

self.salary=100

def get_salary(self):

return self.salary

obj = Child()

obj.run()

obj.run调用的是parent里面的方法。

而parent的run里面调用一个hasattr, 来判断self 是否有get_salary这个函数。

因为self是从子类传进去的,所以self实际是 child的实例。

因为child里面是有get_salary方法(属性)的,所以hasatrr 是返回true, 然后调用子类的self.get_salary

从而程序没有报错。打印正确的返回数据

查看全部

看看下面的例子

class Parent:

def __init__(self):

self.name='parent'

self.age=10

def run(self):

if hasattr(self,'get_salary'):

print('has func')

print(self.get_salary())

class Child(Parent):

def __init__(self):

# self.name='child'

Parent.__init__(self)

self.salary=100

def get_salary(self):

return self.salary

obj = Child()

obj.run()

obj.run调用的是parent里面的方法。

而parent的run里面调用一个hasattr, 来判断self 是否有get_salary这个函数。

因为self是从子类传进去的,所以self实际是 child的实例。

因为child里面是有get_salary方法(属性)的,所以hasatrr 是返回true, 然后调用子类的self.get_salary

从而程序没有报错。打印正确的返回数据

Django mysql SSL 证书配置

数据库 • 马化云 发表了文章 • 0 个评论 • 2724 次浏览 • 2022-10-13 15:35

具体配置如下:

ca_path = '/etc/ssl/certs/ca-certificates.crt' # 证书地址

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'NAME': 'wordpress',

'USER': 'root',

'PASSWORD': '123456',

'HOST': '127.0.0.1`',

'PORT': 3306,

'OPTIONS': {'ssl':{'KEY': ca_path}}

}

} 查看全部

具体配置如下:

ca_path = '/etc/ssl/certs/ca-certificates.crt' # 证书地址

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'NAME': 'wordpress',

'USER': 'root',

'PASSWORD': '123456',

'HOST': '127.0.0.1`',

'PORT': 3306,

'OPTIONS': {'ssl':{'KEY': ca_path}}

}

}

SQLAlchemy mysql ssl证书 连接

数据库 • 马化云 发表了文章 • 0 个评论 • 2970 次浏览 • 2022-10-09 20:50

需要加上参数:

connect_args,加上ssl路径。

from sqlalchemy import create_engine

ca_path = '/etc/ssl/certs/ca-certificates.crt' # linux 证书路径

ssl_args = {'ssl_ca': ca_path}

engine = create_engine('mysql+pymysql://root:password@127.0.01:3306/wordpressdb?charset=utf8',

echo = True,

connect_args=ssl_args

) 查看全部

需要加上参数:

connect_args,加上ssl路径。

from sqlalchemy import create_engine

ca_path = '/etc/ssl/certs/ca-certificates.crt' # linux 证书路径

ssl_args = {'ssl_ca': ca_path}

engine = create_engine('mysql+pymysql://root:password@127.0.01:3306/wordpressdb?charset=utf8',

echo = True,

connect_args=ssl_args

)

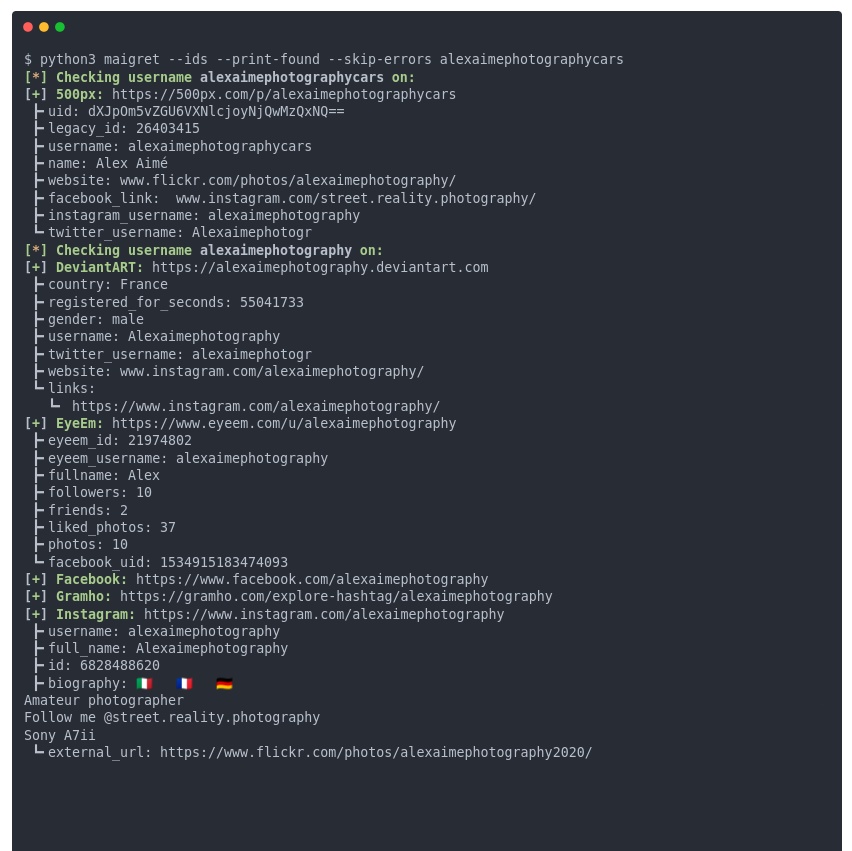

python社工库合集

网络安全 • 马化云 发表了文章 • 0 个评论 • 3733 次浏览 • 2022-10-08 17:30

这个项目太吓人了,输入 id,就能把互联网上你的相关账号全部扒出来,而且不仅仅是简单的 id 匹配,你的用户资料字段也会被匹配,而且连 pornhub/xvideo 账号都有。

使用方法(python):

# install from pypi

pip3 install maigret

# usage

maigret username

个人亲测了一下,这个库主要针对国内外一些大型的网站进行扫描,得到的结果还是很准的。

如果有专门针对国内网站的库,欢迎留言回复~

查看全部

https://github.com/soxoj/maigret

这个项目太吓人了,输入 id,就能把互联网上你的相关账号全部扒出来,而且不仅仅是简单的 id 匹配,你的用户资料字段也会被匹配,而且连 pornhub/xvideo 账号都有。

使用方法(python):

# install from pypi

pip3 install maigret

# usage

maigret username

个人亲测了一下,这个库主要针对国内外一些大型的网站进行扫描,得到的结果还是很准的。

如果有专门针对国内网站的库,欢迎留言回复~

国庆节 微信头像红旗 制作 附 python代码 和 红旗素材

python • 马化云 发表了文章 • 0 个评论 • 3650 次浏览 • 2022-09-23 10:31

给自己制作国旗头像,是一件很有意义的事。微信官方就曾经举办过活动。

制作国旗头像的方法有很多,本文给大家介绍用Python制作渐变的微信国旗头像。

渐变的国旗头像效果非常好看。

制作方式也很简单,下面介绍实现方法,可以复制本文的代码,制作属于自己的国旗头像。

1.准备国旗图片

声明:严禁非法使用国旗图片。在国旗图片下载页面下方有《国旗法》等相关规定。

本文使用1024像素的图片。

2.准备头像图片

登录自己的微信,打开个人信息,点击头像,点击右上角的三个点,将图片保存到手机,

然后将图片传到电脑上。

为了不失一般性,本文使用的图片是我从网络上获取的一张600*600像素的头像图片。

准备好后,将国旗图片和头像图片拷贝到代码同一个目录下。

代码实现

先安装Python中用于处理图片的pillow库。

pip install pillow

安装完成后,使用pillow库来制作国旗头像。

只需要十几行代码就能实现。完整代码如下。

# coding=utf-8

from PIL import Image

import math

key = 3.2# 修改key值可以调整国旗的范围,推荐2~4之间的数字,支持小数

motherland_flag = Image.open('flag-1024.png')

head_picture = Image.open('mmexport1663893338571.png')

# 截图国旗上的五颗五角星

flag_width, flag_height = motherland_flag.size

crop_flag = motherland_flag.crop((66, 0, flag_height+66, flag_height))

# 将国旗截图处理成颜色渐变

for i in range(flag_height):

for j in range(flag_height):

color = crop_flag.getpixel((i, j))

distance = int(math.sqrt(i*i + j*j))

alpha = 255 - int(distance//key)

new_color = (*color[0:-1], alpha if alpha > 0 else 0)

crop_flag.putpixel((i, j), new_color)

# 修改渐变图片的尺寸,适应头像大小,粘贴到头像上

new_crop_flag = crop_flag.resize(head_picture.size)

head_picture.paste(new_crop_flag, (0, 0), new_crop_flag)

# 保存自己的国旗头像

head_picture.save('国旗头像.png')

到此为止,已经制作好了国旗头像了。

下面是代码的详细结束:

代码介绍:代码介绍:

导入需要使用的Python库,pillow库用于对图片进行截取、大小修改、粘贴等处理。math库用于计算像素点的距离。

使用Image.open()方法,读取准备好的国旗图片和头像图片到代码中。

对国旗图片进行截取,获取一张正方形的图片,截取时调整截取位置,保证5颗五角星完整展示在截图中。

crop()方法中传入的是一个(left, upper, right, lower)的元组,分别是截图的左、上、右、下像素位置。

将正方形国旗截图设置成透明度渐变的图片。国旗图片的模式默认是RGBA,本文需要的刚好是RGBA(red,green,blue,alpha)模式的图片,RGBA模式的图片颜色值是一个长度为4的元组,我们修改不同像素点的A值即可将图片设置成渐变。

本文是以国旗左上角为圆心,离圆心越远的像素点A值越小,像素点越透明。使用getpixel()和putpixel()两个方法来获取和重设像素点的颜色值,使用math.sqrt()计算像素点距离。

将渐变图片的大小转换成和头像的大小一样,然后粘贴到图片顶层。使用resize()方法重设图片大小,使用paste()方法粘贴图片。

保存图片,此时的微信头像图片上已经粘贴了透明渐变的国旗图片,微信国旗头像制作完成。

本文介绍了用Python制作微信国旗头像的方法。在本文的代码中,以左上角为圆心,离圆心越远越透明,可以修改key值,调整国旗透明变化的范围。

如果需要制作其他渐变类型,如以右上角为圆心逐渐透明、从左侧向右侧逐渐透明、从上到下逐渐透明等,可以修改国旗渐变部分的代码、翻转图片等。

查看全部

给自己制作国旗头像,是一件很有意义的事。微信官方就曾经举办过活动。

制作国旗头像的方法有很多,本文给大家介绍用Python制作渐变的微信国旗头像。

渐变的国旗头像效果非常好看。

制作方式也很简单,下面介绍实现方法,可以复制本文的代码,制作属于自己的国旗头像。

1.准备国旗图片

声明:严禁非法使用国旗图片。在国旗图片下载页面下方有《国旗法》等相关规定。

本文使用1024像素的图片。

2.准备头像图片

登录自己的微信,打开个人信息,点击头像,点击右上角的三个点,将图片保存到手机,

然后将图片传到电脑上。

为了不失一般性,本文使用的图片是我从网络上获取的一张600*600像素的头像图片。

准备好后,将国旗图片和头像图片拷贝到代码同一个目录下。

代码实现

先安装Python中用于处理图片的pillow库。

pip install pillow

安装完成后,使用pillow库来制作国旗头像。

只需要十几行代码就能实现。完整代码如下。

# coding=utf-8

from PIL import Image

import math

key = 3.2# 修改key值可以调整国旗的范围,推荐2~4之间的数字,支持小数

motherland_flag = Image.open('flag-1024.png')

head_picture = Image.open('mmexport1663893338571.png')

# 截图国旗上的五颗五角星

flag_width, flag_height = motherland_flag.size

crop_flag = motherland_flag.crop((66, 0, flag_height+66, flag_height))

# 将国旗截图处理成颜色渐变

for i in range(flag_height):

for j in range(flag_height):

color = crop_flag.getpixel((i, j))

distance = int(math.sqrt(i*i + j*j))

alpha = 255 - int(distance//key)

new_color = (*color[0:-1], alpha if alpha > 0 else 0)

crop_flag.putpixel((i, j), new_color)

# 修改渐变图片的尺寸,适应头像大小,粘贴到头像上

new_crop_flag = crop_flag.resize(head_picture.size)

head_picture.paste(new_crop_flag, (0, 0), new_crop_flag)

# 保存自己的国旗头像

head_picture.save('国旗头像.png')

到此为止,已经制作好了国旗头像了。

下面是代码的详细结束:

代码介绍:

代码介绍:

导入需要使用的Python库,pillow库用于对图片进行截取、大小修改、粘贴等处理。math库用于计算像素点的距离。

使用Image.open()方法,读取准备好的国旗图片和头像图片到代码中。

对国旗图片进行截取,获取一张正方形的图片,截取时调整截取位置,保证5颗五角星完整展示在截图中。

crop()方法中传入的是一个(left, upper, right, lower)的元组,分别是截图的左、上、右、下像素位置。

将正方形国旗截图设置成透明度渐变的图片。国旗图片的模式默认是RGBA,本文需要的刚好是RGBA(red,green,blue,alpha)模式的图片,RGBA模式的图片颜色值是一个长度为4的元组,我们修改不同像素点的A值即可将图片设置成渐变。

本文是以国旗左上角为圆心,离圆心越远的像素点A值越小,像素点越透明。使用getpixel()和putpixel()两个方法来获取和重设像素点的颜色值,使用math.sqrt()计算像素点距离。

将渐变图片的大小转换成和头像的大小一样,然后粘贴到图片顶层。使用resize()方法重设图片大小,使用paste()方法粘贴图片。

保存图片,此时的微信头像图片上已经粘贴了透明渐变的国旗图片,微信国旗头像制作完成。

本文介绍了用Python制作微信国旗头像的方法。在本文的代码中,以左上角为圆心,离圆心越远越透明,可以修改key值,调整国旗透明变化的范围。

如果需要制作其他渐变类型,如以右上角为圆心逐渐透明、从左侧向右侧逐渐透明、从上到下逐渐透明等,可以修改国旗渐变部分的代码、翻转图片等。

6行python代码 获取通达信的可转债分时数据

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 3864 次浏览 • 2022-08-27 14:33

api = TdxHq_API()

with api.connect('119.147.212.81', 7709):

data = api.get_security_bars(7, 0, '123045', 0, 240) # 123045 为转债代码 ,240 为获取 240个转债数据

df = api.to_df(data)

df=df.sort_values('datetime')

点击查看大图

如果需要遍历当前最新可转债代码(集思录),需要结合前面的文章。

公众号:

查看全部

ptrade如何以指定价格下单?

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 3706 次浏览 • 2022-07-30 19:27

order函数:order-按数量买卖

order(security, amount, limit_price=None)

买卖标的。

注意:

由于下述原因,回测中实际买入或者卖出的股票数量有时候可能与委托设置的不一样,针对上述内容调整,系统会在日志中增加警告信息:

根据委托买入数量与价格经计算后的资金数量,大于当前可用资金;

委托卖出数量大于当前可用持仓数量;

每次交易数量只能是100的整数倍,但是卖出所有股票时不受此限制;

股票停牌、股票未上市或者退市、股票不存在;

回测中每天结束时会取消所有未完成交易;

order_target - 函数order_target(security, amount, limit_price=None)

买卖股票,直到股票最终数量达到指定的amount。

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

参数

security: 股票代码(str);

amount: 期望的最终数量(int);

limit_price:买卖限价(float);

返回

Order对象中的id或者None。如果创建订单成功,则返回Order对象的id,失败则返回None(str)。

order_value 函数order_value - 指定目标价值买卖

order_value(security, value, limit_price=None)

买卖指定价值为value的股票。

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

order_target_value - 函数order_target_value - 指定持仓市值买卖

order_target_value(security, value, limit_price=None)

调整股票仓位到value价值

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

order_market 函数order_market - 按市价进行委托

order_market(security, amount, market_type=None, limit_price=None)

可以使用多种市价类型进行委托。

注意:该函数仅在股票交易模块可用。

上面几个在handle_data中使用的下单函数,都是无法指定价格的,limit_price 只是用于限价,比如你要卖1000股,limit_price的作用是不要把价格卖出你的目标,至于多少卖,是无法控制的。

但是有一个tick_data函数,专门用于行情交易的,里面可调用的函数也很少。tick_data(可选)

tick_data(context, data)

该函数会每隔3秒执行一次。

注意 :

该函数仅在交易模块可用。

该函数在9:30之后才能执行。

该函数中只能使用order_tick进行对应的下单操作。里面下单,用的下单函数是

order_tick - tick行情触发买卖

order_tick(sid, amount, priceGear='1', limit_price=None)

买卖股票下单,可设定价格档位进行委托

注意:该函数仅在交易模块可用。

参数

sid:股票代码(str);

amount:交易数量,正数表示买入,负数表示卖出(int)

priceGear:盘口档位,level1:1~5买档/-1~-5卖档,level2:1~10买档/-1~-10卖档(str)

limit_price:买卖限价,当输入参数中也包含priceGear时,下单价格以limit_price为主(float);

注意到里面:

limit_price:买卖限价,当输入参数中也包含priceGear时,下单价格以limit_price为主

发现这里面居然可以定义价格下单,所以如果一定要指定价格,就需要使用tick_data 触发。

使用代码:

def initialize(context):

g.security = "600570.SS"

set_universe(g.security)

def tick_data(context,data):

security = g.security

current_price = eval(data[security]['tick']['bid_grp'][0])[1][0]

if current_price > 56 and current_price < 57:

# 以买一档下单

order_tick(g.security, -100, "1")

# 以卖二档下单

order_tick(g.security, 100, "-2")

# 以指定价格下单

order_tick(g.security, 100, limit_price=56.5)

def handle_data(context, data):

pass 查看全部

order函数:

order-按数量买卖

order(security, amount, limit_price=None)

买卖标的。

注意:

由于下述原因,回测中实际买入或者卖出的股票数量有时候可能与委托设置的不一样,针对上述内容调整,系统会在日志中增加警告信息:

根据委托买入数量与价格经计算后的资金数量,大于当前可用资金;

委托卖出数量大于当前可用持仓数量;

每次交易数量只能是100的整数倍,但是卖出所有股票时不受此限制;

股票停牌、股票未上市或者退市、股票不存在;

回测中每天结束时会取消所有未完成交易;

order_target - 函数

order_target(security, amount, limit_price=None)

买卖股票,直到股票最终数量达到指定的amount。

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

参数

security: 股票代码(str);

amount: 期望的最终数量(int);

limit_price:买卖限价(float);

返回

Order对象中的id或者None。如果创建订单成功,则返回Order对象的id,失败则返回None(str)。

order_value 函数

order_value - 指定目标价值买卖

order_value(security, value, limit_price=None)

买卖指定价值为value的股票。

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

order_target_value - 函数

order_target_value - 指定持仓市值买卖

order_target_value(security, value, limit_price=None)

调整股票仓位到value价值

注意:该函数在委托股票时取整100股,委托可转债时取整100张。

order_market 函数

order_market - 按市价进行委托

order_market(security, amount, market_type=None, limit_price=None)

可以使用多种市价类型进行委托。

注意:该函数仅在股票交易模块可用。

上面几个在handle_data中使用的下单函数,都是无法指定价格的,limit_price 只是用于限价,比如你要卖1000股,limit_price的作用是不要把价格卖出你的目标,至于多少卖,是无法控制的。

但是有一个tick_data函数,专门用于行情交易的,里面可调用的函数也很少。

tick_data(可选)里面下单,用的下单函数是

tick_data(context, data)

该函数会每隔3秒执行一次。

注意 :

该函数仅在交易模块可用。

该函数在9:30之后才能执行。

该函数中只能使用order_tick进行对应的下单操作。

order_tick - tick行情触发买卖

order_tick(sid, amount, priceGear='1', limit_price=None)

买卖股票下单,可设定价格档位进行委托

注意:该函数仅在交易模块可用。

参数

sid:股票代码(str);

amount:交易数量,正数表示买入,负数表示卖出(int)

priceGear:盘口档位,level1:1~5买档/-1~-5卖档,level2:1~10买档/-1~-10卖档(str)

limit_price:买卖限价,当输入参数中也包含priceGear时,下单价格以limit_price为主(float);

注意到里面:

limit_price:买卖限价,当输入参数中也包含priceGear时,下单价格以limit_price为主

发现这里面居然可以定义价格下单,所以如果一定要指定价格,就需要使用tick_data 触发。

使用代码:

def initialize(context):

g.security = "600570.SS"

set_universe(g.security)

def tick_data(context,data):

security = g.security

current_price = eval(data[security]['tick']['bid_grp'][0])[1][0]

if current_price > 56 and current_price < 57:

# 以买一档下单

order_tick(g.security, -100, "1")

# 以卖二档下单

order_tick(g.security, 100, "-2")

# 以指定价格下单

order_tick(g.security, 100, limit_price=56.5)

def handle_data(context, data):

pass

国盛证券qmt mini模式 xtquant

券商万一免五 • 李魔佛 发表了文章 • 0 个评论 • 13773 次浏览 • 2022-07-29 01:00

【国盛QMT支持 xtquant qmt mini模式】

mini模式可以在外部运行,同时可以下载历史tick数据。xtdata是xtquant库中提供行情相关数据的模块,本模块旨在提供精简直接的数据满足量化交易者的数

据需求,作为python库的形式可以被灵活添加到各种策略脚本中。

主要提供行情数据(历史和实时的K线和分笔)、财务数据、合约基础信息、板块和行业分类信息等通

用的行情数据

可以直接获取level2的数据

使用python代码直接运行,不用在qmt软件里面憋屈地写代码,可直接使用pycharm,vscode编写,且有代码提示,补全,好用多了。

附一个完整的策略例子。

保存为: demo.py

命令行下运行:

python demo.py# 创建策略

#coding=utf-8

from xtquant.xttrader import XtQuantTrader, XtQuantTraderCallback

from xtquant.xtquant import StockAccount

from xtquant import xtconstant

class MyXtQuantTraderCallback(XtQuantTraderCallback):

def on_disconnected(self):

"""

连接断开

:return:

"""

print("connection lost")

def on_stock_order(self, order):

"""

委托回报推送

:param order: XtOrder对象

:return:

"""

print("on order callback:")

print(order.stock_code, order.order_status, order.order_sysid)

def on_stock_asset(self, asset):

"""

资金变动推送

:param asset: XtAsset对象

:return:

"""

print("on asset callback")

print(asset.account_id, asset.cash, asset.total_asset)

def on_stock_trade(self, trade):

"""

成交变动推送

:param trade: XtTrade对象

:return:

"""

print("on trade callback")

print(trade.account_id, trade.stock_code, trade.order_id)

def on_stock_position(self, position):

"""

持仓变动推送

:param position: XtPosition对象

:return:

"""

print("on position callback")

print(position.stock_code, position.volume)

def on_order_error(self, order_error):

"""

委托失败推送

:param order_error:XtOrderError 对象

:return:

"""

print("on order_error callback")

print(order_error.order_id, order_error.error_id, order_error.error_msg)

def on_cancel_error(self, cancel_error):

"""

撤单失败推送

:param cancel_error: XtCancelError 对象

:return:

"""

print("on cancel_error callback")

print(cancel_error.order_id, cancel_error.error_id,

cancel_error.error_msg)

def on_order_stock_async_response(self, response):

"""

异步下单回报推送

:param response: XtOrderResponse 对象

:return:

"""

print("on_order_stock_async_response")

print(response.account_id, response.order_id, response.seq)

if __name__ == "__main__":

print("demo test")

# path为mini qmt客户端安装目录下userdata_mini路径

path = 'D:\\迅投极速交易终端 睿智融科版\\userdata_mini'

# session_id为会话编号,策略使用方对于不同的Python策略需要使用不同的会话编号

session_id = 123456

xt_trader = XtQuantTrader(path, session_id)

# 创建资金账号为1000000365的证券账号对象

acc = StockAccount('1000000365')

# 创建交易回调类对象,并声明接收回调

callback = MyXtQuantTraderCallback()

xt_trader.register_callback(callback)

# 启动交易线程

xt_trader.start()

# 建立交易连接,返回0表示连接成功

connect_result = xt_trader.connect()

print(connect_result)

# 对交易回调进行订阅,订阅后可以收到交易主推,返回0表示订阅成功

subscribe_result = xt_trader.subscribe(acc)

print(subscribe_result)

stock_code = '600000.SH'

# 使用指定价下单,接口返回订单编号,后续可以用于撤单操作以及查询委托状态

print("order using the fix price:")

fix_result_order_id = xt_trader.order_stock(acc, stock_code,

xtconstant.STOCK_BUY, 200, xtconstant.FIX_PRICE, 10.5, 'strategy_name',

'remark')

print(fix_result_order_id)

# 使用订单编号撤单

print("cancel order:")

cancel_order_result = xt_trader.cancel_order_stock(acc, fix_result_order_id)

print(cancel_order_result)

# 使用异步下单接口,接口返回下单请求序号seq,seq可以和on_order_stock_async_response

的委托反馈response对应起来

print("order using async api:")

async_seq = xt_trader.order_stock(acc, stock_code, xtconstant.STOCK_BUY,

200, xtconstant.FIX_PRICE, 10.5, 'strategy_name', 'remark')

print(async_seq)

# 查询证券资产

print("query asset:")

asset = xt_trader.query_stock_asset(acc)

if asset:

print("asset:")

print("cash {0}".format(asset.cash))

# 根据订单编号查询委托

print("query order:")

order = xt_trader.query_stock_order(acc, fix_result_order_id)

if order:

print("order:")

print("order {0}".format(order.order_id))

# 查询当日所有的委托

print("query orders:")

orders = xt_trader.query_stock_orders(acc)

print("orders:", len(orders))

if len(orders) != 0:

print("last order:")

print("{0} {1} {2}".format(orders[-1].stock_code,

orders[-1].order_volume, orders[-1].price))

# 查询当日所有的成交

print("query trade:")

trades = xt_trader.query_stock_trades(acc)

print("trades:", len(trades))

if len(trades) != 0:

print("last trade:")

print("{0} {1} {2}".format(trades[-1].stock_code,

trades[-1].traded_volume, trades[-1].traded_price))

# 查询当日所有的持仓

print("query positions:")

positions = xt_trader.query_stock_positions(acc)

print("positions:", len(positions))

if len(positions) != 0:

print("last position:")

print("{0} {1} {2}".format(positions[-1].account_id,

positions[-1].stock_code, positions[-1].volume))

# 根据股票代码查询对应持仓

print("query position:")

position = xt_trader.query_stock_position(acc, stock_code)

if position:

print("position:")

print("{0} {1} {2}".format(position.account_id, position.stock_code,

position.volume))

# 阻塞线程,接收交易推送

xt_trader.run_forever()

开通xtquant的方式可以咨询。

目前开户费率低,门槛低,提供技术支持与交流。

需要的朋友,可以扫码咨询:

备注开户 查看全部

【国盛QMT支持 xtquant qmt mini模式】

mini模式可以在外部运行,同时可以下载历史tick数据。

xtdata是xtquant库中提供行情相关数据的模块,本模块旨在提供精简直接的数据满足量化交易者的数

据需求,作为python库的形式可以被灵活添加到各种策略脚本中。

主要提供行情数据(历史和实时的K线和分笔)、财务数据、合约基础信息、板块和行业分类信息等通

用的行情数据

可以直接获取level2的数据

使用python代码直接运行,不用在qmt软件里面憋屈地写代码,可直接使用pycharm,vscode编写,且有代码提示,补全,好用多了。

附一个完整的策略例子。

保存为: demo.py

命令行下运行:

python demo.py

# 创建策略

#coding=utf-8

from xtquant.xttrader import XtQuantTrader, XtQuantTraderCallback

from xtquant.xtquant import StockAccount

from xtquant import xtconstant

class MyXtQuantTraderCallback(XtQuantTraderCallback):

def on_disconnected(self):

"""

连接断开

:return:

"""

print("connection lost")

def on_stock_order(self, order):

"""

委托回报推送

:param order: XtOrder对象

:return:

"""

print("on order callback:")

print(order.stock_code, order.order_status, order.order_sysid)

def on_stock_asset(self, asset):

"""

资金变动推送

:param asset: XtAsset对象

:return:

"""

print("on asset callback")

print(asset.account_id, asset.cash, asset.total_asset)

def on_stock_trade(self, trade):

"""

成交变动推送

:param trade: XtTrade对象

:return:

"""

print("on trade callback")

print(trade.account_id, trade.stock_code, trade.order_id)

def on_stock_position(self, position):

"""

持仓变动推送

:param position: XtPosition对象

:return:

"""

print("on position callback")

print(position.stock_code, position.volume)

def on_order_error(self, order_error):

"""

委托失败推送

:param order_error:XtOrderError 对象

:return:

"""

print("on order_error callback")

print(order_error.order_id, order_error.error_id, order_error.error_msg)

def on_cancel_error(self, cancel_error):

"""

撤单失败推送

:param cancel_error: XtCancelError 对象

:return:

"""

print("on cancel_error callback")

print(cancel_error.order_id, cancel_error.error_id,

cancel_error.error_msg)

def on_order_stock_async_response(self, response):

"""

异步下单回报推送

:param response: XtOrderResponse 对象

:return:

"""

print("on_order_stock_async_response")

print(response.account_id, response.order_id, response.seq)

if __name__ == "__main__":

print("demo test")

# path为mini qmt客户端安装目录下userdata_mini路径

path = 'D:\\迅投极速交易终端 睿智融科版\\userdata_mini'

# session_id为会话编号,策略使用方对于不同的Python策略需要使用不同的会话编号

session_id = 123456

xt_trader = XtQuantTrader(path, session_id)

# 创建资金账号为1000000365的证券账号对象

acc = StockAccount('1000000365')

# 创建交易回调类对象,并声明接收回调

callback = MyXtQuantTraderCallback()

xt_trader.register_callback(callback)

# 启动交易线程

xt_trader.start()

# 建立交易连接,返回0表示连接成功

connect_result = xt_trader.connect()

print(connect_result)

# 对交易回调进行订阅,订阅后可以收到交易主推,返回0表示订阅成功

subscribe_result = xt_trader.subscribe(acc)

print(subscribe_result)

stock_code = '600000.SH'

# 使用指定价下单,接口返回订单编号,后续可以用于撤单操作以及查询委托状态

print("order using the fix price:")

fix_result_order_id = xt_trader.order_stock(acc, stock_code,

xtconstant.STOCK_BUY, 200, xtconstant.FIX_PRICE, 10.5, 'strategy_name',

'remark')

print(fix_result_order_id)

# 使用订单编号撤单

print("cancel order:")

cancel_order_result = xt_trader.cancel_order_stock(acc, fix_result_order_id)

print(cancel_order_result)

# 使用异步下单接口,接口返回下单请求序号seq,seq可以和on_order_stock_async_response

的委托反馈response对应起来

print("order using async api:")

async_seq = xt_trader.order_stock(acc, stock_code, xtconstant.STOCK_BUY,

200, xtconstant.FIX_PRICE, 10.5, 'strategy_name', 'remark')

print(async_seq)

# 查询证券资产

print("query asset:")

asset = xt_trader.query_stock_asset(acc)

if asset:

print("asset:")

print("cash {0}".format(asset.cash))

# 根据订单编号查询委托

print("query order:")

order = xt_trader.query_stock_order(acc, fix_result_order_id)

if order:

print("order:")

print("order {0}".format(order.order_id))

# 查询当日所有的委托

print("query orders:")

orders = xt_trader.query_stock_orders(acc)

print("orders:", len(orders))

if len(orders) != 0:

print("last order:")

print("{0} {1} {2}".format(orders[-1].stock_code,

orders[-1].order_volume, orders[-1].price))

# 查询当日所有的成交

print("query trade:")

trades = xt_trader.query_stock_trades(acc)

print("trades:", len(trades))

if len(trades) != 0:

print("last trade:")

print("{0} {1} {2}".format(trades[-1].stock_code,

trades[-1].traded_volume, trades[-1].traded_price))

# 查询当日所有的持仓

print("query positions:")

positions = xt_trader.query_stock_positions(acc)

print("positions:", len(positions))

if len(positions) != 0:

print("last position:")

print("{0} {1} {2}".format(positions[-1].account_id,

positions[-1].stock_code, positions[-1].volume))

# 根据股票代码查询对应持仓

print("query position:")

position = xt_trader.query_stock_position(acc, stock_code)

if position:

print("position:")

print("{0} {1} {2}".format(position.account_id, position.stock_code,

position.volume))

# 阻塞线程,接收交易推送

xt_trader.run_forever()

开通xtquant的方式可以咨询。

目前开户费率低,门槛低,提供技术支持与交流。

需要的朋友,可以扫码咨询:

备注开户

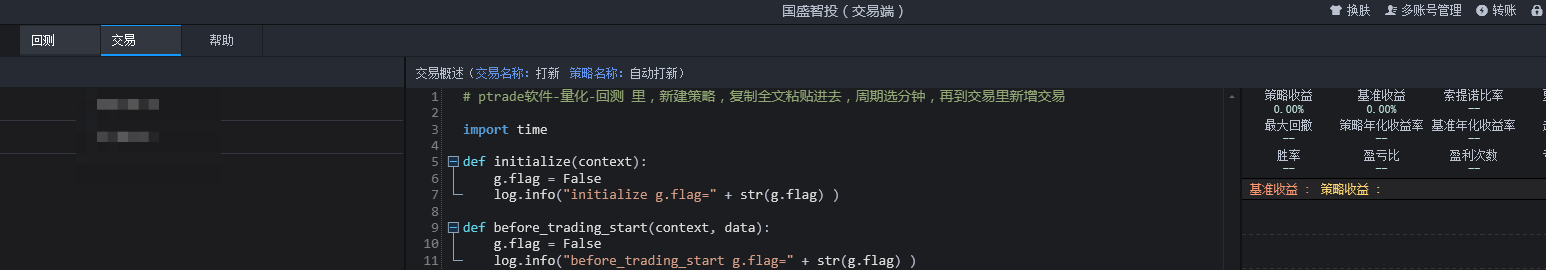

ptrade每天自动打新 (新股和可转债)附python代码

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 5340 次浏览 • 2022-07-28 11:10

def initialize(context):

g.flag = False

log.info("initialize g.flag=" + str(g.flag) )

def before_trading_start(context, data):

g.flag = False

log.info("before_trading_start g.flag=" + str(g.flag) )

def handle_data(context, data):

if not g.flag and time.strftime("%H:%M:%S", time.localtime()) > '09:35:00':

# 自动打新

log.info("自动打新")

ipo_stocks_order()

g.flag = True

def on_order_response(context, order_list):

# 该函数会在委托回报返回时响应

log.info(order_list)

交易页面

程序运行返回代码:

点击查看大图

【如果没有打新额度或者没有开通对应的权限,会显示可收购为0】

底下的成功的是可转债申购成功。

然后可以到券商app上看看是否已经有自动申购成功的记录。 查看全部

import time

def initialize(context):

g.flag = False

log.info("initialize g.flag=" + str(g.flag) )

def before_trading_start(context, data):

g.flag = False

log.info("before_trading_start g.flag=" + str(g.flag) )

def handle_data(context, data):

if not g.flag and time.strftime("%H:%M:%S", time.localtime()) > '09:35:00':

# 自动打新

log.info("自动打新")

ipo_stocks_order()

g.flag = True

def on_order_response(context, order_list):

# 该函数会在委托回报返回时响应

log.info(order_list)

交易页面

程序运行返回代码:

点击查看大图

【如果没有打新额度或者没有开通对应的权限,会显示可收购为0】

底下的成功的是可转债申购成功。

然后可以到券商app上看看是否已经有自动申购成功的记录。

ciso8601 性能对比 datetime 默认库

python • 李魔佛 发表了文章 • 0 个评论 • 2380 次浏览 • 2022-07-22 12:04

In [2]: ds = u'2014-01-09T21:48:00.921000'

In [3]: %timeit ciso8601.parse_datetime(ds)

1000000 loops, best of 3: 204 ns per loop

In [4]: %timeit datetime.datetime.strptime(ds, "%Y-%m-%dT%H:%M:%S.%f")

100000 loops, best of 3: 15 µs per loop

In [5]: %timeit dateutil.parser.parse(ds)

10000 loops, best of 3: 122 µs per loop

In [6]: %timeit aniso8601.parse_datetime(ds)

10000 loops, best of 3: 28.9 µs per loop

In [7]: %timeit iso8601.parse_date(ds)

10000 loops, best of 3: 42 µs per loop

In [8]: %timeit isodate.parse_datetime(ds)

10000 loops, best of 3: 69.4 µs per loop

In [9]: %timeit arrow.get(ds).datetime

10000 loops, best of 3: 87 µs per loopIn [1]: import datetime, aniso8601, iso8601, isodate, dateutil.parser, arrow, ciso8601

In [2]: ds = u'2014-01-09T21:48:00.921000+05:30'

In [3]: %timeit ciso8601.parse_datetime(ds)

1000000 loops, best of 3: 525 ns per loop

In [4]: %timeit dateutil.parser.parse(ds)

10000 loops, best of 3: 162 µs per loop

In [5]: %timeit aniso8601.parse_datetime(ds)

10000 loops, best of 3: 36.8 µs per loop

In [6]: %timeit iso8601.parse_date(ds)

10000 loops, best of 3: 53.5 µs per loop

In [7]: %timeit isodate.parse_datetime(ds)

10000 loops, best of 3: 82.6 µs per loop

In [8]: %timeit arrow.get(ds).datetime

10000 loops, best of 3: 104 µs per loop

Even with time zone information, ciso8601 is 70x as fast as aniso8601.

Tested on Python 2.7.10 on macOS 10.12.6 using the following modules:

ciso8601 是纳秒级别的,如果要对上千万的数据操作,建议使用ciso这个C库。

查看全部

In [1]: import datetime, aniso8601, iso8601, isodate, dateutil.parser, arrow, ciso8601

In [2]: ds = u'2014-01-09T21:48:00.921000'

In [3]: %timeit ciso8601.parse_datetime(ds)

1000000 loops, best of 3: 204 ns per loop

In [4]: %timeit datetime.datetime.strptime(ds, "%Y-%m-%dT%H:%M:%S.%f")

100000 loops, best of 3: 15 µs per loop

In [5]: %timeit dateutil.parser.parse(ds)

10000 loops, best of 3: 122 µs per loop

In [6]: %timeit aniso8601.parse_datetime(ds)

10000 loops, best of 3: 28.9 µs per loop

In [7]: %timeit iso8601.parse_date(ds)

10000 loops, best of 3: 42 µs per loop

In [8]: %timeit isodate.parse_datetime(ds)

10000 loops, best of 3: 69.4 µs per loop

In [9]: %timeit arrow.get(ds).datetime

10000 loops, best of 3: 87 µs per loop

In [1]: import datetime, aniso8601, iso8601, isodate, dateutil.parser, arrow, ciso8601

In [2]: ds = u'2014-01-09T21:48:00.921000+05:30'

In [3]: %timeit ciso8601.parse_datetime(ds)

1000000 loops, best of 3: 525 ns per loop

In [4]: %timeit dateutil.parser.parse(ds)

10000 loops, best of 3: 162 µs per loop

In [5]: %timeit aniso8601.parse_datetime(ds)

10000 loops, best of 3: 36.8 µs per loop

In [6]: %timeit iso8601.parse_date(ds)

10000 loops, best of 3: 53.5 µs per loop

In [7]: %timeit isodate.parse_datetime(ds)

10000 loops, best of 3: 82.6 µs per loop

In [8]: %timeit arrow.get(ds).datetime

10000 loops, best of 3: 104 µs per loop

Even with time zone information, ciso8601 is 70x as fast as aniso8601.

Tested on Python 2.7.10 on macOS 10.12.6 using the following modules:

ciso8601 是纳秒级别的,如果要对上千万的数据操作,建议使用ciso这个C库。

python安装demjson报错:error in setup command: use_2to3 is invalid.

python • 李魔佛 发表了文章 • 0 个评论 • 3712 次浏览 • 2022-06-06 19:23

随便整一个

pip install setuptools==57.5.0

原因:在setuptools 58之后的版本已经废弃了use_2to3所以安装一个旧版本的setuptools就可以了

随便整一个

pip install setuptools==57.5.0

B站批量下载某个UP主的所有视频

python • 李魔佛 发表了文章 • 0 个评论 • 4862 次浏览 • 2022-05-21 18:48

使用python实现

https://github.com/Rockyzsu/bilibili

B站视频下载

自动批量下载B站一个系列的视频

下载某个UP主的所有视频

使用:

下载you-get库,git clone https://github.com/soimort/you-get.git 复制其本地路径,比如/root/you-get/you-get

初次运行,删除history.db 文件, 修改配置文件config.py

START=1 # 下载系列视频的 第一个

END=1 # 下载系列视频的最后一个 , 比如一个系列教程有30个视频, start=5 ,end = 20 下载从第5个到第20个

ID='BV1oK411L7au' # 视频的ID

YOU_GET_PATH='/home/xda/othergit/you-get/you-get' # 你的you-get路径

MINS=1 # 每次循环等待1分钟

user_id = '518973111' # UP主的ID

total_page = 3 # up主的视频的页数

执行 python downloader.py ,进行下载循环

python people.py ,把某个up主的视频链接加入到待下载队列

python add_data.py --id=BV1oK411L7au --start=4 --end=8 下载视频id为BV1oK411L7au的系列教程,从第4开始,到第8个结束,如果只有一个的话,start和end设为1即可。

可以不断地往队列里面添加下载链接。

主要代码:

# @Time : 2019/1/28 14:19

# @File : youtube_downloader.py

import logging

import os

import subprocess

import datetime

import sqlite3

import time

from config import YOU_GET_PATH,MINS

CMD = 'python {} {}'

filename = 'url.txt'

class SQLite():

def __init__(self):

self.conn = sqlite3.connect('history.db')

self.cursor = self.conn.cursor()

self.create_table()

def create_table(self):

create_sql = 'create table if not exists tb_download (url varchar(100),status tinyint,crawltime datetime)'

create_record_tb = 'create table if not exists tb_record (idx varchar(100) PRIMARY KEY,start tinyint,end tinyint,status tinyint)'

self.cursor.execute(create_record_tb)

self.conn.commit()

self.cursor.execute(create_sql)

self.conn.commit()

def exists(self,url):

querySet = 'select * from tb_download where url = ? and status = 1'

self.cursor.execute(querySet,(url,))

ret = self.cursor.fetchone()

return True if ret else False

def insert_history(self,url,status):

query = 'select * from tb_download where url=?'

self.cursor.execute(query,(url,))

ret = self.cursor.fetchone()

current = datetime.datetime.now()

if ret:

insert_sql='update tb_download set status=?,crawltime=? where url = ?'

args=(status,status,current,url)

else:

insert_sql = 'insert into tb_download values(?,?,?)'

args=(url,status,current)

try:

self.cursor.execute(insert_sql,args)

except:

self.conn.rollback()

return False

else:

self.conn.commit()

return True

def get(self):

sql = 'select idx,start,end from tb_record where status=0'

self.cursor.execute(sql)

ret= self.cursor.fetchone()

return ret

def set(self,idx):

print('set status =1')

sql='update tb_record set status=1 where idx=?'

self.cursor.execute(sql,(idx,))

self.conn.commit()

def llogger(filename):

logger = logging.getLogger(filename) # 不加名称设置root logger

logger.setLevel(logging.DEBUG) # 设置输出级别

formatter = logging.Formatter(

'[%(asctime)s][%(filename)s][line: %(lineno)d]\[%(levelname)s] ## %(message)s)',

datefmt='%Y-%m-%d %H:%M:%S')

# 使用FileHandler输出到文件

prefix = os.path.splitext(filename)[0]

fh = logging.FileHandler(prefix + '.log')

fh.setLevel(logging.DEBUG)

fh.setFormatter(formatter)

# 使用StreamHandler输出到屏幕

ch = logging.StreamHandler()

ch.setLevel(logging.DEBUG)

ch.setFormatter(formatter)

# 添加两个Handler

logger.addHandler(ch)

logger.addHandler(fh)

return logger

logger = llogger('download.log')

sql_obj = SQLite()

def run():

while 1:

result = sql_obj.get()

print(result)

if result:

idx=result[0]

start=result[1]

end=result[2]

try:

download_bilibili(idx,start,end)

except:

pass

else:

sql_obj.set(idx)

else:

time.sleep(MINS*60)

def download_bilibili(id,start_page,total_page):

global doc

bilibili_url = 'https://www.bilibili.com/video/{}?p={}'

for i in range(start_page, total_page+1):

next_url = bilibili_url.format(id, i)

if sql_obj.exists(next_url):

print('have download')

continue

try:

command = CMD.format(YOU_GET_PATH, next_url)

p = subprocess.Popen(command, stdout=subprocess.PIPE, stderr=subprocess.PIPE,

shell=True)

output, error = p.communicate()

except Exception as e:

print('has execption')

sql_obj.insert_history(next_url,status=0)

logger.error(e)

continue

else:

output_str = output.decode()

if len(output_str) == 0:

sql_obj.insert_history(next_url,status=0)

logger.info('下载失败')

continue

logger.info('{} has been downloaded !'.format(next_url))

sql_obj.insert_history(next_url,status=1)

run()

查看全部

使用python实现

https://github.com/Rockyzsu/bilibili

B站视频下载

自动批量下载B站一个系列的视频

下载某个UP主的所有视频

使用:

下载you-get库,git clone https://github.com/soimort/you-get.git 复制其本地路径,比如/root/you-get/you-get

初次运行,删除history.db 文件, 修改配置文件config.py

START=1 # 下载系列视频的 第一个

END=1 # 下载系列视频的最后一个 , 比如一个系列教程有30个视频, start=5 ,end = 20 下载从第5个到第20个

ID='BV1oK411L7au' # 视频的ID

YOU_GET_PATH='/home/xda/othergit/you-get/you-get' # 你的you-get路径

MINS=1 # 每次循环等待1分钟

user_id = '518973111' # UP主的ID

total_page = 3 # up主的视频的页数

执行 python downloader.py ,进行下载循环

python people.py ,把某个up主的视频链接加入到待下载队列

python add_data.py --id=BV1oK411L7au --start=4 --end=8 下载视频id为BV1oK411L7au的系列教程,从第4开始,到第8个结束,如果只有一个的话,start和end设为1即可。

可以不断地往队列里面添加下载链接。

主要代码:

# @Time : 2019/1/28 14:19

# @File : youtube_downloader.py

import logging

import os

import subprocess

import datetime

import sqlite3

import time

from config import YOU_GET_PATH,MINS

CMD = 'python {} {}'

filename = 'url.txt'

class SQLite():

def __init__(self):

self.conn = sqlite3.connect('history.db')

self.cursor = self.conn.cursor()

self.create_table()

def create_table(self):

create_sql = 'create table if not exists tb_download (url varchar(100),status tinyint,crawltime datetime)'

create_record_tb = 'create table if not exists tb_record (idx varchar(100) PRIMARY KEY,start tinyint,end tinyint,status tinyint)'

self.cursor.execute(create_record_tb)

self.conn.commit()

self.cursor.execute(create_sql)

self.conn.commit()

def exists(self,url):

querySet = 'select * from tb_download where url = ? and status = 1'

self.cursor.execute(querySet,(url,))

ret = self.cursor.fetchone()

return True if ret else False

def insert_history(self,url,status):

query = 'select * from tb_download where url=?'

self.cursor.execute(query,(url,))

ret = self.cursor.fetchone()

current = datetime.datetime.now()

if ret:

insert_sql='update tb_download set status=?,crawltime=? where url = ?'

args=(status,status,current,url)

else:

insert_sql = 'insert into tb_download values(?,?,?)'

args=(url,status,current)

try:

self.cursor.execute(insert_sql,args)

except:

self.conn.rollback()

return False

else:

self.conn.commit()

return True

def get(self):

sql = 'select idx,start,end from tb_record where status=0'

self.cursor.execute(sql)

ret= self.cursor.fetchone()

return ret

def set(self,idx):

print('set status =1')

sql='update tb_record set status=1 where idx=?'

self.cursor.execute(sql,(idx,))

self.conn.commit()

def llogger(filename):

logger = logging.getLogger(filename) # 不加名称设置root logger

logger.setLevel(logging.DEBUG) # 设置输出级别

formatter = logging.Formatter(

'[%(asctime)s][%(filename)s][line: %(lineno)d]\[%(levelname)s] ## %(message)s)',

datefmt='%Y-%m-%d %H:%M:%S')

# 使用FileHandler输出到文件

prefix = os.path.splitext(filename)[0]

fh = logging.FileHandler(prefix + '.log')

fh.setLevel(logging.DEBUG)

fh.setFormatter(formatter)

# 使用StreamHandler输出到屏幕

ch = logging.StreamHandler()

ch.setLevel(logging.DEBUG)

ch.setFormatter(formatter)

# 添加两个Handler

logger.addHandler(ch)

logger.addHandler(fh)

return logger

logger = llogger('download.log')

sql_obj = SQLite()

def run():

while 1:

result = sql_obj.get()

print(result)

if result:

idx=result[0]

start=result[1]

end=result[2]

try:

download_bilibili(idx,start,end)

except:

pass

else:

sql_obj.set(idx)

else:

time.sleep(MINS*60)

def download_bilibili(id,start_page,total_page):

global doc

bilibili_url = 'https://www.bilibili.com/video/{}?p={}'

for i in range(start_page, total_page+1):

next_url = bilibili_url.format(id, i)

if sql_obj.exists(next_url):

print('have download')

continue

try:

command = CMD.format(YOU_GET_PATH, next_url)

p = subprocess.Popen(command, stdout=subprocess.PIPE, stderr=subprocess.PIPE,

shell=True)

output, error = p.communicate()

except Exception as e:

print('has execption')

sql_obj.insert_history(next_url,status=0)

logger.error(e)

continue

else:

output_str = output.decode()

if len(output_str) == 0:

sql_obj.insert_history(next_url,status=0)

logger.info('下载失败')

continue

logger.info('{} has been downloaded !'.format(next_url))

sql_obj.insert_history(next_url,status=1)

run()

python3的map是迭代器,不用for循环或者next触发是不会执行的

python • 李魔佛 发表了文章 • 0 个评论 • 2563 次浏览 • 2022-05-21 17:59

def update_data(id,start,end):

status=0

conn = sqlite3.connect('history.db')

cursor = conn.cursor()

insert_sql ='insert into tb_record values(?,?,?,?)'

try:

cursor.execute(insert_sql,(id,start,end,status))

except Exception as e:

print(e)

print('Error')

else:

conn.commit()

print("successfully insert")

bv_list = []

for i in range(1, total_page + 1):

bv_list.extend(visit(i))

print(bv_list)

map(lambda x:update_data(x,1,1),bv_list)

作用很简单,就是拿到列表后用map放入到sqlite里面。

但是上面的代码并不起作用。

因为map只是定义了一个迭代器,并没有被触发。

可以加一个list(map(lambda x:update_data(x,1,1),bv_list))

这样就可以执行了。 查看全部

def update_data(id,start,end):

status=0

conn = sqlite3.connect('history.db')

cursor = conn.cursor()

insert_sql ='insert into tb_record values(?,?,?,?)'

try:

cursor.execute(insert_sql,(id,start,end,status))

except Exception as e:

print(e)

print('Error')

else:

conn.commit()

print("successfully insert")

bv_list = []

for i in range(1, total_page + 1):

bv_list.extend(visit(i))

print(bv_list)

map(lambda x:update_data(x,1,1),bv_list)

作用很简单,就是拿到列表后用map放入到sqlite里面。

但是上面的代码并不起作用。

因为map只是定义了一个迭代器,并没有被触发。

可以加一个list(map(lambda x:update_data(x,1,1),bv_list))

这样就可以执行了。

dataframe如何 遍历所有的列?

python • 李魔佛 发表了文章 • 0 个评论 • 3379 次浏览 • 2022-05-21 02:16

可以使用df.items()

Python pandas.DataFrame.items用法及代码示例

用法:

DataFrame.items()

迭代(列名,系列)对。

遍历 DataFrame 列,返回一个包含列名和内容的元组作为一个系列。

生成(Yield):

label:对象

被迭代的 DataFrame 的列名。

content:Series

属于每个标签的列条目,作为一个系列。

例子:

>>> df = pd.DataFrame({'species':['bear', 'bear', 'marsupial'],

... 'population':[1864, 22000, 80000]},

... index=['panda', 'polar', 'koala'])

>>> df

species population

panda bear 1864

polar bear 22000

koala marsupial 80000

>>> for label, content in df.items():

... print(f'label:{label}')

... print(f'content:{content}', sep='\n')

...

label:species

content:

panda bear

polar bear

koala marsupial

Name:species, dtype:object

label:population

content:

panda 1864

polar 22000

koala 80000

Name:population, dtype:int64 查看全部

可以使用df.items()

Python pandas.DataFrame.items用法及代码示例

用法:

DataFrame.items()

迭代(列名,系列)对。

遍历 DataFrame 列,返回一个包含列名和内容的元组作为一个系列。

生成(Yield):

label:对象

被迭代的 DataFrame 的列名。

content:Series

属于每个标签的列条目,作为一个系列。

例子:

>>> df = pd.DataFrame({'species':['bear', 'bear', 'marsupial'],

... 'population':[1864, 22000, 80000]},

... index=['panda', 'polar', 'koala'])

>>> df

species population

panda bear 1864

polar bear 22000

koala marsupial 80000

>>> for label, content in df.items():

... print(f'label:{label}')

... print(f'content:{content}', sep='\n')

...

label:species

content:

panda bear

polar bear

koala marsupial

Name:species, dtype:object

label:population

content:

panda 1864

polar 22000

koala 80000

Name:population, dtype:int64

python3 安装demjson 报错 use_2to3 is invalid

python • 李魔佛 发表了文章 • 0 个评论 • 6483 次浏览 • 2022-04-18 20:19

Collecting demjson==2.2.4

Downloading https://pypi.doubanio.com/pack ... ar.gz (131 kB)

|████████████████████████████████| 131 kB 985 kB/s

ERROR: Command errored out with exit status 1:

command: /root/miniconda3/envs/py37/bin/python -c 'import io, os, sys, setuptools, tokenize; sys.argv[0] = '"'"'/tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/setup.py'"'"'; __file__='"'"'/tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/setup.py'"'"';f = getattr(tokenize, '"'"'open'"'"', open)(__file__) if os.path.exists(__file__) else io.StringIO('"'"'from setuptools import setup; setup()'"'"');code = f.read().replace('"'"'\r\n'"'"', '"'"'\n'"'"');f.close();exec(compile(code, __file__, '"'"'exec'"'"'))' egg_info --egg-base /tmp/pip-pip-egg-info-7ve4tu87

cwd: /tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/

Complete output (3 lines):

/root/miniconda3/envs/py37/lib/python3.7/site-packages/setuptools/dist.py:760: UserWarning: Usage of dash-separated 'index-url' will not be supported in future versions. Please use the underscore name 'index_url' instead

% (opt, underscore_opt)

error in demjson setup command: use_2to3 is invalid.

记录一下解决办法:

setuptools 降级:

pip install --upgrade setuptools==57.5.0

然后再pip install demjson 即可

如果担心setuptools 修改到系统的其他库,可以创建一个虚拟环境。

然后在虚拟环境里面对setuptools 降级,再安装demjson

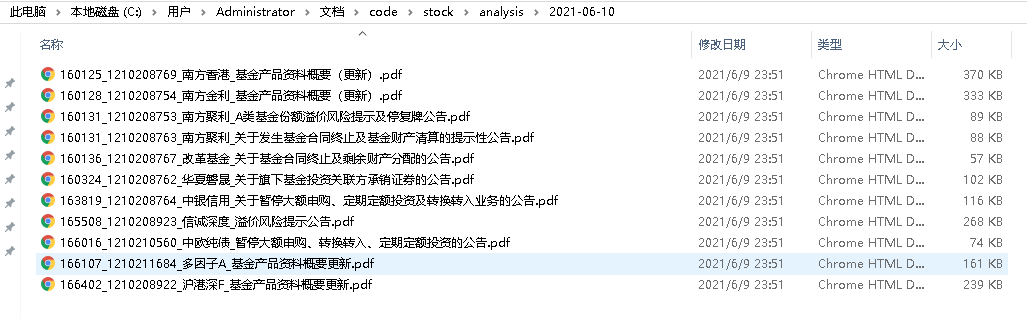

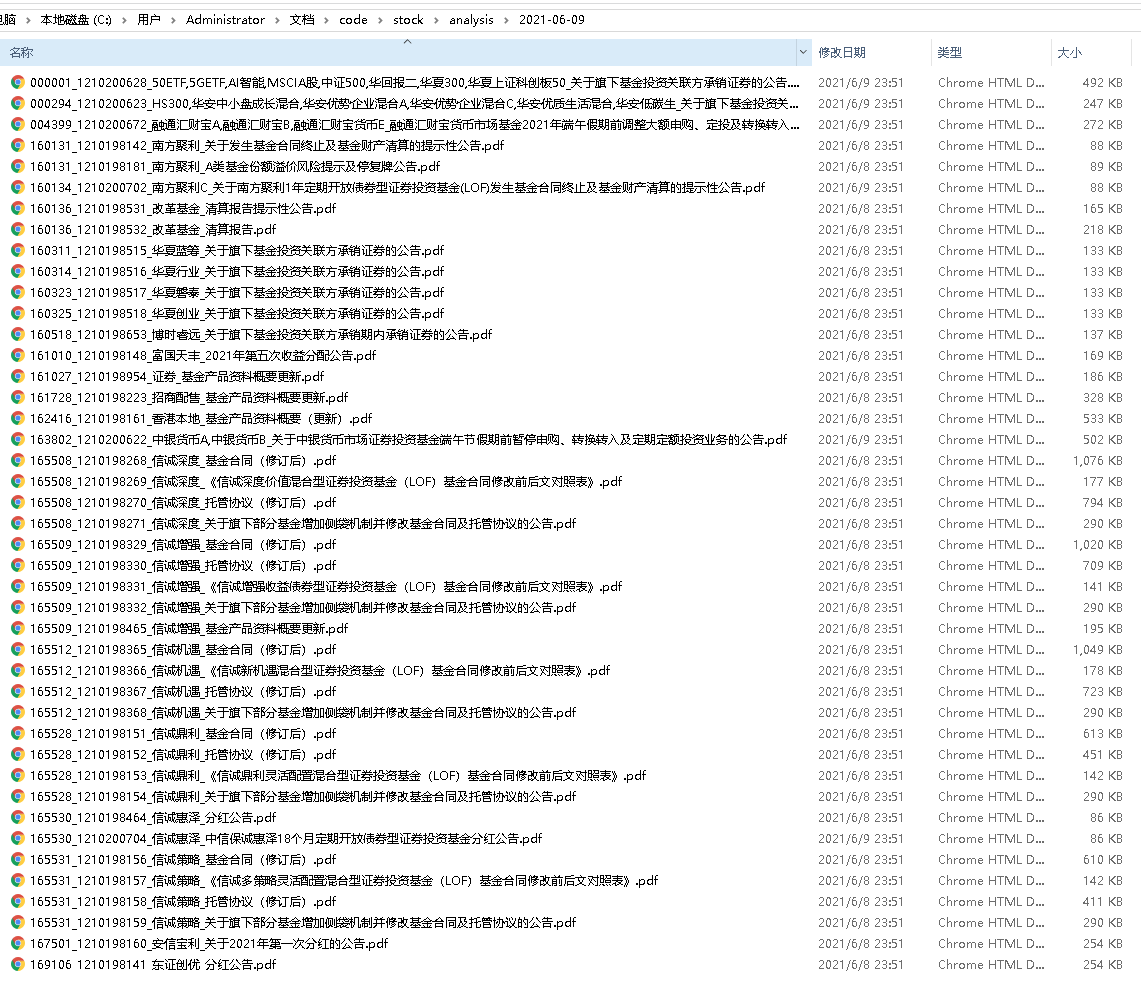

来个养眼图: 查看全部

ooking in indexes: https://pypi.douban.com/simple

Collecting demjson==2.2.4

Downloading https://pypi.doubanio.com/pack ... ar.gz (131 kB)

|████████████████████████████████| 131 kB 985 kB/s

ERROR: Command errored out with exit status 1:

command: /root/miniconda3/envs/py37/bin/python -c 'import io, os, sys, setuptools, tokenize; sys.argv[0] = '"'"'/tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/setup.py'"'"'; __file__='"'"'/tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/setup.py'"'"';f = getattr(tokenize, '"'"'open'"'"', open)(__file__) if os.path.exists(__file__) else io.StringIO('"'"'from setuptools import setup; setup()'"'"');code = f.read().replace('"'"'\r\n'"'"', '"'"'\n'"'"');f.close();exec(compile(code, __file__, '"'"'exec'"'"'))' egg_info --egg-base /tmp/pip-pip-egg-info-7ve4tu87

cwd: /tmp/pip-install-pj0ajcpl/demjson_86a1bab6643c4ed7a7b0c6bb6d3a43a2/

Complete output (3 lines):

/root/miniconda3/envs/py37/lib/python3.7/site-packages/setuptools/dist.py:760: UserWarning: Usage of dash-separated 'index-url' will not be supported in future versions. Please use the underscore name 'index_url' instead

% (opt, underscore_opt)

error in demjson setup command: use_2to3 is invalid.

记录一下解决办法:

setuptools 降级:

pip install --upgrade setuptools==57.5.0

然后再pip install demjson 即可

如果担心setuptools 修改到系统的其他库,可以创建一个虚拟环境。

然后在虚拟环境里面对setuptools 降级,再安装demjson

来个养眼图:

centos/ubuntu linux 下 python matplotlib 绘图中文标题乱码 解决

Linux • 李魔佛 发表了文章 • 0 个评论 • 3102 次浏览 • 2022-04-15 22:23

测试代码:import matplotlib as mpl

import matplotlib.pyplot as plt

from matplotlib import rcParams

plt.rcParams['font.family'] = 'sans-serif'

plt.rcParams['font.sans-serif'] = ['simhei'] # 指定默认字体

plt.rcParams['axes.unicode_minus'] = False

plt.title(r'宋体 Times New Roman')

plt.axis('off')

plt.savefig('usestix.png')

每次换机器都遇到这个问题,所以记录下来,以免日后又在折腾

首先找到一个ttf格式的中文字体,windows系统的可以在C盘的system里面找找。

我用的是微软雅黑。msyh.ttf , 需要的可以到公众号里面取。 后台回复: msyh.ttf 即可

或者simhei.ttfcd /usr/share/fonts/

sudo mkdir chinese

sudo cp simhei.ttf /usr/share/fonts/chinese/

sudo chmod -R 755 /usr/share/fonts/chinese

更新缓存mkfontscale

mkfontdir

fc-cache

注意,如果你的系统没有上述命令,需要使用yum install mkfontscale mkfontdir c-cache安装

然后接下来这一步,很重要。

清理缓存,不然不会生效!!!!rm -rf ~/.cache/matplotlib

matplotlib:

同时把这个msyh.ttf的文件复制到matplotlib库下的文件夹:

~python3.9/site-packages/matplotlib/mpl-data/fonts/ttf/

下面

然后运行程序,搞定~

公众号:可转债量化分析

后台回复 : msyh.ttf 或者 simhei.ttf 即可获取字体文件。 查看全部

测试代码:

import matplotlib as mpl

import matplotlib.pyplot as plt

from matplotlib import rcParams

plt.rcParams['font.family'] = 'sans-serif'

plt.rcParams['font.sans-serif'] = ['simhei'] # 指定默认字体

plt.rcParams['axes.unicode_minus'] = False

plt.title(r'宋体 Times New Roman')

plt.axis('off')

plt.savefig('usestix.png')

每次换机器都遇到这个问题,所以记录下来,以免日后又在折腾

首先找到一个ttf格式的中文字体,windows系统的可以在C盘的system里面找找。

我用的是微软雅黑。msyh.ttf , 需要的可以到公众号里面取。 后台回复: msyh.ttf 即可

或者simhei.ttf

cd /usr/share/fonts/

sudo mkdir chinese

sudo cp simhei.ttf /usr/share/fonts/chinese/

sudo chmod -R 755 /usr/share/fonts/chinese

更新缓存

mkfontscale

mkfontdir

fc-cache

注意,如果你的系统没有上述命令,需要使用yum install mkfontscale mkfontdir c-cache安装

然后接下来这一步,很重要。

清理缓存,不然不会生效!!!!

rm -rf ~/.cache/matplotlib

matplotlib:

同时把这个msyh.ttf的文件复制到matplotlib库下的文件夹:

~python3.9/site-packages/matplotlib/mpl-data/fonts/ttf/

下面

然后运行程序,搞定~

公众号:可转债量化分析

后台回复 : msyh.ttf 或者 simhei.ttf 即可获取字体文件。

知识星球获取文章链接与数据

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 2933 次浏览 • 2022-03-21 20:15

既然官方不提供这个功能,只能自己使用爬虫手段获取了,额。

既然官方不提供这个功能,只能自己使用爬虫手段获取了,额。

python AES 加密 windows和linux平台的不同

python • 李魔佛 发表了文章 • 0 个评论 • 3158 次浏览 • 2022-03-19 11:18

实际两个平台使用pip install安装的aes库不一样。

windows报错

File "C:\anaconda\lib\site-packages\Crypto\Cipher\__init__.py", line 77, in _create_cipher

raise TypeError("IV is not meaningful for the ECB mode")

TypeError: IV is not meaningful for the ECB mode

只需要把AES.new() 的参数里面的iv给去掉就可以了。

查看全部

实际两个平台使用pip install安装的aes库不一样。

windows报错

File "C:\anaconda\lib\site-packages\Crypto\Cipher\__init__.py", line 77, in _create_cipher

raise TypeError("IV is not meaningful for the ECB mode")

TypeError: IV is not meaningful for the ECB mode

只需要把AES.new() 的参数里面的iv给去掉就可以了。

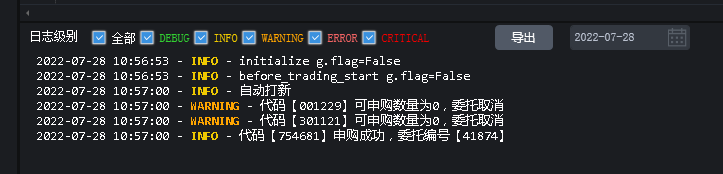

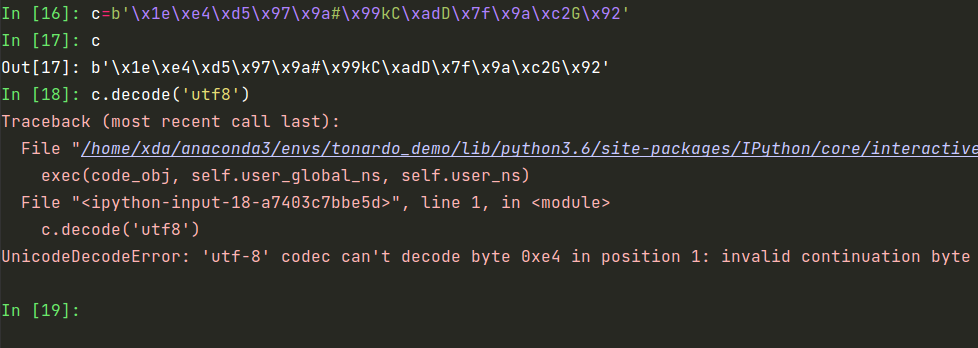

不是所有的bytes都可以转换为string

python • 李魔佛 发表了文章 • 0 个评论 • 2731 次浏览 • 2022-01-14 14:56

b.decode('utf8')

如果报错:UnicodeDecodeError: 'utf-8' codec can't decode byte 0xe4 in position 1: invalid continuation byte

说明字节无法字节转为string,

上面的字节是可以正常decode为utf8

而改下字节数据

所以你试下decode下面的字节:c=b'\x1e\xe4\xd5\x97\x9a#\x99kC\xadD\x7f\x9a\xc2G\x92'

是无法解析的。

这个是没有办法的,如果要硬刚 。

可以加入参数errors = ‘replace’

b.decode('utf8',errors='replace')

这样就不会报错。但是这也只是输出的乱码。

正确的姿势是要看看你的字节的最原始编码格式。如果是gbk,那么就应该使用b.decode('gbk')

查看全部

b.decode('utf8')

如果报错:

UnicodeDecodeError: 'utf-8' codec can't decode byte 0xe4 in position 1: invalid continuation byte

说明字节无法字节转为string,

上面的字节是可以正常decode为utf8

而改下字节数据

所以你试下decode下面的字节:

c=b'\x1e\xe4\xd5\x97\x9a#\x99kC\xadD\x7f\x9a\xc2G\x92'

是无法解析的。

这个是没有办法的,如果要硬刚 。

可以加入参数errors = ‘replace’

b.decode('utf8',errors='replace')这样就不会报错。但是这也只是输出的乱码。

正确的姿势是要看看你的字节的最原始编码格式。如果是gbk,那么就应该使用b.decode('gbk')

目前能用的 可以下载youtube 油管视频的方法 合集 亲测

网络 • 李魔佛 发表了文章 • 0 个评论 • 5935 次浏览 • 2021-11-08 13:03

Subject: Discontinuation of Service in the United States

April 16, 2020

Dear Savefrom User:

As you may have heard, our industry has been under strenuous attacks by certain US copyright holders. Because of these attacks, it has become financially impractical for Savefrom to continue to provide services in the United States.

Accordingly, Savefrom will be terminating its services in the United States as of April 28, 2020.

We thank you for your past loyalty and patronage and wish you health and safety during the present health crisis and beyond.

Very truly yours,

Savefrom所以这个网页下载的方法失效了。

还有其他 可以使用的方法:

方法一 you-get

这是一个python库。

在github下载下来

默认github下载是很卡,且断断续续,具体原因,你懂的。

所以笔者提供一个镜像下载,代码也是最新的。

git clone https://hub.fastgit.org/soimort/you-get.git

运行上面命令即可。

然后下载过程就是切换的CMD命令行:

python you-get --debug https://www.youtube.com/watch?v=59a-XNPngrw

静静等待即可下载。

查看全部

Subject: Discontinuation of Service in the United States所以这个网页下载的方法失效了。

April 16, 2020

Dear Savefrom User:

As you may have heard, our industry has been under strenuous attacks by certain US copyright holders. Because of these attacks, it has become financially impractical for Savefrom to continue to provide services in the United States.

Accordingly, Savefrom will be terminating its services in the United States as of April 28, 2020.

We thank you for your past loyalty and patronage and wish you health and safety during the present health crisis and beyond.

Very truly yours,

Savefrom

还有其他 可以使用的方法:

方法一 you-get

这是一个python库。

在github下载下来

默认github下载是很卡,且断断续续,具体原因,你懂的。

所以笔者提供一个镜像下载,代码也是最新的。

git clone https://hub.fastgit.org/soimort/you-get.git

运行上面命令即可。

然后下载过程就是切换的CMD命令行:

python you-get --debug https://www.youtube.com/watch?v=59a-XNPngrw

静静等待即可下载。

通达信公式转python代码

股票 • 量化大师 发表了文章 • 0 个评论 • 3892 次浏览 • 2021-08-12 18:10

如何使用控制台将动态加载数据刷新出来啊????

python • 低调的哥哥 回复了问题 • 2 人关注 • 1 个回复 • 3762 次浏览 • 2021-08-11 02:06

python 上传文件夹内图片到七牛,同时加入批量删除,单个删除

python • 李魔佛 发表了文章 • 0 个评论 • 2940 次浏览 • 2021-08-07 17:08

然后把key写入到环境变量或者写到下面的python文件里面from qiniu import Auth, put_file,BucketManager,build_batch_delete

import os

import fire

access_key = os.getenv('qiniu_access_key')

secret_key = os.getenv('qiniu_secret_key')

bucket_name = '' # 你的空间名称

HOST ='[url]http://xximg.xxx.com/{}'[/url] # 可以不用填

TEMPLATE = '\n\n\n\n'

def upload(file,category=''):

#构建鉴权对象

q = Auth(access_key, secret_key)

#要上传的空间

#上传后保存的文件名

key = category +'/' + os.path.split(file)[1]

#生成上传 Token,可以指定过期时间等

token = q.upload_token(bucket_name, key) # 永不过期

#要上传文件的本地路径

ret, info = put_file(token, key, file, version='v1')

print(ret)

print(info)

return HOST.format(ret['key'])

def bulk_upload(path,category=''):

with open('qiniu_image.md','a+') as fp:

for file in os.listdir(path):

full_path = os.path.join(path,file)

if os.path.isfile(full_path):

host_url = upload(full_path,category)

fp.write(TEMPLATE.format(host_url,host_url))

def get_file_info(prefix,limit = 10):

q = Auth(access_key, secret_key)

bucket = BucketManager(q)

delimiter = None

marker = None

ret, eof, info = bucket.list(bucket_name, prefix, marker, limit, delimiter)

# assert len(ret.get('items')) is not None

url_list=[]

for item in ret.get('items',):

url_list.append(item['key'])

# print(url_list)

# print(len(url_list))

return url_list,len(url_list)

def bulk_delete(prefix,limit=None):

url_list,lens = get_file_info(prefix,limit=limit)

q = Auth(access_key, secret_key)

bucket = BucketManager(q)

ops = build_batch_delete(bucket_name, url_list)

ret, info = bucket.batch(ops)

print(info)

print(ret)

def delete_one(key):

q = Auth(access_key, secret_key)

#初始化BucketManager

bucket = BucketManager(q)

#你要测试的空间, 并且这个key在你空间中存在

# key = 'python-logo.png'

#删除bucket_name 中的文件 key

ret, info = bucket.delete(bucket_name, key)

print(info)

print(ret)

# assert ret == {}

def bulk_delete_ones(prefix):

url_list,lens = get_file_info(prefix,limit=10)

for url in url_list:

delete_one(url)

# print(url)

def main(path,category):

if os.path.isdir(path):

bulk_upload(path,category)

elif os.path.isfile(path):

upload(path,category)

else:

raise ValueError('文件不存在')

get_file_info()

bulk_delete('resource')

bulk_delete_ones('resource')

delete_one('resource/data_beauty.png')

if __name__ == '__main__':

fire.Fire(main)

然后运行:

python main.py --path='C:\Photo' --category='person'

运行后会上传到七牛的虚拟目录 person目录下

如果要删除,bulk_delete批量删除某个前缀或者文件夹的 查看全部

然后把key写入到环境变量或者写到下面的python文件里面

from qiniu import Auth, put_file,BucketManager,build_batch_delete

import os

import fire

access_key = os.getenv('qiniu_access_key')

secret_key = os.getenv('qiniu_secret_key')

bucket_name = '' # 你的空间名称

HOST ='[url]http://xximg.xxx.com/{}'[/url] # 可以不用填

TEMPLATE = '\n\n\n\n'

def upload(file,category=''):

#构建鉴权对象

q = Auth(access_key, secret_key)

#要上传的空间

#上传后保存的文件名

key = category +'/' + os.path.split(file)[1]

#生成上传 Token,可以指定过期时间等

token = q.upload_token(bucket_name, key) # 永不过期

#要上传文件的本地路径

ret, info = put_file(token, key, file, version='v1')

print(ret)

print(info)

return HOST.format(ret['key'])

def bulk_upload(path,category=''):

with open('qiniu_image.md','a+') as fp:

for file in os.listdir(path):

full_path = os.path.join(path,file)

if os.path.isfile(full_path):

host_url = upload(full_path,category)

fp.write(TEMPLATE.format(host_url,host_url))

def get_file_info(prefix,limit = 10):

q = Auth(access_key, secret_key)

bucket = BucketManager(q)

delimiter = None

marker = None

ret, eof, info = bucket.list(bucket_name, prefix, marker, limit, delimiter)

# assert len(ret.get('items')) is not None

url_list=[]

for item in ret.get('items',):

url_list.append(item['key'])

# print(url_list)

# print(len(url_list))

return url_list,len(url_list)

def bulk_delete(prefix,limit=None):

url_list,lens = get_file_info(prefix,limit=limit)

q = Auth(access_key, secret_key)

bucket = BucketManager(q)

ops = build_batch_delete(bucket_name, url_list)

ret, info = bucket.batch(ops)

print(info)

print(ret)

def delete_one(key):

q = Auth(access_key, secret_key)

#初始化BucketManager

bucket = BucketManager(q)

#你要测试的空间, 并且这个key在你空间中存在

# key = 'python-logo.png'

#删除bucket_name 中的文件 key

ret, info = bucket.delete(bucket_name, key)

print(info)

print(ret)

# assert ret == {}

def bulk_delete_ones(prefix):

url_list,lens = get_file_info(prefix,limit=10)

for url in url_list:

delete_one(url)

# print(url)

def main(path,category):

if os.path.isdir(path):

bulk_upload(path,category)

elif os.path.isfile(path):

upload(path,category)

else:

raise ValueError('文件不存在')

get_file_info()

bulk_delete('resource')

bulk_delete_ones('resource')

delete_one('resource/data_beauty.png')

if __name__ == '__main__':

fire.Fire(main)

然后运行:

python main.py --path='C:\Photo' --category='person'

运行后会上传到七牛的虚拟目录 person目录下

如果要删除,bulk_delete批量删除某个前缀或者文件夹的

为什么登录成功但是爬取不到其他数据

python爬虫 • 低调的哥哥 回复了问题 • 2 人关注 • 1 个回复 • 3884 次浏览 • 2021-08-04 01:17

优矿接口的日期定义真让人蛋疼

股票 • 李魔佛 发表了文章 • 0 个评论 • 2682 次浏览 • 2021-07-17 20:24

然后接口查询结果返回的是YYYY-MM-DD

难道统一一下这么难吗?

然后接口查询结果返回的是YYYY-MM-DD

难道统一一下这么难吗?

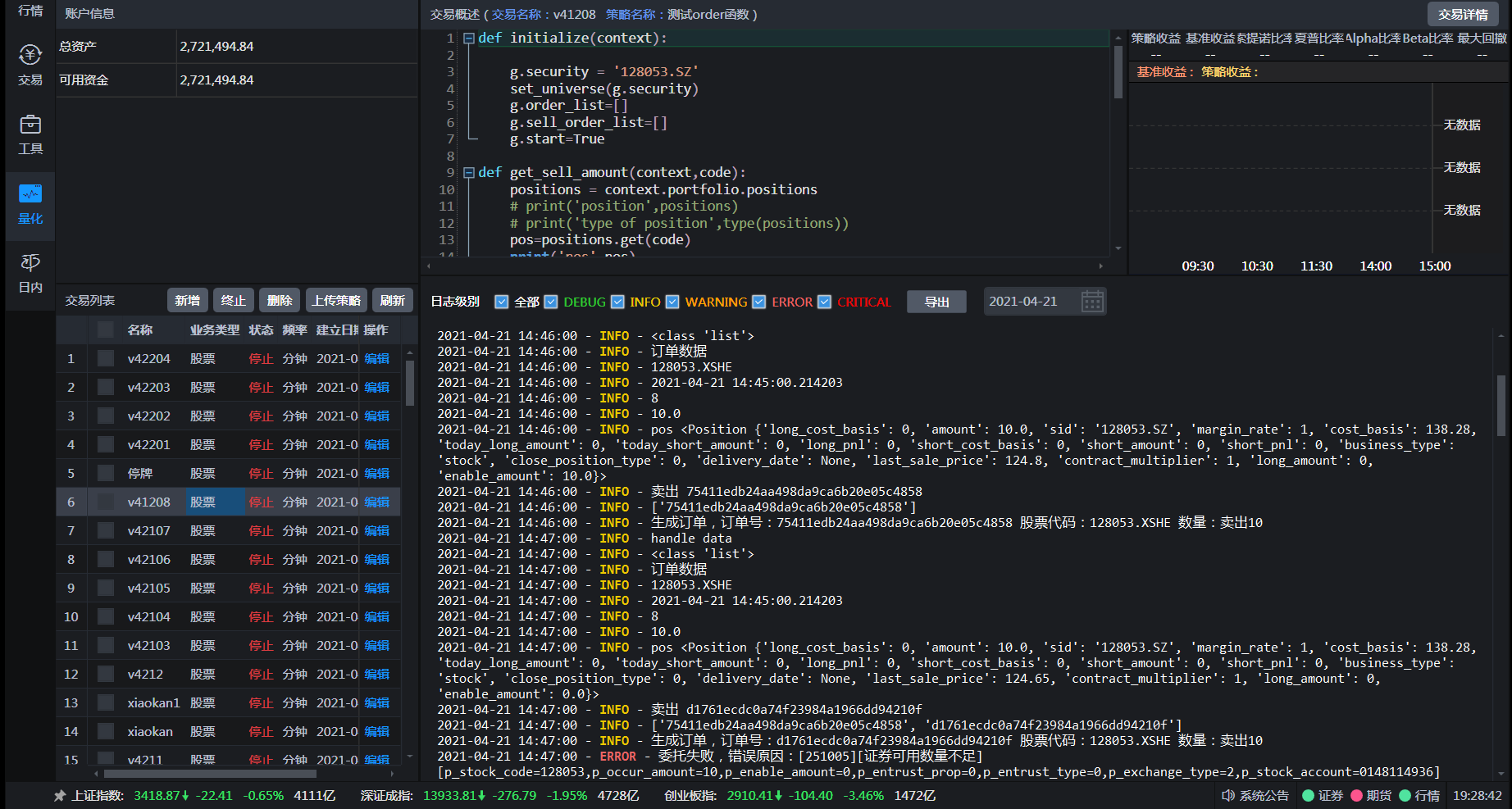

开通Ptrade Python量化接口 国金证券/国盛证券

股票 • 绫波丽 发表了文章 • 0 个评论 • 28957 次浏览 • 2021-07-06 08:40

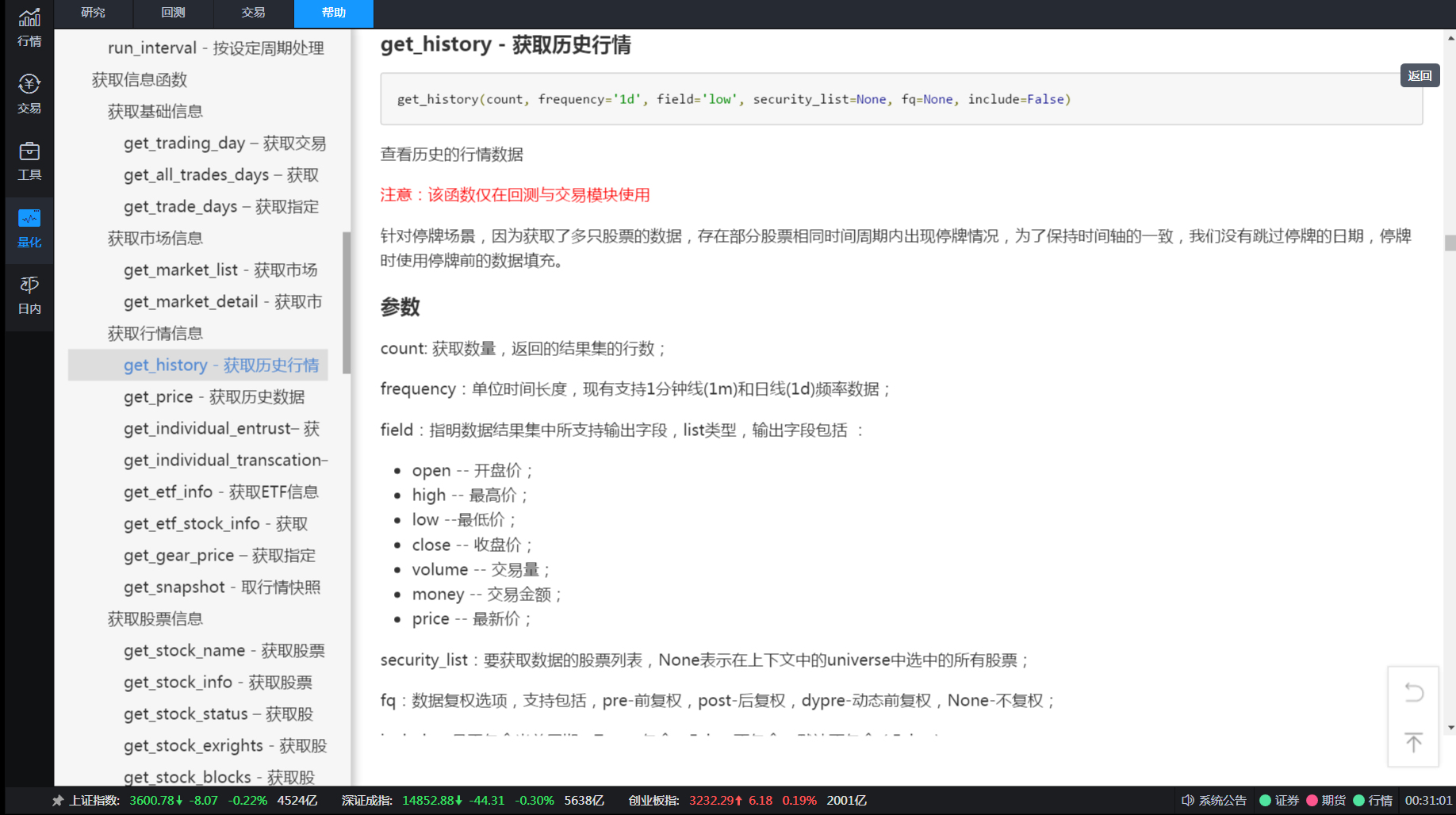

而退而求其次使用按键精灵,模拟点击交易软件进行点击下单,非常不稳定,无法判断下单后是否成交,也无法实时获取行情数据。如果使用tushare或者新浪接口数据,扫描一次全市场的行情用时很久且不稳定,等扫描结束,再下单,此时价格可能已经是几分钟前的了,且此类接口调用次数多是会被封IP的。

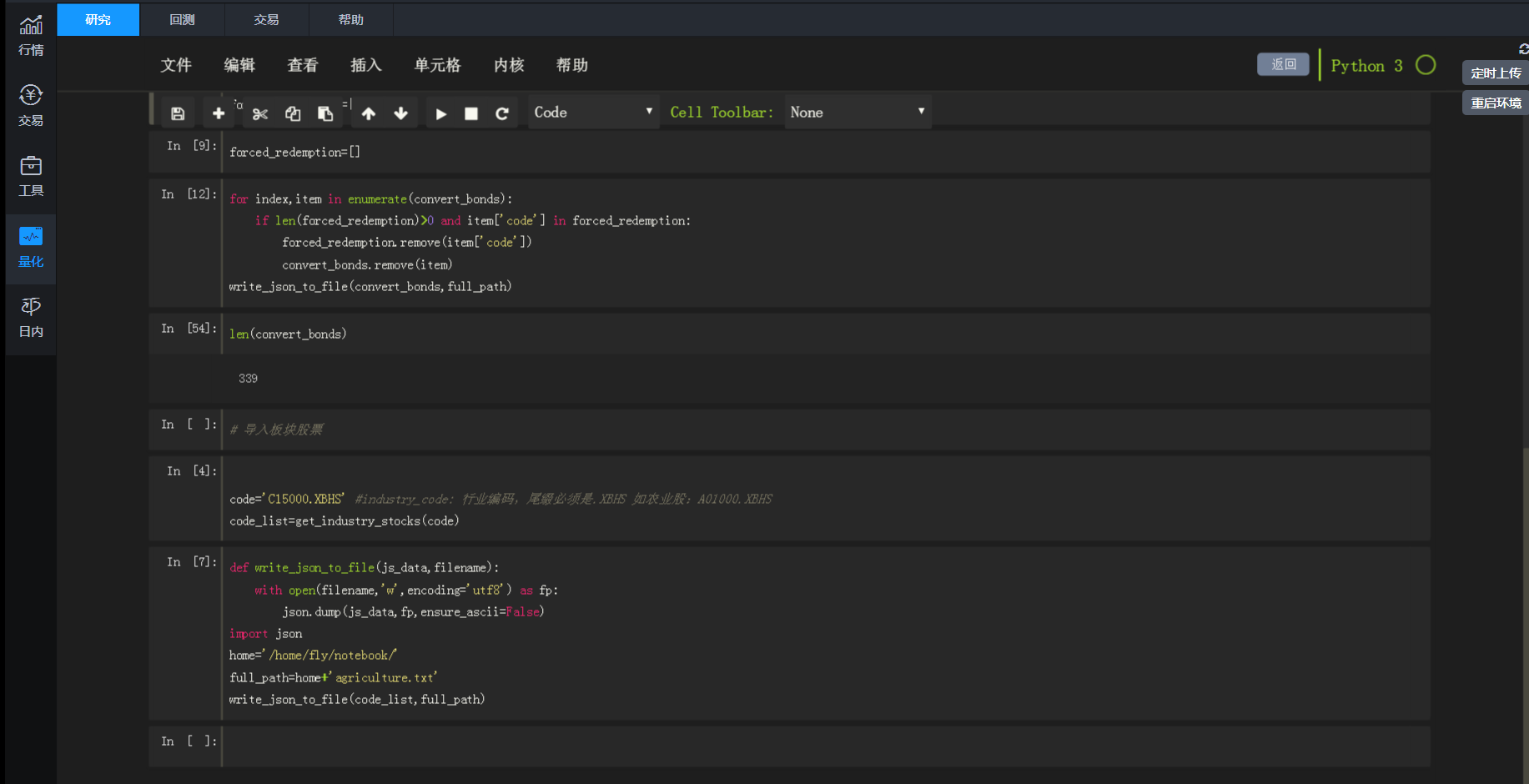

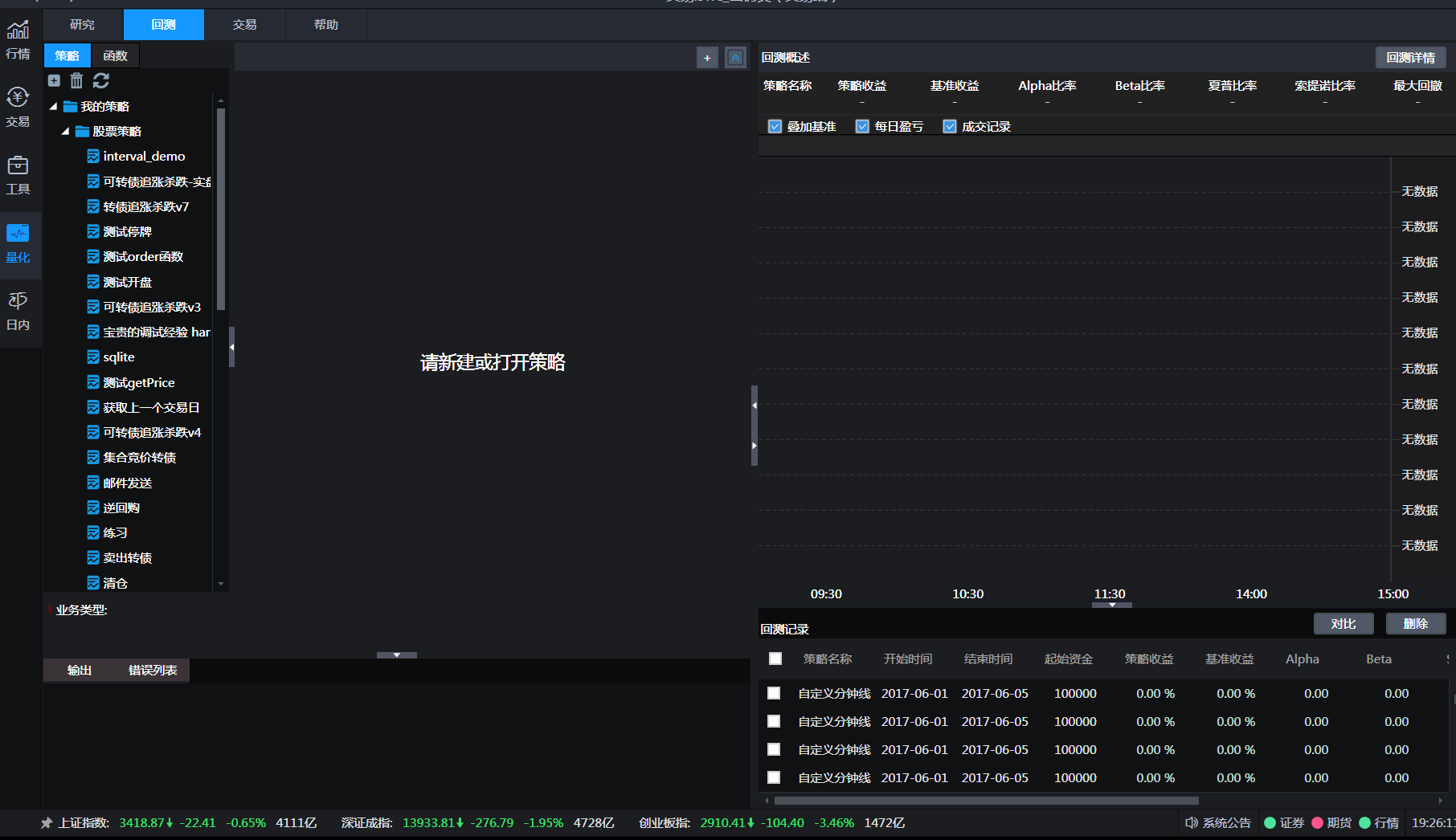

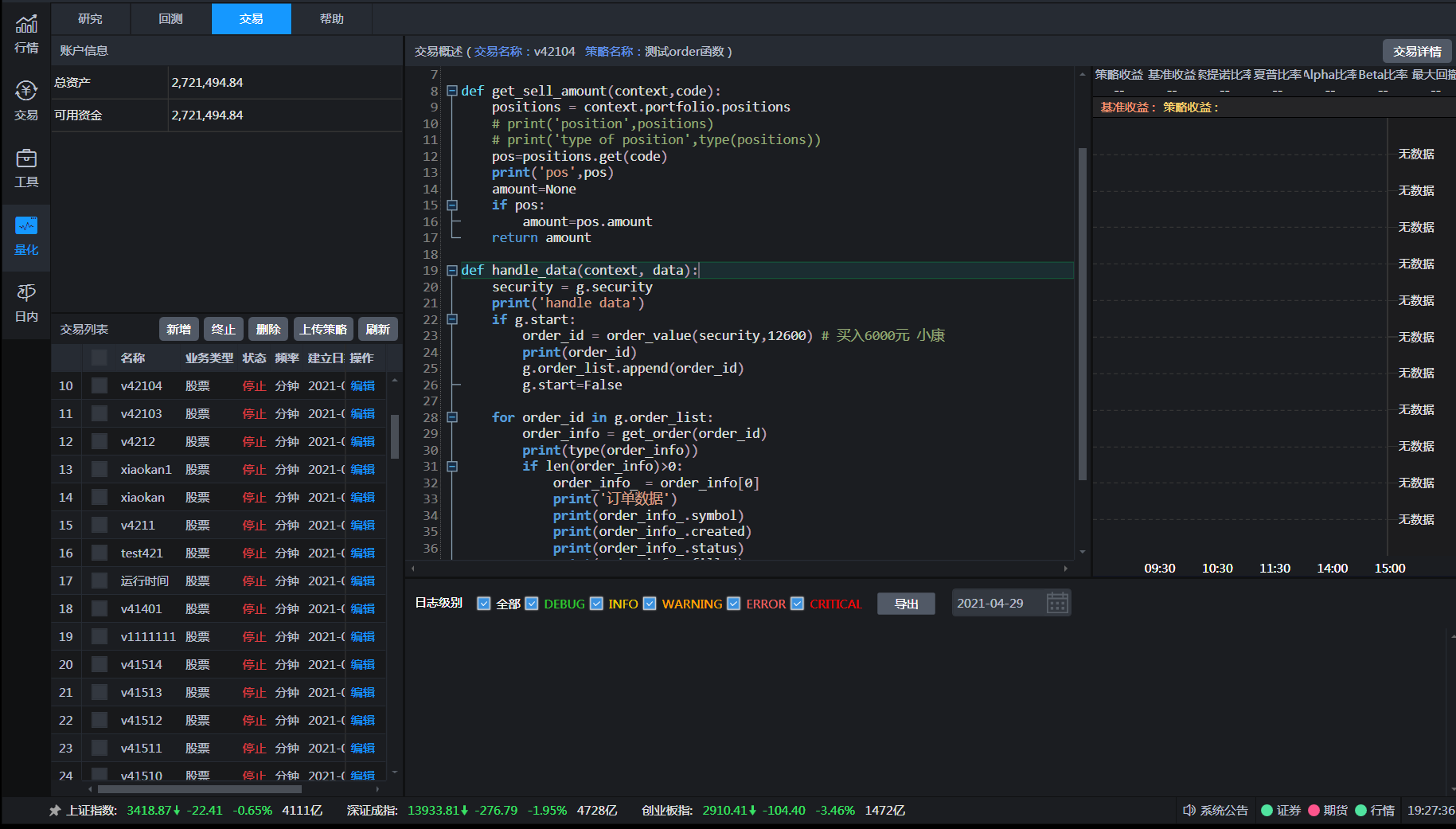

笔者使用的是券商提供的量化软件:Ptrade。是恒生电子研发的提供给机构使用的程序化交易软件。提供策略回测,下单API接口,实时行情获取,并且使用的开发语言python,易于上手。

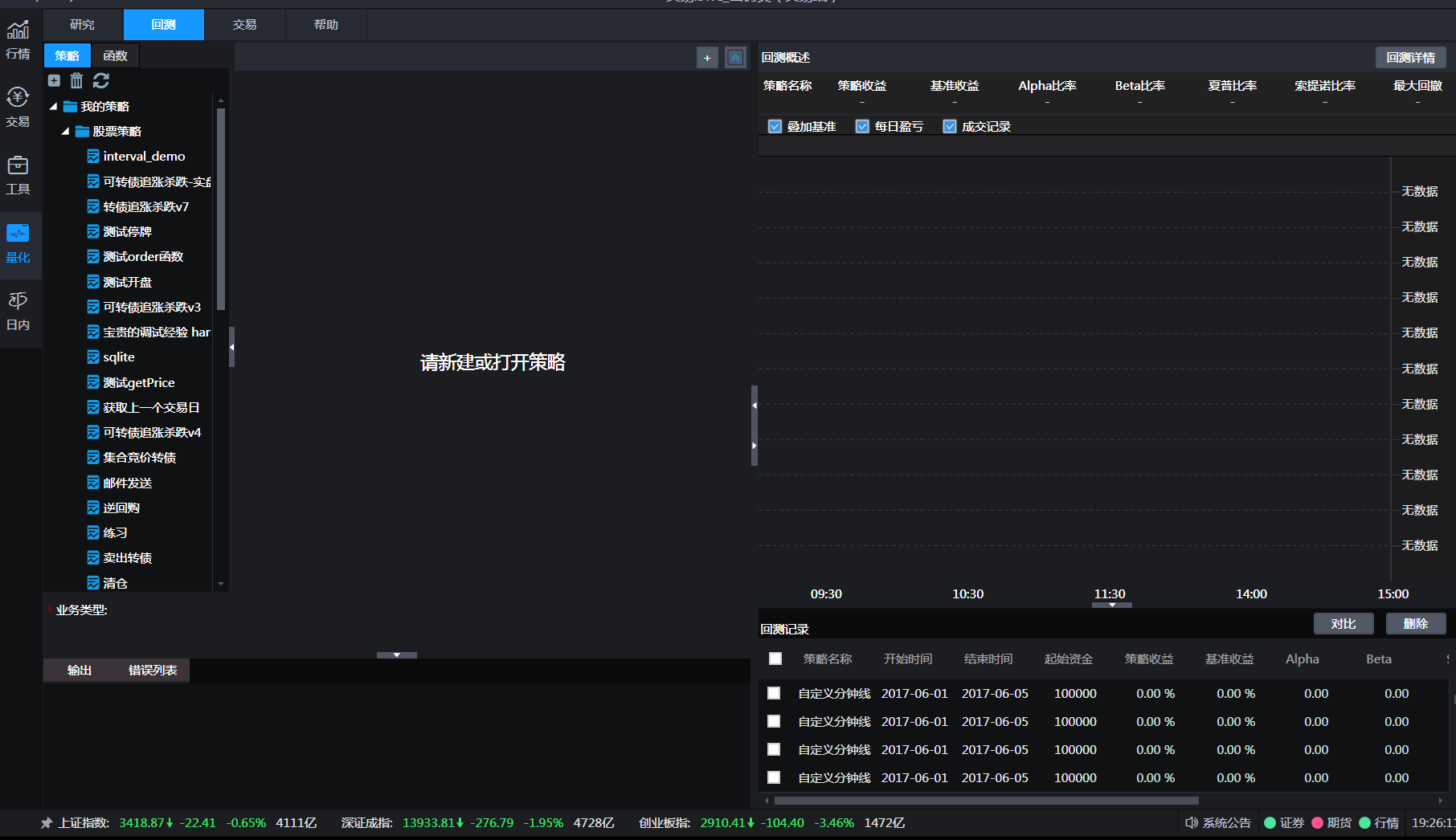

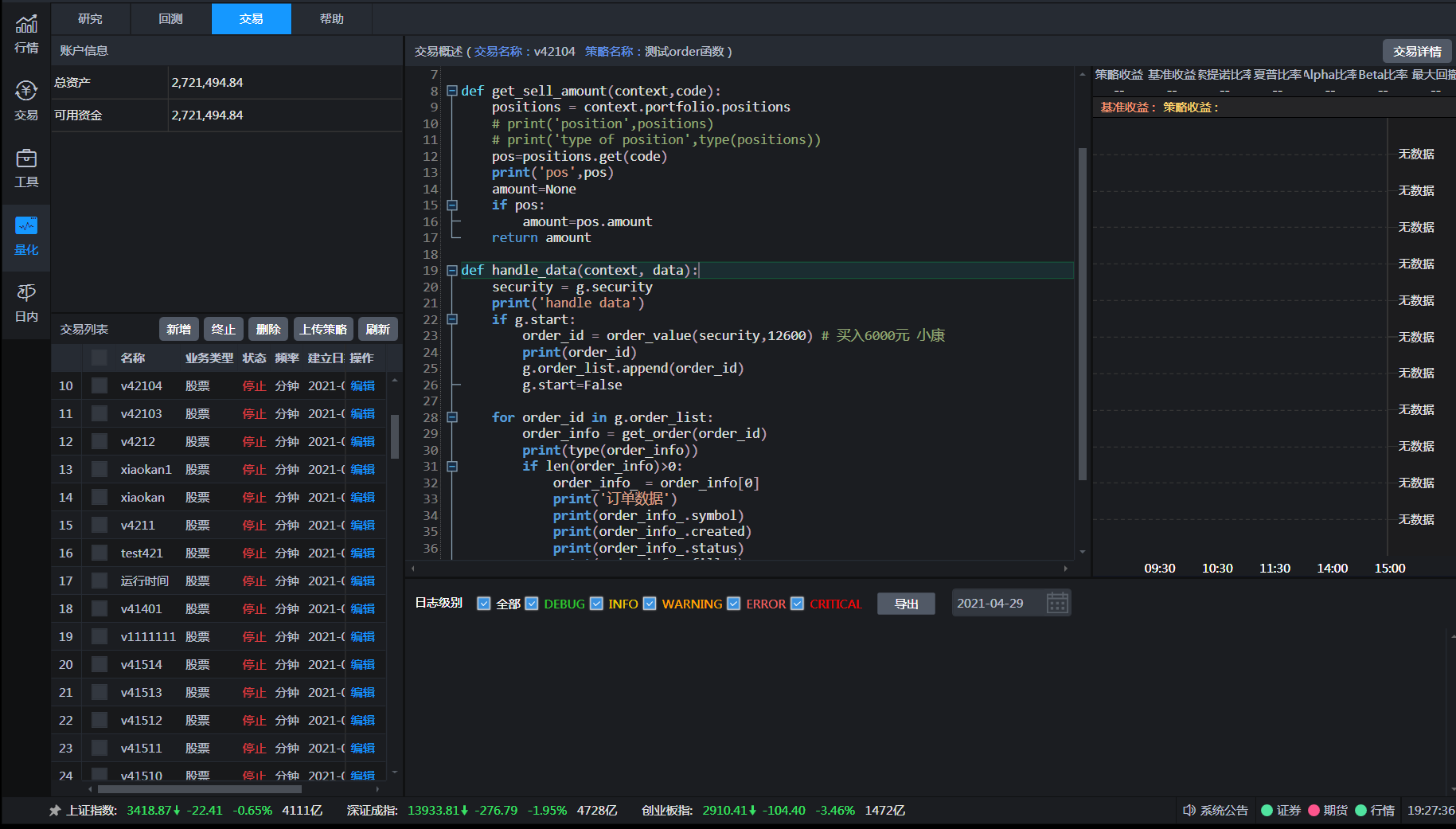

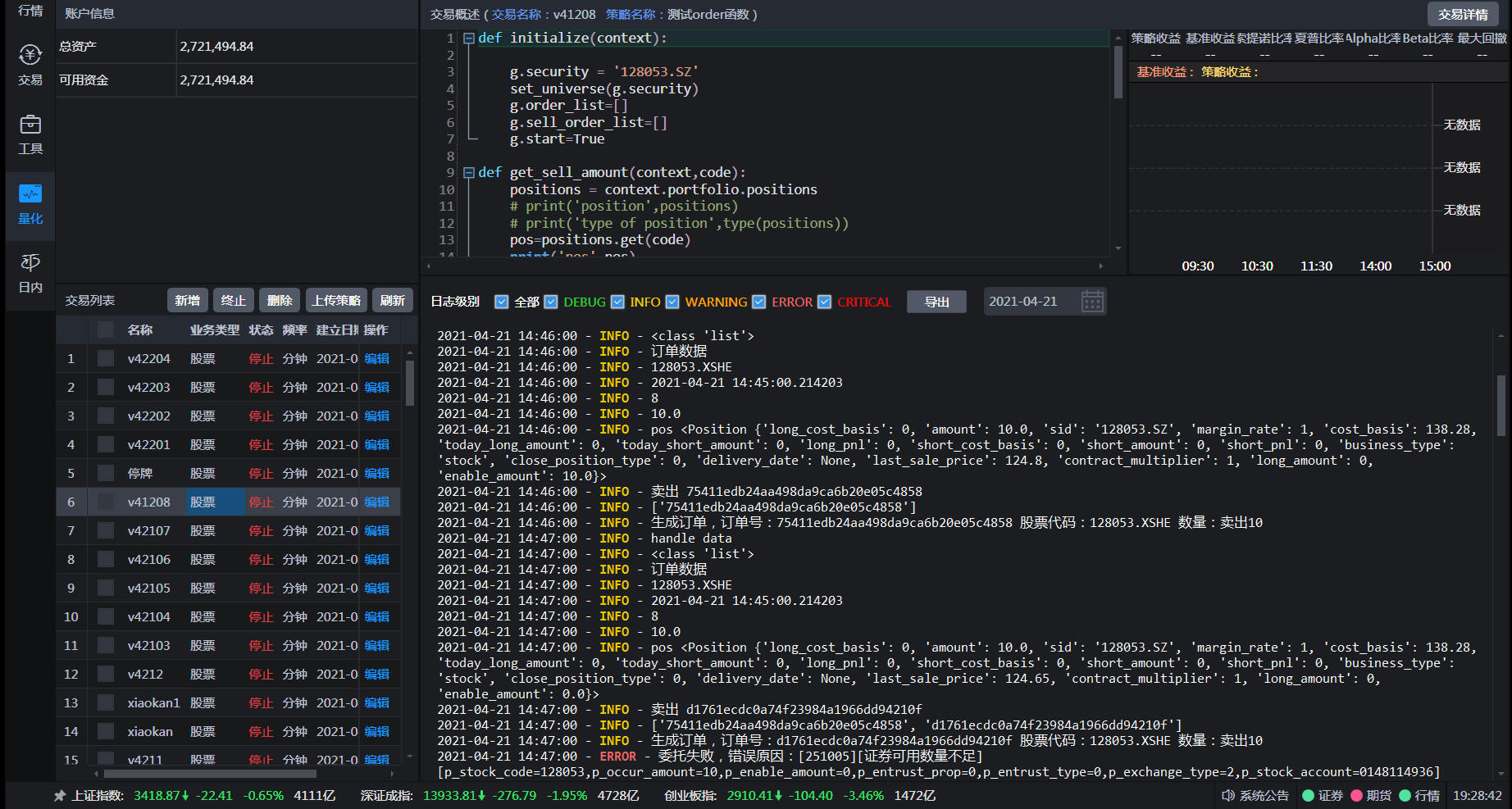

策略回测与实盘交易

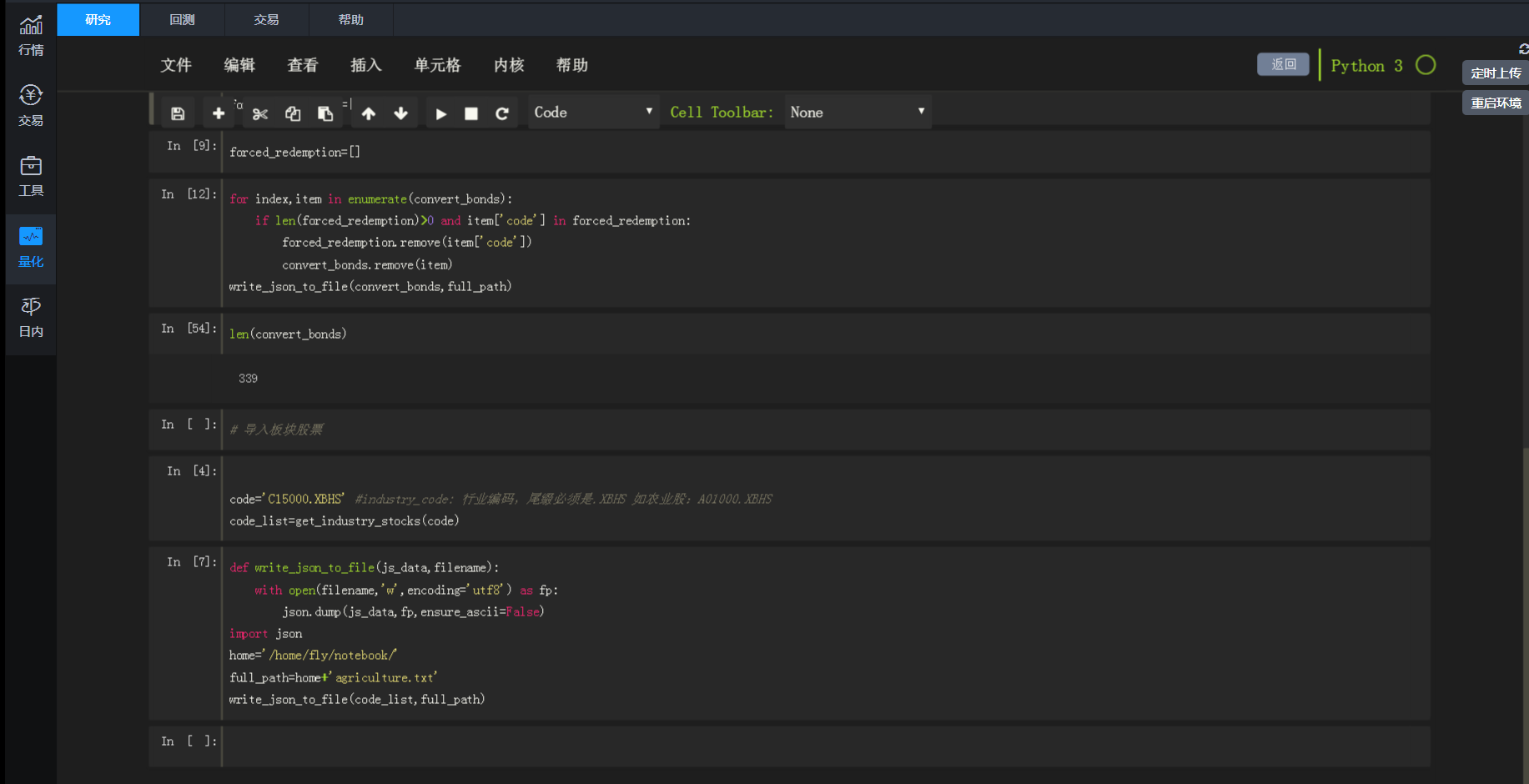

研究页面

研究页面,熟悉python jupyter notebook的朋友对这个界面肯定很熟悉。

研究的页面实际就运行你逐行输出调试程序,了解每个函数的具体使用,或者你策略的中途结果调试。

回测策略

实际代码需要在回测策略里面写,写完后确定无误,就可以放在仿真环境下真实运行。如果你运行得到的结果很满意,那么就可以直接部署到实盘服务器上。实盘服务器是在券商那边,不需要个人购买服务器,也不需要本地开着这个Ptrade,就是说不需要在个人电脑上一直开着跑,你的最终代码和程序是在券商服务器上部署与运行,除非有报错异常停止,不然在你不暂停或者停止的前提下,可以一直运行下去。

条件满足后下单

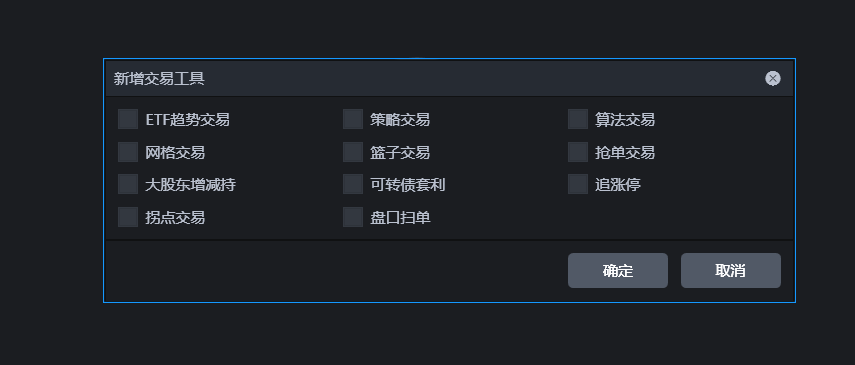

可视化量化

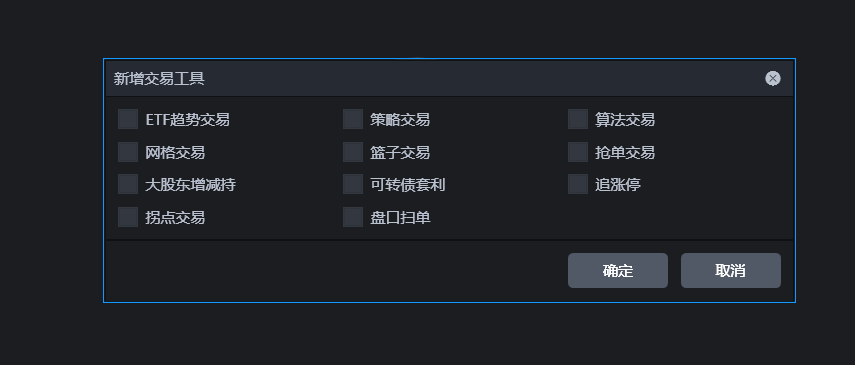

同时也提供一些常见的现成的量化策略,选中后只要鼠标点点点也能够自动化跑这些策略了,当然里面很多参数都可以用鼠标点点点修改。

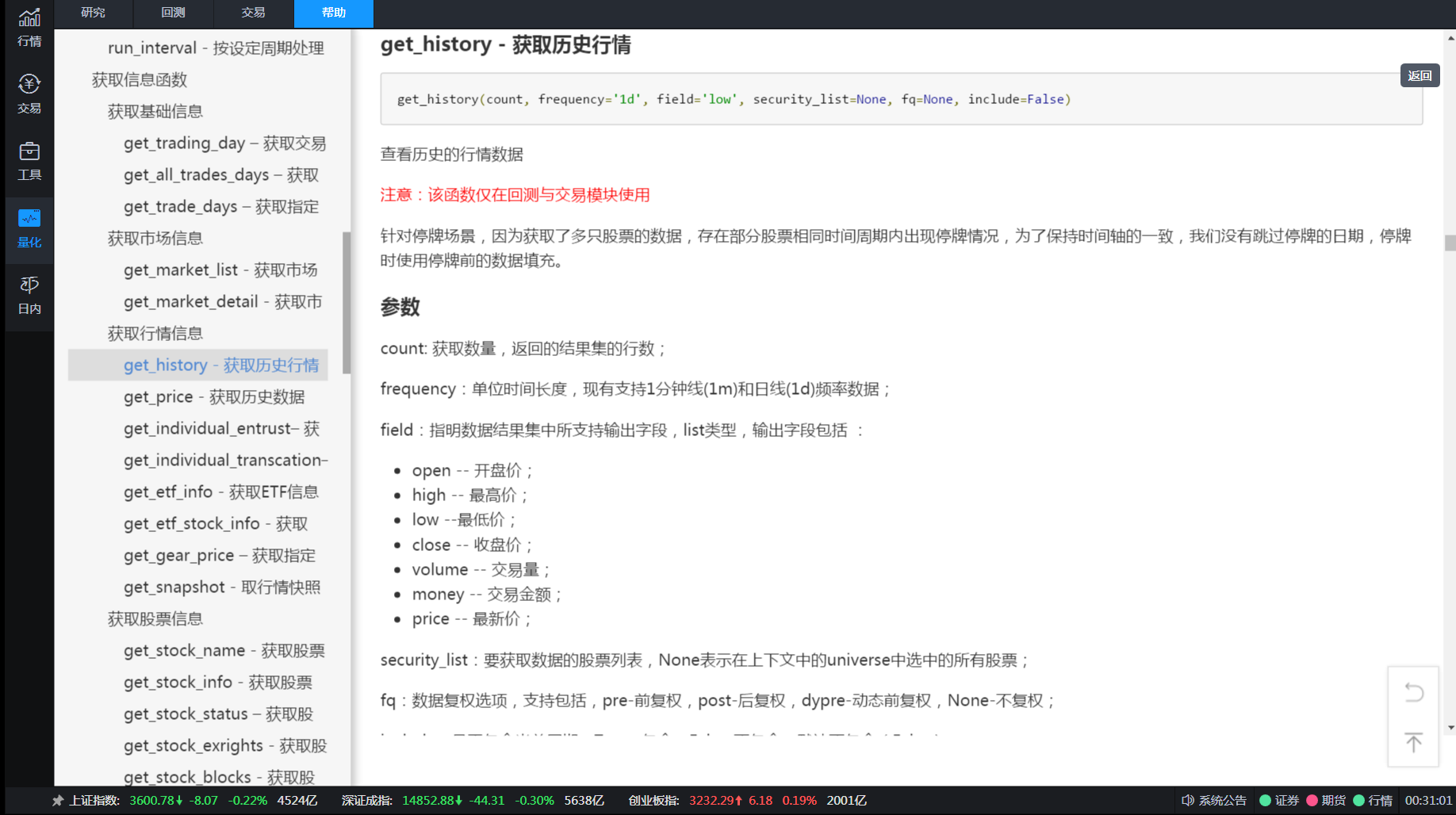

接口文档也非常详细:

一些常见策略代码:

集合竞价追涨停策略def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

#每天9:23分运行集合竞价处理函数

run_daily(context, aggregate_auction_func, time='9:23')

def aggregate_auction_func(context):

stock = g.security

#最新价

snapshot = get_snapshot(stock)

price = snapshot[stock]['last_px']

#涨停价

up_limit = snapshot[stock]['up_px']

#如果最新价不小于涨停价,买入

if float(price) >= float(up_limit):

order(g.security, 100, limit_price=up_limit)

def handle_data(context, data):

pass

双均线策略def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

pass

#当五日均线高于十日均线时买入,当五日均线低于十日均线时卖出

def handle_data(context, data):

security = g.security

#得到十日历史价格

df = get_history(10, '1d', 'close', security, fq=None, include=False)

# 得到五日均线价格

ma5 = round(df['close'][-5:].mean(), 3)

# 得到十日均线价格

ma10 = round(df['close'][-10:].mean(), 3)

# 取得昨天收盘价

price = data[security]['close']

# 得到当前资金余额

cash = context.portfolio.cash

# 如果当前有余额,并且五日均线大于十日均线

if ma5 > ma10:

# 用所有 cash 买入股票

order_value(security, cash)

# 记录这次买入

log.info("Buying %s" % (security))

# 如果五日均线小于十日均线,并且目前有头寸

elif ma5 < ma10 and get_position(security).amount > 0:

# 全部卖出

order_target(security, 0)

# 记录这次卖出

log.info("Selling %s" % (security))

tick级别均线策略

通俗点就是按照秒级别进行操作。def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

#每3秒运行一次主函数

run_interval(context, func, seconds=3)

#盘前准备历史数据

def before_trading_start(context, data):

history = get_history(10, '1d', 'close', g.security, fq='pre', include=False)

g.close_array = history['close'].values

#当五日均线高于十日均线时买入,当五日均线低于十日均线时卖出

def func(context):

stock = g.security

#获取最新价

snapshot = get_snapshot(stock)

price = snapshot[stock]['last_px']

# 得到五日均线价格

days = 5

ma5 = get_MA_day(stock, days, g.close_array[-4:], price)

# 得到十日均线价格

days = 10

ma10 = get_MA_day(stock, days, g.close_array[-9:], price)

# 得到当前资金余额

cash = context.portfolio.cash

# 如果当前有余额,并且五日均线大于十日均线

if ma5 > ma10:

# 用所有 cash 买入股票

order_value(stock, cash)

# 记录这次买入

log.info("Buying %s" % (stock))

# 如果五日均线小于十日均线,并且目前有头寸

elif ma5 < ma10 and get_position(stock).amount > 0:

# 全部卖出

order_target(stock, 0)

# 记录这次卖出

log.info("Selling %s" % (stock))

#计算实时均线函数

def get_MA_day(stock,days,close_array,current_price):

close_sum = close_array[-(days-1):].sum()

MA = (current_price + close_sum)/days

return MA

def handle_data(context, data):

pass

macd策略def f_expma(N,m,EXPMA1,price):

a = m/(N+1)

EXPMA2 = a * price + (1 - a)*EXPMA1

return EXPMA2 #2为后一天值

#定义macd函数,输入平滑系数参数、前一日值,输出当日值

def macd(N1,N2,N3,m,EXPMA12_1,EXPMA26_1,DEA1,price):

EXPMA12_2 = f_expma(N1,m,EXPMA12_1,price)

EXPMA26_2 = f_expma(N2,m,EXPMA26_1,price)

DIF2 = EXPMA12_2 - EXPMA26_2

a = m/(N3+1)

DEA2 = a * DIF2 + (1 - a)*DEA1

BAR2=2*(DIF2-DEA2)

return EXPMA12_2,EXPMA26_2,DIF2,DEA2,BAR2

def initialize(context):

global init_price

init_price = None

# 获取沪深300股票

g.security = get_index_stocks('000300.SS')

#g.security = ['600570.SS']

# 设置我们要操作的股票池, 这里我们只操作一支股票

set_universe(g.security)

def handle_data(context, data):

# 获取历史数据,这里只获取了2天的数据,如果希望最终MACD指标结果更准确最好是获取

# 从股票上市至今的所有历史数据,即增加获取的天数

close_price = get_history(2, '1d', field='close', security_list=g.security)

#如果是停牌不进行计算

for security in g.security:

if data[security].is_open >0:

global init_price,EXPMA12_1,EXPMA26_1,EXPMA12_2,EXPMA26_2,DIF1,DIF2,DEA1,DEA2

if init_price is None:

init_price = close_price[security].mean()#nan和N-1个数,mean为N-1个数的均值

EXPMA12_1 = init_price

EXPMA26_1 = init_price

DIF1 = init_price

DEA1 = init_price

# m用于计算平滑系数a=m/(N+1)

m = 2.0

#设定指数平滑基期数

N1 = 12

N2 = 26

N3 = 9

EXPMA12_2,EXPMA26_2,DIF2,DEA2,BAR2 = macd(N1,N2,N3,m,EXPMA12_1,EXPMA26_1,DEA1,close_price[security][-1])

# 取得当前价格

current_price = data[security].price

# 取得当前的现金

cash = context.portfolio.cash

# DIF、DEA均为正,DIF向上突破DEA,买入信号参考

if DIF2 > 0 and DEA2 > 0 and DIF1 < DEA1 and DIF2 > DEA2:

# 计算可以买多少只股票

number_of_shares = int(cash/current_price)

# 购买量大于0时,下单

if number_of_shares > 0:

# 以市单价买入股票,日回测时即是开盘价

order(security, +number_of_shares)

# 记录这次买入

log.info("Buying %s" % (security))

# DIF、DEA均为负,DIF向下突破DEA,卖出信号参考

elif DIF2 < 0 and DEA2 < 0 and DIF1 > DEA1 and DIF2 < DEA2 and get_position(security).amount > 0:

# 卖出所有股票,使这只股票的最终持有量为0

order_target(security, 0)

# 记录这次卖出

log.info("Selling %s" % (security))

# 将今日的值赋给全局变量作为下一次前一日的值

DEA1 = DEA2

DIF1 = DIF2

EXPMA12_1 = EXPMA12_2

EXPMA26_1 = EXPMA26_2

软件与交易接口开通条件:

开通该券商后,存入资金指定资金即可开通。开通后股票交易费率万一

本身券商的交易费率为股票万一,可转债沪百万分之五,深十万分之五,基金万0.5,非常厚道。

不太了解量化行业的可以了解下,不少面向机构的量化交易软件的佣金是万2.5的,且开户门槛高,基本是500W以上,比如华泰的matic量化的门槛是1千万元起步。

所以笔者还是很推荐目前该券商的量化交易接口。

需要开通咨询了解的朋友可以扫码联系:

开通券商账户后可以 可以先试用,再考虑是否开通量化接口权限 查看全部

而退而求其次使用按键精灵,模拟点击交易软件进行点击下单,非常不稳定,无法判断下单后是否成交,也无法实时获取行情数据。如果使用tushare或者新浪接口数据,扫描一次全市场的行情用时很久且不稳定,等扫描结束,再下单,此时价格可能已经是几分钟前的了,且此类接口调用次数多是会被封IP的。

笔者使用的是券商提供的量化软件:Ptrade。是恒生电子研发的提供给机构使用的程序化交易软件。提供策略回测,下单API接口,实时行情获取,并且使用的开发语言python,易于上手。

策略回测与实盘交易

研究页面

研究页面,熟悉python jupyter notebook的朋友对这个界面肯定很熟悉。

研究的页面实际就运行你逐行输出调试程序,了解每个函数的具体使用,或者你策略的中途结果调试。

回测策略

实际代码需要在回测策略里面写,写完后确定无误,就可以放在仿真环境下真实运行。如果你运行得到的结果很满意,那么就可以直接部署到实盘服务器上。实盘服务器是在券商那边,不需要个人购买服务器,也不需要本地开着这个Ptrade,就是说不需要在个人电脑上一直开着跑,你的最终代码和程序是在券商服务器上部署与运行,除非有报错异常停止,不然在你不暂停或者停止的前提下,可以一直运行下去。

条件满足后下单

可视化量化

同时也提供一些常见的现成的量化策略,选中后只要鼠标点点点也能够自动化跑这些策略了,当然里面很多参数都可以用鼠标点点点修改。

接口文档也非常详细:

一些常见策略代码:

集合竞价追涨停策略

def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

#每天9:23分运行集合竞价处理函数

run_daily(context, aggregate_auction_func, time='9:23')

def aggregate_auction_func(context):

stock = g.security

#最新价

snapshot = get_snapshot(stock)

price = snapshot[stock]['last_px']

#涨停价

up_limit = snapshot[stock]['up_px']

#如果最新价不小于涨停价,买入

if float(price) >= float(up_limit):

order(g.security, 100, limit_price=up_limit)

def handle_data(context, data):

pass

双均线策略

def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

pass

#当五日均线高于十日均线时买入,当五日均线低于十日均线时卖出

def handle_data(context, data):

security = g.security

#得到十日历史价格

df = get_history(10, '1d', 'close', security, fq=None, include=False)

# 得到五日均线价格

ma5 = round(df['close'][-5:].mean(), 3)

# 得到十日均线价格

ma10 = round(df['close'][-10:].mean(), 3)

# 取得昨天收盘价

price = data[security]['close']

# 得到当前资金余额

cash = context.portfolio.cash

# 如果当前有余额,并且五日均线大于十日均线

if ma5 > ma10:

# 用所有 cash 买入股票

order_value(security, cash)

# 记录这次买入

log.info("Buying %s" % (security))

# 如果五日均线小于十日均线,并且目前有头寸

elif ma5 < ma10 and get_position(security).amount > 0:

# 全部卖出

order_target(security, 0)

# 记录这次卖出

log.info("Selling %s" % (security))

tick级别均线策略

通俗点就是按照秒级别进行操作。

def initialize(context):

# 初始化此策略

# 设置我们要操作的股票池, 这里我们只操作一支股票

g.security = '600570.SS'

set_universe(g.security)

#每3秒运行一次主函数

run_interval(context, func, seconds=3)

#盘前准备历史数据

def before_trading_start(context, data):

history = get_history(10, '1d', 'close', g.security, fq='pre', include=False)

g.close_array = history['close'].values

#当五日均线高于十日均线时买入,当五日均线低于十日均线时卖出

def func(context):

stock = g.security

#获取最新价

snapshot = get_snapshot(stock)

price = snapshot[stock]['last_px']

# 得到五日均线价格

days = 5

ma5 = get_MA_day(stock, days, g.close_array[-4:], price)

# 得到十日均线价格

days = 10

ma10 = get_MA_day(stock, days, g.close_array[-9:], price)

# 得到当前资金余额

cash = context.portfolio.cash

# 如果当前有余额,并且五日均线大于十日均线

if ma5 > ma10:

# 用所有 cash 买入股票

order_value(stock, cash)

# 记录这次买入

log.info("Buying %s" % (stock))

# 如果五日均线小于十日均线,并且目前有头寸

elif ma5 < ma10 and get_position(stock).amount > 0:

# 全部卖出

order_target(stock, 0)

# 记录这次卖出

log.info("Selling %s" % (stock))

#计算实时均线函数

def get_MA_day(stock,days,close_array,current_price):

close_sum = close_array[-(days-1):].sum()

MA = (current_price + close_sum)/days

return MA

def handle_data(context, data):

pass

macd策略

def f_expma(N,m,EXPMA1,price):

a = m/(N+1)

EXPMA2 = a * price + (1 - a)*EXPMA1

return EXPMA2 #2为后一天值

#定义macd函数,输入平滑系数参数、前一日值,输出当日值

def macd(N1,N2,N3,m,EXPMA12_1,EXPMA26_1,DEA1,price):

EXPMA12_2 = f_expma(N1,m,EXPMA12_1,price)

EXPMA26_2 = f_expma(N2,m,EXPMA26_1,price)

DIF2 = EXPMA12_2 - EXPMA26_2

a = m/(N3+1)

DEA2 = a * DIF2 + (1 - a)*DEA1

BAR2=2*(DIF2-DEA2)

return EXPMA12_2,EXPMA26_2,DIF2,DEA2,BAR2

def initialize(context):

global init_price

init_price = None

# 获取沪深300股票

g.security = get_index_stocks('000300.SS')

#g.security = ['600570.SS']

# 设置我们要操作的股票池, 这里我们只操作一支股票

set_universe(g.security)

def handle_data(context, data):

# 获取历史数据,这里只获取了2天的数据,如果希望最终MACD指标结果更准确最好是获取

# 从股票上市至今的所有历史数据,即增加获取的天数

close_price = get_history(2, '1d', field='close', security_list=g.security)

#如果是停牌不进行计算

for security in g.security:

if data[security].is_open >0:

global init_price,EXPMA12_1,EXPMA26_1,EXPMA12_2,EXPMA26_2,DIF1,DIF2,DEA1,DEA2

if init_price is None:

init_price = close_price[security].mean()#nan和N-1个数,mean为N-1个数的均值

EXPMA12_1 = init_price

EXPMA26_1 = init_price

DIF1 = init_price

DEA1 = init_price

# m用于计算平滑系数a=m/(N+1)

m = 2.0

#设定指数平滑基期数

N1 = 12

N2 = 26

N3 = 9

EXPMA12_2,EXPMA26_2,DIF2,DEA2,BAR2 = macd(N1,N2,N3,m,EXPMA12_1,EXPMA26_1,DEA1,close_price[security][-1])

# 取得当前价格

current_price = data[security].price

# 取得当前的现金

cash = context.portfolio.cash

# DIF、DEA均为正,DIF向上突破DEA,买入信号参考

if DIF2 > 0 and DEA2 > 0 and DIF1 < DEA1 and DIF2 > DEA2:

# 计算可以买多少只股票

number_of_shares = int(cash/current_price)

# 购买量大于0时,下单

if number_of_shares > 0:

# 以市单价买入股票,日回测时即是开盘价

order(security, +number_of_shares)

# 记录这次买入

log.info("Buying %s" % (security))

# DIF、DEA均为负,DIF向下突破DEA,卖出信号参考

elif DIF2 < 0 and DEA2 < 0 and DIF1 > DEA1 and DIF2 < DEA2 and get_position(security).amount > 0:

# 卖出所有股票,使这只股票的最终持有量为0

order_target(security, 0)

# 记录这次卖出

log.info("Selling %s" % (security))

# 将今日的值赋给全局变量作为下一次前一日的值

DEA1 = DEA2

DIF1 = DIF2

EXPMA12_1 = EXPMA12_2

EXPMA26_1 = EXPMA26_2

软件与交易接口开通条件:

开通该券商后,存入资金指定资金即可开通。开通后股票交易费率万一

本身券商的交易费率为股票万一,可转债沪百万分之五,深十万分之五,基金万0.5,非常厚道。

不太了解量化行业的可以了解下,不少面向机构的量化交易软件的佣金是万2.5的,且开户门槛高,基本是500W以上,比如华泰的matic量化的门槛是1千万元起步。

所以笔者还是很推荐目前该券商的量化交易接口。

需要开通咨询了解的朋友可以扫码联系:

开通券商账户后可以 可以先试用,再考虑是否开通量化接口权限

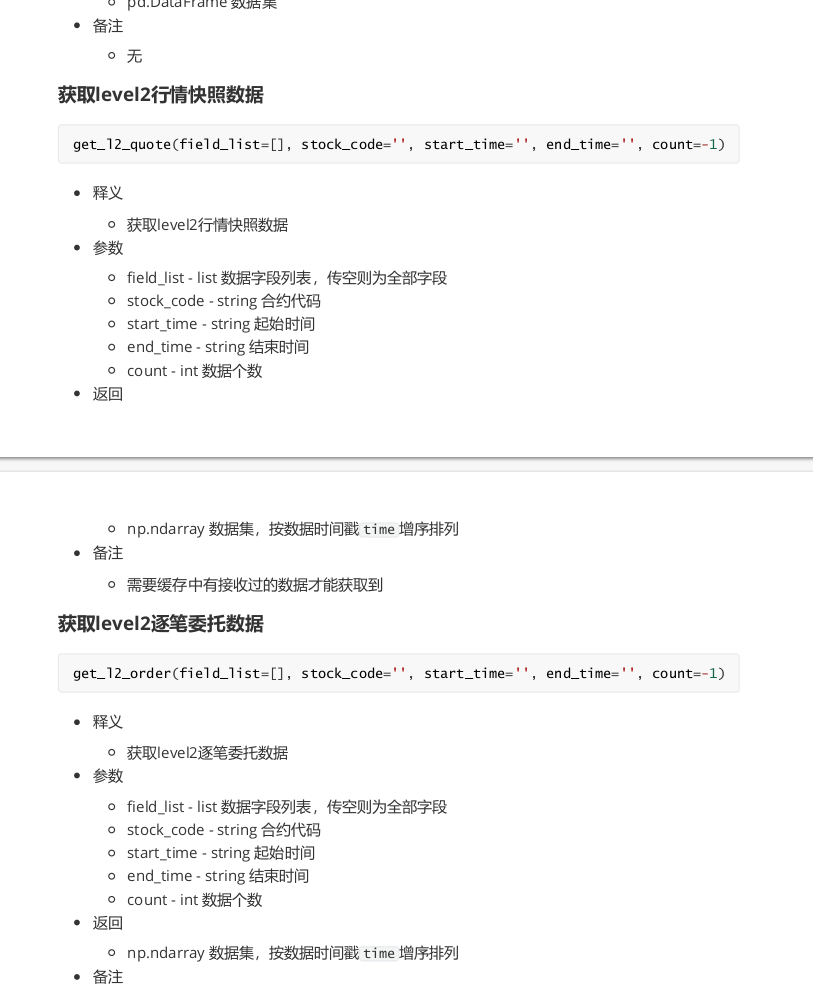

量化交易接口python A股

股票 • 绫波丽 发表了文章 • 0 个评论 • 12939 次浏览 • 2021-07-01 11:22

实际操作也好,几乎没见几个人教你怎么用程序下单,实盘交易。

稍微好点的easytrader使用的是模拟点击交易软件进行点击下单,基本无法判断下单后是否成交,也无法实时获取行情数据。别跟我说用tushare或者新浪这些接口数据,除非你做的是低频交易。

试试扫描一次全市场的行情看看用时多少?等得到满足条件了,再下单,此时价格可能已经在涨停板上封住了。

笔者使用的是券商提供的量化软件:Ptrade。

是恒生电子研发的提供给券商机构使用的程序化交易软件。提供策略回测,自动下单功能,使用的开发语言python。

策略回测与实盘交易

研究页面

研究页面,熟悉python jupyter notebook的朋友对这个界面肯定很熟悉。

研究的页面实际就运行你逐行输出调试程序,了解每个函数的具体使用,或者你策略的中途结果调试。

回测策略

实际代码需要在回测策略里面写,写完后确定无误,就可以放在仿真环境下真实运行。

如果你运行得到的结果很满意,那么就可以直接部署到实盘服务器上。

实盘服务器是在券商那边,不需要个人购买服务器,也不需要本地开着这个Ptrade,就是说不需要在个人电脑上一直开着跑,你的最终代码和程序是在券商服务器上部署与运行,除非有报错异常停止,不然在你不暂停或者停止的前提下,可以一直运行下去。

条件满足后下单

可视化量化

同时也提供一些常见的现成的量化策略,选中后只要鼠标点点点也能够自动化跑这些策略了,当然里面很多参数都可以用鼠标点点点修改。

接口文档也非常详细:

一些常见策略代码:

双均线策略 def initialize(context):

2 # 初始化此策略

3 # 设置我们要操作的股票池, 这里我们只操作一支股票

4 g.security = '600570.SS'

5 set_universe(g.security)

6 pass

7

8 #当五日均线高于十日均线时买入,当五日均线低于十日均线时卖出

9 def handle_data(context, data):

10 security = g.security

11

12 #得到十日历史价格

13 df = get_history(10, '1d', 'close', security, fq=None, include=False)

14

15 # 得到五日均线价格

16 ma5 = round(df['close'][-5:].mean(), 3)

17

18 # 得到十日均线价格

19 ma10 = round(df['close'][-10:].mean(), 3)

20

21 # 取得昨天收盘价

22 price = data[security]['close']

23

24 # 得到当前资金余额

25 cash = context.portfolio.cash

26

27 # 如果当前有余额,并且五日均线大于十日均线

28 if ma5 > ma10:

29 # 用所有 cash 买入股票

30 order_value(security, cash)

31 # 记录这次买入

32 log.info("Buying %s" % (security))

33

34 # 如果五日均线小于十日均线,并且目前有头寸

35 elif ma5 < ma10 and get_position(security).amount > 0:

36 # 全部卖出

37 order_target(security, 0)

38 # 记录这次卖出

39 log.info("Selling %s" % (security))

macd策略

指数平滑均线函数,以price计算,可以选择收盘、开盘价等价格,N为时间周期,m用于计算平滑系数a=m/(N+1),EXPMA1为前一日值 def f_expma(N,m,EXPMA1,price):

2 a = m/(N+1)

3 EXPMA2 = a * price + (1 - a)*EXPMA1

4 return EXPMA2 #2为后一天值

5

6 #定义macd函数,输入平滑系数参数、前一日值,输出当日值

7 def macd(N1,N2,N3,m,EXPMA12_1,EXPMA26_1,DEA1,price):

8 EXPMA12_2 = f_expma(N1,m,EXPMA12_1,price)

9 EXPMA26_2 = f_expma(N2,m,EXPMA26_1,price)

10 DIF2 = EXPMA12_2 - EXPMA26_2

11 a = m/(N3+1)

12 DEA2 = a * DIF2 + (1 - a)*DEA1

13 BAR2=2*(DIF2-DEA2)

14 return EXPMA12_2,EXPMA26_2,DIF2,DEA2,BAR2

15

16 def initialize(context):

17 global init_price

18 init_price = None

19 # 获取沪深300股票

20 g.security = get_index_stocks('000300.SS')

21 #g.security = ['600570.SS']

22 # 设置我们要操作的股票池, 这里我们只操作一支股票

23 set_universe(g.security)

24

25 def handle_data(context, data):

26 # 获取历史数据,这里只获取了2天的数据,如果希望最终MACD指标结果更准确最好是获取

27 # 从股票上市至今的所有历史数据,即增加获取的天数

28 close_price = get_history(2, '1d', field='close', security_list=g.security)

29 #如果是停牌不进行计算

30 for security in g.security:

31 if data[security].is_open >0:

32 global init_price,EXPMA12_1,EXPMA26_1,EXPMA12_2,EXPMA26_2,DIF1,DIF2,DEA1,DEA2

33 if init_price is None:

34 init_price = close_price[security].mean()#nan和N-1个数,mean为N-1个数的均值

35 EXPMA12_1 = init_price

36 EXPMA26_1 = init_price

37 DIF1 = init_price

38 DEA1 = init_price

39 # m用于计算平滑系数a=m/(N+1)

40 m = 2.0

41 #设定指数平滑基期数

42 N1 = 12