通知设置 新通知

scrapy response转化为图片

李魔佛 发表了文章 • 0 个评论 • 4665 次浏览 • 2019-02-01 14:39

with open('temp.jpg','wb') as f:

f.write(reponse.body)

即可。

查看全部

with open('temp.jpg','wb') as f:

f.write(reponse.body)

即可。

拉勾网的反爬策略

李魔佛 发表了文章 • 0 个评论 • 4747 次浏览 • 2019-01-23 10:18

(请注意日期,因为不保证往后的日子里面反爬策略还有效)

1. 封IP,这个没的说,肯定要使用代理IP

2. scrapy里面的需要添加headers,而headers中一定要加上Cookies的数据。 之前要做Request中的cookies参数添加cookies,现在发现失效了,只能在headers中添加cookies数据。

headers = {'Accept': 'application/json,text/javascript,*/*;q=0.01', 'Accept-Encoding':

'gzip,deflate,br',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8', 'Cache-Control': 'no-cache',

# 'Connection': 'keep-alive',

'Content-Type': 'application/x-www-form-urlencoded;charset=UTF-8',

'Cookie': 'JSESSIONID=ABAAABAABEEAAJAACF8F22F99AFA35F9EEC28F2D0E46A41;_ga=GA1.2.331323650.1548204973;_gat=1;Hm_lvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204973;user_trace_token=20190123085612-adf35b62-1ea9-11e9-b744-5254005c3644;LGSID=20190123085612-adf35c69-1ea9-11e9-b744-5254005c3644;PRE_UTM=;PRE_HOST=;PRE_SITE=;PRE_LAND=https%3A%2F%2Fwww.lagou.com%2F;LGUID=20190123085612-adf35ed5-1ea9-11e9-b744-5254005c3644;_gid=GA1.2.1809874038.1548204973;index_location_city=%E6%B7%B1%E5%9C%B3;TG-TRACK-CODE=index_search;SEARCH_ID=169bf76c08b548f8830967a1968d10ca;Hm_lpvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204985;LGRID=20190123085624-b52a0555-1ea9-11e9-b744-5254005c3644',

'Host': 'www.lagou.com', 'Origin': 'https://www.lagou.com', 'Pragma': 'no-cache',

'Referer': 'https://www.lagou.com/jobs/list_%E7%88%AC%E8%99%AB?labelWords=&fromSearch=true&suginput=',

'User-Agent': 'Mozilla/5.0(WindowsNT6.3;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/71.0.3578.98Safari/537.36',

'X-Anit-Forge-Code': '0',

'X-Anit-Forge-Token': 'None',

'X-Requested-With': 'XMLHttpRequest'

} 查看全部

(请注意日期,因为不保证往后的日子里面反爬策略还有效)

1. 封IP,这个没的说,肯定要使用代理IP

2. scrapy里面的需要添加headers,而headers中一定要加上Cookies的数据。 之前要做Request中的cookies参数添加cookies,现在发现失效了,只能在headers中添加cookies数据。

headers = {'Accept': 'application/json,text/javascript,*/*;q=0.01', 'Accept-Encoding':

'gzip,deflate,br',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8', 'Cache-Control': 'no-cache',

# 'Connection': 'keep-alive',

'Content-Type': 'application/x-www-form-urlencoded;charset=UTF-8',

'Cookie': 'JSESSIONID=ABAAABAABEEAAJAACF8F22F99AFA35F9EEC28F2D0E46A41;_ga=GA1.2.331323650.1548204973;_gat=1;Hm_lvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204973;user_trace_token=20190123085612-adf35b62-1ea9-11e9-b744-5254005c3644;LGSID=20190123085612-adf35c69-1ea9-11e9-b744-5254005c3644;PRE_UTM=;PRE_HOST=;PRE_SITE=;PRE_LAND=https%3A%2F%2Fwww.lagou.com%2F;LGUID=20190123085612-adf35ed5-1ea9-11e9-b744-5254005c3644;_gid=GA1.2.1809874038.1548204973;index_location_city=%E6%B7%B1%E5%9C%B3;TG-TRACK-CODE=index_search;SEARCH_ID=169bf76c08b548f8830967a1968d10ca;Hm_lpvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204985;LGRID=20190123085624-b52a0555-1ea9-11e9-b744-5254005c3644',

'Host': 'www.lagou.com', 'Origin': 'https://www.lagou.com', 'Pragma': 'no-cache',

'Referer': 'https://www.lagou.com/jobs/list_%E7%88%AC%E8%99%AB?labelWords=&fromSearch=true&suginput=',

'User-Agent': 'Mozilla/5.0(WindowsNT6.3;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/71.0.3578.98Safari/537.36',

'X-Anit-Forge-Code': '0',

'X-Anit-Forge-Token': 'None',

'X-Requested-With': 'XMLHttpRequest'

} CryptoJS.enc.UTF8 中文乱码

李魔佛 发表了文章 • 4 个评论 • 17103 次浏览 • 2019-01-08 15:52

内容用CryptoJS解密出来的,解出来是一个HTML格式的文本,标签,英文是正常显示的,但是中文是乱码的。

demo: # data='中国人'

data='hello'

ret = CryptoJS.AES.encrypt(data,'secret key 123')

content = ret.toString()

result = CryptoJS.AES.decrypt(content,'secret key 123')

print(result.toString(CryptoJS.enc.Utf8))data用hello可以解密成功,

用“中国人”就还原不了

调试中。

待更新。

已解决:

看大佬最近几期文章,有一篇解决了,就是去Python目录下lib文件夹里面dsubprocess.py

文件下更改encding为UTF-8, 查看全部

内容用CryptoJS解密出来的,解出来是一个HTML格式的文本,标签,英文是正常显示的,但是中文是乱码的。

demo:

# data='中国人'data用hello可以解密成功,

data='hello'

ret = CryptoJS.AES.encrypt(data,'secret key 123')

content = ret.toString()

result = CryptoJS.AES.decrypt(content,'secret key 123')

print(result.toString(CryptoJS.enc.Utf8))

用“中国人”就还原不了

调试中。

待更新。

已解决:

看大佬最近几期文章,有一篇解决了,就是去Python目录下lib文件夹里面dsubprocess.py

文件下更改encding为UTF-8,

浏览器抓包post字段里面有 (unable to decode value) ,requests如何正确的post

李魔佛 发表了文章 • 0 个评论 • 7396 次浏览 • 2018-12-12 14:52

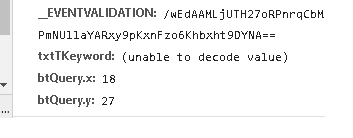

数据是通过post形式提交的, 字段txtTKeyword无法显示,看来是用了其他的编码导致了浏览器无法识别。

可以使用fiddler工具查看。

在python中用代码直接编码后post,不然服务器无法识别提交的数据

注意不需要用 urllib.parse.quote(uncode_str),直接encode就可以(特殊情况特殊处理,有些网站就是奇怪)

s='耐克球鞋'

s =s.encode('gb2312')

data = {'__VIEWSTATE': view_state,

'__EVENTVALIDATION': event_validation,

'txtTKeyword': s,

'btQuery.x': 41,

'btQuery.y': 24,

}

r = session.post(url=self.base_url, headers=headers,

data=data,proxies=self.get_proxy()

查看全部

数据是通过post形式提交的, 字段txtTKeyword无法显示,看来是用了其他的编码导致了浏览器无法识别。

可以使用fiddler工具查看。

在python中用代码直接编码后post,不然服务器无法识别提交的数据

注意不需要用 urllib.parse.quote(uncode_str),直接encode就可以(特殊情况特殊处理,有些网站就是奇怪)

s='耐克球鞋'

s =s.encode('gb2312')

data = {'__VIEWSTATE': view_state,

'__EVENTVALIDATION': event_validation,

'txtTKeyword': s,

'btQuery.x': 41,

'btQuery.y': 24,

}

r = session.post(url=self.base_url, headers=headers,

data=data,proxies=self.get_proxy()

批量获取Grequests返回内容

李魔佛 发表了文章 • 0 个评论 • 7172 次浏览 • 2018-11-23 10:36

如何批量获取Grequests返回内容?

import grequests

import requests

import bs4

def simple_request(url):

page = requests.get(url)

return page

urls = [

'http://www.heroku.com',

'http://python-tablib.org',

'http://httpbin.org',

'http://python-requests.org',

'http://kennethreitz.com'

]

rs = [grequests.get(simple_request(u)) for u in urls]

grequests.map(rs)

注意,上面的写法是错误的!!!!!!

grequests.get只能接受url!!! 不能放入一个函数。

正确的写法:

rs = (grequests.get(u) for u in urls)

requests = grequests.map(rs)

for response in requests:

market_watch(response.content)

具体的对response内容操作放入到market_watch函数中。

查看全部

如何批量获取Grequests返回内容?

import grequests

import requests

import bs4

def simple_request(url):

page = requests.get(url)

return page

urls = [

'http://www.heroku.com',

'http://python-tablib.org',

'http://httpbin.org',

'http://python-requests.org',

'http://kennethreitz.com'

]

rs = [grequests.get(simple_request(u)) for u in urls]

grequests.map(rs)

注意,上面的写法是错误的!!!!!!

grequests.get只能接受url!!! 不能放入一个函数。

正确的写法:

rs = (grequests.get(u) for u in urls)

requests = grequests.map(rs)

for response in requests:

market_watch(response.content)

具体的对response内容操作放入到market_watch函数中。

雪球的元卫南靠打赏收割了多少钱 ? python爬虫实例

李魔佛 发表了文章 • 7 个评论 • 33251 次浏览 • 2018-10-23 18:37

今天重新爬了一下,元卫南今年的人气暴涨,在2019年开始到现在,已经获取了31851.6元的打赏金额,虽然金额也不是特别高,但是已经比他2019年前所有打赏金额之和还要高了。 具体分析过程见 http://30daydo.com/article/362

********* 2019-08-05 更新 ***********

文章是去年写的,没想到最近居然在雪球火了。 后续会更新下最新的数据,还有趴一趴释老毛的打赏金额。

雪球的元卫南每天坚持发帖,把一个股民的日常描述的栩栩如生,让人感叹股民的无助与悲哀。 同时也看到上了严重杠杆后,对生活造成的压力,靠着借债来给股票续命。

元卫南雪球链接:https://xueqiu.com/u/2227798650

而且不断有人质疑元卫南写文章,靠打赏金来消费粉丝。 刚开始我也这么觉得,毕竟不少人几十块,一百块的打赏,十几万的粉丝,那每天的收入都很客观呀。 于是抱着好奇心,把元卫南的所有专栏的文章都爬下来,获取每个文章的赏金金额,然后就知道元兄到底靠赏金拿了多少钱。

撸起袖子干。 代码不多,在python3的环境下运行,隐去了header的个人信息,如果在电脑上运行,把你个人的header和cookie加上即可# -*-coding=utf-8-*-

# @Time : 2018/10/23 9:26

# @File : money_reward.py

import requests

from collections import OrderedDict

import time

import datetime

import pymongo

import config

session = requests.Session()

def get_proxy(retry=10):

proxyurl = 'http://{}:8081/dynamicIp/common/getDynamicIp.do'.format(config.PROXY)

count = 0

for i in range(retry):

try:

r = requests.get(proxyurl, timeout=10)

except Exception as e:

print(e)

count += 1

print('代理获取失败,重试' + str(count))

time.sleep(1)

else:

js = r.json()

proxyServer = 'http://{0}:{1}'.format(js.get('ip'), js.get('port'))

proxies_random = {

'http': proxyServer

}

return proxies_random

def get_content(url):

headers = {

# 此处添加个人的header信息

}

try:

proxy = get_proxy()

except Exception as e:

print(e)

proxy = get_proxy()

try:

r = session.get(url=url, headers=headers,proxies=proxy,timeout=10)

except Exception as e:

print(e)

proxy = get_proxy()

r = session.get(url=url, headers=headers,proxies=proxy,timeout=10)

return r

def parse_content(post_id):

url = 'https://xueqiu.com/statuses/reward/list_by_user.json?status_id={}&page=1&size=99999999'.format(post_id)

r = get_content(url)

print(r.text)

if r.status_code != 200:

print('status code != 200')

failed_doc.insert({'post_id':post_id,'status':0})

return None

try:

js_data = r.json()

except Exception as e:

print(e)

print('can not parse to json')

print(post_id)

failed_doc.insert({'post_id': post_id, 'status': 0})

return

ret =

been_reward_user = '元卫南'

for item in js_data.get('items'):

name = item.get('name')

amount = item.get('amount')

description = item.get('description')

user_id = item.get('user_id')

created_at = item.get('created_at')

if created_at:

created_at = datetime.datetime.fromtimestamp(int(created_at) / 1000).strftime('%Y-%m-%d %H:%M:%S')

d = OrderedDict()

d['name'] = name

d['user_id'] = user_id

d['amount'] = amount / 100

d['description'] = description

d['created_at'] = created_at

d['been_reward'] = been_reward_user

ret.append(d)

print(ret)

if ret:

doc.insert_many(ret)

failed_doc.insert({'post_id':post_id,'status':1})

def get_all_page_id(user_id):

doc = db['db_parker']['xueqiu_zhuanglan']

get_page_url = 'https://xueqiu.com/statuses/original/timeline.json?user_id={}&page=1'.format(user_id)

r = get_content(get_page_url)

max_page = int(r.json().get('maxPage'))

for i in range(1, max_page + 1):

url = 'https://xueqiu.com/statuses/original/timeline.json?user_id=2227798650&page={}'.format(i)

r = get_content(url)

js_data = r.json()

ret =

for item in js_data.get('list'):

d = OrderedDict()

d['article_id'] = item.get('id')

d['title'] = item.get('title')

d['description'] = item.get('description')

d['view_count'] = item.get('view_count')

d['target'] = 'https://xueqiu.com/' + item.get('target')

d['user_id']= item.get('user_id')

d['created_at'] = datetime.datetime.fromtimestamp(int(item.get('created_at')) / 1000).strftime(

'%Y-%m-%d %H:%M:%S')

ret.append(d)

print(d)

doc.insert_many(ret)

def loop_page_id():

doc = db['db_parker']['xueqiu_zhuanglan']

ret = doc.find({},{'article_id':1})

failed_doc = db['db_parker']['xueqiu_reward_status']

failed_ret = failed_doc.find({'status':1})

article_id_list =

for i in failed_ret:

article_id_list.append(i.get('article_id'))

for item in ret:

article_id = item.get('article_id')

print(article_id)

if article_id in article_id_list:

continue

else:

parse_content(article_id)

loop_page_id()

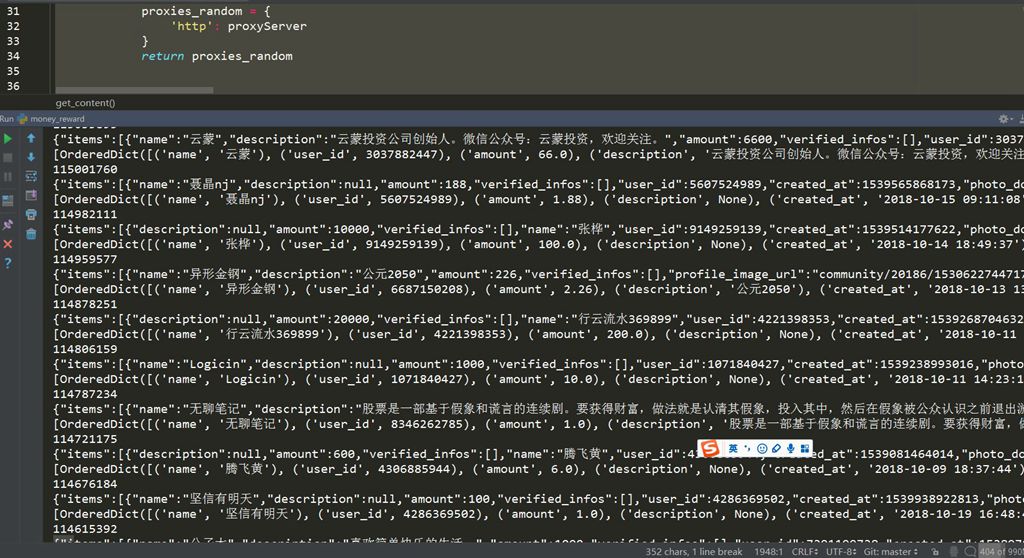

然后就是开始爬。

因为使用了代理,所有速度回有点慢,大概10分钟就把所有内容爬完了。

点击查看大图

数据是存储在mongodb数据库中,打开mongodb,可以查看每一条数据,还可以做统计。

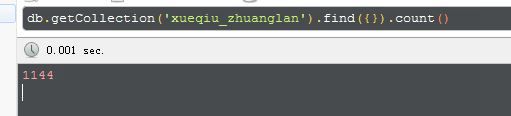

点击查看大图

从今天(2018-10-23)追溯到元兄第一篇专栏文章(2014-2-17),元兄总共发了1144篇文章。

点击查看大图

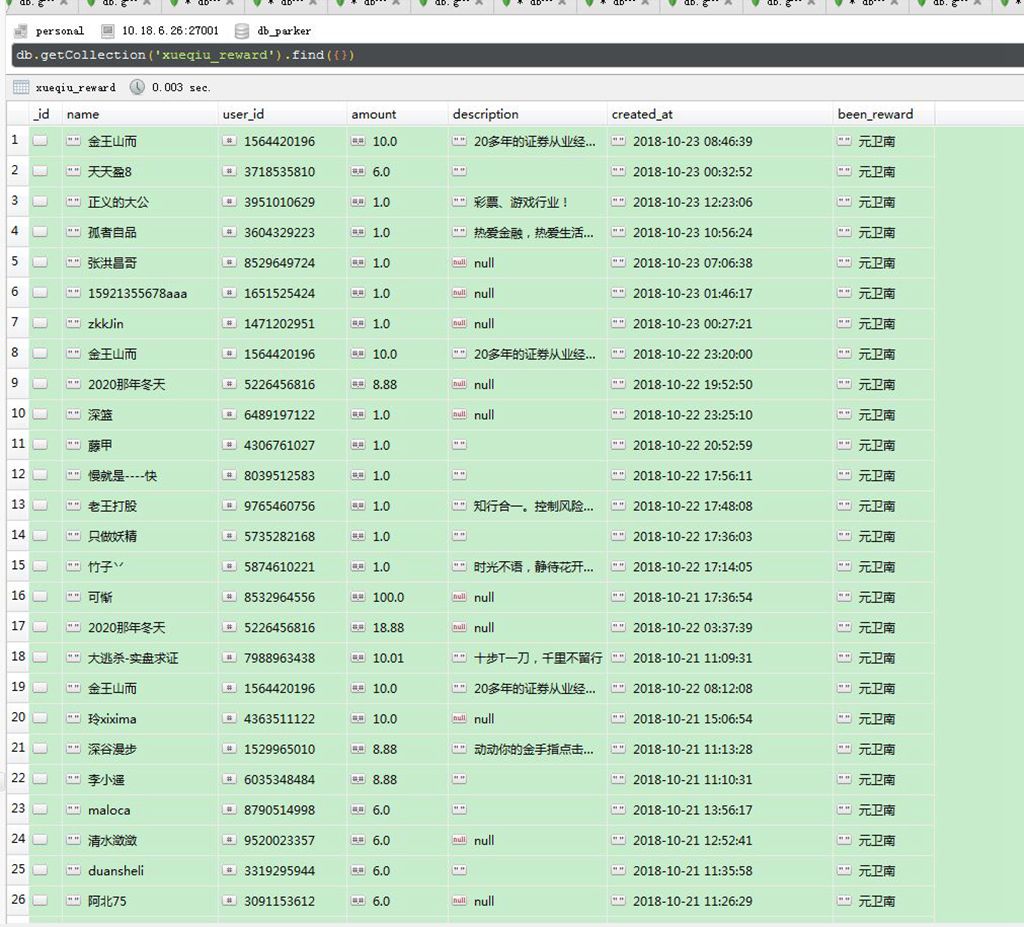

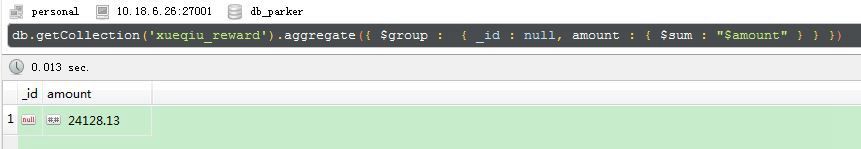

然后再看另外一个打赏的列表

点击查看大图

从最新的开始日期(2018-10-23),这位 金王山而 的用户似乎打赏的很多次,看了是元兄的忠实粉丝。

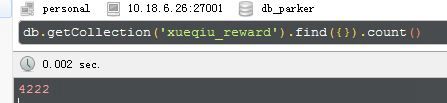

统计了下,元神共有4222次打赏。

点击查看大图

打赏总金额为:

24128.13

点击查看大图

好吧,太出乎意料了!!! 还以为会有几百万的打赏金额呀,最后算出来才只有24128,这点钱,元兄只够补仓5手东阿阿胶呀。

然后按照打赏金额排序:

点击查看大图

打赏最高金额的是唐史主任,金额为250元,200元的有十来个, 还看到之前梁大师打赏的200元,可以排在并列前10了。

其实大部分人都是拿小钱来打赏下,2元以下就有2621,占了50%了。

还是很支持元神每天坚持发帖,在当前的行情下或可以聊以慰藉,或娱乐大家,或引以为戒,让大家看到股市对散户生活造成的影响,避免重蹈覆辙。

原创文章

转载请注明出处:

http://30daydo.com/article/361

个人公众号:

下篇:

python数据分析入门 分析雪球元卫南每个月打赏收入 查看全部

今天重新爬了一下,元卫南今年的人气暴涨,在2019年开始到现在,已经获取了31851.6元的打赏金额,虽然金额也不是特别高,但是已经比他2019年前所有打赏金额之和还要高了。 具体分析过程见 http://30daydo.com/article/362

********* 2019-08-05 更新 ***********

文章是去年写的,没想到最近居然在雪球火了。 后续会更新下最新的数据,还有趴一趴释老毛的打赏金额。

雪球的元卫南每天坚持发帖,把一个股民的日常描述的栩栩如生,让人感叹股民的无助与悲哀。 同时也看到上了严重杠杆后,对生活造成的压力,靠着借债来给股票续命。

元卫南雪球链接:https://xueqiu.com/u/2227798650

而且不断有人质疑元卫南写文章,靠打赏金来消费粉丝。 刚开始我也这么觉得,毕竟不少人几十块,一百块的打赏,十几万的粉丝,那每天的收入都很客观呀。 于是抱着好奇心,把元卫南的所有专栏的文章都爬下来,获取每个文章的赏金金额,然后就知道元兄到底靠赏金拿了多少钱。

撸起袖子干。 代码不多,在python3的环境下运行,隐去了header的个人信息,如果在电脑上运行,把你个人的header和cookie加上即可

# -*-coding=utf-8-*-

# @Time : 2018/10/23 9:26

# @File : money_reward.py

import requests

from collections import OrderedDict

import time

import datetime

import pymongo

import config

session = requests.Session()

def get_proxy(retry=10):

proxyurl = 'http://{}:8081/dynamicIp/common/getDynamicIp.do'.format(config.PROXY)

count = 0

for i in range(retry):

try:

r = requests.get(proxyurl, timeout=10)

except Exception as e:

print(e)

count += 1

print('代理获取失败,重试' + str(count))

time.sleep(1)

else:

js = r.json()

proxyServer = 'http://{0}:{1}'.format(js.get('ip'), js.get('port'))

proxies_random = {

'http': proxyServer

}

return proxies_random

def get_content(url):

headers = {

# 此处添加个人的header信息

}

try:

proxy = get_proxy()

except Exception as e:

print(e)

proxy = get_proxy()

try:

r = session.get(url=url, headers=headers,proxies=proxy,timeout=10)

except Exception as e:

print(e)

proxy = get_proxy()

r = session.get(url=url, headers=headers,proxies=proxy,timeout=10)

return r

def parse_content(post_id):

url = 'https://xueqiu.com/statuses/reward/list_by_user.json?status_id={}&page=1&size=99999999'.format(post_id)

r = get_content(url)

print(r.text)

if r.status_code != 200:

print('status code != 200')

failed_doc.insert({'post_id':post_id,'status':0})

return None

try:

js_data = r.json()

except Exception as e:

print(e)

print('can not parse to json')

print(post_id)

failed_doc.insert({'post_id': post_id, 'status': 0})

return

ret =

been_reward_user = '元卫南'

for item in js_data.get('items'):

name = item.get('name')

amount = item.get('amount')

description = item.get('description')

user_id = item.get('user_id')

created_at = item.get('created_at')

if created_at:

created_at = datetime.datetime.fromtimestamp(int(created_at) / 1000).strftime('%Y-%m-%d %H:%M:%S')

d = OrderedDict()

d['name'] = name

d['user_id'] = user_id

d['amount'] = amount / 100

d['description'] = description

d['created_at'] = created_at

d['been_reward'] = been_reward_user

ret.append(d)

print(ret)

if ret:

doc.insert_many(ret)

failed_doc.insert({'post_id':post_id,'status':1})

def get_all_page_id(user_id):

doc = db['db_parker']['xueqiu_zhuanglan']

get_page_url = 'https://xueqiu.com/statuses/original/timeline.json?user_id={}&page=1'.format(user_id)

r = get_content(get_page_url)

max_page = int(r.json().get('maxPage'))

for i in range(1, max_page + 1):

url = 'https://xueqiu.com/statuses/original/timeline.json?user_id=2227798650&page={}'.format(i)

r = get_content(url)

js_data = r.json()

ret =

for item in js_data.get('list'):

d = OrderedDict()

d['article_id'] = item.get('id')

d['title'] = item.get('title')

d['description'] = item.get('description')

d['view_count'] = item.get('view_count')

d['target'] = 'https://xueqiu.com/' + item.get('target')

d['user_id']= item.get('user_id')

d['created_at'] = datetime.datetime.fromtimestamp(int(item.get('created_at')) / 1000).strftime(

'%Y-%m-%d %H:%M:%S')

ret.append(d)

print(d)

doc.insert_many(ret)

def loop_page_id():

doc = db['db_parker']['xueqiu_zhuanglan']

ret = doc.find({},{'article_id':1})

failed_doc = db['db_parker']['xueqiu_reward_status']

failed_ret = failed_doc.find({'status':1})

article_id_list =

for i in failed_ret:

article_id_list.append(i.get('article_id'))

for item in ret:

article_id = item.get('article_id')

print(article_id)

if article_id in article_id_list:

continue

else:

parse_content(article_id)

loop_page_id()

然后就是开始爬。

因为使用了代理,所有速度回有点慢,大概10分钟就把所有内容爬完了。

点击查看大图

数据是存储在mongodb数据库中,打开mongodb,可以查看每一条数据,还可以做统计。

点击查看大图

从今天(2018-10-23)追溯到元兄第一篇专栏文章(2014-2-17),元兄总共发了1144篇文章。

点击查看大图

然后再看另外一个打赏的列表

点击查看大图

从最新的开始日期(2018-10-23),这位 金王山而 的用户似乎打赏的很多次,看了是元兄的忠实粉丝。

统计了下,元神共有4222次打赏。

点击查看大图

打赏总金额为:

24128.13

点击查看大图

好吧,太出乎意料了!!! 还以为会有几百万的打赏金额呀,最后算出来才只有24128,这点钱,元兄只够补仓5手东阿阿胶呀。

然后按照打赏金额排序:

点击查看大图

打赏最高金额的是唐史主任,金额为250元,200元的有十来个, 还看到之前梁大师打赏的200元,可以排在并列前10了。

其实大部分人都是拿小钱来打赏下,2元以下就有2621,占了50%了。

还是很支持元神每天坚持发帖,在当前的行情下或可以聊以慰藉,或娱乐大家,或引以为戒,让大家看到股市对散户生活造成的影响,避免重蹈覆辙。

原创文章

转载请注明出处:

http://30daydo.com/article/361

个人公众号:

下篇:

python数据分析入门 分析雪球元卫南每个月打赏收入

python3 pytesseract Tesseract-OCR 验证码识别工具的安装

李魔佛 发表了文章 • 2 个评论 • 5336 次浏览 • 2018-10-13 19:48

1. 首先安装Tesseract-OCR

可以google或者百度搜索,实在找不到可以到百度网盘下载:

https://pan.baidu.com/s/1Y7nLk5QKioK2DG5oxrMFlQ

下载后就直接安装, 安装时记住安装的路径,默认是在 C:\Program Files (x86)\Tesseract-OCR

2. 安装 pytesseract

使用pip命令安装

pip install pytesseract

3. 配置环境变量:

我的电脑 右键,点击属性

有个环境变量的选项:

然后添加一个环境变量:

名字叫:TESSDATA_PREFIX

它的值就是Tesseract-OCR安装路径

比如我的就是 C:\Program Files (x86)\Tesseract-OCR

4. 一般按照前三步就可以正常使用pytesseract了。

如果还是无法使用,那么可以找到文件 pytesseract.py,这个文件看你是安装的python2还是python3,

假如是python3,那么文件路径大概就是在 C:\python3_64\Lib\site-packages\pytesseract (具体位置根据你的python安装路径为准), 然后打开这个文件, 大概在28行的位置:

把这个tesseract_cmd的路径修改为 tesseract_cmd = r'C:\Program Files (x86)\Tesseract-OCR\tesseract.exe'

然后最重要的一部就是。 关掉你的pycharm或者IDE,或者cmd命令行。

重新打开pycharm或者新开一个cmd窗口, 然后运行一下pytesseract的识别代码,就可以正常识别拉。

from PIL import Image

im = Image.open('test_0.jpg')

pytesseract.image_to_string(im)

查看全部

1. 首先安装Tesseract-OCR

可以google或者百度搜索,实在找不到可以到百度网盘下载:

https://pan.baidu.com/s/1Y7nLk5QKioK2DG5oxrMFlQ

下载后就直接安装, 安装时记住安装的路径,默认是在 C:\Program Files (x86)\Tesseract-OCR

2. 安装 pytesseract

使用pip命令安装

pip install pytesseract

3. 配置环境变量:

我的电脑 右键,点击属性

有个环境变量的选项:

然后添加一个环境变量:

名字叫:TESSDATA_PREFIX

它的值就是Tesseract-OCR安装路径

比如我的就是 C:\Program Files (x86)\Tesseract-OCR

4. 一般按照前三步就可以正常使用pytesseract了。

如果还是无法使用,那么可以找到文件 pytesseract.py,这个文件看你是安装的python2还是python3,

假如是python3,那么文件路径大概就是在 C:\python3_64\Lib\site-packages\pytesseract (具体位置根据你的python安装路径为准), 然后打开这个文件, 大概在28行的位置:

把这个tesseract_cmd的路径修改为 tesseract_cmd = r'C:\Program Files (x86)\Tesseract-OCR\tesseract.exe'

然后最重要的一部就是。 关掉你的pycharm或者IDE,或者cmd命令行。

重新打开pycharm或者新开一个cmd窗口, 然后运行一下pytesseract的识别代码,就可以正常识别拉。

from PIL import Image

im = Image.open('test_0.jpg')

pytesseract.image_to_string(im)

python爬虫集思录所有用户的帖子 scrapy写入mongodb数据库

李魔佛 发表了文章 • 0 个评论 • 7480 次浏览 • 2018-09-02 21:52

项目采用scrapy的框架,数据写入到mongodb的数据库。 整个站点爬下来大概用了半小时,数据有12w条。

项目中的主要代码如下:

主spider# -*- coding: utf-8 -*-

import re

import scrapy

from scrapy import Request, FormRequest

from jsl.items import JslItem

from jsl import config

import logging

class AllcontentSpider(scrapy.Spider):

name = 'allcontent'

headers = {

'Host': 'www.jisilu.cn', 'Connection': 'keep-alive', 'Pragma': 'no-cache',

'Cache-Control': 'no-cache', 'Accept': 'application/json,text/javascript,*/*;q=0.01',

'Origin': 'https://www.jisilu.cn', 'X-Requested-With': 'XMLHttpRequest',

'User-Agent': 'Mozilla/5.0(WindowsNT6.1;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/67.0.3396.99Safari/537.36',

'Content-Type': 'application/x-www-form-urlencoded;charset=UTF-8',

'Referer': 'https://www.jisilu.cn/login/',

'Accept-Encoding': 'gzip,deflate,br',

'Accept-Language': 'zh,en;q=0.9,en-US;q=0.8'

}

def start_requests(self):

login_url = 'https://www.jisilu.cn/login/'

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip,deflate,br', 'Accept-Language': 'zh,en;q=0.9,en-US;q=0.8',

'Cache-Control': 'no-cache', 'Connection': 'keep-alive',

'Host': 'www.jisilu.cn', 'Pragma': 'no-cache', 'Referer': 'https://www.jisilu.cn/',

'Upgrade-Insecure-Requests': '1',

'User-Agent': 'Mozilla/5.0(WindowsNT6.1;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/67.0.3396.99Safari/537.36'}

yield Request(url=login_url, headers=headers, callback=self.login,dont_filter=True)

def login(self, response):

url = 'https://www.jisilu.cn/account/ajax/login_process/'

data = {

'return_url': 'https://www.jisilu.cn/',

'user_name': config.username,

'password': config.password,

'net_auto_login': '1',

'_post_type': 'ajax',

}

yield FormRequest(

url=url,

headers=self.headers,

formdata=data,

callback=self.parse,

dont_filter=True

)

def parse(self, response):

for i in range(1,3726):

focus_url = 'https://www.jisilu.cn/home/explore/sort_type-new__day-0__page-{}'.format(i)

yield Request(url=focus_url, headers=self.headers, callback=self.parse_page,dont_filter=True)

def parse_page(self, response):

nodes = response.xpath('//div[@class="aw-question-list"]/div')

for node in nodes:

each_url=node.xpath('.//h4/a/@href').extract_first()

yield Request(url=each_url,headers=self.headers,callback=self.parse_item,dont_filter=True)

def parse_item(self,response):

item = JslItem()

title = response.xpath('//div[@class="aw-mod-head"]/h1/text()').extract_first()

s = response.xpath('//div[@class="aw-question-detail-txt markitup-box"]').xpath('string(.)').extract_first()

ret = re.findall('(.*?)\.donate_user_avatar', s, re.S)

try:

content = ret[0].strip()

except:

content = None

createTime = response.xpath('//div[@class="aw-question-detail-meta"]/span/text()').extract_first()

resp_no = response.xpath('//div[@class="aw-mod aw-question-detail-box"]//ul/h2/text()').re_first('\d+')

url = response.url

item['title'] = title.strip()

item['content'] = content

try:

item['resp_no']=int(resp_no)

except Exception as e:

logging.warning('e')

item['resp_no']=None

item['createTime'] = createTime

item['url'] = url.strip()

resp =

for index,reply in enumerate(response.xpath('//div[@class="aw-mod-body aw-dynamic-topic"]/div[@class="aw-item"]')):

replay_user = reply.xpath('.//div[@class="pull-left aw-dynamic-topic-content"]//p/a/text()').extract_first()

rep_content = reply.xpath(

'.//div[@class="pull-left aw-dynamic-topic-content"]//div[@class="markitup-box"]/text()').extract_first()

# print rep_content

agree=reply.xpath('.//em[@class="aw-border-radius-5 aw-vote-count pull-left"]/text()').extract_first()

resp.append({replay_user.strip()+'_{}'.format(index): [int(agree),rep_content.strip()]})

item['resp'] = resp

yield item

login函数是模拟登录集思录,通过抓包就可以知道一些上传的data。

然后就是分页去抓取。逻辑很简单。

然后pipeline里面写入mongodb。import pymongo

from collections import OrderedDict

class JslPipeline(object):

def __init__(self):

self.db = pymongo.MongoClient(host='10.18.6.1',port=27017)

# self.user = u'neo牛3' # 修改为指定的用户名 如 毛之川 ,然后找到用户的id,在用户也的源码哪里可以找到 比如持有封基是8132

self.collection = self.db['db_parker']['jsl']

def process_item(self, item, spider):

self.collection.insert(OrderedDict(item))

return item

抓取到的数据入库mongodb:

点击查看大图

原创文章

转载请注明出处:http://30daydo.com/publish/article/351

查看全部

项目采用scrapy的框架,数据写入到mongodb的数据库。 整个站点爬下来大概用了半小时,数据有12w条。

项目中的主要代码如下:

主spider

# -*- coding: utf-8 -*-

import re

import scrapy

from scrapy import Request, FormRequest

from jsl.items import JslItem

from jsl import config

import logging

class AllcontentSpider(scrapy.Spider):

name = 'allcontent'

headers = {

'Host': 'www.jisilu.cn', 'Connection': 'keep-alive', 'Pragma': 'no-cache',

'Cache-Control': 'no-cache', 'Accept': 'application/json,text/javascript,*/*;q=0.01',

'Origin': 'https://www.jisilu.cn', 'X-Requested-With': 'XMLHttpRequest',

'User-Agent': 'Mozilla/5.0(WindowsNT6.1;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/67.0.3396.99Safari/537.36',

'Content-Type': 'application/x-www-form-urlencoded;charset=UTF-8',

'Referer': 'https://www.jisilu.cn/login/',

'Accept-Encoding': 'gzip,deflate,br',

'Accept-Language': 'zh,en;q=0.9,en-US;q=0.8'

}

def start_requests(self):

login_url = 'https://www.jisilu.cn/login/'

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip,deflate,br', 'Accept-Language': 'zh,en;q=0.9,en-US;q=0.8',

'Cache-Control': 'no-cache', 'Connection': 'keep-alive',

'Host': 'www.jisilu.cn', 'Pragma': 'no-cache', 'Referer': 'https://www.jisilu.cn/',

'Upgrade-Insecure-Requests': '1',

'User-Agent': 'Mozilla/5.0(WindowsNT6.1;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/67.0.3396.99Safari/537.36'}

yield Request(url=login_url, headers=headers, callback=self.login,dont_filter=True)

def login(self, response):

url = 'https://www.jisilu.cn/account/ajax/login_process/'

data = {

'return_url': 'https://www.jisilu.cn/',

'user_name': config.username,

'password': config.password,

'net_auto_login': '1',

'_post_type': 'ajax',

}

yield FormRequest(

url=url,

headers=self.headers,

formdata=data,

callback=self.parse,

dont_filter=True

)

def parse(self, response):

for i in range(1,3726):

focus_url = 'https://www.jisilu.cn/home/explore/sort_type-new__day-0__page-{}'.format(i)

yield Request(url=focus_url, headers=self.headers, callback=self.parse_page,dont_filter=True)

def parse_page(self, response):

nodes = response.xpath('//div[@class="aw-question-list"]/div')

for node in nodes:

each_url=node.xpath('.//h4/a/@href').extract_first()

yield Request(url=each_url,headers=self.headers,callback=self.parse_item,dont_filter=True)

def parse_item(self,response):

item = JslItem()

title = response.xpath('//div[@class="aw-mod-head"]/h1/text()').extract_first()

s = response.xpath('//div[@class="aw-question-detail-txt markitup-box"]').xpath('string(.)').extract_first()

ret = re.findall('(.*?)\.donate_user_avatar', s, re.S)

try:

content = ret[0].strip()

except:

content = None

createTime = response.xpath('//div[@class="aw-question-detail-meta"]/span/text()').extract_first()

resp_no = response.xpath('//div[@class="aw-mod aw-question-detail-box"]//ul/h2/text()').re_first('\d+')

url = response.url

item['title'] = title.strip()

item['content'] = content

try:

item['resp_no']=int(resp_no)

except Exception as e:

logging.warning('e')

item['resp_no']=None

item['createTime'] = createTime

item['url'] = url.strip()

resp =

for index,reply in enumerate(response.xpath('//div[@class="aw-mod-body aw-dynamic-topic"]/div[@class="aw-item"]')):

replay_user = reply.xpath('.//div[@class="pull-left aw-dynamic-topic-content"]//p/a/text()').extract_first()

rep_content = reply.xpath(

'.//div[@class="pull-left aw-dynamic-topic-content"]//div[@class="markitup-box"]/text()').extract_first()

# print rep_content

agree=reply.xpath('.//em[@class="aw-border-radius-5 aw-vote-count pull-left"]/text()').extract_first()

resp.append({replay_user.strip()+'_{}'.format(index): [int(agree),rep_content.strip()]})

item['resp'] = resp

yield item

login函数是模拟登录集思录,通过抓包就可以知道一些上传的data。

然后就是分页去抓取。逻辑很简单。

然后pipeline里面写入mongodb。

import pymongo

from collections import OrderedDict

class JslPipeline(object):

def __init__(self):

self.db = pymongo.MongoClient(host='10.18.6.1',port=27017)

# self.user = u'neo牛3' # 修改为指定的用户名 如 毛之川 ,然后找到用户的id,在用户也的源码哪里可以找到 比如持有封基是8132

self.collection = self.db['db_parker']['jsl']

def process_item(self, item, spider):

self.collection.insert(OrderedDict(item))

return item

抓取到的数据入库mongodb:

点击查看大图

原创文章

转载请注明出处:http://30daydo.com/publish/article/351

how to use proxy in scrapy_splash ?

李魔佛 发表了文章 • 3 个评论 • 4564 次浏览 • 2018-08-24 21:44

yield scrapy.Request(

url=self.base_url.format(i),

meta={'page':str(i),

'splash': {

'args': {

'images':0,

'wait': 15,

'proxy': self.get_proxy(),

},

'endpoint': 'render.html',

},

},

)

其中get_proxy() 返回的是 字符创,类似于 http://8.8.8.8.8:8888 这样的格式代理数据。

这个方式自己试过是可以使用的。

当然也可以使用 scrapy_splash 中的 SplashRequest方法进行调用,参数一样,只是位置有点变化。

方法二是写中间件,不过自己试了很多次,没有成功。 感觉网上的都是忽悠。

就是在 process_request中修改 request['splash']['args']['proxy']=xxxxxxx

无效,另外一个朋友也沟通过,也是说无法生效。

如果有人成功了的话,可以私信交流交流。

查看全部

yield scrapy.Request(

url=self.base_url.format(i),

meta={'page':str(i),

'splash': {

'args': {

'images':0,

'wait': 15,

'proxy': self.get_proxy(),

},

'endpoint': 'render.html',

},

},

)

其中get_proxy() 返回的是 字符创,类似于 http://8.8.8.8.8:8888 这样的格式代理数据。

这个方式自己试过是可以使用的。

当然也可以使用 scrapy_splash 中的 SplashRequest方法进行调用,参数一样,只是位置有点变化。

方法二是写中间件,不过自己试了很多次,没有成功。 感觉网上的都是忽悠。

就是在 process_request中修改 request['splash']['args']['proxy']=xxxxxxx

无效,另外一个朋友也沟通过,也是说无法生效。

如果有人成功了的话,可以私信交流交流。

scrapy记录日志的最新方法

李魔佛 发表了文章 • 0 个评论 • 4868 次浏览 • 2018-08-15 15:01

log.msg("This is a warning", level=log.WARING)

在Spider中添加log

在spider中添加log的推荐方式是使用Spider的 log() 方法。该方法会自动在调用 scrapy.log.start() 时赋值 spider 参数。

其它的参数则直接传递给 msg() 方法

scrapy.log模块scrapy.log.start(logfile=None, loglevel=None, logstdout=None)启动log功能。该方法必须在记录任何信息之前被调用。否则调用前的信息将会丢失。

但是运行的时候出现警告:

[py.warnings] WARNING: E:\git\CrawlMan\bilibili\bilibili\spiders\bili.py:14: ScrapyDeprecationWarning: log.msg has been deprecated, create a python logger and log through it instead

log.msg

原来官方以及不推荐使用log.msg了

最新的用法:# -*- coding: utf-8 -*-

import scrapy

from scrapy_splash import SplashRequest

import logging

# from scrapy import log

class BiliSpider(scrapy.Spider):

name = 'ordinary' # 这个名字就是上面连接中那个启动应用的名字

allowed_domain = ["bilibili.com"]

start_urls = [

"https://www.bilibili.com/"

]

def parse(self, response):

logging.info('====================================================')

content = response.xpath("//div[@class='num-wrap']").extract_first()

logging.info(content)

logging.info('====================================================') 查看全部

from scrapy import log

log.msg("This is a warning", level=log.WARING)

在Spider中添加log

在spider中添加log的推荐方式是使用Spider的 log() 方法。该方法会自动在调用 scrapy.log.start() 时赋值 spider 参数。

其它的参数则直接传递给 msg() 方法

scrapy.log模块scrapy.log.start(logfile=None, loglevel=None, logstdout=None)启动log功能。该方法必须在记录任何信息之前被调用。否则调用前的信息将会丢失。

但是运行的时候出现警告:

[py.warnings] WARNING: E:\git\CrawlMan\bilibili\bilibili\spiders\bili.py:14: ScrapyDeprecationWarning: log.msg has been deprecated, create a python logger and log through it instead

log.msg

原来官方以及不推荐使用log.msg了

最新的用法:

# -*- coding: utf-8 -*-

import scrapy

from scrapy_splash import SplashRequest

import logging

# from scrapy import log

class BiliSpider(scrapy.Spider):

name = 'ordinary' # 这个名字就是上面连接中那个启动应用的名字

allowed_domain = ["bilibili.com"]

start_urls = [

"https://www.bilibili.com/"

]

def parse(self, response):

logging.info('====================================================')

content = response.xpath("//div[@class='num-wrap']").extract_first()

logging.info(content)

logging.info('====================================================')

想写一个爬取开奖数据并预测下一期的py

李魔佛 回复了问题 • 2 人关注 • 1 个回复 • 6863 次浏览 • 2018-08-10 00:22

最新版的chrome中info lite居然不支持了

李魔佛 发表了文章 • 0 个评论 • 3752 次浏览 • 2018-06-25 18:58

只好降级......

版本 65.0.3325.162(正式版本) (64 位)

这个版本最新且支持info lite的。

只好降级......

版本 65.0.3325.162(正式版本) (64 位)

这个版本最新且支持info lite的。

Message: invalid selector: Compound class names not permitted

李魔佛 发表了文章 • 0 个评论 • 4518 次浏览 • 2018-01-30 00:59

driver.find_element_by_class_name("content")

使用class名字来查找元素的话,就会出现

Message: invalid selector: Compound class names not permitted

这个错误。

比如京东的登录页面中:

<div id="content">

<div class="login-wrap">

<div class="w">

<div class="login-form">

<div class="login-tab login-tab-l">

<a href="javascript:void(0)" clstag="pageclick|keycount|201607144|1"> 扫码登录</a>

</div>

<div class="login-tab login-tab-r">

<a href="javascript:void(0)" clstag="pageclick|keycount|201607144|2">账户登录</a>

</div>

<div class="login-box">

<div class="mt tab-h">

</div>

<div class="msg-wrap">

<div class="msg-error hide"><b></b></div>

</div>

我要找的是<div class="login-tab login-tab-l">

那么应该使用css选择器:

browser.find_element_by_css_selector('div.login-tab.login-tab-r')

查看全部

driver.find_element_by_class_name("content")

使用class名字来查找元素的话,就会出现

Message: invalid selector: Compound class names not permitted

这个错误。

比如京东的登录页面中:

<div id="content">

<div class="login-wrap">

<div class="w">

<div class="login-form">

<div class="login-tab login-tab-l">

<a href="javascript:void(0)" clstag="pageclick|keycount|201607144|1"> 扫码登录</a>

</div>

<div class="login-tab login-tab-r">

<a href="javascript:void(0)" clstag="pageclick|keycount|201607144|2">账户登录</a>

</div>

<div class="login-box">

<div class="mt tab-h">

</div>

<div class="msg-wrap">

<div class="msg-error hide"><b></b></div>

</div>

我要找的是<div class="login-tab login-tab-l">

那么应该使用css选择器:

browser.find_element_by_css_selector('div.login-tab.login-tab-r')

python模拟登录vexx.pro 获取你的总资产/币值和其他个人信息

李魔佛 发表了文章 • 0 个评论 • 4742 次浏览 • 2018-01-10 03:22

# -*-coding=utf-8-*-

import requests

session = requests.Session()

user = ''

password = ''

def getCode():

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'}

url = 'http://vexx.pro/verify/code.html'

s = session.get(url=url, headers=headers)

with open('code.png', 'wb') as f:

f.write(s.content)

code = raw_input('input the code: ')

print 'code is ', code

login_url = 'http://vexx.pro/login/up_login.html'

post_data = {

'moble': user,

'mobles': '+86',

'password': password,

'verify': code,

'login_token': ''}

login_s = session.post(url=login_url, headers=header, data=post_data)

print login_s.status_code

zzc_url = 'http://vexx.pro/ajax/check_zzc/'

zzc_s = session.get(url=zzc_url, headers=headers)

print zzc_s.text

def main():

getCode()

if __name__ == '__main__':

main()

把自己的用户名和密码填上去,中途输入一次验证码。

可以把session保存到本地,然后下一次就可以不用再输入密码。

后记: 经过几个月后,这个网站被证实是一个圈钱跑路的网站,目前已经无法正常登陆了。希望大家不要再上当了

原创地址:http://30daydo.com/article/263

转载请注明出处。 查看全部

# -*-coding=utf-8-*-

import requests

session = requests.Session()

user = ''

password = ''

def getCode():

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'}

url = 'http://vexx.pro/verify/code.html'

s = session.get(url=url, headers=headers)

with open('code.png', 'wb') as f:

f.write(s.content)

code = raw_input('input the code: ')

print 'code is ', code

login_url = 'http://vexx.pro/login/up_login.html'

post_data = {

'moble': user,

'mobles': '+86',

'password': password,

'verify': code,

'login_token': ''}

login_s = session.post(url=login_url, headers=header, data=post_data)

print login_s.status_code

zzc_url = 'http://vexx.pro/ajax/check_zzc/'

zzc_s = session.get(url=zzc_url, headers=headers)

print zzc_s.text

def main():

getCode()

if __name__ == '__main__':

main()

把自己的用户名和密码填上去,中途输入一次验证码。

可以把session保存到本地,然后下一次就可以不用再输入密码。

后记: 经过几个月后,这个网站被证实是一个圈钱跑路的网站,目前已经无法正常登陆了。希望大家不要再上当了

原创地址:http://30daydo.com/article/263

转载请注明出处。

[scrapy]修改爬虫默认user agent的多种方法

李魔佛 发表了文章 • 0 个评论 • 11309 次浏览 • 2017-12-14 16:22

3. 目标站点:

https://helloacm.com/api/user-agent/

这一个站点直接返回用户的User-Agent, 这样你就可以直接查看你的User-Agent是否设置成功。

尝试用浏览器打开网址

https://helloacm.com/api/user-agent/,

网站直接返回:

"Mozilla\/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit\/537.36 (KHTML, like Gecko) Chrome\/62.0.3202.94 Safari\/537.36"

3. 配置scrapy

在spider文件夹的headervalidation.py 修改为一下内容。class HeadervalidationSpider(scrapy.Spider):

name = 'headervalidation'

allowed_domains = ['helloacm.com']

start_urls = ['http://helloacm.com/api/user-agent/']

def parse(self, response):

print '*'*20

print response.body

print '*'*20

项目只是打印出response的body,也就是打印出访问的User-Agent信息。

运行:scrapy crawl headervalidation会发现返回的是503。 接下来,我们修改scrapy的User-Agent

方法1:

修改setting.py中的User-Agent# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Hello World'

然后重新运行scrapy crawl headervalidation

这个时候,能够看到正常的scrapy输出了。2017-12-14 16:17:35 [scrapy.extensions.telnet] DEBUG: Telnet console listening on 127.0.0.1:6023

2017-12-14 16:17:35 [scrapy.downloadermiddlewares.redirect] DEBUG: Redirecting (301) to <GET https://helloacm.com/api/us

er-agent/> from <GET http://helloacm.com/api/user-agent/>

2017-12-14 16:17:36 [scrapy.core.engine] DEBUG: Crawled (200) <GET https://helloacm.com/api/user-agent/> (referer: None)

[b]********************

"Hello World"

********************

[/b]2017-12-14 16:17:37 [scrapy.core.engine] INFO: Closing spider (finished)

2017-12-14 16:17:37 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

{'downloader/request_bytes': 406,

'downloader/request_count': 2,

'downloader/request_method_count/GET': 2,

'downloader/response_bytes': 796,

'downloader/response_count': 2,

'downloader/response_status_count/200': 1,

'downloader/response_status_count/301': 1,

'finish_reason': 'finished',

'finish_time': datetime.datetime(2017, 12, 14, 8, 17, 37, 29000),

'log_count/DEBUG': 3,

'log_count/INFO': 7,

'response_received_count': 1,

'scheduler/dequeued': 2,

'scheduler/dequeued/memory': 2,

'scheduler/enqueued': 2,

'scheduler/enqueued/memory': 2,

'start_time': datetime.datetime(2017, 12, 14, 8, 17, 35, 137000)}

2017-12-14 16:17:37 [scrapy.core.engine] INFO: Spider closed (finished)

正确设置了User-Agent

方法2.

修改setting中的

DEFAULT_REQUEST_HEADERS# Override the default request headers:

DEFAULT_REQUEST_HEADERS = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'en',

'User-Agent':'Hello World'

}

运行后也能够看到上面的输出。

方法3.

在代码中修改。class HeadervalidationSpider(scrapy.Spider):

name = 'headervalidation'

allowed_domains = ['helloacm.com']

def start_requests(self):

header={'User-Agent':'Hello World'}

yield scrapy.Request(url='http://helloacm.com/api/user-agent/',headers=header)

def parse(self, response):

print '*'*20

print response.body

print '*'*20

运行后也能够看到下面的输出。2017-12-14 16:17:35 [scrapy.extensions.telnet] DEBUG: Telnet console listening on 127.0.0.1:6023

2017-12-14 16:17:35 [scrapy.downloadermiddlewares.redirect] DEBUG: Redirecting (301) to <GET https://helloacm.com/api/us

er-agent/> from <GET http://helloacm.com/api/user-agent/>

2017-12-14 16:17:36 [scrapy.core.engine] DEBUG: Crawled (200) <GET https://helloacm.com/api/user-agent/> (referer: None)

********************

"Hello World"

********************

2017-12-14 16:17:37 [scrapy.core.engine] INFO: Closing spider (finished)

2017-12-14 16:17:37 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

方法4.

在中间件中自定义Header

在项目目录下添加一个目录:

customerMiddleware,在目录中新建一个自定义的中间件文件:

文件名随意为 customMiddleware.py

文件内容为修改request User-Agent#-*-coding=utf-8-*-

from scrapy.contrib.downloadermiddleware.useragent import UserAgentMiddleware

class CustomerUserAgent(UserAgentMiddleware):

def process_request(self, request, spider):

ua='HELLO World?????????'

request.headers.setdefault('User-Agent',ua)

在setting中添加下面一句,以便使中间件生效。DOWNLOADER_MIDDLEWARES = {

'headerchange.customerMiddleware.customMiddleware.CustomerUserAgent':10

# 'headerchange.middlewares.MyCustomDownloaderMiddleware': 543,

}

然后重新运行,同样能够得到一样的效果。

原创文章,转载请注明:http://30daydo.com/article/245

附上github的源码:https://github.com/Rockyzsu/base_function/tree/master/scrapy_demo/headerchange

欢迎star和点赞。

如果你觉得文章对你有用,可以视乎你心情来打赏,以支持小站的服务器网络费用。

你的支持是我最大的动力!

PS:谢谢下面朋友的打赏

A Keung

阿贾克斯

白驹过隙

Che Long 查看全部

scrapy startproject headerchange2. 创建爬虫文件

scrapy genspider headervalidation helloacm.com

3. 目标站点:

https://helloacm.com/api/user-agent/

这一个站点直接返回用户的User-Agent, 这样你就可以直接查看你的User-Agent是否设置成功。

尝试用浏览器打开网址

https://helloacm.com/api/user-agent/,

网站直接返回:

"Mozilla\/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit\/537.36 (KHTML, like Gecko) Chrome\/62.0.3202.94 Safari\/537.36"

3. 配置scrapy

在spider文件夹的headervalidation.py 修改为一下内容。

class HeadervalidationSpider(scrapy.Spider):

name = 'headervalidation'

allowed_domains = ['helloacm.com']

start_urls = ['http://helloacm.com/api/user-agent/']

def parse(self, response):

print '*'*20

print response.body

print '*'*20

项目只是打印出response的body,也就是打印出访问的User-Agent信息。

运行:

scrapy crawl headervalidation会发现返回的是503。 接下来,我们修改scrapy的User-Agent

方法1:

修改setting.py中的User-Agent

# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Hello World'

然后重新运行

scrapy crawl headervalidation

这个时候,能够看到正常的scrapy输出了。

2017-12-14 16:17:35 [scrapy.extensions.telnet] DEBUG: Telnet console listening on 127.0.0.1:6023

2017-12-14 16:17:35 [scrapy.downloadermiddlewares.redirect] DEBUG: Redirecting (301) to <GET https://helloacm.com/api/us

er-agent/> from <GET http://helloacm.com/api/user-agent/>

2017-12-14 16:17:36 [scrapy.core.engine] DEBUG: Crawled (200) <GET https://helloacm.com/api/user-agent/> (referer: None)

[b]********************

"Hello World"

********************

[/b]2017-12-14 16:17:37 [scrapy.core.engine] INFO: Closing spider (finished)

2017-12-14 16:17:37 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

{'downloader/request_bytes': 406,

'downloader/request_count': 2,

'downloader/request_method_count/GET': 2,

'downloader/response_bytes': 796,

'downloader/response_count': 2,

'downloader/response_status_count/200': 1,

'downloader/response_status_count/301': 1,

'finish_reason': 'finished',

'finish_time': datetime.datetime(2017, 12, 14, 8, 17, 37, 29000),

'log_count/DEBUG': 3,

'log_count/INFO': 7,

'response_received_count': 1,

'scheduler/dequeued': 2,

'scheduler/dequeued/memory': 2,

'scheduler/enqueued': 2,

'scheduler/enqueued/memory': 2,

'start_time': datetime.datetime(2017, 12, 14, 8, 17, 35, 137000)}

2017-12-14 16:17:37 [scrapy.core.engine] INFO: Spider closed (finished)

正确设置了User-Agent

方法2.

修改setting中的

DEFAULT_REQUEST_HEADERS

# Override the default request headers:

DEFAULT_REQUEST_HEADERS = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'en',

'User-Agent':'Hello World'

}

运行后也能够看到上面的输出。

方法3.

在代码中修改。

class HeadervalidationSpider(scrapy.Spider):

name = 'headervalidation'

allowed_domains = ['helloacm.com']

def start_requests(self):

header={'User-Agent':'Hello World'}

yield scrapy.Request(url='http://helloacm.com/api/user-agent/',headers=header)

def parse(self, response):

print '*'*20

print response.body

print '*'*20

运行后也能够看到下面的输出。

2017-12-14 16:17:35 [scrapy.extensions.telnet] DEBUG: Telnet console listening on 127.0.0.1:6023

2017-12-14 16:17:35 [scrapy.downloadermiddlewares.redirect] DEBUG: Redirecting (301) to <GET https://helloacm.com/api/us

er-agent/> from <GET http://helloacm.com/api/user-agent/>

2017-12-14 16:17:36 [scrapy.core.engine] DEBUG: Crawled (200) <GET https://helloacm.com/api/user-agent/> (referer: None)

********************

"Hello World"

********************

2017-12-14 16:17:37 [scrapy.core.engine] INFO: Closing spider (finished)

2017-12-14 16:17:37 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

方法4.

在中间件中自定义Header

在项目目录下添加一个目录:

customerMiddleware,在目录中新建一个自定义的中间件文件:

文件名随意为 customMiddleware.py

文件内容为修改request User-Agent

#-*-coding=utf-8-*-

from scrapy.contrib.downloadermiddleware.useragent import UserAgentMiddleware

class CustomerUserAgent(UserAgentMiddleware):

def process_request(self, request, spider):

ua='HELLO World?????????'

request.headers.setdefault('User-Agent',ua)

在setting中添加下面一句,以便使中间件生效。

DOWNLOADER_MIDDLEWARES = {

'headerchange.customerMiddleware.customMiddleware.CustomerUserAgent':10

# 'headerchange.middlewares.MyCustomDownloaderMiddleware': 543,

}然后重新运行,同样能够得到一样的效果。

原创文章,转载请注明:http://30daydo.com/article/245

附上github的源码:https://github.com/Rockyzsu/base_function/tree/master/scrapy_demo/headerchange

欢迎star和点赞。

如果你觉得文章对你有用,可以视乎你心情来打赏,以支持小站的服务器网络费用。

你的支持是我最大的动力!

PS:谢谢下面朋友的打赏

A Keung

阿贾克斯

白驹过隙

Che Long

儿歌多多 下载全部儿歌视频文件

李魔佛 发表了文章 • 0 个评论 • 20070 次浏览 • 2017-09-28 23:44

http://30daydo.com/article/236

更新 ******** 2018-01-09*************

最近才发现以前曾经挖了这个坑,现在来完成它吧。

儿歌多多在爱奇艺的视频网站上也有全集,所以目标转为抓取iqiyi的儿歌多多视频列表。

github上有一个现成的下载iqiyi的第三方库,可以通过python调用这个库来实现下载功能。

代码使用python3来实现。

1. 打开网页 http://www.iqiyi.com/v_19rrkwcx6w.html#curid=455603300_26b870cbb10342a6b8a90f7f0b225685

这个是第一集的儿歌多多,url后面的curid只是一个随机的字符串,可以直接去掉。

url=“http://www.iqiyi.com/v_19rrkwcx6w.htm”

浏览器直接查看源码,里面直接包含了1-30集的视频url,那么要做的就是提取这30个url

先抓取网页内容:session = requests.Session()

def getContent(url):

try:

ret = session.get(url)

except:

return None

if ret.status_code==200:

return ret.text

else:

return None

然后提取内容中的url

点击查看大图

提取div标签中的属性 data-current-count=1的。然后选择子节点中的li标签,提取li中的a中的href链接即可。 content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

2. 有了url,就可以下载这个页面的中的内容了。

这里我使用的是一个第三方的视频下载库,you-get。(非常好用,fork到自己仓库研究 https://github.com/Rockyzsu/you-get)

使用方法:

python you-get -d --format=HD url

you-get 需要下载一个ffmpeg.exe的文件来解码视频流的,去官网就可以免费下载。

url就是你要下载的url地址,format可以选择高清还是其他格式的,我这里选择的是HD。

在python脚本里面调用另外一个python脚本,可以使用subprocess来调用。 p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

上面的song_url 就是接着最上面那个代码的。

完整代码如下:#-*-coding=utf-8-*-

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = session.get(url)

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

上面的是1-30集的,全部集数现在是120集,31-60的在url

http://www.iqiyi.com/v_19rrl2td7g.html

这个url只要你选择iqiyi视频的右边栏,就会自动变化。 同理也可以找到61-120的url,然后替换到上面代码中最开始的url就可以了。(这里因为页码少,所以就没有用循环去做)

最终的下载结果:

后面修改了下代码,判断文件是不是已经存在,存在的会就不下载,对于长时间下载100多个文件很有用,如果掉线了,重新下载就不会去下载那些已经下好的。#-*-coding=utf-8-*-

import sys,os

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = requests.get(url)

ret.encoding='utf-8'

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

if not content:

print "network issue, retry"

exit(0)

root = etree.HTML(content,parser=etree.HTMLParser(encoding='utf-8'))

elements=root.xpath('//div[@data-current-count="1"]//li')

for items in elements:

url_item=items.xpath('.//a/@href')[0]

song_url = url_item.replace('//','')

song_url=song_url.strip()

print(song_url)

# name=items.xpath('.//span[@class="item-num"]/text()')[0]

name=items.xpath('.//span[@class="item-num"]/text()')[0].encode('utf-8').strip()+\

' '+items.xpath('.//span[@class="item-txt"]/text()')[0].encode('utf-8').strip()+'.mp4'

name= '儿歌多多 '+name

name=name.decode('utf-8')

filename=os.path.join(os.getcwd(),name)

print filename

if os.path.exists(filename):

continue

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

下载下来大概300多集,直接拷贝到平板上离线播放,再也不卡了。

原创地址:http://30daydo.com/article/236

转载请注明出处

查看全部

http://30daydo.com/article/236

更新 ******** 2018-01-09*************

最近才发现以前曾经挖了这个坑,现在来完成它吧。

儿歌多多在爱奇艺的视频网站上也有全集,所以目标转为抓取iqiyi的儿歌多多视频列表。

github上有一个现成的下载iqiyi的第三方库,可以通过python调用这个库来实现下载功能。

代码使用python3来实现。

1. 打开网页 http://www.iqiyi.com/v_19rrkwcx6w.html#curid=455603300_26b870cbb10342a6b8a90f7f0b225685

这个是第一集的儿歌多多,url后面的curid只是一个随机的字符串,可以直接去掉。

url=“http://www.iqiyi.com/v_19rrkwcx6w.htm”

浏览器直接查看源码,里面直接包含了1-30集的视频url,那么要做的就是提取这30个url

先抓取网页内容:

session = requests.Session()

def getContent(url):

try:

ret = session.get(url)

except:

return None

if ret.status_code==200:

return ret.text

else:

return None

然后提取内容中的url

点击查看大图

提取div标签中的属性 data-current-count=1的。然后选择子节点中的li标签,提取li中的a中的href链接即可。

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

2. 有了url,就可以下载这个页面的中的内容了。

这里我使用的是一个第三方的视频下载库,you-get。(非常好用,fork到自己仓库研究 https://github.com/Rockyzsu/you-get)

使用方法:

python you-get -d --format=HD url

you-get 需要下载一个ffmpeg.exe的文件来解码视频流的,去官网就可以免费下载。

url就是你要下载的url地址,format可以选择高清还是其他格式的,我这里选择的是HD。

在python脚本里面调用另外一个python脚本,可以使用subprocess来调用。

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()上面的song_url 就是接着最上面那个代码的。

完整代码如下:

#-*-coding=utf-8-*-

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = session.get(url)

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

上面的是1-30集的,全部集数现在是120集,31-60的在url

http://www.iqiyi.com/v_19rrl2td7g.html

这个url只要你选择iqiyi视频的右边栏,就会自动变化。 同理也可以找到61-120的url,然后替换到上面代码中最开始的url就可以了。(这里因为页码少,所以就没有用循环去做)

最终的下载结果:

后面修改了下代码,判断文件是不是已经存在,存在的会就不下载,对于长时间下载100多个文件很有用,如果掉线了,重新下载就不会去下载那些已经下好的。

#-*-coding=utf-8-*-

import sys,os

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = requests.get(url)

ret.encoding='utf-8'

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

if not content:

print "network issue, retry"

exit(0)

root = etree.HTML(content,parser=etree.HTMLParser(encoding='utf-8'))

elements=root.xpath('//div[@data-current-count="1"]//li')

for items in elements:

url_item=items.xpath('.//a/@href')[0]

song_url = url_item.replace('//','')

song_url=song_url.strip()

print(song_url)

# name=items.xpath('.//span[@class="item-num"]/text()')[0]

name=items.xpath('.//span[@class="item-num"]/text()')[0].encode('utf-8').strip()+\

' '+items.xpath('.//span[@class="item-txt"]/text()')[0].encode('utf-8').strip()+'.mp4'

name= '儿歌多多 '+name

name=name.decode('utf-8')

filename=os.path.join(os.getcwd(),name)

print filename

if os.path.exists(filename):

continue

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

下载下来大概300多集,直接拷贝到平板上离线播放,再也不卡了。

原创地址:http://30daydo.com/article/236

转载请注明出处

批量下载懒人听书mp3文件

李魔佛 发表了文章 • 7 个评论 • 37300 次浏览 • 2017-09-14 01:09

只有安装app后才能下载。

装了app也只能一个一个地去下载,所以索性一次过下载全部的音频吧。

方法很简单,代码很短。 你也可以看得懂。

以财经郎眼的节目音频为例。 其他的节目内容方法差不多的。

浏览器打开页面:

http://www.lrts.me/book/32551

然后按F12打开调试窗口,我用的是chrome

然后看到网页底下有下一页的按钮,点击下一页,看看每一页的url. 就能找到具体的下一页的url.

(待续)

python代码:# coding: utf-8

# http://30daydo.com

import urllib

import os

import requests

import time

from lxml import etree

from header_toolkit import getheader

def spider():

curr=os.getcwd()

target_dir=os.path.join(curr,'data')

if not os.path.exists(target_dir):

os.mkdir(target_dir)

for i in range(1, 100, 10):

url = 'http://www.lrts.me/ajax/playlist/2/32551/%d' % i

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

s = requests.get(url=url, headers=headers)

tree = etree.HTML(s.text)

nodes = tree.xpath('//*[starts-with(@class,"clearfix section-item section")]')

print len(nodes)

for node in nodes:

filename = node.xpath('.//div[@class="column1 nowrap"]/span/text()')[0]

link = node.xpath('.//input[@name="source" and @type="hidden"]/@value')[0]

print link

post_fix=link.split('.')[-1]

full_path= filename+'.'+post_fix

urllib.urlretrieve(link, filename=os.path.join(target_dir,full_path))

time.sleep(1)

if __name__ == '__main__':

spider()

抓取的内容:

原创文章,转载请注明出处:

http://30daydo.com/article/231

需要下载的打包数据可以留下邮箱或者私信。

查看全部

只有安装app后才能下载。

装了app也只能一个一个地去下载,所以索性一次过下载全部的音频吧。

方法很简单,代码很短。 你也可以看得懂。

以财经郎眼的节目音频为例。 其他的节目内容方法差不多的。

浏览器打开页面:

http://www.lrts.me/book/32551

然后按F12打开调试窗口,我用的是chrome

然后看到网页底下有下一页的按钮,点击下一页,看看每一页的url. 就能找到具体的下一页的url.

(待续)

python代码:

# coding: utf-8

# http://30daydo.com

import urllib

import os

import requests

import time

from lxml import etree

from header_toolkit import getheader

def spider():

curr=os.getcwd()

target_dir=os.path.join(curr,'data')

if not os.path.exists(target_dir):

os.mkdir(target_dir)

for i in range(1, 100, 10):

url = 'http://www.lrts.me/ajax/playlist/2/32551/%d' % i

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

s = requests.get(url=url, headers=headers)

tree = etree.HTML(s.text)

nodes = tree.xpath('//*[starts-with(@class,"clearfix section-item section")]')

print len(nodes)

for node in nodes:

filename = node.xpath('.//div[@class="column1 nowrap"]/span/text()')[0]

link = node.xpath('.//input[@name="source" and @type="hidden"]/@value')[0]

print link

post_fix=link.split('.')[-1]

full_path= filename+'.'+post_fix

urllib.urlretrieve(link, filename=os.path.join(target_dir,full_path))

time.sleep(1)

if __name__ == '__main__':

spider()

抓取的内容:

原创文章,转载请注明出处:

http://30daydo.com/article/231

需要下载的打包数据可以留下邮箱或者私信。

怎么判断你用的代理是高度匿名还是透明的

李魔佛 发表了文章 • 0 个评论 • 10502 次浏览 • 2017-09-06 20:42

你用透明代理上QQ,对方还是能看到你的本来的IP

只有用匿名和高匿名才不会被对方看到IP.

详细的说:

匿名代理:

如果从隐藏使用代理用户的级别上划分,代理可以分为三种,即高度匿名代理、普通匿名代理和透明代理。

(1)高度匿名代理不改变客户机的请求,这样在服务器看来就像有个真正的客户浏览器在访问它,这时客户的真实IP是隐藏的,服务器端不会认为我们使用了代理。

(2)普通匿名代理能隐藏客户机的真实IP,但会改变我们的请求信息,服务器端有可能会认为我们使用了代理。不过使用此种代理时,虽然被访问的网站不能知道你的ip地址,但仍然可以知道你在使用代理,当然某些能够侦测ip的网页仍然可以查到你的ip。

(3)透明代理,它不但改变了我们的请求信息,还会传送真实的IP地址。

三者隐藏使用代理者身份的级别依次为高度匿名代理最隐蔽,其次是普通匿名代理,最差的是透明代理。

把你找到的代理iP,在你的浏览器里设置一下, 具体可以百度谷歌, 不难.

然后用浏览器打开这个网站:

http://members.3322.org/dyndns/getip

网站返回很简单, 就是你当前的iP地址. 据目前使用那么多的检测iP地址的网站来看,这个网站最准.

用代理打开这个网站,如果网站显示的是你代理IP,那么说明你的ip是高度匿名的.

如果网站显示的是有2个ip,那么你的代理是透明的, 第一个ip是你的原始ip,而第二个ip是你用的代理ip.

查看全部

你用透明代理上QQ,对方还是能看到你的本来的IP

只有用匿名和高匿名才不会被对方看到IP.

详细的说:

匿名代理:

如果从隐藏使用代理用户的级别上划分,代理可以分为三种,即高度匿名代理、普通匿名代理和透明代理。

(1)高度匿名代理不改变客户机的请求,这样在服务器看来就像有个真正的客户浏览器在访问它,这时客户的真实IP是隐藏的,服务器端不会认为我们使用了代理。

(2)普通匿名代理能隐藏客户机的真实IP,但会改变我们的请求信息,服务器端有可能会认为我们使用了代理。不过使用此种代理时,虽然被访问的网站不能知道你的ip地址,但仍然可以知道你在使用代理,当然某些能够侦测ip的网页仍然可以查到你的ip。

(3)透明代理,它不但改变了我们的请求信息,还会传送真实的IP地址。

三者隐藏使用代理者身份的级别依次为高度匿名代理最隐蔽,其次是普通匿名代理,最差的是透明代理。

把你找到的代理iP,在你的浏览器里设置一下, 具体可以百度谷歌, 不难.

然后用浏览器打开这个网站:

http://members.3322.org/dyndns/getip

网站返回很简单, 就是你当前的iP地址. 据目前使用那么多的检测iP地址的网站来看,这个网站最准.

用代理打开这个网站,如果网站显示的是你代理IP,那么说明你的ip是高度匿名的.

如果网站显示的是有2个ip,那么你的代理是透明的, 第一个ip是你的原始ip,而第二个ip是你用的代理ip.

lxml.etree._ElementUnicodeResult 转为字符

李魔佛 发表了文章 • 0 个评论 • 22885 次浏览 • 2017-08-14 15:57

address=each.xpath('.//address/text()')[0].strip()

结果用address与一般的字符进行拼接时,总是出现

UnicodeDecodeError: 'ascii' codec can't decode byte 0xe4 in position 0: ordinal not in range(128)

这种错误。

主要因为python2的蛋疼的编码原因。

解决办法:

根据lxml的官方文档:http://lxml.de/api/lxml.etree._ElementUnicodeResult-class.html

object --+ | basestring --+ | unicode --+ | _ElementUnicodeResult

_ElementUnicodeResult 是unicode的一个子类。

那么可以直接将它转为unicode

address.encode('utf-8') 就可以了。

查看全部

address=each.xpath('.//address/text()')[0].strip()

结果用address与一般的字符进行拼接时,总是出现

UnicodeDecodeError: 'ascii' codec can't decode byte 0xe4 in position 0: ordinal not in range(128)

这种错误。

主要因为python2的蛋疼的编码原因。

解决办法:

根据lxml的官方文档:http://lxml.de/api/lxml.etree._ElementUnicodeResult-class.html

object --+ | basestring --+ | unicode --+ | _ElementUnicodeResult

_ElementUnicodeResult 是unicode的一个子类。

那么可以直接将它转为unicode

address.encode('utf-8') 就可以了。

爬虫获取CSDN用户的排名

李魔佛 发表了文章 • 5 个评论 • 4842 次浏览 • 2017-05-17 12:40

这个是很简单的一个爬虫脚本。 我设置成每周运行一次,这样就可以监测自己的账号每周的排名情况。 还可以绘制成曲线图标,很直观的可以看出每周的排名变化:

具体的python代码如下:#Get your range of csdn

'''

http://30daydo.com

contact: weigesysu@qq.com

'''

import urllib2,re

import time

link='http://blog.csdn.net/[b]用户名[/b]/article/details/52858314'

user_agent = "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0)"

header = {"User-Agent": user_agent}

req = urllib2.Request(link, headers=header)

resp = urllib2.urlopen(req)

content = resp.read()

#print content

p=re.compile(r'<li>排名:<span>第(\d+)名</span></li>')

result=p.findall(content)

print result[0]

today=time.strftime("%Y-%m-%d")

print today

f=open("data/csdn_range.txt",'a')

contents=today+'\t'+result[0]+'\n'

f.write(contents)

f.close()

只要把代码中的用户名改成你的csdn的用户名就可以了。

然后在linux或者windows设置每周一心一次,程序自动记录到csdn.txt这个文件里头。 查看全部

这个是很简单的一个爬虫脚本。 我设置成每周运行一次,这样就可以监测自己的账号每周的排名情况。 还可以绘制成曲线图标,很直观的可以看出每周的排名变化:

具体的python代码如下:

#Get your range of csdn

'''

http://30daydo.com

contact: weigesysu@qq.com

'''

import urllib2,re

import time

link='http://blog.csdn.net/[b]用户名[/b]/article/details/52858314'

user_agent = "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0)"

header = {"User-Agent": user_agent}

req = urllib2.Request(link, headers=header)

resp = urllib2.urlopen(req)

content = resp.read()

#print content

p=re.compile(r'<li>排名:<span>第(\d+)名</span></li>')

result=p.findall(content)

print result[0]

today=time.strftime("%Y-%m-%d")

print today

f=open("data/csdn_range.txt",'a')

contents=today+'\t'+result[0]+'\n'

f.write(contents)

f.close()

只要把代码中的用户名改成你的csdn的用户名就可以了。

然后在linux或者windows设置每周一心一次,程序自动记录到csdn.txt这个文件里头。

requests 使用默认 cookies

李魔佛 发表了文章 • 0 个评论 • 7038 次浏览 • 2017-03-17 01:41

使用requests库的时候,可以初始化一次cookies信息,后面的回话就能够一直用这个cookies了。session=requests.session()

#先创建一个seession

s=session.get('http://xueqiu.com',headers=self.headers)

#随意建立一个访问雪球的session,此时的session就自带了雪球的cookies

url='https://xueqiu.com/snowmart/push/stocks.json?product_id=19&page=3&count=5'

headers['Referer']='https://xueqiu.com/strategy/19'

headers['X-Requested-With']='XMLHttpRequest'

headers['DNT']='1'

data={'product_id':19,'page':3,'count':5}

resp=session.get(url,headers=self.headers,params=data).text

#如果这里用的request.get的话,就不能获取到网页返回的正确内容

print resp 这里需要注意的是,第一次

s=session.get('http://xueqiu.com',headers=self.headers) #随意建立一个访问雪球的session,此时的session就自带了雪球的cookies

是必须的,如果没有只一次正常访问,cookies就不能保存下来供下一次正常使用。

2017-3-28 更新

一般来说,除非是为了每天定期跑的或者破解他人密码这些,可以不用管他们的登录问题,可以很直接的在浏览器中,把你自己账号的cookie信息写进到request的header里面,完全可以访问。

所以一旦cookie被别人获取了,他们就可以构造数据,去获取你账号的相关信息。 (cookie应该和你的电脑硬件没关系的吧? 因为我曾经在几台机器上用同一个cookie获取我登录了的账号,也是没有问题的)

举个栗子:

def csdn():

session=requests.session()

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.82 Safari/537.36'}

url='[url]http://msg.csdn.net/'[/url] header['Cookie']='uuid_tt_dd=-5697318013068753627_20160111; _ga=GA1.2.795042232.1452766190; _message_m=quvq2wle24wa4awe UserInfo=zMhiNgesgIlEBQ3TOqLCtx4nUI360IIq3ciBzg4EKH%2FW8mSpTANpu5cTlRFLj2Tqh%2FZzQr2rNqDtT1SZz%2Be2%2FpDkGoQxDK3IVUZXvwZ%2FEP1I4UTg6MoZkH7LDO3sjrJJ; UserNick=%E9%87%8D%E5%A4%8D%E7%9A%84%E7%94%9F%E6%B4%BB; AU=0F1; UD=%E8%AE%B0%E5%BD%95%E8%87%AA%E5%AD%A6%E7%9A%84%E5%8E%86%E7%A8%8B+%E5%88%83%E8%8D%; BT=1490707396344; access-token=c2e12bff-5b27-4a91-953b-448ff6f6beac; _csdn_notify_admin_session=VE41a0d3TitrVGY2bGtXY09pZENwR1lHenhUU1NVaWc1b04wL1I3dCtDQVdadWpjMXBzdGRJL0RZR04wYldvZDBhTU96b2oycVVKeVI1UEVyUHFKbG1yNnB2b2pHRWVnWG1uc2JMM2R3YWthakRyTXZNaEpVU1NtUy9zQUJrNjd3R2lpbG5PK0paMnlyc1dyK0lTZUtRPT0tLXlPQUE1QzF5UmhDNjEvSFdtRFlQS2c9PQ%3D%3D--4569c5a32916dcf969a8b7e007c37abeb90be4f3; dc_tos=onj1dg; dc_session_id=1490707393375; Hm_lvt_6bcd52f51e9b3dce32bec4a3997715ac=1490024083,1490024559,1490374375,1490707368; Hm_lpvt_6bcd52f51e9b3dce32bec4a3997715ac=1490707638' header['Cache-Control']='max-age=0'

header['Host']='msg.csdn.net'

header['Referer']='http://blog.csdn.net/username'

resp=requests.get(url,headers=header)

print resp.text

上面这段代码,只要你改一下cookie和 Refer 的连接,改成你自己的用户名。 你就可以访问你的csdn的消息,也就是别人在你的csdn博客访问的的留言,评论。

只是这个cookie只能在某个时间段生效,也就是存活期大概就一个星期左右。

抓包技术过硬,何须模拟登陆?

http://30daydo.com/publish/article/155

查看全部

使用requests库的时候,可以初始化一次cookies信息,后面的回话就能够一直用这个cookies了。

session=requests.session()这里需要注意的是,第一次

#先创建一个seession

s=session.get('http://xueqiu.com',headers=self.headers)

#随意建立一个访问雪球的session,此时的session就自带了雪球的cookies

url='https://xueqiu.com/snowmart/push/stocks.json?product_id=19&page=3&count=5'

headers['Referer']='https://xueqiu.com/strategy/19'

headers['X-Requested-With']='XMLHttpRequest'

headers['DNT']='1'

data={'product_id':19,'page':3,'count':5}

resp=session.get(url,headers=self.headers,params=data).text

#如果这里用的request.get的话,就不能获取到网页返回的正确内容

print resp

s=session.get('http://xueqiu.com',headers=self.headers) #随意建立一个访问雪球的session,此时的session就自带了雪球的cookies

是必须的,如果没有只一次正常访问,cookies就不能保存下来供下一次正常使用。

2017-3-28 更新

一般来说,除非是为了每天定期跑的或者破解他人密码这些,可以不用管他们的登录问题,可以很直接的在浏览器中,把你自己账号的cookie信息写进到request的header里面,完全可以访问。

所以一旦cookie被别人获取了,他们就可以构造数据,去获取你账号的相关信息。 (cookie应该和你的电脑硬件没关系的吧? 因为我曾经在几台机器上用同一个cookie获取我登录了的账号,也是没有问题的)

举个栗子:

def csdn():

session=requests.session()

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.82 Safari/537.36'}

url='[url]http://msg.csdn.net/'[/url]header['Cookie']='uuid_tt_dd=-5697318013068753627_20160111; _ga=GA1.2.795042232.1452766190; _message_m=quvq2wle24wa4awe UserInfo=zMhiNgesgIlEBQ3TOqLCtx4nUI360IIq3ciBzg4EKH%2FW8mSpTANpu5cTlRFLj2Tqh%2FZzQr2rNqDtT1SZz%2Be2%2FpDkGoQxDK3IVUZXvwZ%2FEP1I4UTg6MoZkH7LDO3sjrJJ; UserNick=%E9%87%8D%E5%A4%8D%E7%9A%84%E7%94%9F%E6%B4%BB; AU=0F1; UD=%E8%AE%B0%E5%BD%95%E8%87%AA%E5%AD%A6%E7%9A%84%E5%8E%86%E7%A8%8B+%E5%88%83%E8%8D%; BT=1490707396344; access-token=c2e12bff-5b27-4a91-953b-448ff6f6beac; _csdn_notify_admin_session=VE41a0d3TitrVGY2bGtXY09pZENwR1lHenhUU1NVaWc1b04wL1I3dCtDQVdadWpjMXBzdGRJL0RZR04wYldvZDBhTU96b2oycVVKeVI1UEVyUHFKbG1yNnB2b2pHRWVnWG1uc2JMM2R3YWthakRyTXZNaEpVU1NtUy9zQUJrNjd3R2lpbG5PK0paMnlyc1dyK0lTZUtRPT0tLXlPQUE1QzF5UmhDNjEvSFdtRFlQS2c9PQ%3D%3D--4569c5a32916dcf969a8b7e007c37abeb90be4f3; dc_tos=onj1dg; dc_session_id=1490707393375; Hm_lvt_6bcd52f51e9b3dce32bec4a3997715ac=1490024083,1490024559,1490374375,1490707368; Hm_lpvt_6bcd52f51e9b3dce32bec4a3997715ac=1490707638'header['Cache-Control']='max-age=0'

header['Host']='msg.csdn.net'

header['Referer']='http://blog.csdn.net/username'

resp=requests.get(url,headers=header)

print resp.text

上面这段代码,只要你改一下cookie和 Refer 的连接,改成你自己的用户名。 你就可以访问你的csdn的消息,也就是别人在你的csdn博客访问的的留言,评论。

只是这个cookie只能在某个时间段生效,也就是存活期大概就一个星期左右。

抓包技术过硬,何须模拟登陆?

http://30daydo.com/publish/article/155

python 爬虫 urllib/requests 中文乱码 终极解决

李魔佛 发表了文章 • 0 个评论 • 7520 次浏览 • 2017-03-11 16:17

content.encoding='gbk'

print content.text 一般情况 是直接可以content.text 就可以输出网页的内容,不过如果网页的编码不是utf-8的话,需要手动编码

content.encoding='gbk'

这样content.text就可以正常显示中文。

查看全部

content=requests.get(url,headers=self.header)一般情况 是直接可以content.text 就可以输出网页的内容,不过如果网页的编码不是utf-8的话,需要手动编码

content.encoding='gbk'

print content.text

content.encoding='gbk'

这样content.text就可以正常显示中文。

自动抢雪球红包 python代码

李魔佛 发表了文章 • 0 个评论 • 17825 次浏览 • 2017-01-25 12:29

Link https://github.com/Rockyzsu/red_bag

每天自动获取深圳上海北京的新房二手房的成交量

李魔佛 发表了文章 • 2 个评论 • 18973 次浏览 • 2016-10-10 14:28

每天自动获取深圳上海北京的新房二手房的成交量

深圳市房地产信息系统:http://ris.szpl.gov.cn/

#-*-coding=utf-8-*-

__author__ = 'rocky'

#获取每天深圳一手房,二手房的成交套数与面积,并且写入数据库

#主要就是正则表达抓取几个数字

import urllib2,re

import database

def getContent():

url="http://ris.szpl.gov.cn/"

one_hand="credit/showcjgs/ysfcjgs.aspx"

second_hand="credit/showcjgs/esfcjgs.aspx"

req=urllib2.Request(url+one_hand)

content=urllib2.urlopen(req).read()

#返回的就是网页的源码,没有做任何防爬虫的处理,zf网站,呵呵

#print content

date=re.compile(r'<SPAN class=titleblue><span id=\"lblCurTime5\">(.*)</span>')

reg=re.compile(r'<td width="14%"><b>(\d+)</b>')

result=reg.findall(content)

current_date=date.findall(content)

reg2=re.compile(r'<td align="right"><b>(.*?)</b>')

yishou_area=reg2.findall(content)

print current_date[0]

print '一手商品房成交套数:%s' % result[0]

print '一手商品房成交面积: %s' % yishou_area[0]

sec_req=urllib2.Request(url+second_hand)

sec_content=urllib2.urlopen(sec_req).read()

sec_quantity=re.compile(r'<td width="30%">(\d+)</td>')

sec_result=sec_quantity.findall(sec_content)

second_area=re.findall(r'<td align="right">(.*?)</td>',sec_content)

print '二手商品房成交套数:%s' % sec_result[1]

print '二手商品房成交面积: %s' % second_area[2]

database.create_table()

database.insert(current_date[0],result[0],yishou_area[0],sec_result[1],second_area[2])

getContent()

github代码:https://github.com/Rockyzsu/house

查看全部

每天自动获取深圳上海北京的新房二手房的成交量

深圳市房地产信息系统:http://ris.szpl.gov.cn/

#-*-coding=utf-8-*-

__author__ = 'rocky'

#获取每天深圳一手房,二手房的成交套数与面积,并且写入数据库

#主要就是正则表达抓取几个数字

import urllib2,re

import database

def getContent():

url="http://ris.szpl.gov.cn/"

one_hand="credit/showcjgs/ysfcjgs.aspx"

second_hand="credit/showcjgs/esfcjgs.aspx"

req=urllib2.Request(url+one_hand)

content=urllib2.urlopen(req).read()

#返回的就是网页的源码,没有做任何防爬虫的处理,zf网站,呵呵

#print content

date=re.compile(r'<SPAN class=titleblue><span id=\"lblCurTime5\">(.*)</span>')

reg=re.compile(r'<td width="14%"><b>(\d+)</b>')

result=reg.findall(content)

current_date=date.findall(content)

reg2=re.compile(r'<td align="right"><b>(.*?)</b>')

yishou_area=reg2.findall(content)

print current_date[0]

print '一手商品房成交套数:%s' % result[0]

print '一手商品房成交面积: %s' % yishou_area[0]

sec_req=urllib2.Request(url+second_hand)

sec_content=urllib2.urlopen(sec_req).read()

sec_quantity=re.compile(r'<td width="30%">(\d+)</td>')

sec_result=sec_quantity.findall(sec_content)

second_area=re.findall(r'<td align="right">(.*?)</td>',sec_content)

print '二手商品房成交套数:%s' % sec_result[1]

print '二手商品房成交面积: %s' % second_area[2]

database.create_table()

database.insert(current_date[0],result[0],yishou_area[0],sec_result[1],second_area[2])

getContent()

github代码:https://github.com/Rockyzsu/house

python 爬虫获取XiciDaili代理IP

李魔佛 发表了文章 • 20 个评论 • 23987 次浏览 • 2016-08-11 23:17

class getProxy():

def __init__(self):

self.user_agent = "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0)"

self.header = {"User-Agent": self.user_agent}

self.dbname="proxy.db"

self.now = time.strftime("%Y-%m-%d")

def getContent(self, num):

nn_url = "http://www.xicidaili.com/nn/" + str(num)

#国内高匿

req = urllib2.Request(nn_url, headers=self.header)

resp = urllib2.urlopen(req, timeout=10)

content = resp.read()

et = etree.HTML(content)

result_even = et.xpath('//tr[@class=""]')

result_odd = et.xpath('//tr[@class="odd"]')

#因为网页源码中class 分开了奇偶两个class,所以使用lxml最方便的方式就是分开获取。

#刚开始我使用一个方式获取,因而出现很多不对称的情况,估计是网站会经常修改源码,怕被其他爬虫的抓到

#使用上面的方法可以不管网页怎么改,都可以抓到ip 和port

for i in result_even:

t1 = i.xpath("./td/text()")[:2]

print "IP:%s\tPort:%s" % (t1[0], t1[1])

if self.isAlive(t1[0], t1[1]):

self.insert_db(self.now,t1[0],t1[1])

for i in result_odd:

t2 = i.xpath("./td/text()")[:2]

print "IP:%s\tPort:%s" % (t2[0], t2[1])

if self.isAlive(t2[0], t2[1]):

self.insert_db(self.now,t2[0],t2[1])

接着实现写插入数据库函数:def insert_db(self,date,ip,port):

dbname=self.dbname

try:

conn=sqlite3.connect(dbname)

except:

print "Error to open database%" %self.dbname

create_tb='''

CREATE TABLE IF NOT EXISTS PROXY

(DATE TEXT,

IP TEXT,

PORT TEXT

);

'''

conn.execute(create_tb)

insert_db_cmd='''

INSERT INTO PROXY (DATE,IP,PORT) VALUES ('%s','%s','%s');

''' %(date,ip,port) #写入时间,ip和端口

conn.execute(insert_db_cmd)

conn.commit() #记得commit

conn.close()

接着完成判断代理是否有效 #查看爬到的代理IP是否还能用

def isAlive(self,ip,port):

proxy={'http':ip+':'+port}

print proxy

#使用这个方式是全局方法。

proxy_support=urllib2.ProxyHandler(proxy)

opener=urllib2.build_opener(proxy_support)

urllib2.install_opener(opener)

#使用代理访问腾讯官网,进行验证代理是否有效

test_url="http://www.qq.com"

req=urllib2.Request(test_url,headers=self.header)

try:

#timeout 设置为10,如果你不能忍受你的代理延时超过10,就修改timeout的数字

resp=urllib2.urlopen(req,timeout=10)

if resp.code==200:

print "work"

return True

else:

print "not work"

return False

except :

print "Not work"

return False

获取前面多少也的代理IP,用一个循环即可: def loop(self,page):

for i in range(1,page):

self.getContent(i)

更新2016-08-13

接着实现对已有的数据库进行清洗,失效的代理要移除。 待续。。。

调用类实例:设置爬取前面5页的代理ipif __name__ == "__main__":

now = datetime.datetime.now()

print "Start at %s" % now

obj=getProxy()

obj.loop(5)

获取最新source code,可以到

https://github.com/Rockyzsu/getProxy

sync up 查看全部

class getProxy():

def __init__(self):

self.user_agent = "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0)"

self.header = {"User-Agent": self.user_agent}

self.dbname="proxy.db"

self.now = time.strftime("%Y-%m-%d")

def getContent(self, num):

nn_url = "http://www.xicidaili.com/nn/" + str(num)

#国内高匿

req = urllib2.Request(nn_url, headers=self.header)

resp = urllib2.urlopen(req, timeout=10)

content = resp.read()

et = etree.HTML(content)

result_even = et.xpath('//tr[@class=""]')

result_odd = et.xpath('//tr[@class="odd"]')

#因为网页源码中class 分开了奇偶两个class,所以使用lxml最方便的方式就是分开获取。

#刚开始我使用一个方式获取,因而出现很多不对称的情况,估计是网站会经常修改源码,怕被其他爬虫的抓到

#使用上面的方法可以不管网页怎么改,都可以抓到ip 和port

for i in result_even:

t1 = i.xpath("./td/text()")[:2]

print "IP:%s\tPort:%s" % (t1[0], t1[1])

if self.isAlive(t1[0], t1[1]):

self.insert_db(self.now,t1[0],t1[1])

for i in result_odd:

t2 = i.xpath("./td/text()")[:2]

print "IP:%s\tPort:%s" % (t2[0], t2[1])