通知设置 新通知

pyecharts绘图保存为图片 适用于ssh无头浏览器运行

python • 李魔佛 发表了文章 • 0 个评论 • 2485 次浏览 • 2020-11-04 22:27

make_snapshot(snapshot, bar.render(), f"data/{today}_cb.png", driver=driver)

在最后一行传入一个driver既可以了,这个driver使用phantomjs的实例。

import os

from pyecharts.render import make_snapshot

from snapshot_selenium import snapshot

import pandas as pd

from pyecharts import options as opts

from pyecharts.charts import Bar

import sys

from selenium import webdriver

from pyecharts.commons.utils import JsCode

if sys.platform == 'win32':

SELENIUM_PATH = r'C:\OneDrive\Tool\phantomjs-2.1.1-windows\phantomjs-2.1.1-windows\bin\phantomjs.exe'

driver = None

else:

SELENIUM_PATH = './phantomjs'

driver = webdriver.PhantomJS(executable_path=SELENIUM_PATH)

bar = (

Bar()

.add_xaxis(list(result_dict .keys()))

.add_yaxis(f"{today}-可转债价格分布", y_list, category_gap=3)

.add_yaxis(f"{today}-正股价格分布", y_zg_list, category_gap=3)

.set_series_opts(

label_opts=opts.LabelOpts(is_show=True),

axispointer_opts=opts.AxisPointerOpts(is_show=True))

.set_global_opts(

title_opts=opts.TitleOpts(title="可转债价格分布"),

xaxis_opts=opts.AxisOpts(

name="涨跌幅",

is_show=True,

name_rotate=30,

),

graphic_opts=[

opts.GraphicGroup(

graphic_item=opts.GraphicItem(

left="70%",

top="20%",

),

children=[

opts.GraphicText(

graphic_item=opts.GraphicItem(

left="center",

top="middle",

z=100,

),

graphic_textstyle_opts=opts.GraphicTextStyleOpts(

text=JsCode(

f"['涨幅>=0:{bigger}',"

f"'涨幅<0:{smaller}',"

f"'平均涨幅:{avg}%',"

f"'波动方差:{std}',"

f"'',"

f"'最大:{max_name} {max_pct}%',"

f"'最小:{min_name} {min_pct}%',"

"''].join('\\n')"

),

font="14px Microsoft YaHei",

graphic_basicstyle_opts=opts.GraphicBasicStyleOpts(

fill="#333"

)

)

)

]

)

],

)

)

bar.render(os.path.join('data', f"{today}_cb.html"))

make_snapshot(snapshot, bar.render(), f"data/{today}_cb.png", driver=driver)

查看全部

make_snapshot(snapshot, bar.render(), f"data/{today}_cb.png", driver=driver)

在最后一行传入一个driver既可以了,这个driver使用phantomjs的实例。

import os

from pyecharts.render import make_snapshot

from snapshot_selenium import snapshot

import pandas as pd

from pyecharts import options as opts

from pyecharts.charts import Bar

import sys

from selenium import webdriver

from pyecharts.commons.utils import JsCode

if sys.platform == 'win32':

SELENIUM_PATH = r'C:\OneDrive\Tool\phantomjs-2.1.1-windows\phantomjs-2.1.1-windows\bin\phantomjs.exe'

driver = None

else:

SELENIUM_PATH = './phantomjs'

driver = webdriver.PhantomJS(executable_path=SELENIUM_PATH)

bar = (

Bar()

.add_xaxis(list(result_dict .keys()))

.add_yaxis(f"{today}-可转债价格分布", y_list, category_gap=3)

.add_yaxis(f"{today}-正股价格分布", y_zg_list, category_gap=3)

.set_series_opts(

label_opts=opts.LabelOpts(is_show=True),

axispointer_opts=opts.AxisPointerOpts(is_show=True))

.set_global_opts(

title_opts=opts.TitleOpts(title="可转债价格分布"),

xaxis_opts=opts.AxisOpts(

name="涨跌幅",

is_show=True,

name_rotate=30,

),

graphic_opts=[

opts.GraphicGroup(

graphic_item=opts.GraphicItem(

left="70%",

top="20%",

),

children=[

opts.GraphicText(

graphic_item=opts.GraphicItem(

left="center",

top="middle",

z=100,

),

graphic_textstyle_opts=opts.GraphicTextStyleOpts(

text=JsCode(

f"['涨幅>=0:{bigger}',"

f"'涨幅<0:{smaller}',"

f"'平均涨幅:{avg}%',"

f"'波动方差:{std}',"

f"'',"

f"'最大:{max_name} {max_pct}%',"

f"'最小:{min_name} {min_pct}%',"

"''].join('\\n')"

),

font="14px Microsoft YaHei",

graphic_basicstyle_opts=opts.GraphicBasicStyleOpts(

fill="#333"

)

)

)

]

)

],

)

)

bar.render(os.path.join('data', f"{today}_cb.html"))

make_snapshot(snapshot, bar.render(), f"data/{today}_cb.png", driver=driver)

使用sshtunnel SSHTunnelForwarder 作为跳板连接mysql后一直卡住不退出

python • 李魔佛 发表了文章 • 0 个评论 • 5356 次浏览 • 2020-11-04 10:10

ssh_address_or_host=host,

ssh_port=port,

ssh_username=user,

ssh_password=password,

local_bind_address=('127.0.0.1', local_port),

remote_bind_address=(host, mysql_port)

)

server.start()

conn = pymysql.connect(

host='127.0.0.1',

port=local_port,

user=user,

password=password,

db='db_stock'

)

cursor = conn.cursor()

cursor.execute('select count(*) from tb_cb_index')

ret = cursor.fetchall()

print(ret)

server.stop()

print('stop')

代码运行后并没有结束,或者没有答应stop的字符。 在程序里已经使用了server.stop()关闭ssh的连接。

后面发现日志里面,mysql的连接没有断开,导致server没有被关闭,所以在上面的代码中加一句:

print(ret)

conn.close()

server.stop()

print('stop')

把mysql的连接关闭,然后就可以把ssh的连接关闭,然后打印stop字符了。

查看全部

server = SSHTunnelForwarder(代码运行后并没有结束,或者没有答应stop的字符。 在程序里已经使用了server.stop()关闭ssh的连接。

ssh_address_or_host=host,

ssh_port=port,

ssh_username=user,

ssh_password=password,

local_bind_address=('127.0.0.1', local_port),

remote_bind_address=(host, mysql_port)

)

server.start()

conn = pymysql.connect(

host='127.0.0.1',

port=local_port,

user=user,

password=password,

db='db_stock'

)

cursor = conn.cursor()

cursor.execute('select count(*) from tb_cb_index')

ret = cursor.fetchall()

print(ret)

server.stop()

print('stop')

后面发现日志里面,mysql的连接没有断开,导致server没有被关闭,所以在上面的代码中加一句:

print(ret)

conn.close()

server.stop()

print('stop')

把mysql的连接关闭,然后就可以把ssh的连接关闭,然后打印stop字符了。

pyecharts感觉这个库的设计有点业余,太过于反python了

python • 李魔佛 发表了文章 • 0 个评论 • 2064 次浏览 • 2020-11-03 01:09

一些扩展的类型int64作为数据导入到绘图函数中,居然不兼容,而且也不报错。

经过逐个参数的排查,才发现是数据类型的问题。 数据是直接在pandas里面抽取出来的,然后填充到绘图汇总,然后就显示一片空白,还一直以为是我哪个参数用错了。

也许是从前端设计者手里接过来的项目吧。按葫芦画瓢这样操作。

一个函数里面居然可以放置几十个,上百个参数,我滴神呀,而且参数里面还有其他类型的参数,尼玛!

当然最让人头疼是那往上不兼容的做法,现在的新版本完全已经修改了,不兼容旧版本,之前的写代码又是一通修改。 查看全部

一些扩展的类型int64作为数据导入到绘图函数中,居然不兼容,而且也不报错。

经过逐个参数的排查,才发现是数据类型的问题。 数据是直接在pandas里面抽取出来的,然后填充到绘图汇总,然后就显示一片空白,还一直以为是我哪个参数用错了。

也许是从前端设计者手里接过来的项目吧。按葫芦画瓢这样操作。

一个函数里面居然可以放置几十个,上百个参数,我滴神呀,而且参数里面还有其他类型的参数,尼玛!

当然最让人头疼是那往上不兼容的做法,现在的新版本完全已经修改了,不兼容旧版本,之前的写代码又是一通修改。

免费代理ip与收费的代理ip

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 2685 次浏览 • 2020-10-30 18:00

曾经有尝试过使用免费的代理ip来搭建代理池,可是免费的代理ip不仅资源少,而且可用率、高匿性、速度等都极差,每次使用都需要借助第三方软件进行检查是否可用,严重影响效率,根本满足不了任务的需求。

收费的代理ip与免费的代理ip差距非常大,不仅拥有海量的ip资源,可用率、高匿性、速度都是极好。操作简单工作效率既然提高上去了。经过多家的测试,最终选择了性价比最高的万变ip。高质量的优质代理ip才可以真正用来防止爬虫被封锁,如果使用普通代理,爬虫的真实IP还是会暴露。新获取一批新IP 查看全部

曾经有尝试过使用免费的代理ip来搭建代理池,可是免费的代理ip不仅资源少,而且可用率、高匿性、速度等都极差,每次使用都需要借助第三方软件进行检查是否可用,严重影响效率,根本满足不了任务的需求。

收费的代理ip与免费的代理ip差距非常大,不仅拥有海量的ip资源,可用率、高匿性、速度都是极好。操作简单工作效率既然提高上去了。经过多家的测试,最终选择了性价比最高的万变ip。高质量的优质代理ip才可以真正用来防止爬虫被封锁,如果使用普通代理,爬虫的真实IP还是会暴露。新获取一批新IP

autojs基础教程 入门篇

Android • 李魔佛 发表了文章 • 0 个评论 • 9268 次浏览 • 2020-10-30 11:09

像下面笔者自己封装的一个模块:

function Helper(packageName) {

this.packageName = packageName;

if (packageName && !getAppName(packageName)) {

toast("找不到此应用, 无法提供服务");

this.sleep(1000);

exit();

}

this.click = function (x, y) {

return click(x, y);

};

this.clickCenter = function (widget) {

if (!widget) {

toast('找不到控件');

return false;

}

let rect = widget.bounds();

return click(rect.centerX(), rect.centerY());

};

this.clickSelectorCenter = function (selector) {

if (!selector) {

toast('找不到控件');

return false;

}

let widget = selector.findOne(2000);

return this.clickCenter(widget);

};

this.clickMulti = function (points, interval) {

points.forEach(function (point) {

this.click(point[0], point[1]);

this.sleep(interval);

}.bind(this));

};

this.clickMultiCenter = function (widgets) {

if (!widgets || widgets.length == 0)

return;

var points = ;

widgets.forEach(function (widget) {

var rect = widget.bounds();

points.push([rect.centerX(), rect.centerY()]);

});

this.clickMulti(points);

};

this.clickIdCenter = function (idStr) {

if (!idStr) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(id(idStr));

};

this.clickTextCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(text(str));

};

this.clickRegTextCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(textMatches(str));

};

this.clickDescCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(desc(str));

};

this.clickRegDescCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(descMatches(str));

};

this.clickClassCenter = function (classNameStr) {

if (!className) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(className(classNameStr));

};

// index表示第几个文字, 从1开始

this.clickNTextCenter = function (str, index) {

if (!str)

return false;

let widgets = text(str).find();

if (!widgets)

return false;

index--

for (let i = 0; i < widgets.length; i++) {

let widget = widgets[i];

if (i == index)

return this.clickCenter(widget);

else

continue;

}

return false;

};

this.pageUp = (counter, time) => {

if (counter && time) {

for (let i = 0; i < counter; i++) {

scrollUp();

this.sleep(time);

}

} else {

scrollUp();

}

};

this.pageDown = (counter, time) => {

if (counter && time) {

for (let i = 0; i < counter; i++) {

scrollDown();

this.sleep(time);

}

} else {

scrollDown();

}

};

this.swipe = function (x1, y1, x2, y2, duration) {

swipe(x1, y1, x2, y2, duration);

};

this.sleep = (second) => {

sleep(second * 1000);

};

this.back = function () {

back();

};

this.home = function () {

home();

};

this.shell = function (command) {

shell(command, true);

};

this.launch = function () {

launch(this.packageName);

};

this.waitForActivity = function (activityName) {

waitForActivity(activityName);

};

this.launchActivity = function (activityName) {

shell("am start -n " + this.packageName + "/" + activityName, true);

waitForActivity(activityName);

};

this.kill = function () {

shell("am force-stop " + this.packageName, true);

};

this.before = function (ignoreSleep) {

let source = engines.myEngine().source.toString();

source = source.replace("/storage/emulated/0/脚本/", "");

toast("开始执行[" + source + "]...");

const WIDTH = Math.min(device.width, device.height);

const HEIGHT = Math.max(device.width, device.height);

setScreenMetrics(WIDTH, HEIGHT);

if (!ignoreSleep)

this.sleep(random() * 10); //随机睡眠[0-10]秒, 使签到\打卡时间不固定

};

this.after = function () {

let source = engines.myEngine().source.toString();

source = source.replace("/storage/emulated/0/脚本", "");

toast("结束执行[" + source + "]...");

exit();

};

this.getCaptureImg = () => {

var img = captureScreen();

if (!img || typeof (img) == "undifined") {

console.log("截图失败,退出脚本");

exit();

} else {

return img;

}

}

}

module.exports = Helper;[/i]

可以把文件保存为Helper.js, 然后要放到 手机的 "脚本" 文件夹下

然后在其他文件中,如果要调用

[i]var Helper = require("Helper.js");

var helper = new Helper("com.galaxy.stock");[/i]

然后后续可以用helper来正常操作,比如上面我要自动启动 银河证券[i]helper.launch()[/i] 就可以了

华宝油气自动化申购脚本 AutoJS

更新待续。。。。

查看全部

"/storage/emulated/0/脚本/"2. 对于一些封装的模块的调用

像下面笔者自己封装的一个模块:

function Helper(packageName) {

this.packageName = packageName;

if (packageName && !getAppName(packageName)) {

toast("找不到此应用, 无法提供服务");

this.sleep(1000);

exit();

}

this.click = function (x, y) {

return click(x, y);

};

this.clickCenter = function (widget) {

if (!widget) {

toast('找不到控件');

return false;

}

let rect = widget.bounds();

return click(rect.centerX(), rect.centerY());

};

this.clickSelectorCenter = function (selector) {

if (!selector) {

toast('找不到控件');

return false;

}

let widget = selector.findOne(2000);

return this.clickCenter(widget);

};

this.clickMulti = function (points, interval) {

points.forEach(function (point) {

this.click(point[0], point[1]);

this.sleep(interval);

}.bind(this));

};

this.clickMultiCenter = function (widgets) {

if (!widgets || widgets.length == 0)

return;

var points = ;

widgets.forEach(function (widget) {

var rect = widget.bounds();

points.push([rect.centerX(), rect.centerY()]);

});

this.clickMulti(points);

};

this.clickIdCenter = function (idStr) {

if (!idStr) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(id(idStr));

};

this.clickTextCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(text(str));

};

this.clickRegTextCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(textMatches(str));

};

this.clickDescCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(desc(str));

};

this.clickRegDescCenter = function (str) {

if (!str) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(descMatches(str));

};

this.clickClassCenter = function (classNameStr) {

if (!className) {

toast('找不到控件');

return false;

}

return this.clickSelectorCenter(className(classNameStr));

};

// index表示第几个文字, 从1开始

this.clickNTextCenter = function (str, index) {

if (!str)

return false;

let widgets = text(str).find();

if (!widgets)

return false;

index--

for (let i = 0; i < widgets.length; i++) {

let widget = widgets[i];

if (i == index)

return this.clickCenter(widget);

else

continue;

}

return false;

};

this.pageUp = (counter, time) => {

if (counter && time) {

for (let i = 0; i < counter; i++) {

scrollUp();

this.sleep(time);

}

} else {

scrollUp();

}

};

this.pageDown = (counter, time) => {

if (counter && time) {

for (let i = 0; i < counter; i++) {

scrollDown();

this.sleep(time);

}

} else {

scrollDown();

}

};

this.swipe = function (x1, y1, x2, y2, duration) {

swipe(x1, y1, x2, y2, duration);

};

this.sleep = (second) => {

sleep(second * 1000);

};

this.back = function () {

back();

};

this.home = function () {

home();

};

this.shell = function (command) {

shell(command, true);

};

this.launch = function () {

launch(this.packageName);

};

this.waitForActivity = function (activityName) {

waitForActivity(activityName);

};

this.launchActivity = function (activityName) {

shell("am start -n " + this.packageName + "/" + activityName, true);

waitForActivity(activityName);

};

this.kill = function () {

shell("am force-stop " + this.packageName, true);

};

this.before = function (ignoreSleep) {

let source = engines.myEngine().source.toString();

source = source.replace("/storage/emulated/0/脚本/", "");

toast("开始执行[" + source + "]...");

const WIDTH = Math.min(device.width, device.height);

const HEIGHT = Math.max(device.width, device.height);

setScreenMetrics(WIDTH, HEIGHT);

if (!ignoreSleep)

this.sleep(random() * 10); //随机睡眠[0-10]秒, 使签到\打卡时间不固定

};

this.after = function () {

let source = engines.myEngine().source.toString();

source = source.replace("/storage/emulated/0/脚本", "");

toast("结束执行[" + source + "]...");

exit();

};

this.getCaptureImg = () => {

var img = captureScreen();

if (!img || typeof (img) == "undifined") {

console.log("截图失败,退出脚本");

exit();

} else {

return img;

}

}

}

module.exports = Helper;[/i]可以把文件保存为Helper.js, 然后要放到 手机的 "脚本" 文件夹下

然后在其他文件中,如果要调用

[i]var Helper = require("Helper.js");

var helper = new Helper("com.galaxy.stock");[/i]

然后后续可以用helper来正常操作,比如上面我要自动启动 银河证券

[i]helper.launch()[/i]就可以了

华宝油气自动化申购脚本 AutoJS

更新待续。。。。

pandas dataframe 切片与python列表切片的区别

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 3088 次浏览 • 2020-10-29 23:34

有一个Dataframedf = pd.DataFrame(np.arange(16).reshape((8,2)),index=list('abcdefgh'),columns=['COL1','COL2'])COL1 COL2

a 0 1

b 2 3

c 4 5

d 6 7

e 8 9

f 10 11

g 12 13

h 14 15那么如果我用df['a':'e'] 返回的结果是:

COL1 COL2

a 0 1

b 2 3

c 4 5

d 6 7

e 8 9是包含e尾部的,

而python的切片

a = [0,1,2,3,4,5]

a[1:5] 是不包含最后一个元素的。

原文链接:

http://30daydo.com/article/630

查看全部

有一个Dataframe

df = pd.DataFrame(np.arange(16).reshape((8,2)),index=list('abcdefgh'),columns=['COL1','COL2'])COL1 COL2那么如果我用df['a':'e'] 返回的结果是:

a 0 1

b 2 3

c 4 5

d 6 7

e 8 9

f 10 11

g 12 13

h 14 15

COL1 COL2是包含e尾部的,

a 0 1

b 2 3

c 4 5

d 6 7

e 8 9

而python的切片

a = [0,1,2,3,4,5]

a[1:5] 是不包含最后一个元素的。

原文链接:

http://30daydo.com/article/630

【python数据采集与分析】获取配售新股最多的基金 - 天天基金网 套利

股票 • 李魔佛 发表了文章 • 0 个评论 • 2277 次浏览 • 2020-10-28 23:37

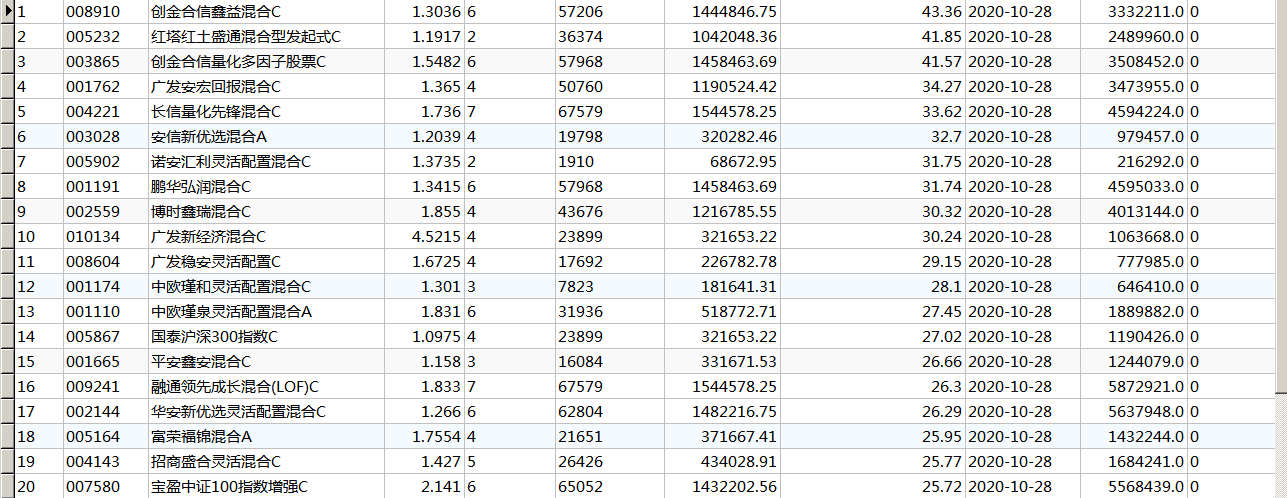

根据天天基金网的获得新股的基金数据,采集下来。然后再去新股获配详情里面,点击某一只新股,然后里面有每一个基金的拟申购股数与金额,通过这个数据取更新某个基金的实际获配金额,更为精确的知道基金中新股的占比。

已完成。

部分数据如下图:

点击查看大图

程序编译为exe可执行程序,兼容各个平台。

对数据或者程序有意者可以私信。 查看全部

Python爬虫学习者需要注意什么?

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 2466 次浏览 • 2020-10-28 17:14

最常见的解决方法就是使用大量的ip,就是借着代理ip保证IP被封时有替换IP可用,永远保持着续航能力。这里推荐51代理ip,作为一家提供代理IP的专业服务商,万变ip代理拥有强大的技术团队运营维护,全高匿系统所产生的高匿ip不仅安全稳定、而且速度快, 以及与爬虫用户多年来合作的宝贵经验,是Python爬虫首选代理IP。

Python是一种全栈计算机程序设计语言,全栈,顾名思义,应用范围广。你可能听说过很多编程语言,例如C语言,Java语言等,众所周知,这些语言都非常难学,更别说景桐使用了。而python不一样,比如完成一个Web服务,C语言要写1000行代码,Java要写100行,而python可能只要写20行。对!这就是差距!目前由于python“简单易懂”,已逐步成为网络爬虫主流语言。

在初学python爬虫时,很多程序员会被一些“小问题”阻碍脚步,为避免大家再次犯同样的错误,加快学习进程,在爬取网站信息时一定要使用大量代理IP。好用的代理IP服务商,

高效率的爬虫工作离不开ip代理的支持,这就是ip代理越来越受欢迎的原因!收藏举报投诉 查看全部

最常见的解决方法就是使用大量的ip,就是借着代理ip保证IP被封时有替换IP可用,永远保持着续航能力。这里推荐51代理ip,作为一家提供代理IP的专业服务商,万变ip代理拥有强大的技术团队运营维护,全高匿系统所产生的高匿ip不仅安全稳定、而且速度快, 以及与爬虫用户多年来合作的宝贵经验,是Python爬虫首选代理IP。

Python是一种全栈计算机程序设计语言,全栈,顾名思义,应用范围广。你可能听说过很多编程语言,例如C语言,Java语言等,众所周知,这些语言都非常难学,更别说景桐使用了。而python不一样,比如完成一个Web服务,C语言要写1000行代码,Java要写100行,而python可能只要写20行。对!这就是差距!目前由于python“简单易懂”,已逐步成为网络爬虫主流语言。

在初学python爬虫时,很多程序员会被一些“小问题”阻碍脚步,为避免大家再次犯同样的错误,加快学习进程,在爬取网站信息时一定要使用大量代理IP。好用的代理IP服务商,

高效率的爬虫工作离不开ip代理的支持,这就是ip代理越来越受欢迎的原因!收藏举报投诉

优矿 由于您的Notebook运行内容占用内存过大或其他逻辑错误,微核已自动重启。

股票 • 李魔佛 发表了文章 • 0 个评论 • 2137 次浏览 • 2020-10-28 01:12

Python爬虫虎牙平台主播的图片代码

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 2500 次浏览 • 2020-10-27 17:55

代码如下:

import urllib.request

import re

import os

# 全局变量用来记录图片的编号

gl_z = 0

def down_img(url1):

"""下载图片"""

# 处理图片链接,拼接http:

url = "https:" + re.sub(r"\?", "", url1)

global gl_z

print(url)

# 请求链接

response = urllib.request.urlopen(url)

# 读取内容

data = response.read()

# 切片取出图片名称

file_name = url[url.rfind('/') + 1:]

# 生成列表

a = [x for x in range(10000)]

# 打开文件用以写入

file = open(os.path.join("photo3", "img" + file_name + str(a[gl_z]) + ".jpg"), "wb")

file.write(data)

# 关闭文件

file.close()

# 编号加1

gl_z += 1

if __name__ == '__main__':

# 要抓去信息的网址

home = """http://www.huya.com/g/xingxiu"""

# 模拟请求头

headers = {

"Host": "www.huya.com",

"User-Agent": "agent信息"

}

# 构造好请求对象 将请求提交到服务器 获取的响应就是到首页的html代码

request = urllib.request.Request(url=home, headers=headers)

response = urllib.request.urlopen(request)

# 读取抓到的内容并解码

html_data = response.read().decode()

"""huyaimg.msstatic.com/avatar/1054/db/6590aa9bcf98e12e5d809d371e46cc_180_135.jpg

"""

# 使用正则 从首页中 提取出所有的图片链接

img_list = re.findall(r"//huyaimg\.msstatic\.com.+\.jpg\?", html_data)

print(img_list)

# 取出每张图片进行下载

for img_url in img_list:

print(img_url)

down_img(img_url) 查看全部

代码如下:

import urllib.request

import re

import os

# 全局变量用来记录图片的编号

gl_z = 0

def down_img(url1):

"""下载图片"""

# 处理图片链接,拼接http:

url = "https:" + re.sub(r"\?", "", url1)

global gl_z

print(url)

# 请求链接

response = urllib.request.urlopen(url)

# 读取内容

data = response.read()

# 切片取出图片名称

file_name = url[url.rfind('/') + 1:]

# 生成列表

a = [x for x in range(10000)]

# 打开文件用以写入

file = open(os.path.join("photo3", "img" + file_name + str(a[gl_z]) + ".jpg"), "wb")

file.write(data)

# 关闭文件

file.close()

# 编号加1

gl_z += 1

if __name__ == '__main__':

# 要抓去信息的网址

home = """http://www.huya.com/g/xingxiu"""

# 模拟请求头

headers = {

"Host": "www.huya.com",

"User-Agent": "agent信息"

}

# 构造好请求对象 将请求提交到服务器 获取的响应就是到首页的html代码

request = urllib.request.Request(url=home, headers=headers)

response = urllib.request.urlopen(request)

# 读取抓到的内容并解码

html_data = response.read().decode()

"""huyaimg.msstatic.com/avatar/1054/db/6590aa9bcf98e12e5d809d371e46cc_180_135.jpg

"""

# 使用正则 从首页中 提取出所有的图片链接

img_list = re.findall(r"//huyaimg\.msstatic\.com.+\.jpg\?", html_data)

print(img_list)

# 取出每张图片进行下载

for img_url in img_list:

print(img_url)

down_img(img_url)

python打造3D撞球小游戏

python • wanbainip 发表了文章 • 0 个评论 • 2794 次浏览 • 2020-10-26 15:52

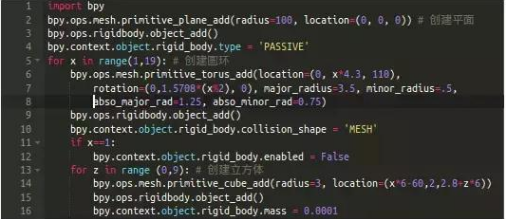

我们需要三组刚体(当您在Blender的对象上打开一个刚体的属性时,Blender将模拟与其它刚体的碰撞):

1.平面

第2行代码创建了一个简单的平面,立方体将放置在该平面上。为了防止它因重力而坠落,我们将其设为“受体”第4行代码。

2. 圆环

第11-12行将第一个圆环的"Enabled"属性设置为false,防止由于重力而坠落。这样它就固定在那牵住整个链条。

3. 立方体

因为z循环第13行嵌套在x循环[第5行]中,我们将得到一个18X10的立方体组成的墙。 查看全部

Python爬虫基本框架

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 2274 次浏览 • 2020-10-25 18:01

1. 爬虫调度器负责统筹其他四个模块协调工作。

2. URL管理器负责管理URL链接,包括已爬取的链接和未爬取的链接。

3. HTML下载器用于从URL管理器中获取未爬取的链接并下载其HTML网页。

4. HTML解析器用于解析HTML下载器下载的HTML网页,获取URL链接交给URL管理器,提取要获取的数据交给数据存储器。

5. 数据存储器用于将HTML解析器解析出来的数据存储到数据库或文件。 查看全部

1. 爬虫调度器负责统筹其他四个模块协调工作。

2. URL管理器负责管理URL链接,包括已爬取的链接和未爬取的链接。

3. HTML下载器用于从URL管理器中获取未爬取的链接并下载其HTML网页。

4. HTML解析器用于解析HTML下载器下载的HTML网页,获取URL链接交给URL管理器,提取要获取的数据交给数据存储器。

5. 数据存储器用于将HTML解析器解析出来的数据存储到数据库或文件。

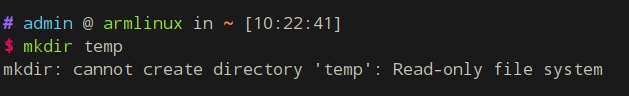

斐讯N1 armlinux 长时间运行会导致文件系统只读 readonly

Linux • 李魔佛 发表了文章 • 0 个评论 • 3029 次浏览 • 2020-10-25 00:24

比如放着几个晚上不关机,然后文件系统变成了只读,无法写入文件,提示只读系统。

原因是系统分区有坏道。 可能由于关机使用拔电源的方式导致的。

所以要养成好的习惯,正常关机,使用命令 shutdown -h 或者点击关机按钮就好了。

那么如果出现了上述问题,怎么办?

可以使用用U盘启动,运行一次e2fsck /dev/mmcblk1p2

然后选择Y,修复坏道就可以了。

U盘启动就是之前刷Armlinux时的那个U盘。

接上U盘,然后上电启动即可。 然后进入系统运行上述的命令:

e2fsck /dev/mmcblk1p2

查看全部

比如放着几个晚上不关机,然后文件系统变成了只读,无法写入文件,提示只读系统。

原因是系统分区有坏道。 可能由于关机使用拔电源的方式导致的。

所以要养成好的习惯,正常关机,使用命令 shutdown -h 或者点击关机按钮就好了。

那么如果出现了上述问题,怎么办?

可以使用用U盘启动,运行一次e2fsck /dev/mmcblk1p2

然后选择Y,修复坏道就可以了。

U盘启动就是之前刷Armlinux时的那个U盘。

接上U盘,然后上电启动即可。 然后进入系统运行上述的命令:

e2fsck /dev/mmcblk1p2

Python爬虫如何防止ip被封?

python爬虫 • wanbainip 发表了文章 • 0 个评论 • 2526 次浏览 • 2020-10-24 10:22

第一种:降低访问的速度,我们可以使用 time模块中的sleep,使程序每运行一次后就睡眠1s,这样可以很有效的降低ip被封机率,但是效率效果不是很高,一般是用于量小的采集任务。

第二种:使用类似万变ip代理这样的优质换ip软件,这也是爬虫工作者最常用的手段之一,通过代理ip来伪装我们的ip,隐藏本地真实的ip地址,让目标服务器无法识别是相同ip发出的请求,这样就很有效的防止ip被封。突破了ip的限制,采集数据的任务就会顺利,工作效率自然会提高!

查看全部

第一种:降低访问的速度,我们可以使用 time模块中的sleep,使程序每运行一次后就睡眠1s,这样可以很有效的降低ip被封机率,但是效率效果不是很高,一般是用于量小的采集任务。

第二种:使用类似万变ip代理这样的优质换ip软件,这也是爬虫工作者最常用的手段之一,通过代理ip来伪装我们的ip,隐藏本地真实的ip地址,让目标服务器无法识别是相同ip发出的请求,这样就很有效的防止ip被封。突破了ip的限制,采集数据的任务就会顺利,工作效率自然会提高!

网络爬虫的分类

网络 • wanbainip 发表了文章 • 0 个评论 • 2471 次浏览 • 2020-10-23 17:51

网络爬虫我们可以分为三大类型:

(1)分布式爬虫:Nutch

(2)JAVA爬虫:Crawler4j、WebMagic、WebCollector

(3)非JAVA爬虫:scrapy(基于Python语言开发)

网络爬虫采集数据过程中,经常会遇到被反爬虫机制限制,最常见的就是ip被限制,网站根据ip的访问频率来识别

判断爬虫,当相同的ip频繁的对目标服务器进行访问,那么就会触发服务器的反爬虫机制,这个时候ip就会被限制

或者无法进行访问,爬虫工作将无法继续进行,因此需要借用到万变ip代理来突破ip的限制。

查看全部

网络爬虫我们可以分为三大类型:

(1)分布式爬虫:Nutch

(2)JAVA爬虫:Crawler4j、WebMagic、WebCollector

(3)非JAVA爬虫:scrapy(基于Python语言开发)

网络爬虫采集数据过程中,经常会遇到被反爬虫机制限制,最常见的就是ip被限制,网站根据ip的访问频率来识别

判断爬虫,当相同的ip频繁的对目标服务器进行访问,那么就会触发服务器的反爬虫机制,这个时候ip就会被限制

或者无法进行访问,爬虫工作将无法继续进行,因此需要借用到万变ip代理来突破ip的限制。

pipreqs python3 不兼容问题解决

python • 李魔佛 发表了文章 • 0 个评论 • 3830 次浏览 • 2020-10-21 16:02

1. 如果报错信息是:

如果提示“UnicodeDecodeError: 'gbk' codec can't decode ”的错误,需要指定字符集 --encoding=utf8

pipreqs ./ --encoding=utf8

2. 出现诸如:Traceback (most recent call last):

File "c:\anaconda\envs\py37\lib\runpy.py", line 193, in _run_module_as_main

"__main__", mod_spec)

File "c:\anaconda\envs\py37\lib\runpy.py", line 85, in _run_code

exec(code, run_globals)

File "C:\anaconda\envs\py37\Scripts\pipreqs.exe\__main__.py", line 7, in <module>

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 470, in main

init(args)

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 409, in init

follow_links=follow_links)

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 138, in get_all_imports

raise exc

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 124, in get_all_imports

tree = ast.parse(contents)

File "c:\anaconda\envs\py37\lib\ast.py", line 35, in parse

return compile(source, filename, mode, PyCF_ONLY_AST)

File "<unknown>", line 162

except Exception ,e:

^

SyntaxError: invalid syntax

明显的python2的语法报错,这时很可能是你的项目中有python2语法的py文件,可以使用

--ignore <dirs> ...忽略额外的目录

参数解决。

原文链接:

http://30daydo.com/article/619

转载请注明出处 查看全部

1. 如果报错信息是:

如果提示“UnicodeDecodeError: 'gbk' codec can't decode ”的错误,需要指定字符集 --encoding=utf8

pipreqs ./ --encoding=utf8

2. 出现诸如:

Traceback (most recent call last):

File "c:\anaconda\envs\py37\lib\runpy.py", line 193, in _run_module_as_main

"__main__", mod_spec)

File "c:\anaconda\envs\py37\lib\runpy.py", line 85, in _run_code

exec(code, run_globals)

File "C:\anaconda\envs\py37\Scripts\pipreqs.exe\__main__.py", line 7, in <module>

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 470, in main

init(args)

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 409, in init

follow_links=follow_links)

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 138, in get_all_imports

raise exc

File "c:\anaconda\envs\py37\lib\site-packages\pipreqs\pipreqs.py", line 124, in get_all_imports

tree = ast.parse(contents)

File "c:\anaconda\envs\py37\lib\ast.py", line 35, in parse

return compile(source, filename, mode, PyCF_ONLY_AST)

File "<unknown>", line 162

except Exception ,e:

^

SyntaxError: invalid syntax

明显的python2的语法报错,这时很可能是你的项目中有python2语法的py文件,可以使用

--ignore <dirs> ...忽略额外的目录

参数解决。

原文链接:

http://30daydo.com/article/619

转载请注明出处

2020-10-20 可转债市场成交量较昨天多一倍

股票 • 绫波丽 发表了文章 • 0 个评论 • 2183 次浏览 • 2020-10-20 17:51

最近的策略就是减仓。

最近的策略就是减仓。

Started update UTMP about system Runlevel during booting ubuntu/armlinux

Linux • 李魔佛 发表了文章 • 0 个评论 • 4993 次浏览 • 2020-10-20 13:33

Started update UTMP about system Runlevel

Finally, i try to enter into secure mode and check logs.

it was caused by system disk is out of space.

So i try to delete some unless file to release some space, then reboot system, then everything is ok now.

http://30daydo.com/article/617

查看全部

Started update UTMP about system Runlevel

Finally, i try to enter into secure mode and check logs.

it was caused by system disk is out of space.

So i try to delete some unless file to release some space, then reboot system, then everything is ok now.

http://30daydo.com/article/617

mysql存储过程学习

数据库 • 李魔佛 发表了文章 • 0 个评论 • 2291 次浏览 • 2020-10-18 16:38

环境 : MySQL8 + Navicat

1 .创建一个存储过程:

在navicat的查询窗口执行:

delimiter $$

create procedure hello_procedure ()

begin

select 'hello world';

END $$

call hello_procedure();

查看全部

环境 : MySQL8 + Navicat

1 .创建一个存储过程:

在navicat的查询窗口执行:

delimiter $$

create procedure hello_procedure ()

begin

select 'hello world';

END $$

call hello_procedure();

pycharm实用插件

python • 李魔佛 发表了文章 • 0 个评论 • 2492 次浏览 • 2020-10-17 02:25

括号对变成彩色的

2. kite

人工智能预测输入提示: 根据机器学习,预测你下一个输入函数的名

括号对变成彩色的

2. kite

人工智能预测输入提示: 根据机器学习,预测你下一个输入函数的名

为什么美股打新只能打部分公司,而且大部分都是中国境内运营的公司?

量化交易 • 李魔佛 发表了文章 • 0 个评论 • 3993 次浏览 • 2020-10-17 00:46

之前一个比较疑惑的问题,在一些可以打美股新股的券商软件上,明明看到不少美股新股上市,排队也爬的慢慢的,为什么我们只能打一些中国境内运营的公司?

原因是:

作为全球第一大市场,美股每年IPO融资规模和上市宗数基本稳定在全球前3。

从之前笔者汇总的数据来看:美股IPO首日破发率比港股还要低一点,打新确实有利可图。可为什么一直火不起来呢?

应粉丝要求,今天简单讲一讲。可能有的地方会说错,欢迎指正。美股打新只有美国人可以参与,其他人只能参与国际配售。其实港股也是这样的,不允许非香港居民参与公开申购,很多银行都严格执行这个规定,但是对参与国际配售就没有限制。

然而港交所并不认真查这个,原因有2点:香港本地居民很少参与IPO认购,2018年之前新股平均认购人数不足3000。大概是因为本地券商手续费太高,申购新股根本赚不到钱。如果再不让大陆人来参与的话,很多公司都发不出去。

同时,投资者通过券商认购新股,港交所会收取5元/笔的EIPO费用。如果单个新股有20万人申购,就可以一次收100万元,谁会跟钱过不去?

港股很多规则是跟美股学的,还是说回美股。

具体申购美股要不要钱(指费用)我不知道,反正国际配售不要钱。连1.0077%中签费好像都没有,参与成本低于港股IPO。

美国居民人数是香港的几十倍,不用担心人数不足;

美国法律那是杠杠的,应该没有券商敢去以身试法。

所以大陆人只能参与国际配售,就会面临一个很麻烦的问题:我们能接触到的开户券商根本就拿不到货,除了少数几个中概股之外。

那么,我们能参与的标的就非常少,通常一年也就那么几次。然而问题并不是到此为止。

还有几个很现实的问题:

首先是新股上市首日,时间很不确定。据说在美股开盘后,新股有很长一段时间是集合竞价时间,将会在这半小时至2小时内随机开盘。你以为可以提前挂个竞价单去睡觉?很不幸,这是不可能的,因为你股票大概率还没到账!

券商拿到股票之后,在通过各种后台分发到投资者账户,根据上手(可以认为是保荐人或者承销商)的不同,时长也不同。反正基本不要指望开盘前能到。

亏钱就算了,还TM不知道要熬夜到几点!

还有一点,同样让人很纠结:券商在派货上有相当大的自主权。

如果股票热门,不分给你,你又能怎么样?跟你很熟吗?

有券商经常这样玩:

认购100股,分50股;

认购300股,还是分50股!

认购1000股,也只分了50股...

为了做到人人有份,简直是侮辱智商!那以后SB才去认购那么多!

烂票都是你的,这个你肯定也不介意吧

申购100股,能分你130股,因为你交的1000美元,下限定价后可以买130股啦!加量不加价哟...

基本就讲完了吧,我只玩过一次就果断拉黑了。集团上市不让我们参与,也没搞成。如果后面有非常好的标的去美国上市,我可能会再参与下。

出了瑞幸这档子事之后,中概股去美国上市,估计要被砍估值。

如果读者有需要开港美股,可以关注公众号:

后台留言: 港美股开户

优惠多多哦。 查看全部

之前一个比较疑惑的问题,在一些可以打美股新股的券商软件上,明明看到不少美股新股上市,排队也爬的慢慢的,为什么我们只能打一些中国境内运营的公司?

原因是:

作为全球第一大市场,美股每年IPO融资规模和上市宗数基本稳定在全球前3。

从之前笔者汇总的数据来看:美股IPO首日破发率比港股还要低一点,打新确实有利可图。可为什么一直火不起来呢?

应粉丝要求,今天简单讲一讲。可能有的地方会说错,欢迎指正。美股打新只有美国人可以参与,其他人只能参与国际配售。其实港股也是这样的,不允许非香港居民参与公开申购,很多银行都严格执行这个规定,但是对参与国际配售就没有限制。

然而港交所并不认真查这个,原因有2点:香港本地居民很少参与IPO认购,2018年之前新股平均认购人数不足3000。大概是因为本地券商手续费太高,申购新股根本赚不到钱。如果再不让大陆人来参与的话,很多公司都发不出去。

同时,投资者通过券商认购新股,港交所会收取5元/笔的EIPO费用。如果单个新股有20万人申购,就可以一次收100万元,谁会跟钱过不去?

港股很多规则是跟美股学的,还是说回美股。

具体申购美股要不要钱(指费用)我不知道,反正国际配售不要钱。连1.0077%中签费好像都没有,参与成本低于港股IPO。

美国居民人数是香港的几十倍,不用担心人数不足;

美国法律那是杠杠的,应该没有券商敢去以身试法。

所以大陆人只能参与国际配售,就会面临一个很麻烦的问题:我们能接触到的开户券商根本就拿不到货,除了少数几个中概股之外。

那么,我们能参与的标的就非常少,通常一年也就那么几次。然而问题并不是到此为止。

还有几个很现实的问题:

首先是新股上市首日,时间很不确定。据说在美股开盘后,新股有很长一段时间是集合竞价时间,将会在这半小时至2小时内随机开盘。你以为可以提前挂个竞价单去睡觉?很不幸,这是不可能的,因为你股票大概率还没到账!

券商拿到股票之后,在通过各种后台分发到投资者账户,根据上手(可以认为是保荐人或者承销商)的不同,时长也不同。反正基本不要指望开盘前能到。

亏钱就算了,还TM不知道要熬夜到几点!

还有一点,同样让人很纠结:券商在派货上有相当大的自主权。

如果股票热门,不分给你,你又能怎么样?跟你很熟吗?

有券商经常这样玩:

认购100股,分50股;

认购300股,还是分50股!

认购1000股,也只分了50股...

为了做到人人有份,简直是侮辱智商!那以后SB才去认购那么多!

烂票都是你的,这个你肯定也不介意吧

申购100股,能分你130股,因为你交的1000美元,下限定价后可以买130股啦!加量不加价哟...

基本就讲完了吧,我只玩过一次就果断拉黑了。集团上市不让我们参与,也没搞成。如果后面有非常好的标的去美国上市,我可能会再参与下。

出了瑞幸这档子事之后,中概股去美国上市,估计要被砍估值。

如果读者有需要开港美股,可以关注公众号:

后台留言: 港美股开户

优惠多多哦。

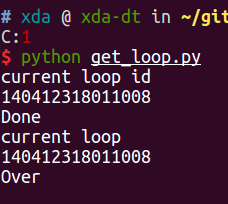

asyncio中get_running_loop和get_event_loop的区别

python • 李魔佛 发表了文章 • 0 个评论 • 7852 次浏览 • 2020-10-10 17:03

asyncio.get_event_loop()

官方地址

https://docs.python.org/3/library/asyncio-eventloop.html?highlight=get_running_loop#asyncio.get_running_loop

get_running_loop() 是python3.7之后新增的函数,用于获取当前正在运行的loop,如果当前主线程中没有正在运行的loop,如果没有就会报RuntimeError 错误。

并且get_running_loop 要在协程里面用,用来捕获当前的loop。

示例用法: 1 # -*- coding: utf-8 -*-

2

3 import asyncio

4

5 async def main():

6 await asyncio.sleep(10)

7 print('Done')

8 myloop = asyncio.get_running_loop()

9 print('current loop ')

10 print(id(myloop))

11

12 # loop = asyncio.get_running_loop()

13 loop = asyncio.get_event_loop()

14 print('current loop id')

15 print(id(loop))

16

17 # print(id(myloop))

18 try:

19 loop.run_until_complete(main())

20 except KeyboardInterrupt:

21 print('key board inpterrupt!')

运行结果:

可以看到两个loop的id是一样的,是同一个对象。

如果第十二行直接调用的话会报错。

asyncio.get_event_loop() 如果在主线程中,如果没有被设置过任何event loop (时间循环),那么会创建一个时间循环,并返回。

查看全部

asyncio.get_event_loop()

官方地址

https://docs.python.org/3/library/asyncio-eventloop.html?highlight=get_running_loop#asyncio.get_running_loop

get_running_loop() 是python3.7之后新增的函数,用于获取当前正在运行的loop,如果当前主线程中没有正在运行的loop,如果没有就会报RuntimeError 错误。

并且get_running_loop 要在协程里面用,用来捕获当前的loop。

示例用法:

1 # -*- coding: utf-8 -*-

2

3 import asyncio

4

5 async def main():

6 await asyncio.sleep(10)

7 print('Done')

8 myloop = asyncio.get_running_loop()

9 print('current loop ')

10 print(id(myloop))

11

12 # loop = asyncio.get_running_loop()

13 loop = asyncio.get_event_loop()

14 print('current loop id')

15 print(id(loop))

16

17 # print(id(myloop))

18 try:

19 loop.run_until_complete(main())

20 except KeyboardInterrupt:

21 print('key board inpterrupt!')

运行结果:

可以看到两个loop的id是一样的,是同一个对象。

如果第十二行直接调用的话会报错。

asyncio.get_event_loop() 如果在主线程中,如果没有被设置过任何event loop (时间循环),那么会创建一个时间循环,并返回。

zsh历史记录文件损坏: zsh: corrupt history file /home/admin/.zsh_history

Linux • 李魔佛 发表了文章 • 0 个评论 • 4470 次浏览 • 2020-10-09 18:12

mv .zsh_history .zsh_history_bad

strings .zsh_history_bad > .zsh_history

fc -R .zsh_history

如果最后一步提示出错 fc的参数不对,可以进入zsh,然后再执行 fc -R .zsh_histroy

原创文章,转载请注明出处:

http://30daydo.com/article/612

查看全部

cd ~

mv .zsh_history .zsh_history_bad

strings .zsh_history_bad > .zsh_history

fc -R .zsh_history

如果最后一步提示出错 fc的参数不对,可以进入zsh,然后再执行 fc -R .zsh_histroy

原创文章,转载请注明出处:

http://30daydo.com/article/612

DBUtils 包名更新为dbutils,居然大部分包名都由驼峰命名改为下划线了

数据库 • 李魔佛 发表了文章 • 0 个评论 • 2922 次浏览 • 2020-10-04 17:01

from DBUtils.PooledDB import PooledDB, SharedDBConnection

POOL = PooledDB

现在是这样的了:

from dbutils.persistent_db import PersistentDB至于使用方法还是和原来的差不多。

原创文章,转载请注明出处

http://30daydo.com/article/611

查看全部

from DBUtils.PooledDB import PooledDB, SharedDBConnection

POOL = PooledDB

现在是这样的了:

from dbutils.persistent_db import PersistentDB至于使用方法还是和原来的差不多。

原创文章,转载请注明出处

http://30daydo.com/article/611

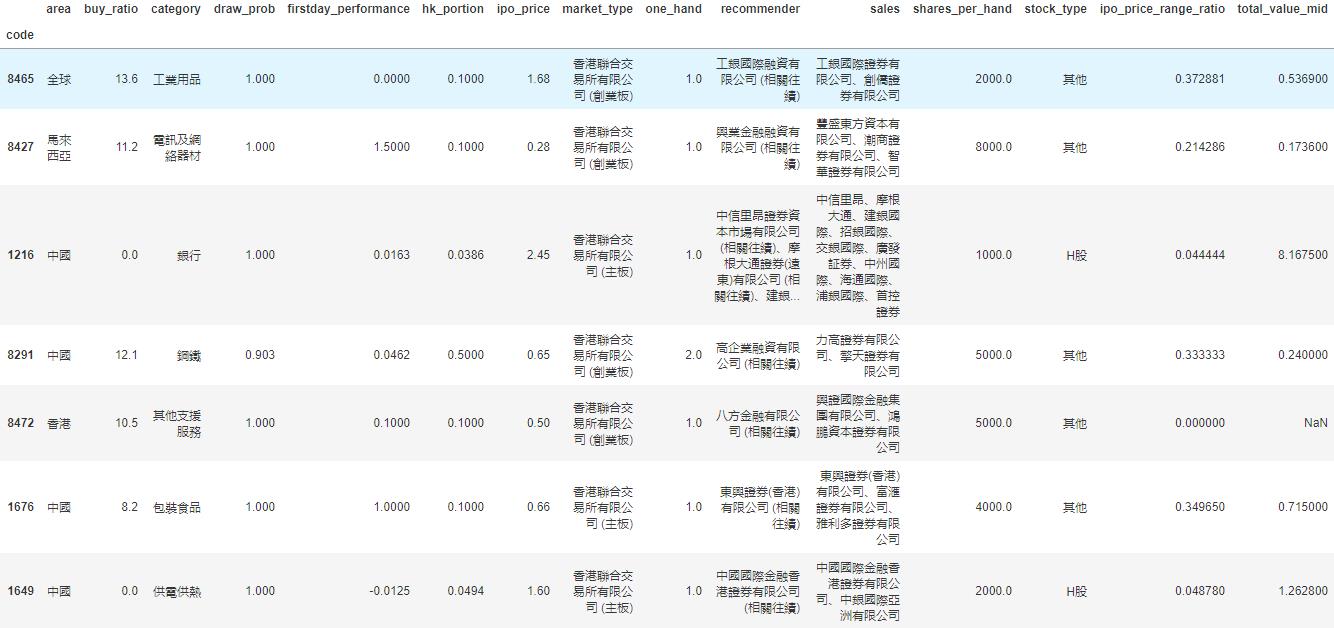

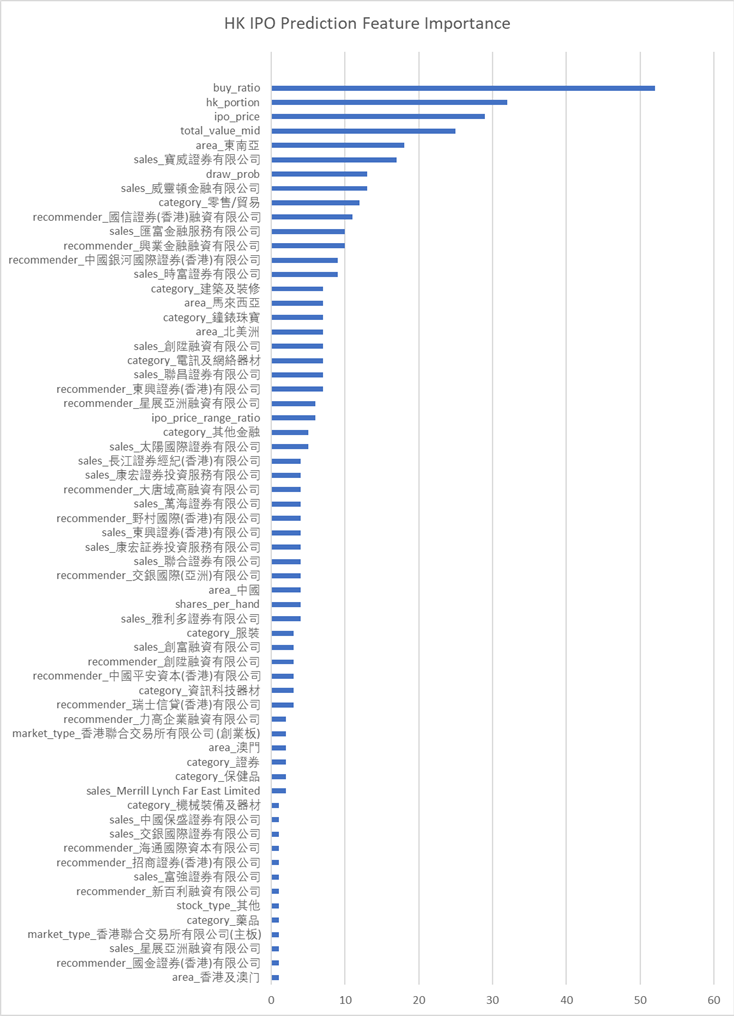

机器学习:港股首日上市价格预测

深度学习 • 李魔佛 发表了文章 • 0 个评论 • 3765 次浏览 • 2020-09-25 22:57

因为我们花了不少时间爬取了港股新股的数据,可以对这些数据加以利用,利用机器学习的模型,预测港股上市价格以及影响因素的权重。

香港股市常年位于全球新股集资三甲之列,每年都有上百只新股上市。与已上市的正股相比,新股的特点是没有任何历史交易数据,这使新股的feature比较朴素,使其可以变成一个较为简单的机器学习问题。

我们在这里,以练手为目的,用新股首日涨跌幅的预测作为例子,介绍一个比较完整的机器学习流程。

数据获取

一个机器学习的项目,最重要的是数据。没有数据,一切再高级的算法都只是纸上谈兵。上一篇文中,已经获取了最近发行的新股的一些基本数据,还有一些详情数据在详细页里面,需要访问详情页获取。

比如农夫山泉,除了之前爬取的基本数据,如上市市值,招股价,中签率,超额倍数,现价等,还有一些保荐人,包销商等有价值数据,所以我们也需要顺带把这些数据获取过来。这时需要在上一篇文章的基础上,获取每一个新股的详情页地址,然后如法炮制,用xpath把数据提取出来。

基本数据页和详情页保存为2个csv文件:data/ipo_list.csv和data/ipo_details.csv

数据清理和特征提取

接下来要做的是对数据进行清理,扔掉无关的项目,然后做一些特征提取和特征处理。

爬取的两个数据,我们先用pandas读取进来,用股票代码code做index,然后合并成为一个大的dataframe.#Read two files and merge

df1 = pd.read_csv('../data/ipo_list', sep='\t', index_col='code')

df2 = pd.read_csv('../data/ipo_details', sep= '\t', index_col = 0)

#Use combine_first to avoid duplicate columns

df = df1.combine_first(df2)

我们看看我们的dataframe有哪些column先:df.columns.values

array(['area', 'banks', 'buy_ratio', 'category', 'date', 'draw_prob',

'eipo', 'firstday_performance', 'hk_portion', 'ipo_price',

'ipo_price_range', 'market_type', 'name', 'now_price', 'one_hand',

'predict_profile_market_ratio', 'predict_profit_ratio',

'profit_ratio', 'recommender', 'sales', 'shares_per_hand',

'stock_type', 'total_performance', 'total_value', 'website'], dtype=object)

我们的目标,也就是我们要预测的值,是首日涨跌幅,即firstday_performance. 我们需要扔掉一些无关的项目,比如日期、收票银行、网址、当前的股价等等。还要扔掉那些没有公开发售的全配售的股票,因为这些股票没有任何散户参与,跟我们目标无关。# Drop unrelated columns

to_del = ['date', 'banks', 'eipo', 'name', 'now_price', 'website', 'total_performance','predict_profile_market_ratio', 'predict_profit_ratio', 'profit_ratio']

for item in to_del:

del df[item]

#Drop non_public ipo stocks

df = df[df.draw_prob.notnull()]

对于百分比的数据,我们要换成float的形式:def per2float(x):

if not pd.isnull(x):

x = x.strip('%')

return float(x)/100.

else:

return x

#Format percentage

df['draw_prob'] = df['draw_prob'].apply(per2float)

df['firstday_performance'] = df['firstday_performance'].apply(per2float)

df['hk_portion'] = df['hk_portion'].apply(per2float)

对于”认购不足”的情况,我们要把超购数替换成为0:def buy_ratio_process(x):

if x == '认购不足':

return 0.0

else:

return float(x)

#Format buy_ratio

df['buy_ratio'] = df['buy_ratio'].apply(buy_ratio_process)

新股招股的IPO价格是一个区间。有一些新股,招股价上下界拉得很开。因为我们已经有了股价作为另一个,所以我们这里希望能拿到IPO招股价格的上下界范围与招股价相比的一个比例,作为一个新的特征:def get_low_bound(x):

if ',' in str(x):

x = x.replace(',', '')

try:

if pd.isnull(x) or '-' not in x:

return float(x)

else:

x = x.split('-')

return float(x[0])

except Exception as e:

print(e)

print(x)

def get_up_bound(x):

if ',' in str(x):

x = x.replace(',', '')

try:

if pd.isnull(x) or '-' not in x:

return float(x)

else:

x = x.split('-')

return float(x[1])

except Exception as e:

print(e)

print(x)

def get_ipo_range_prop(x):

if pd.isnull(x):

return x

low_bound = get_low_bound(x)

up_bound = get_up_bound(x)

return (up_bound-low_bound)*2/(up_bound+low_bound)

#Merge ipo_price_range to proportion of middle

df['ipo_price_range_ratio'] = df['ipo_price_range'].apply(get_ipo_range_prop)

del df['ipo_price_range']

我们取新股招股价对应总市值的中位数作为另一个特征。因为总市值的绝对值是一个非常大的数字,我们把它按比例缩小,使它的取值和其它特征在一个差不多的范围里。def get_total_value_mid(x):

if pd.isnull(x):

return x

low_bound = get_low_bound(x)

up_bound = get_up_bound(x)

return (up_bound+low_bound)/2

df['total_value_mid'] = df['total_value'].apply(get_total_value_mid)/1000000000.

del df['total_value']

于是我们的数据变成了这样一个278 rows × 15 columns的dataframe,即我们有278个数据点和15个特征:

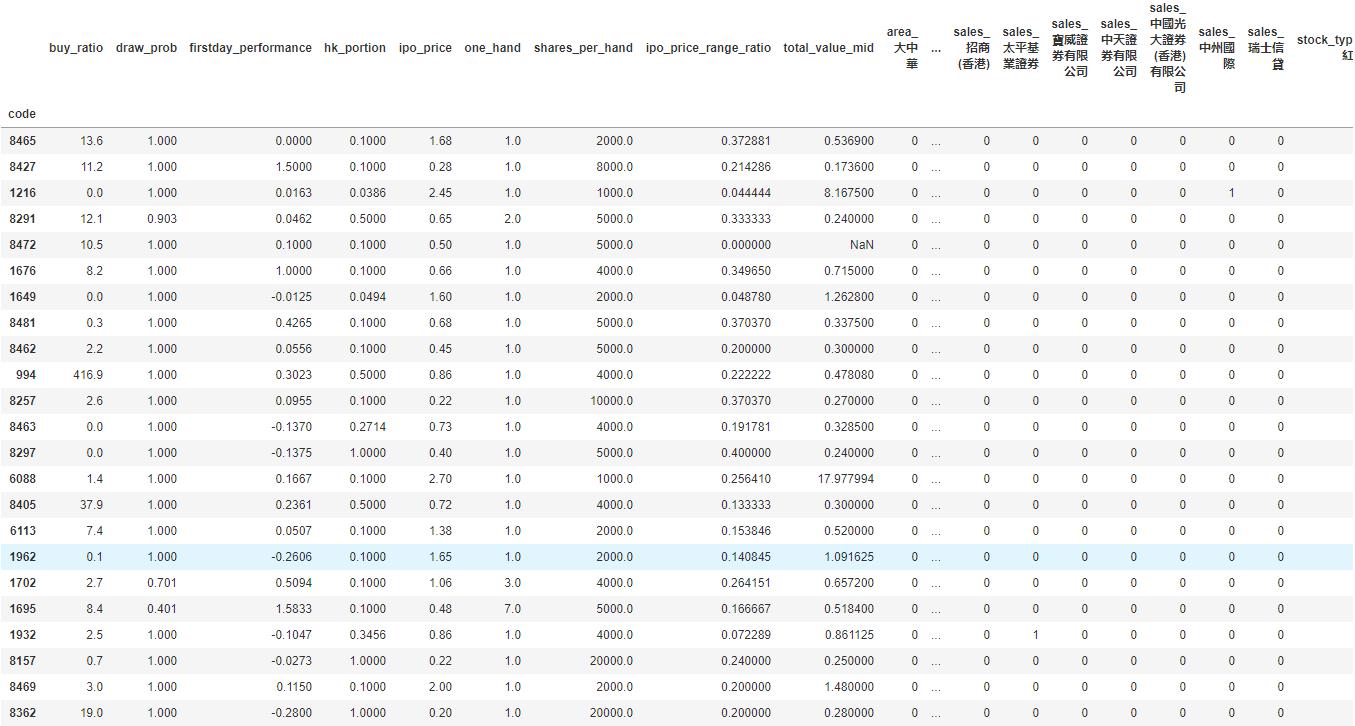

我们看到诸如地区、业务种类等这些特征是categorical的。同时,保荐人和包销商又有多个item的情况。对于这种特征的处理,我们使用one-hot encoding,对每一个种类创建一个新的category,然后用0-1来表示instance是否属于这个category。

#Now do one-hot encoding for all categorical columns

#One problem is that we have to split('、') first for contents with multiple companies

dftest = df.copy()

def one_hot_encoding(df, column_name):

#Reads a df and target column, does tailored one-hot encoding, and return new df for merge

cat_list = df[column_name].unique().tolist()

cat_set = set()

for items in cat_list:

if pd.isnull(items):

continue

items = items.split('、')

for item in items:

item = item.strip()

cat_set.add(item)

for item in cat_set:

item = column_name + '_' + item

df[item] = 0

def check_onehot(x, cat):

if pd.isnull(x):

return 0

x = x.split('、')

for item in x:

if cat == item.strip():

return 1

return 0

for item in cat_set:

df[column_name + '_' + item] = df[column_name].apply(check_onehot, args=(item, ))

del df[column_name]

return df

dftest = one_hot_encoding(dftest, 'area')

dftest = one_hot_encoding(dftest, 'category')

dftest = one_hot_encoding(dftest, 'market_type')

dftest = one_hot_encoding(dftest, 'recommender')

dftest = one_hot_encoding(dftest, 'sales')

dftest = one_hot_encoding(dftest, 'stock_type')这下我们的数据变成了一个278 rows × 535 columns的dataframe,即我们之前的15个特征因为one-hot encoding,一下子变成了535个特征。这其实是机器学习很常见的一个情况,即我们的数据是一个sparce matrix。

训练模型

有了已经整理好特征的数据,我们可以开始建立机器学习模型了。

这里我们用xgboost为例子建立一个非常简单的模型。xgboost是一个基于boosted tree的模型。大家也可以尝试其它更多的算法模型。

我们把数据读入,然后随机把1/3的股票数据分出来做testing data. 我们这里只是一个示例,更高级的方法可以做诸如n-fold validation,以及grid search寻找最优参数等。

# load data and split feature and label

df = pd.read_csv('../data/hk_ipo_feature_engineered', sep='\t', index_col='code', encoding='utf-8')

Y = df['firstday_performance']

X = df.drop('firstday_performance', axis = 1)

# split data into train and test sets

seed = 7

test_size = 0.33

X_train, X_test, y_train, y_test = train_test_split(X, Y, test_size=test_size, random_state=seed)

# fit model no training data

eval_set = [(X_test, y_test)]

因为新股首日涨跌幅是一个float,所以这是一个regression的问题。我们跑xgboost模型,输出mean squared error (越接近0表明准确率越高):

# fit model no training data

xgb_model = xgb.XGBRegressor().fit(X_train,y_train)

predictions = xgb_model.predict(X_test)

actuals = y_test

print mean_squared_error(actuals, predictions)

0.0643324471123

可见准确率还是蛮高的。 xgboost自带了画出特征重要性的方法xgb.plot_importance。 用来描述每个特征对结果的重要程度。

importance = xgb_model.booster().get_score(importance_type='weight')

tuples = [(k, importance[k]) for k in importance]然后利用matplotlib绘制图形。

我们看到几个最强的特征,比如超额倍数、在香港发售的比例、ipo的价格和总市值(细价股更容易涨很多)等。

同时我们还发现了几个比较有意思的特征,比如东南亚地区的股票,和某些包销商与保荐人。

模型预测

这里就略过了。大家大可以自己将即将上市的港股新股做和上面一样的特征处理,然后预测出一个首日涨跌幅,待股票上市后做个对比了!

总结

我们用预测港股新股首日涨跌幅的例子,介绍了一个比较简单的机器学习的流程,包括了数据获取、数据清理、特征处理、模型训练和模型预测等。这其中每一个步骤都可以钻研得非常深;这篇文章只是蜻蜓点水,隔靴搔痒。

最重要的是,掌握了机器学习的知识,也许真的能帮助我们解决很多生活中实际的问题。比如,赚点小钱?

由于微信改版后不再是按时间顺序推送文章,如果后续想持续关注笔者的最新观点,请务必将公众号设为星标,并点击右下角的“赞”和“在看”,不然我又懒得更新了哈,还有更多很好玩的数据等着你哦。

原创文章,转载请注明牛出处

http://30daydo.com/article/608

查看全部

因为我们花了不少时间爬取了港股新股的数据,可以对这些数据加以利用,利用机器学习的模型,预测港股上市价格以及影响因素的权重。

香港股市常年位于全球新股集资三甲之列,每年都有上百只新股上市。与已上市的正股相比,新股的特点是没有任何历史交易数据,这使新股的feature比较朴素,使其可以变成一个较为简单的机器学习问题。

我们在这里,以练手为目的,用新股首日涨跌幅的预测作为例子,介绍一个比较完整的机器学习流程。

数据获取

一个机器学习的项目,最重要的是数据。没有数据,一切再高级的算法都只是纸上谈兵。上一篇文中,已经获取了最近发行的新股的一些基本数据,还有一些详情数据在详细页里面,需要访问详情页获取。

比如农夫山泉,除了之前爬取的基本数据,如上市市值,招股价,中签率,超额倍数,现价等,还有一些保荐人,包销商等有价值数据,所以我们也需要顺带把这些数据获取过来。这时需要在上一篇文章的基础上,获取每一个新股的详情页地址,然后如法炮制,用xpath把数据提取出来。

基本数据页和详情页保存为2个csv文件:data/ipo_list.csv和data/ipo_details.csv

数据清理和特征提取

接下来要做的是对数据进行清理,扔掉无关的项目,然后做一些特征提取和特征处理。

爬取的两个数据,我们先用pandas读取进来,用股票代码code做index,然后合并成为一个大的dataframe.

#Read two files and merge

df1 = pd.read_csv('../data/ipo_list', sep='\t', index_col='code')

df2 = pd.read_csv('../data/ipo_details', sep= '\t', index_col = 0)

#Use combine_first to avoid duplicate columns

df = df1.combine_first(df2)

我们看看我们的dataframe有哪些column先:

df.columns.values

array(['area', 'banks', 'buy_ratio', 'category', 'date', 'draw_prob',

'eipo', 'firstday_performance', 'hk_portion', 'ipo_price',

'ipo_price_range', 'market_type', 'name', 'now_price', 'one_hand',

'predict_profile_market_ratio', 'predict_profit_ratio',

'profit_ratio', 'recommender', 'sales', 'shares_per_hand',

'stock_type', 'total_performance', 'total_value', 'website'], dtype=object)

我们的目标,也就是我们要预测的值,是首日涨跌幅,即firstday_performance. 我们需要扔掉一些无关的项目,比如日期、收票银行、网址、当前的股价等等。还要扔掉那些没有公开发售的全配售的股票,因为这些股票没有任何散户参与,跟我们目标无关。

# Drop unrelated columns

to_del = ['date', 'banks', 'eipo', 'name', 'now_price', 'website', 'total_performance','predict_profile_market_ratio', 'predict_profit_ratio', 'profit_ratio']

for item in to_del:

del df[item]

#Drop non_public ipo stocks

df = df[df.draw_prob.notnull()]

对于百分比的数据,我们要换成float的形式:

def per2float(x):

if not pd.isnull(x):

x = x.strip('%')

return float(x)/100.

else:

return x

#Format percentage

df['draw_prob'] = df['draw_prob'].apply(per2float)

df['firstday_performance'] = df['firstday_performance'].apply(per2float)

df['hk_portion'] = df['hk_portion'].apply(per2float)

对于”认购不足”的情况,我们要把超购数替换成为0:

def buy_ratio_process(x):

if x == '认购不足':

return 0.0

else:

return float(x)

#Format buy_ratio

df['buy_ratio'] = df['buy_ratio'].apply(buy_ratio_process)

新股招股的IPO价格是一个区间。有一些新股,招股价上下界拉得很开。因为我们已经有了股价作为另一个,所以我们这里希望能拿到IPO招股价格的上下界范围与招股价相比的一个比例,作为一个新的特征:

def get_low_bound(x):

if ',' in str(x):

x = x.replace(',', '')

try:

if pd.isnull(x) or '-' not in x:

return float(x)

else:

x = x.split('-')

return float(x[0])

except Exception as e:

print(e)

print(x)

def get_up_bound(x):

if ',' in str(x):

x = x.replace(',', '')

try:

if pd.isnull(x) or '-' not in x:

return float(x)

else:

x = x.split('-')

return float(x[1])

except Exception as e:

print(e)

print(x)

def get_ipo_range_prop(x):

if pd.isnull(x):

return x

low_bound = get_low_bound(x)

up_bound = get_up_bound(x)

return (up_bound-low_bound)*2/(up_bound+low_bound)

#Merge ipo_price_range to proportion of middle

df['ipo_price_range_ratio'] = df['ipo_price_range'].apply(get_ipo_range_prop)

del df['ipo_price_range']

我们取新股招股价对应总市值的中位数作为另一个特征。因为总市值的绝对值是一个非常大的数字,我们把它按比例缩小,使它的取值和其它特征在一个差不多的范围里。

def get_total_value_mid(x):

if pd.isnull(x):

return x

low_bound = get_low_bound(x)

up_bound = get_up_bound(x)

return (up_bound+low_bound)/2

df['total_value_mid'] = df['total_value'].apply(get_total_value_mid)/1000000000.

del df['total_value']

于是我们的数据变成了这样一个278 rows × 15 columns的dataframe,即我们有278个数据点和15个特征:

我们看到诸如地区、业务种类等这些特征是categorical的。同时,保荐人和包销商又有多个item的情况。对于这种特征的处理,我们使用one-hot encoding,对每一个种类创建一个新的category,然后用0-1来表示instance是否属于这个category。

#Now do one-hot encoding for all categorical columns这下我们的数据变成了一个278 rows × 535 columns的dataframe,即我们之前的15个特征因为one-hot encoding,一下子变成了535个特征。这其实是机器学习很常见的一个情况,即我们的数据是一个sparce matrix。

#One problem is that we have to split('、') first for contents with multiple companies

dftest = df.copy()

def one_hot_encoding(df, column_name):

#Reads a df and target column, does tailored one-hot encoding, and return new df for merge

cat_list = df[column_name].unique().tolist()

cat_set = set()

for items in cat_list:

if pd.isnull(items):

continue

items = items.split('、')

for item in items:

item = item.strip()

cat_set.add(item)

for item in cat_set:

item = column_name + '_' + item

df[item] = 0

def check_onehot(x, cat):

if pd.isnull(x):

return 0

x = x.split('、')

for item in x:

if cat == item.strip():

return 1

return 0

for item in cat_set:

df[column_name + '_' + item] = df[column_name].apply(check_onehot, args=(item, ))

del df[column_name]

return df

dftest = one_hot_encoding(dftest, 'area')

dftest = one_hot_encoding(dftest, 'category')

dftest = one_hot_encoding(dftest, 'market_type')

dftest = one_hot_encoding(dftest, 'recommender')

dftest = one_hot_encoding(dftest, 'sales')

dftest = one_hot_encoding(dftest, 'stock_type')

训练模型

有了已经整理好特征的数据,我们可以开始建立机器学习模型了。

这里我们用xgboost为例子建立一个非常简单的模型。xgboost是一个基于boosted tree的模型。大家也可以尝试其它更多的算法模型。

我们把数据读入,然后随机把1/3的股票数据分出来做testing data. 我们这里只是一个示例,更高级的方法可以做诸如n-fold validation,以及grid search寻找最优参数等。

# load data and split feature and label

df = pd.read_csv('../data/hk_ipo_feature_engineered', sep='\t', index_col='code', encoding='utf-8')

Y = df['firstday_performance']

X = df.drop('firstday_performance', axis = 1)

# split data into train and test sets

seed = 7

test_size = 0.33

X_train, X_test, y_train, y_test = train_test_split(X, Y, test_size=test_size, random_state=seed)

# fit model no training data

eval_set = [(X_test, y_test)]

因为新股首日涨跌幅是一个float,所以这是一个regression的问题。我们跑xgboost模型,输出mean squared error (越接近0表明准确率越高):

# fit model no training data可见准确率还是蛮高的。 xgboost自带了画出特征重要性的方法xgb.plot_importance。 用来描述每个特征对结果的重要程度。

xgb_model = xgb.XGBRegressor().fit(X_train,y_train)

predictions = xgb_model.predict(X_test)

actuals = y_test

print mean_squared_error(actuals, predictions)

0.0643324471123

importance = xgb_model.booster().get_score(importance_type='weight')然后利用matplotlib绘制图形。

tuples = [(k, importance[k]) for k in importance]

我们看到几个最强的特征,比如超额倍数、在香港发售的比例、ipo的价格和总市值(细价股更容易涨很多)等。

同时我们还发现了几个比较有意思的特征,比如东南亚地区的股票,和某些包销商与保荐人。

模型预测

这里就略过了。大家大可以自己将即将上市的港股新股做和上面一样的特征处理,然后预测出一个首日涨跌幅,待股票上市后做个对比了!

总结

我们用预测港股新股首日涨跌幅的例子,介绍了一个比较简单的机器学习的流程,包括了数据获取、数据清理、特征处理、模型训练和模型预测等。这其中每一个步骤都可以钻研得非常深;这篇文章只是蜻蜓点水,隔靴搔痒。

最重要的是,掌握了机器学习的知识,也许真的能帮助我们解决很多生活中实际的问题。比如,赚点小钱?

由于微信改版后不再是按时间顺序推送文章,如果后续想持续关注笔者的最新观点,请务必将公众号设为星标,并点击右下角的“赞”和“在看”,不然我又懒得更新了哈,还有更多很好玩的数据等着你哦。

原创文章,转载请注明牛出处

http://30daydo.com/article/608

愿意付费购买商超 商品条形码对应的商品图片,有哪位大神可以帮帮忙啊?+V15032219667

回复python爬虫 • heikekang 发起了问题 • 2 人关注 • 0 个回复 • 2946 次浏览 • 2020-09-25 19:10

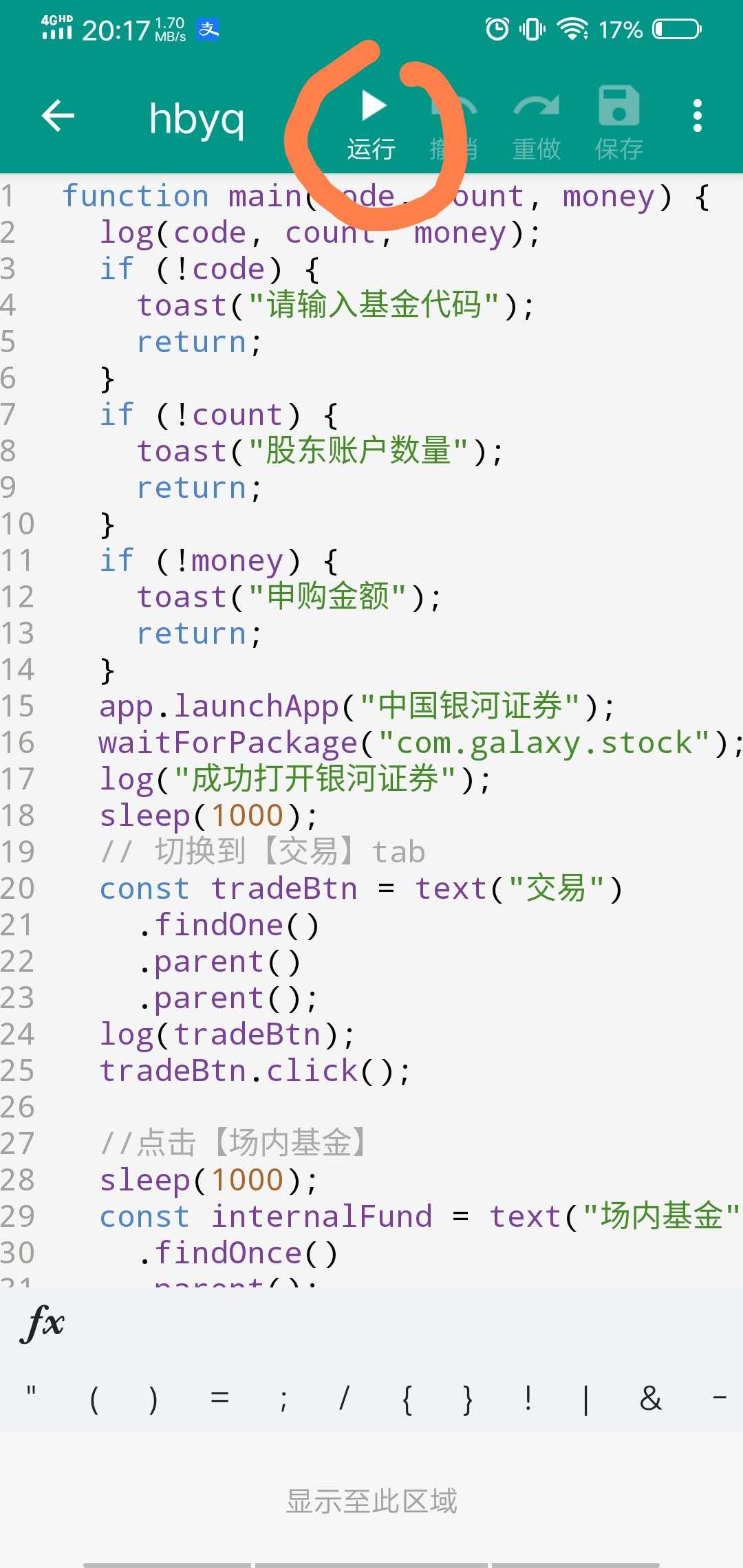

华宝油气自动化申购脚本 AutoJS

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 4408 次浏览 • 2020-09-24 23:40

因为最近两周的华宝油气都呈现很大的折价,但是限购,所以拖拉机申购非常的麻烦,需要一路点击,非常的耗时间,而且容易出错,容易点重复了,导致另外一个股东号没有申购。

所以自己用appium写了个手机自动化申购的脚本,只是它的部署相当不方便,对于一般小白几乎很难独立实现。在上一篇文章中埋了个伏笔 转债水位在降低 当时还准备基于appium写个教程来着。

最近发现有一个叫auto.js的app,基于JS代码的自动化工具,可以很方便的操控手机,只需要在手机上安装一个app,然后写一段JS脚本,然后运行就可以了,部署简化了不少。

后台回复:autojs 会提供相应的app下载与源码打包。

先看运行效果图:

运行的视频文件下面:

https://v.qq.com/x/page/u3155gvuxvt.html

脚本代码入口函数:main("162411", "6", "100");其中第二个参数是申购的次数,场内的最多6个股东号,所以设置为6。

完整代码://可转债量化分析

function main(code, count, money) {

log(code, count, money);

if (!code) {

toast("请输入基金代码");

return;

}

if (!count) {

toast("股东账户数量");

return;

}

if (!money) {

toast("申购金额");

return;

}

app.launchApp("中国银河证券");

waitForPackage("com.galaxy.stock");

log("成功打开银河证券");

sleep(1000);

// 切换到【交易】tab

const tradeBtn = text("交易")

.findOne()

.parent()

.parent();

log(tradeBtn);

tradeBtn.click();

//点击【场内基金】

sleep(1000);

const internalFund = text("场内基金")

.findOnce()

.parent();

internalFund.click();

//点击【基金申购】

waitForActivity("cn.com.chinastock.trade.activity.LofActivity");

const fundPurchase = text("基金申购")

.findOnce()

.parent();

fundPurchase.click();

// 自动填信息

sleep(1000);

purchaseFund(code, count, money);

}

function purchaseFund(code, count, money) {

for (let i = 0; i < count; i++) {

log(code, count, money);

const codeInput = id("stockCode").findOne();

codeInput.click();

codeInput.setText(code);

sleep(1000);

const accountSelect = id("secuidList").findOne();

accountSelect.click();

sleep(1000);

const options = className("CheckedTextView").find();

click(options[i].bounds().left + 2, options[i].bounds().top + 2);

sleep(300);

const orderAmount = id("orderAmount")

.findOnce()

.children()[0];

log(orderAmount);

orderAmount.setText(money);

sleep(300);

id("order")

.findOnce()

.click();

sleep(6000);

id("acceptedCb")

.findOnce()

.click();

id("okBtn")

.findOnce()

.click();

sleep(6000);

click("本人已认真阅读并理解上述内容");

sleep(200);

click("我接受");

sleep(200);

click("本人已认真阅读并理解上述内容");

sleep(200)

click("我接受");

sleep(7000);

click("本人已认真阅读并理解上述内容");

sleep(200);

click("我接受");

sleep(500);

text('确认申购').findOnce().click();

sleep(1000);

text("确定")

.findOnce()

.click();

sleep(1000);

}

}

main("162411", "6", "100");[/i][/i]

[i]安装使用步骤:

安装autojs app

[/i]

[i]手机设置无障碍模式,把autojs添加进去,一般按住app的时候会提示引导你这么操作[/i][list][*][i]打开autojs app,把上面的JS代码复制进去[/i][list][*][i]登录你的X河牌拖拉机[/i][list][*][i]在autojs app里面点击执行[/i]

[/*]

[/list]

[/*]

[/list]

[/*]

[/list]

[i]

然后就静静的等待脚本执行完成,你的6个股东号就全部打完啦。如果你有多个证券账户,需要你退出当前的账户,然后登陆下一个账号,然后继续运行这个脚本即可。

后台回复:autojs 就可以获取autojs的app与上面的源码打包。

PS:如果你有有趣的想法要验证或者苦于没有数据无从下手,可以后台留言,一起交流,笔者会尝试帮你们验证分析。

关注公众号:

[/i] 查看全部

因为最近两周的华宝油气都呈现很大的折价,但是限购,所以拖拉机申购非常的麻烦,需要一路点击,非常的耗时间,而且容易出错,容易点重复了,导致另外一个股东号没有申购。

所以自己用appium写了个手机自动化申购的脚本,只是它的部署相当不方便,对于一般小白几乎很难独立实现。在上一篇文章中埋了个伏笔 转债水位在降低 当时还准备基于appium写个教程来着。

最近发现有一个叫auto.js的app,基于JS代码的自动化工具,可以很方便的操控手机,只需要在手机上安装一个app,然后写一段JS脚本,然后运行就可以了,部署简化了不少。

后台回复:autojs 会提供相应的app下载与源码打包。

先看运行效果图:

运行的视频文件下面:

https://v.qq.com/x/page/u3155gvuxvt.html

脚本代码入口函数:

main("162411", "6", "100");其中第二个参数是申购的次数,场内的最多6个股东号,所以设置为6。完整代码:

//可转债量化分析

function main(code, count, money) {

log(code, count, money);

if (!code) {

toast("请输入基金代码");

return;

}

if (!count) {

toast("股东账户数量");

return;

}

if (!money) {

toast("申购金额");

return;

}

app.launchApp("中国银河证券");

waitForPackage("com.galaxy.stock");

log("成功打开银河证券");

sleep(1000);

// 切换到【交易】tab

const tradeBtn = text("交易")

.findOne()

.parent()

.parent();

log(tradeBtn);

tradeBtn.click();

//点击【场内基金】

sleep(1000);

const internalFund = text("场内基金")

.findOnce()

.parent();

internalFund.click();

//点击【基金申购】

waitForActivity("cn.com.chinastock.trade.activity.LofActivity");

const fundPurchase = text("基金申购")

.findOnce()

.parent();

fundPurchase.click();

// 自动填信息

sleep(1000);

purchaseFund(code, count, money);

}

function purchaseFund(code, count, money) {

for (let i = 0; i < count; i++) {

log(code, count, money);

const codeInput = id("stockCode").findOne();

codeInput.click();

codeInput.setText(code);

sleep(1000);

const accountSelect = id("secuidList").findOne();

accountSelect.click();

sleep(1000);

const options = className("CheckedTextView").find();

click(options[i].bounds().left + 2, options[i].bounds().top + 2);

sleep(300);

const orderAmount = id("orderAmount")

.findOnce()

.children()[0];

log(orderAmount);

orderAmount.setText(money);

sleep(300);

id("order")

.findOnce()

.click();

sleep(6000);

id("acceptedCb")

.findOnce()

.click();

id("okBtn")

.findOnce()

.click();

sleep(6000);

click("本人已认真阅读并理解上述内容");

sleep(200);

click("我接受");

sleep(200);

click("本人已认真阅读并理解上述内容");

sleep(200)

click("我接受");

sleep(7000);

click("本人已认真阅读并理解上述内容");

sleep(200);

click("我接受");

sleep(500);

text('确认申购').findOnce().click();

sleep(1000);

text("确定")

.findOnce()

.click();

sleep(1000);

}

}

main("162411", "6", "100");[/i][/i]

[i]安装使用步骤:

安装autojs app

[/i]

- [i]手机设置无障碍模式,把autojs添加进去,一般按住app的时候会提示引导你这么操作[/i][list][*][i]打开autojs app,把上面的JS代码复制进去[/i][list][*][i]登录你的X河牌拖拉机[/i][list][*][i]在autojs app里面点击执行[/i]

[/*]

[/list]

[/*]

[/list]

[/*]

[/list]

[i]

然后就静静的等待脚本执行完成,你的6个股东号就全部打完啦。如果你有多个证券账户,需要你退出当前的账户,然后登陆下一个账号,然后继续运行这个脚本即可。

后台回复:autojs 就可以获取autojs的app与上面的源码打包。

PS:如果你有有趣的想法要验证或者苦于没有数据无从下手,可以后台留言,一起交流,笔者会尝试帮你们验证分析。

关注公众号:

[/i]