外企,中年失业何去何从 转载于知乎

认真回答,对关注者timeline负责。

12/13更新。

1. 现实是什么和现实应该是什么?

民企累,民企苦,福利差,流程乱,老板苛刻。但是民企在蓬勃发展。

外企轻松,福利好,流程齐全,老板和蔼,但是中国的外企绝大部分在衰退

比如手机,民企现在的没有做到世界第一第二,但是世界第3-10基本上都被搞残了。

这些都是客观现实,跟有没有人性没关系. 你不肯吃苦,就被肯吃苦的抢走客户.

2.有人说,这是企业的前途,跟员工无关。我就要轻松福利好,家庭工作平衡。

当小兵当久了就是这种心态很正常。大船在下沉,这种状态可不可以长久,自己掂量。没人逼你现在跳船,但是你如果没有在之前学会游泳,那到时候说何去何从是你的事。

有人反问:你在民企就学会游泳了?

还真学会的,在外企的人是老外的助手,在民企的人是老外的对手。人家是在跟你的领导一个赛道赛跑呢,时间久了,思维高度都不一样了。外企虽然钱多利润多,都给老外了,中国人就是个低成本的outsource. 现在民企的中国人,工资都比外企的中国人高了. (当然比不上老外高管)20年前可能只有1/10. 多大的差距.

3. 牛的人在哪里都牛,我说了,外企牛人盼望裁员,裁员还有好多补偿而且马上有新工作。

如果外企全是这样的人,就不会问出“中年裁员何去何从”这个问题。我也没有拿华为去年年终奖的数字,来刺激外企的中国员工。

4. 不同层次的人有不同的路——

底层,工资<1万,推荐去外企。

中层,工资在1万到3万,民企外企都能呆。

高层,工资在3万到10万,能够给这个钱的民企,前景肯定比外企好。

顶层,比如CXO,senior VP之类,等等,外企有中国人的顶层位置?不是金发碧眼至少也是绿卡人士, 在民企做的好的中国人能做到陆兆禧,在外企做的好的中国人能做CEO?

5. 最后有人说:我外企给的钱够了。我不要做高层. 人各有志,也祝你好运。

好的评论我都推荐了,有空可以看看。

=============分割线=======

作为一个从外企跳到民企的人。我一直就有一种很深刻的认识——中国的外企要被搞残!

一不重视中国市场. 二核心技术不给中国。三没有成本优势。四没有居安思危的态度。

建议每一个在外企的男人小心~

我从某世界500强公司某世界第一的事业部,跳到中国对应的一家民营企业。我给你看下对比:

1. 论市场与细分外企把中国分为一个市场,中国属于亚太十三国之一。针对所有中国市场,只开发一种产品。民营企业把中国分成N个市场。北方和南方完全是两个截然不同的市场。江浙沪和云川渝又是一个截然不同的市场。不同的市场有不同的打法,不同的产品。

2. 论市场调研与客户需求调研外企的市场部的人,一天到晚坐在办公司里面喝咖啡写PPT,然后某个产品经理出去调研一下市场,拍些照片和视频,回来给其他人看。民企的市场部的人和研发的人,在工地跟工人同吃同住,现场灰尘大也要跟工人一起工作做试验,直到摸清楚客户需求和客户痛点以后才回来。

3. 论产品研发外企在中国的分部,说句难听的,核心的技术研发都放在欧美,中国的工厂没有研发,只有工程部。就是做value engineering和 localization. 他们的关键技术是降本。民营每当外企出一个新的产品,马上买回来,拆解,分析每个零部件的结构,性能,供应商品牌,然后做出一个benchmark表,说,他们用什么,我们用什么,我们比他们好在哪里。

4. 论人员组成和成本。在外企工作轻松,一眼看过去很多美女,好爽!搞研发的30%-50%是女人。外企一到下班时间,10分钟内人员撤退的干干净净,只剩几个领导在哪里加班干活。成本怎么不高?周末周日你要找人加班,实在是开不了口。客户需要服务,还要跟一堆人跑流程。外企的销售根本没有技术含量,感觉就像一个跟单员。反正牌子好,东西能卖出去。民营企业研发部门女人很少,绝大部分是男的。一到下班时间,很多人都去食堂吃饭,晚上一眼看过去,黑压压的一片男人在哪里干活。任何时候,如果客户一句话,都要过来加班。客户一旦需要服务,基本上立马就到。民企的销售个个像狼,跟经销商真的是刀山火海吃喝嫖赌都要把单子搞定。成本怎么不低?

5. 工资待遇与人力成本外企工资看上去其实不高,但是几个外派过来的高层的成本高到恐怖。不仅仅是工资,他们的别墅比天天住五星级酒店还贵,他们的孩子上学,他们的专车司机,他们这几年在中国的各种开销,都必须由公司摊。几个外企高管在中国的费用可能赶得上几千中国工人的费用。中国人工资普遍一般. 民企基层的工资有时候反而会比外企高,(不然吸引不了人过来)但是实际上工资除以平均工作时间,还是外企更贵。

5. 最终价格。民营企业的产品。功能性能跟外企差不多的,价格卖的比外企便宜20%-30%

功能性能比外企还强10%的,卖的价格比外企还低10%外企如果没有品牌,你说怎么比啊!

前面是手机基本是中国的天下,下一个十年就是汽车了。再二三十年,基本上所有的国产品牌都会慢慢起来。这就是为什么我买东西越来越倾向国产的原因。

但是国产也有自己的问题。

民企的弱点就是——中国制造业的批产稳定性质量不足。没办法,这是很多年的差距,需要慢慢赶。

买国产需要运气,同一批产品,可能好的产品很好,不好的到手没几天就坏了。

所以一定要买第一批上市且销量稳定的。

没有稳定的话可能买到手就坏了。稳定太久的,都用便宜货降本了。

但是中国制造还在追,一旦赶上,中国那些没有核心技术的外企分部,基本上都可以滚蛋了。

那些天天呆在里面喝咖啡为了一点鸡毛蒜皮的流程argue的人,如果你还没有掌握外企的有用的知识体系,基本上只能打GG了。

那个时候你还觉得自己端着外企白领的架子,就跟美国当年的汽车企业的工人被失业没有什么区别。

只不过中国你没有选票,不会有人在意你的死活的

=============

看到评论里面的一些话,我回复一下:

1. 我只说中国的外企要残,没有说世界上的外企要亡。

效益不好,外企只不过是裁中国的员工罢了,好歹人家国外还是有上百年的核心技术的。

2. 我在讲述一个中国职场的现实,你没有必要给我普及劳动法。

我并没有说民企的做法是有人性的,但是民企的做法在商场是有竞争力的。商场如战场,资本家只会看最终利益。你可以裁员的时候再去呼吁要不要尊重你。

牛逼的人都盼望外企裁员,因为裁员可以拿N+1的遣散费,而且人家马上就能找到新工作。我说的是那些不牛逼还在外企温水泡青蛙的,裁员了问何去何从的.

3. 我说了,男人要小心!为什么——这不是歧视。这是中国的现实。

现在这几年当然呆在外企更舒服。从女人的角度,呆在外企更能工作家庭平衡。

从男人的角度——现在好,十年后不好,那个时候你上有老下有小,就很危险了。

收起阅读 »

2019

18年过的很失败 浪费了很多很多时间

交易路上的蹒跚学步

资金的不断缩水让自己很被动

真的是踩了数不清的坑

每一次认知的修正都是真金白银换来的

忘了多少次一个人深夜散步

忘了多少次辗转失眠

好在换来一点点曙光

短期的痛苦对长远的信念算不了什么

2019

希望多一点开心

舍得时间管理,把80%的时间精力放在20%最重要的事上,做反做乱都不行

重塑身体管理,18年这块失控了,被亏损后的消极心态影响

精进情绪管理,去年开始对情绪有所认知,但控制力还不够

关于人性,部分简单运用

静和慢,心静则体察精,学习寻寻渐进,做事有几分静气

完善思维体系,处理不同事物运用不同的思维模式,之前的太单一并不适合所有

结交些好友,希望能互相提高分享认知,身边人逐渐被生活随波逐流,

总是一个人记录在封闭的空间也不太好

慢慢往外挪一点吧

不喜太热闹

先试试看

收起阅读 »

交易路上的蹒跚学步

资金的不断缩水让自己很被动

真的是踩了数不清的坑

每一次认知的修正都是真金白银换来的

忘了多少次一个人深夜散步

忘了多少次辗转失眠

好在换来一点点曙光

短期的痛苦对长远的信念算不了什么

2019

希望多一点开心

舍得时间管理,把80%的时间精力放在20%最重要的事上,做反做乱都不行

重塑身体管理,18年这块失控了,被亏损后的消极心态影响

精进情绪管理,去年开始对情绪有所认知,但控制力还不够

关于人性,部分简单运用

静和慢,心静则体察精,学习寻寻渐进,做事有几分静气

完善思维体系,处理不同事物运用不同的思维模式,之前的太单一并不适合所有

结交些好友,希望能互相提高分享认知,身边人逐渐被生活随波逐流,

总是一个人记录在封闭的空间也不太好

慢慢往外挪一点吧

不喜太热闹

先试试看

收起阅读 »

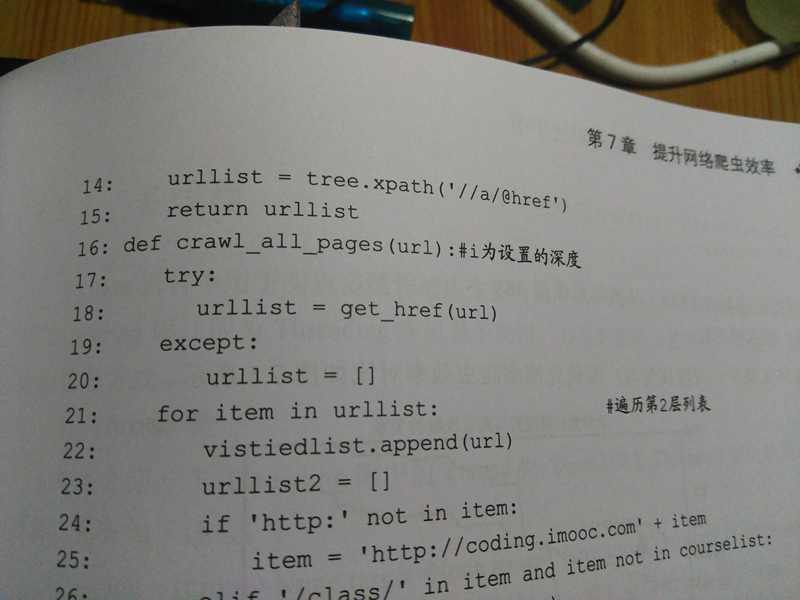

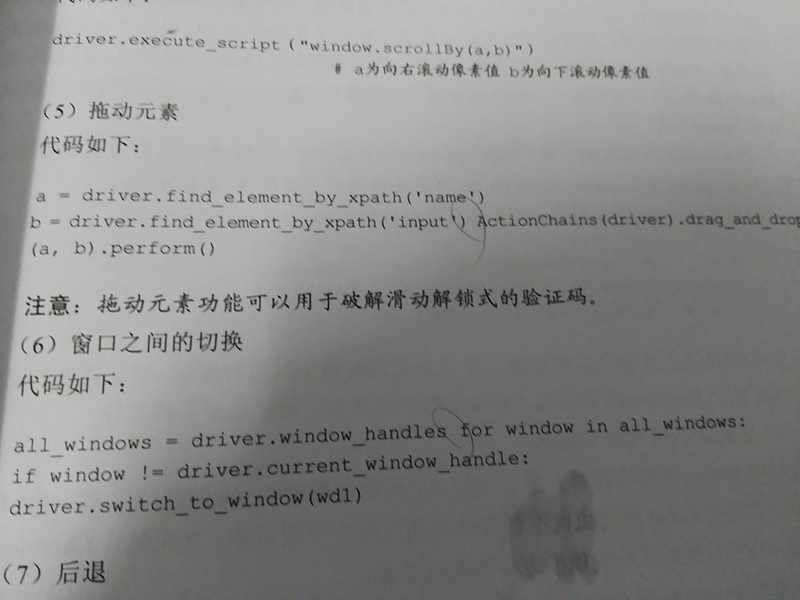

python 中文图片文字识别

pytesseract这个库识别率偏低,也就菜鸟才会用。

使用方法很简单,安装好pytesseract(里面很多坑,小白的话不可避免要折腾一番),然后下载一个中文的字库,百度网盘:https://pan.baidu.com/s/1_jom2d95IeR40gsvkhUuvQ

然后把文件放到tesseract的文件夹中 C:\Program Files (x86)\Tesseract-OCR\tessdata

然后就可以拿来识别了:

图片的内容是这样的:

然后识别效果如下:

还是不咋地。

那么可以换成大厂的API。试试百度的:

先去百度云申请一个API,免费的。

https://cloud.baidu.com/doc/OCR/OCR-Python-SDK.html#.E9.85.8D.E7.BD.AEAipOcr

然后把key复制到上面的代码中就可以了。

然后再调用看看结果:

收起阅读 »

使用方法很简单,安装好pytesseract(里面很多坑,小白的话不可避免要折腾一番),然后下载一个中文的字库,百度网盘:https://pan.baidu.com/s/1_jom2d95IeR40gsvkhUuvQ

然后把文件放到tesseract的文件夹中 C:\Program Files (x86)\Tesseract-OCR\tessdata

然后就可以拿来识别了:

from PIL import Image

im = Image.open('chinese.jpg')

plt.figure(figsize=(20,20))

plt.imshow(im)

pytesseract.image_to_string(im,lang='chi_sim')

图片的内容是这样的:

然后识别效果如下:

'可L又使用以下的语句i上图片显示大 此'

还是不咋地。

那么可以换成大厂的API。试试百度的:

""" 读取图片 """

def get_file_content(filePath):

with open(filePath, 'rb') as fp:

return fp.read()

image = get_file_content('example.jpg')

""" 调用通用文字识别, 图片参数为本地图片 """

client.basicGeneral(image);

""" 如果有可选参数 """

options = {}

options["language_type"] = "CHN_ENG"

options["detect_direction"] = "true"

options["detect_language"] = "true"

options["probability"] = "true"

from aip import AipOcr

""" 你的 APPID AK SK """

APP_ID = '你的 App ID'

API_KEY = '你的 Api Key'

SECRET_KEY = '你的 Secret Key'

client = AipOcr(APP_ID, API_KEY, SECRET_KEY)

""" 带参数调用通用文字识别, 图片参数为本地图片 """

client.basicGeneral(image, options)

url = "https//www.x.com/sample.jpg"

""" 调用通用文字识别, 图片参数为远程url图片 """

client.basicGeneralUrl(url);

""" 如果有可选参数 """

options = {}

options["language_type"] = "CHN_ENG"

options["detect_direction"] = "true"

options["detect_language"] = "true"

options["probability"] = "true"

""" 带参数调用通用文字识别, 图片参数为远程url图片 """

client.basicGeneralUrl(url, options)

先去百度云申请一个API,免费的。

https://cloud.baidu.com/doc/OCR/OCR-Python-SDK.html#.E9.85.8D.E7.BD.AEAipOcr

然后把key复制到上面的代码中就可以了。

然后再调用看看结果:

可以使用以下的语句让图片显示大些正确率明显高很多了。

收起阅读 »

可转债价格分布堆叠图 绘制 可视化 python+pyecharts

这一节课带大家学习如何利用可视化,更好的呈现数据。

即使你有很多数据,可是,你无法直观地看到数据的总体趋势。使用可视化的绘图,可以帮助我们看到数据背后看不到的数据。 比如我已经有每一个可转债的价格,评级。数据如下:

点击查看大图

如果我用下面的图形就可以看出规律:

点击查看大图

横坐标是价格,纵坐标是落在该价格的可转债数量,不同颜色代表不同评级的可转债。

可以看到大部分AA-评级(浅橙色)的可转债价格都在100元以下,而AA(浅蓝色)的可转债价格分布较为平均,从90到110都有。而AA+和AAA的一般都在100以上。

那么如何使用代码实现呢?

如果没有安装pyecharts,需要用pip安装即可。

原创文章

转载请注明出处:

http://30daydo.com/article/400

收起阅读 »

即使你有很多数据,可是,你无法直观地看到数据的总体趋势。使用可视化的绘图,可以帮助我们看到数据背后看不到的数据。 比如我已经有每一个可转债的价格,评级。数据如下:

点击查看大图

如果我用下面的图形就可以看出规律:

点击查看大图

横坐标是价格,纵坐标是落在该价格的可转债数量,不同颜色代表不同评级的可转债。

可以看到大部分AA-评级(浅橙色)的可转债价格都在100元以下,而AA(浅蓝色)的可转债价格分布较为平均,从90到110都有。而AA+和AAA的一般都在100以上。

那么如何使用代码实现呢?

from setting import get_mysql_conn,get_engine

import pandas as pd

import pymongo

from pyecharts import Geo,Style,Map

engine = get_engine('db_stock',local='local')

# 堆叠图

from pyecharts import Bar

df = pd.read_sql('tb_bond_jisilu',con=engine)

result ={}

for name,grades in df.groupby('评级'):

# print(name,grades[['可转债名称','可转债价格']])

for each in grades['可转债价格']:

result.setdefault(name,)

result[name].append(each)

# 确定价格的范围

value = [str(i) for i in range(85,140)]

ret = [0]*len(value)

ret1 = dict(zip(value,ret))

ret_A_add = ret1.copy()

for item in result['A+']:

for k in ret1:

if float(k)+0.5>item and float(k)-0.5<=item:

ret_A_add[k]+=1

retAA_ = ret1.copy()

for item in result['']:

for k in ret1:

if float(k)+0.5>item and float(k)-0.5<=item:

retAA_[k]+=1

retAA = ret1.copy()

for item in result['AA']:

for k in ret1:

if float(k)+0.5>item and float(k)-0.5<=item:

retAA[k]+=1

retAA_add = ret1.copy()

for item in result['AA+']:

for k in ret1:

if float(k)+0.5>item and float(k)-0.5<=item:

retAA_add[k]+=1

retAAA = ret1.copy()

for item in result['AAA']:

for k in ret1:

if float(k)+0.5>item and float(k)-0.5<=item:

retAAA[k]+=1

bar = Bar('可转债价格分布')

bar.add('A+',value,list(ret_A_add.values()),is_stack=True,yaxis_max=11)

bar.add('',value,list(retAA_.values()),is_stack=True,yaxis_max=11)

bar.add('AA',value,list(retAA.values()),is_stack=True,yaxis_max=11)

bar.add('AA+',value,list(retAA_add.values()),is_stack=True,yaxis_max=11)

bar.add('AAA',value,list(retAAA.values()),is_stack=True,yaxis_max=11)

如果没有安装pyecharts,需要用pip安装即可。

原创文章

转载请注明出处:

http://30daydo.com/article/400

收起阅读 »

拉勾网的反爬策略

更新于2019-01-23 ************

(请注意日期,因为不保证往后的日子里面反爬策略还有效)

1. 封IP,这个没的说,肯定要使用代理IP

2. scrapy里面的需要添加headers,而headers中一定要加上Cookies的数据。 之前要做Request中的cookies参数添加cookies,现在发现失效了,只能在headers中添加cookies数据。

(请注意日期,因为不保证往后的日子里面反爬策略还有效)

1. 封IP,这个没的说,肯定要使用代理IP

2. scrapy里面的需要添加headers,而headers中一定要加上Cookies的数据。 之前要做Request中的cookies参数添加cookies,现在发现失效了,只能在headers中添加cookies数据。

headers = {'Accept': 'application/json,text/javascript,*/*;q=0.01', 'Accept-Encoding':

'gzip,deflate,br',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8', 'Cache-Control': 'no-cache',

# 'Connection': 'keep-alive',

'Content-Type': 'application/x-www-form-urlencoded;charset=UTF-8',

'Cookie': 'JSESSIONID=ABAAABAABEEAAJAACF8F22F99AFA35F9EEC28F2D0E46A41;_ga=GA1.2.331323650.1548204973;_gat=1;Hm_lvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204973;user_trace_token=20190123085612-adf35b62-1ea9-11e9-b744-5254005c3644;LGSID=20190123085612-adf35c69-1ea9-11e9-b744-5254005c3644;PRE_UTM=;PRE_HOST=;PRE_SITE=;PRE_LAND=https%3A%2F%2Fwww.lagou.com%2F;LGUID=20190123085612-adf35ed5-1ea9-11e9-b744-5254005c3644;_gid=GA1.2.1809874038.1548204973;index_location_city=%E6%B7%B1%E5%9C%B3;TG-TRACK-CODE=index_search;SEARCH_ID=169bf76c08b548f8830967a1968d10ca;Hm_lpvt_4233e74dff0ae5bd0a3d81c6ccf756e6=1548204985;LGRID=20190123085624-b52a0555-1ea9-11e9-b744-5254005c3644',

'Host': 'www.lagou.com', 'Origin': 'https://www.lagou.com', 'Pragma': 'no-cache',

'Referer': 'https://www.lagou.com/jobs/list_%E7%88%AC%E8%99%AB?labelWords=&fromSearch=true&suginput=',

'User-Agent': 'Mozilla/5.0(WindowsNT6.3;WOW64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/71.0.3578.98Safari/537.36',

'X-Anit-Forge-Code': '0',

'X-Anit-Forge-Token': 'None',

'X-Requested-With': 'XMLHttpRequest'

} 收起阅读 »

python高手才知道的答案

记录一些python不为人知的有趣的用法或者知识点

1.

2.

3.

Python 字典通过检查键值是否相等和比较哈希值来确定两个键是否相同.

具有相同值的不可变对象在Python中始终具有相同的哈希值.

4. 到处返回

当在 "try...finally" 语句的 try 中执行 return, break 或 continue 后, finally 子句依然会执行.

函数的返回值由最后执行的 return 语句决定. 由于 finally 子句一定会执行, 所以 finally 子句中的 return 将始终是最后执行的语句.

5

0 1 2 3

由于循环在Python中工作方式, 赋值语句 i = 10 并不会影响迭代循环, 在每次迭代开始之前, 迭代器(这里指 range(4)) 生成的下一个元素就被解包并赋值给目标列表的变量(这里指 i)了. 收起阅读 »

1.

>>> a = "some_string"

>>> id(a)

140420665652016

>>> id("some" + "_" + "string") # 注意两个的id值是相同的.

140420665652016

2.

e = "wtf"

f = "wtf"

e is f

结果 True

e = "wtf?"

f = "wtf?"

e is f

结果 False

3.

some_dict = {}

some_dict[5.5] = "Ruby"

some_dict[5.0] = "JavaScript"

some_dict[5] = "Python" >>> some_dict[5.5]

"Ruby"

>>> some_dict[5.0]

"Python"

>>> some_dict[5]

"Python"

Python 字典通过检查键值是否相等和比较哈希值来确定两个键是否相同.

具有相同值的不可变对象在Python中始终具有相同的哈希值.

4. 到处返回

def some_func():

try:

return 'from_try'

finally:

return 'from_finally'

>>> some_func()

'from_finally'

当在 "try...finally" 语句的 try 中执行 return, break 或 continue 后, finally 子句依然会执行.

函数的返回值由最后执行的 return 语句决定. 由于 finally 子句一定会执行, 所以 finally 子句中的 return 将始终是最后执行的语句.

5

for i in range(4):你可曾觉得这个循环只会运行一次?

print(i)

i = 10

0 1 2 3

由于循环在Python中工作方式, 赋值语句 i = 10 并不会影响迭代循环, 在每次迭代开始之前, 迭代器(这里指 range(4)) 生成的下一个元素就被解包并赋值给目标列表的变量(这里指 i)了. 收起阅读 »

numpy 二维数组按列合并

numpy的数组默认按行合并,如何按列合并?

先生产测试数组

转化形态:

然后运用concatenate函数拼接:

这个只需要添加参数axis=1就可以了,axis默认是为0,按照行拼接。

先生产测试数组

# np 的运算

n = np.arange(1,17)

转化形态:

n0 = n.reshape(4,4)变成4x4的矩阵

array([[ 1, 2, 3, 4],

[ 5, 6, 7, 8],

[ 9, 10, 11, 12],

[13, 14, 15, 16]])

然后运用concatenate函数拼接:

np.concatenate((n0,n0),axis=1)

array([[ 1, 2, 3, 4, 1, 2, 3, 4], [ 5, 6, 7, 8, 5, 6, 7, 8], [ 9, 10, 11, 12, 9, 10, 11, 12], [13, 14, 15, 16, 13, 14, 15, 16]])

这个只需要添加参数axis=1就可以了,axis默认是为0,按照行拼接。

np.concatenate((n0,n0),axis=1)

array([[ 1, 2, 3, 4],收起阅读 »

[ 5, 6, 7, 8],

[ 9, 10, 11, 12],

[13, 14, 15, 16],

[ 1, 2, 3, 4],

[ 5, 6, 7, 8],

[ 9, 10, 11, 12],

[13, 14, 15, 16]])

Django2.0+ 加载本地JS文件 配置

搜索网络上的,貌似有几种方案,不过都是坑,运行返回404,无法找到js文件的。 以下是自己亲测车工的。

本地调试,把JS存放本地,可以加快调试速度,不然每次都从CDN上取,影响效率,且无法离线运行

(没有网络的情况下)。

环境:python3.6 + Django 2.1.5

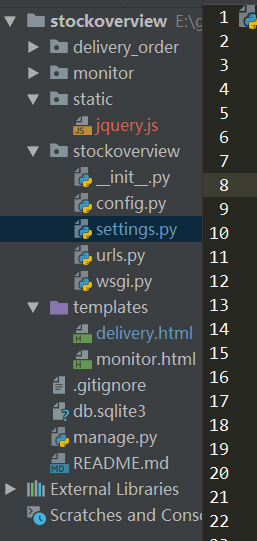

文件结构:

在django项目根目录,创建一个static的目录,里面存放一个jquery.js 的文件(这个文件可以到官方下载),然后在settings.py里面配置:

setting.py

然后在模板文件 test.html中引用:

然后重新运行django,就可以了。 收起阅读 »

本地调试,把JS存放本地,可以加快调试速度,不然每次都从CDN上取,影响效率,且无法离线运行

(没有网络的情况下)。

环境:python3.6 + Django 2.1.5

文件结构:

在django项目根目录,创建一个static的目录,里面存放一个jquery.js 的文件(这个文件可以到官方下载),然后在settings.py里面配置:

setting.py

STATIC_URL = '/static/'

STATICFILES_DIRS = (

os.path.join(BASE_DIR, 'static/'),

)

然后在模板文件 test.html中引用:

<!DOCTYPE html>

{% load staticfiles %}

<html lang="en">

<head>

<meta charset="UTF-8">

<title>交割单查询</title>

<script type="text/javascript" src="{% static 'jquery.js' %}"></script>

然后重新运行django,就可以了。 收起阅读 »

发现一个好玩的python脚本,你家小公主一定喜欢哈

#coding:utf-8

from turtle import *

def nose(x,y):#鼻子

penup()#提起笔

goto(x,y)#定位

pendown()#落笔,开始画

setheading(-30)#将乌龟的方向设置为to_angle/为数字(0-东、90-北、180-西、270-南)

begin_fill()#准备开始填充图形

a=0.4

for i in range(120):

if 0<=i<30 or 60<=i<90:

a=a+0.08

left(3) #向左转3度

forward(a) #向前走a的步长

else:

a=a-0.08

left(3)

forward(a)

end_fill()#填充完成

penup()

setheading(90)

forward(25)

setheading(0)

forward(10)

pendown()

pencolor(255,155,192)#画笔颜色

setheading(10)

begin_fill()

circle(5)

color(160,82,45)#返回或设置pencolor和fillcolor

end_fill()

penup()

setheading(0)

forward(20)

pendown()

pencolor(255,155,192)

setheading(10)

begin_fill()

circle(5)

color(160,82,45)

end_fill()

def head(x,y):#头

color((255,155,192),"pink")

penup()

goto(x,y)

setheading(0)

pendown()

begin_fill()

setheading(180)

circle(300,-30)

circle(100,-60)

circle(80,-100)

circle(150,-20)

circle(60,-95)

setheading(161)

circle(-300,15)

penup()

goto(-100,100)

pendown()

setheading(-30)

a=0.4

for i in range(60):

if 0<=i<30 or 60<=i<90:

a=a+0.08

lt(3) #向左转3度

fd(a) #向前走a的步长

else:

a=a-0.08

lt(3)

fd(a)

end_fill()

def ears(x,y): #耳朵

color((255,155,192),"pink")

penup()

goto(x,y)

pendown()

begin_fill()

setheading(100)

circle(-50,50)

circle(-10,120)

circle(-50,54)

end_fill()

penup()

setheading(90)

forward(-12)

setheading(0)

forward(30)

pendown()

begin_fill()

setheading(100)

circle(-50,50)

circle(-10,120)

circle(-50,56)

end_fill()

def eyes(x,y):#眼睛

color((255,155,192),"white")

penup()

setheading(90)

forward(-20)

setheading(0)

forward(-95)

pendown()

begin_fill()

circle(15)

end_fill()

color("black")

penup()

setheading(90)

forward(12)

setheading(0)

forward(-3)

pendown()

begin_fill()

circle(3)

end_fill()

color((255,155,192),"white")

penup()

seth(90)

forward(-25)

seth(0)

forward(40)

pendown()

begin_fill()

circle(15)

end_fill()

color("black")

penup()

setheading(90)

forward(12)

setheading(0)

forward(-3)

pendown()

begin_fill()

circle(3)

end_fill()

def cheek(x,y):#腮

color((255,155,192))

penup()

goto(x,y)

pendown()

setheading(0)

begin_fill()

circle(30)

end_fill()

def mouth(x,y): #嘴

color(239,69,19)

penup()

goto(x,y)

pendown()

setheading(-80)

circle(30,40)

circle(40,80)

def body(x,y):#身体

color("red",(255,99,71))

penup()

goto(x,y)

pendown()

begin_fill()

setheading(-130)

circle(100,10)

circle(300,30)

setheading(0)

forward(230)

setheading(90)

circle(300,30)

circle(100,3)

color((255,155,192),(255,100,100))

setheading(-135)

circle(-80,63)

circle(-150,24)

end_fill()

def hands(x,y):#手

color((255,155,192))

penup()

goto(x,y)

pendown()

setheading(-160)

circle(300,15)

penup()

setheading(90)

forward(15)

setheading(0)

forward(0)

pendown()

setheading(-10)

circle(-20,90)

penup()

setheading(90)

forward(30)

setheading(0)

forward(237)

pendown()

setheading(-20)

circle(-300,15)

penup()

setheading(90)

forward(20)

setheading(0)

forward(0)

pendown()

setheading(-170)

circle(20,90)

def foot(x,y):#脚

pensize(10)

color((240,128,128))

penup()

goto(x,y)

pendown()

setheading(-90)

forward(40)

setheading(-180)

color("black")

pensize(15)

fd(20)

pensize(10)

color((240,128,128))

penup()

setheading(90)

forward(40)

setheading(0)

forward(90)

pendown()

setheading(-90)

forward(40)

setheading(-180)

color("black")

pensize(15)

fd(20)

def tail(x,y):#尾巴

pensize(4)

color((255,155,192))

penup()

goto(x,y)

pendown()

seth(0)

circle(70,20)

circle(10,330)

circle(70,30)

def setting(): #参数设置

pensize(4)

hideturtle() #使乌龟无形(隐藏)

colormode(255) #将其设置为1.0或255.随后 颜色三元组的r,g,b值必须在0 .. cmode范围内

color((255,155,192),"pink")

setup(840,500)

speed(10)

def main():

setting() #画布、画笔设置

nose(-100,100) #鼻子

head(-69,167) #头

ears(0,160) #耳朵

eyes(0,140) #眼睛

cheek(80,10) #腮

mouth(-20,30) #嘴

body(-32,-8) #身体

hands(-56,-45) #手

foot(2,-177) #脚

tail(148,-155) #尾巴

done()

if __name__ == '__main__':

main()

安装turtle

pip install turtle

然后运行上面代码即可哈。

收起阅读 »

CryptoJS.enc.UTF8 中文乱码

最近在破解的JS的时候,遇到一个乱码问题。

内容用CryptoJS解密出来的,解出来是一个HTML格式的文本,标签,英文是正常显示的,但是中文是乱码的。

demo:

用“中国人”就还原不了

调试中。

待更新。

已解决:

看大佬最近几期文章,有一篇解决了,就是去Python目录下lib文件夹里面dsubprocess.py

文件下更改encding为UTF-8, 收起阅读 »

内容用CryptoJS解密出来的,解出来是一个HTML格式的文本,标签,英文是正常显示的,但是中文是乱码的。

demo:

# data='中国人'data用hello可以解密成功,

data='hello'

ret = CryptoJS.AES.encrypt(data,'secret key 123')

content = ret.toString()

result = CryptoJS.AES.decrypt(content,'secret key 123')

print(result.toString(CryptoJS.enc.Utf8))

用“中国人”就还原不了

调试中。

待更新。

已解决:

看大佬最近几期文章,有一篇解决了,就是去Python目录下lib文件夹里面dsubprocess.py

文件下更改encding为UTF-8, 收起阅读 »

missing 1 required positional argument on_delete --Django2.0

Django2.0+

使用ForeignKey 报错

TypeError: __init__() missing 1 required positional argument: 'on_delete'

解决办法:

定义ForeignKey的时候添加参数on_delete,然后需要重新migration model,不然还是会报错。

(如果还是不行,把migration文件夹的内容全部删掉,在migrated一下) 收起阅读 »

使用ForeignKey 报错

TypeError: __init__() missing 1 required positional argument: 'on_delete'

解决办法:

from django.db import models

class Article(models.Model):

category = models.ForeignKey('Category', on_delete=models.PROTECT)

title = models.CharField(max_length=55)

# ...

def __str__(self):

return self.title

定义ForeignKey的时候添加参数on_delete,然后需要重新migration model,不然还是会报错。

(如果还是不行,把migration文件夹的内容全部删掉,在migrated一下) 收起阅读 »

pyecharts真的是一个神一样的库

可视化太牛x了!!! 感叹一下国内的大牛。

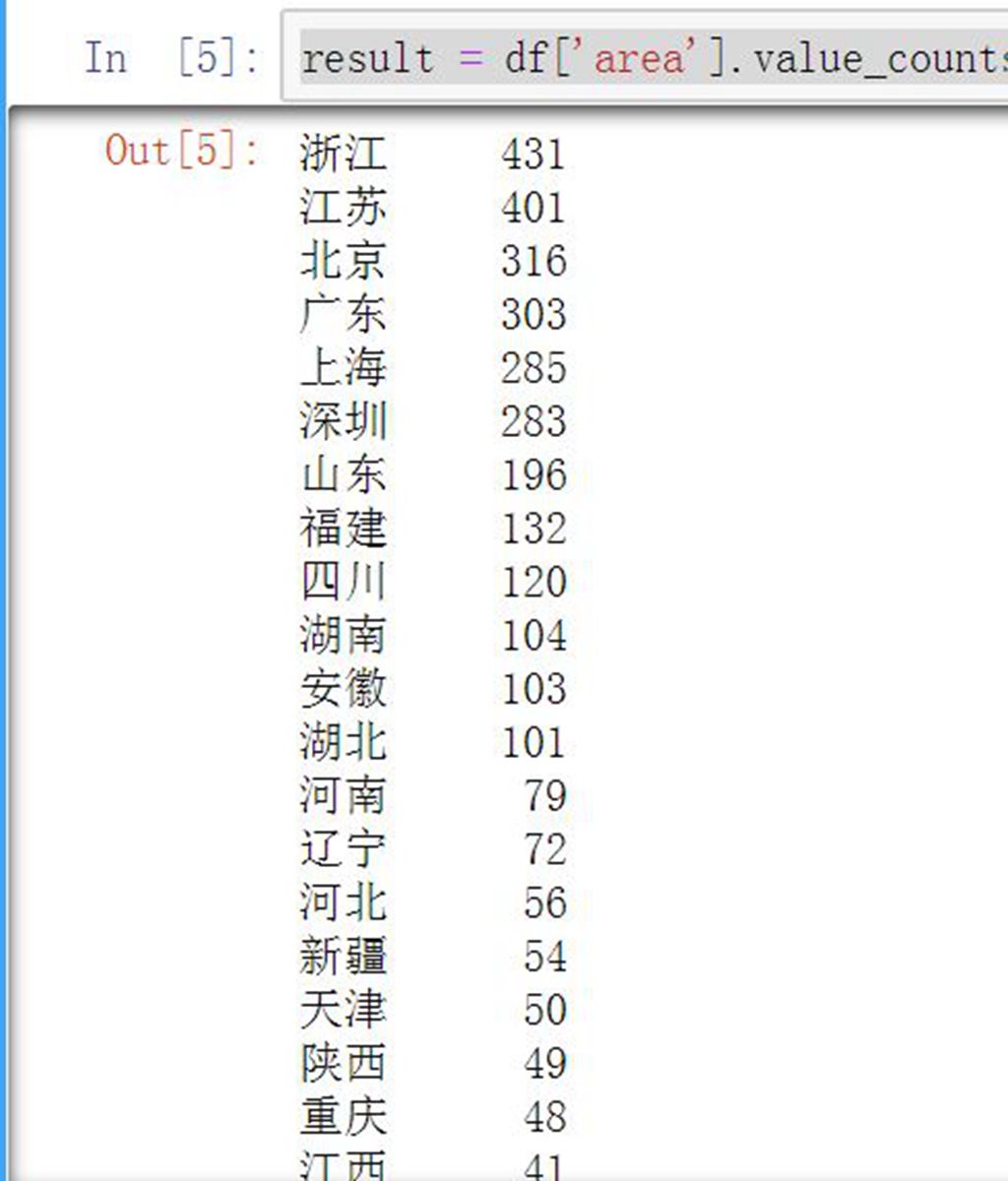

python数据分析之 A股上市公司按地区分布与可视化 地图显示

首先传统方法是使用数据库:

地区 数目

浙江 431

江苏 401

北京 316

广东 303

上海 285

深圳 283

山东 196

福建 132

四川 120

湖南 104

安徽 103

湖北 101

河南 79

辽宁 72

河北 56

新疆 54

天津 50

陕西 49

重庆 48

吉林 41

江西 41

山西 38

黑龙江 37

广西 37

云南 33

甘肃 33

海南 31

贵州 29

内蒙 25

西藏 18

宁夏 13

青海 12

看看我们的641主席的功劳,江浙一带的上市公司数量已经超过广东了。

接下来我们使用pandas进行数据可视化:

首先读入数据:

然后直接统计:

看是不是比mysql语句简单多了?

得到一样的数据。

接下来使用图像来显示我们的数据:

什么? 一条命令就可以啦~ 实在太强大了!

从这个柱状图上,可以更加直观地看到A股上市公司的分布情况,东部长三角和珠三角的公司数目最多。而西部只有东部的零头。

接着把数据转化为百分比数据:

可以看到江浙地区占了22%的数量,体量还是很大的。

接下来,为了数据更加直观,把数据在地图上显示出来:

点击查看大图

颜色越红,表明上市公司越多。现在数据够直观了吧。

实现代码:

更多的数据分析,请关注本网站。

不定期更新哦

原创文章

转载请注明出处:

http://30daydo.com/article/388

收起阅读 »

SELECT area `地区`,count(*) as `数目` FROM `tb_basic_info` GROUP BY area order by 数目 desc;得到下面的结果: 接着我们使用pandas进行数据可视化。

地区 数目

浙江 431

江苏 401

北京 316

广东 303

上海 285

深圳 283

山东 196

福建 132

四川 120

湖南 104

安徽 103

湖北 101

河南 79

辽宁 72

河北 56

新疆 54

天津 50

陕西 49

重庆 48

吉林 41

江西 41

山西 38

黑龙江 37

广西 37

云南 33

甘肃 33

海南 31

贵州 29

内蒙 25

西藏 18

宁夏 13

青海 12

看看我们的641主席的功劳,江浙一带的上市公司数量已经超过广东了。

接下来我们使用pandas进行数据可视化:

首先读入数据:

# A股上市公司分布:engine为from sqlalchemy import create_engine 中的连接引擎。

df = pd.read_sql('tb_basic_info',con=engine)

然后直接统计:

result = df['area'].value_counts()得到的result就是统计结果:看是不是比mysql语句简单多了?

得到一样的数据。

接下来使用图像来显示我们的数据:

什么? 一条命令就可以啦~ 实在太强大了!

从这个柱状图上,可以更加直观地看到A股上市公司的分布情况,东部长三角和珠三角的公司数目最多。而西部只有东部的零头。

接着把数据转化为百分比数据:

total = result.sum()

ration = result/total*100

可以看到江浙地区占了22%的数量,体量还是很大的。

接下来,为了数据更加直观,把数据在地图上显示出来:

点击查看大图

颜色越红,表明上市公司越多。现在数据够直观了吧。

实现代码:

# 热力图

def create_heatmap(attr,value,name,maptype):

style = Style(title_color="#fff", title_pos="center",

width=1200, height=600, background_color="#696969")

# 可视化

geo = Geo(name,**style.init_style)

geo.add("", attr, value, visual_range=[min(value), max(value)], symbol_size=8,

visual_text_color="#000",

is_visualmap=True, type='effectScatter',effect_scale=7,is_random=True,is_roam=False,is_piecewise = True,visual_split_number= 10,

)

geo.render('{}.html'.format(name))

create_heatmap(attr,value,'公司分布','china')

更多的数据分析,请关注本网站。

不定期更新哦

原创文章

转载请注明出处:

http://30daydo.com/article/388

收起阅读 »

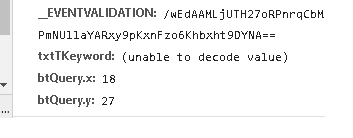

浏览器抓包post字段里面有 (unable to decode value) ,requests如何正确的post

在浏览器F12的抓包信息里面看到如下的数据:

数据是通过post形式提交的, 字段txtTKeyword无法显示,看来是用了其他的编码导致了浏览器无法识别。

可以使用fiddler工具查看。

在python中用代码直接编码后post,不然服务器无法识别提交的数据

注意不需要用 urllib.parse.quote(uncode_str),直接encode就可以(特殊情况特殊处理,有些网站就是奇怪)

收起阅读 »

数据是通过post形式提交的, 字段txtTKeyword无法显示,看来是用了其他的编码导致了浏览器无法识别。

可以使用fiddler工具查看。

在python中用代码直接编码后post,不然服务器无法识别提交的数据

注意不需要用 urllib.parse.quote(uncode_str),直接encode就可以(特殊情况特殊处理,有些网站就是奇怪)

s='耐克球鞋'

s =s.encode('gb2312')

data = {'__VIEWSTATE': view_state,

'__EVENTVALIDATION': event_validation,

'txtTKeyword': s,

'btQuery.x': 41,

'btQuery.y': 24,

}

r = session.post(url=self.base_url, headers=headers,

data=data,proxies=self.get_proxy()

收起阅读 »

randint python 的用法

官方的文档:

random.randint(a, b)

Return a random integer N such that a <= N <= b.

返回一个a到b之间的整数,包括a和b。

random.randint(a, b)

Return a random integer N such that a <= N <= b.

返回一个a到b之间的整数,包括a和b。

有道云笔记对markdown文档支持不友好

虽然最新版的有道云笔记支持markdown文档,可是无论是打开还是搜索,会导致笔记卡死,载入非常的慢。

在滚动栏里面,如果滚动到有markdown文档的地方,会导致文章列表上下的内容都会显示同一个文档的内容。

希望有道能越做越好吧~

在滚动栏里面,如果滚动到有markdown文档的地方,会导致文章列表上下的内容都会显示同一个文档的内容。

希望有道能越做越好吧~

python 代码获取mongodb数据库下所有的collection 文档名字

获取一个数据库下所有的collection 文档

db['db_pledge'].collection_names()

db['db_pledge'].list_collection_names()

21cn邮箱每天还限制发送邮件的次数

注册了一个来发送邮件推送,居然还限制每天的发件次数,每天大概只能发10封左右,都没用户的邮箱域名了,还做这么多限制,正所谓不作死就不会死。

永别21cn

永别21cn

可转债正股的PB<1时,可转债不可以下调转股价

“修正后的转股价格应不低于审议上述方案的股东大会召开日前二十个交易日公司A股股票交易均价,同时修正后的转股价格不低于最近一期经审计的每股净资产和股票面值。”

这是大部分转债“转股价格特别修正条款”的标准表述。

这是大部分转债“转股价格特别修正条款”的标准表述。

批量获取Grequests返回内容

Grequests是一个异步requests的封装库。

如何批量获取Grequests返回内容?

注意,上面的写法是错误的!!!!!!

grequests.get只能接受url!!! 不能放入一个函数。

正确的写法:

具体的对response内容操作放入到market_watch函数中。

收起阅读 »

如何批量获取Grequests返回内容?

import grequests

import requests

import bs4

def simple_request(url):

page = requests.get(url)

return page

urls = [

'http://www.heroku.com',

'http://python-tablib.org',

'http://httpbin.org',

'http://python-requests.org',

'http://kennethreitz.com'

]

rs = [grequests.get(simple_request(u)) for u in urls]

grequests.map(rs)

注意,上面的写法是错误的!!!!!!

grequests.get只能接受url!!! 不能放入一个函数。

正确的写法:

rs = (grequests.get(u) for u in urls)

requests = grequests.map(rs)

for response in requests:

market_watch(response.content)

具体的对response内容操作放入到market_watch函数中。

收起阅读 »

工具与网站分享 <转>

技术站点

Hacker News:非常棒的针对编程的链接聚合网站

Programming reddit:同上

MSDN:微软相关的官方技术集中地,主要是文档类

infoq:企业级应用,关注软件开发领域

OSChina:开源技术社区,开源方面做的不错哦

cnblogs,51cto,csdn:常见的技术社区,各有专长

stackoverflow:IT技术问答网站

GitHub:全球最大的源代码管理平台,很多知名开源项目都在上面,如Linux内核,

OpenStack等免费的it电子书:http://it-ebooks.info/

DevStore:开发者服务商店

不错的书籍

人件

人月神话

代码大全2

计算机程序设计艺术

程序员的自我修养

程序员修炼之道

高效能程序员的修炼(成为一名杰出的程序员其实跟写代码没有太大关系)

深入理解计算机系统

软件随想录

算法导论(麻省理工学院出版社)

离线数学及其应用

设计模式

编程之美

黑客与画家

编程珠玑

C++ Prime

Effective C++

TCP/IP详解

Unix 编程艺术

《精神分析引论》弗洛伊德

搞定:无压力工作的艺术

平台工具(都是开源的好东东哦)

Redmine/Trac:项目管理平台

Jenkins/Jira(非开源):持续集成系统(Apache Continuum,这个是Apache下的CI系统,还没来得及研究)

Sonar:代码质量管理平台

git,svn:源代码版本控制系统

GitLib/Gitorious:构建自己的GitHub服务器

gitbook:https://www.gitbook.io/写书的好东西,当然用来写文档也很不错的

Travis-ci:开源项目持续集成必备,和GitHub相结合,https://travis-ci.org/

开源测试工具、社区(Selenium、OpenQA.org)

Puppet:一个自动管理引擎,可以适用于Linux、Unix以及Windows平台。所谓配置管理系统,就是管理机器里面诸如文件、用户、进程、软件包这些资源。无论是管理1台,还是上万台机器Puppet都能轻松搞定。

Nagios:系统状态监控报警,还有个Icinga(完全兼容nagios所有的插件,工作原理,配置文件以及方法,几乎一模一样。配置简单,功能强大)

Ganglia:分布式监控系统

fleet:分布式init系统

爬虫相关(好玩的工具)

Phantomjs

berserkJS(基于Phantomjs的改进版本)

SlimerJS

CasperJS

selenium

Web 服务器性能/压力测试工具/负载均衡器

http_load: 程序非常小,解压后也不到100K

webbench: 是Linux下的一个网站压力测试工具,最多可以模拟3万个并发连接去测试网站的负载能力

ab: ab是apache自带的一款功能强大的测试工具

Siege: 一款开源的压力测试工具,可以根据配置对一个WEB站点进行多用户的并发访问,记录每个用户所有请求过程的相应时间,并在一定数量的并发访问下重复进行。

squid(前端缓存),nginx(负载),nodejs(没错它也可以,自己写点代码就能实现高性能的负载均衡器):常用的负载均衡器

Piwik:开源网站访问量统计系统

ClickHeat:开源的网站点击情况热力图

HAProxy:高性能TCP /HTTP负载均衡器

ElasticSearch:搜索引擎基于Lucene

Page Speed SDK和YSLOW

HAR Viewer: HAR分析工具

protractor:E2E(end to end)自动化测试工具

Web 前端相关

GRUNT: js task runner

Sea.js: js模块化

knockout.js:MVVM开发前台,绑定技术

Angular.js: 使用超动感HTML & JS开发WEB应用!

Highcharts.js,Flot:常用的Web图表插件

Raw:非常不错的一款高级数据可视化工具

Rickshaw:时序图标库,可用于构建实时图表

JavaScript InfoVis Toolkit:另一款Web数据可视化插件

Pdf.js,在html中展现pdf

ACE,CodeMirror:Html代码编辑器(ACE甚好啊)

NProcess:绚丽的加载进度条

impress.js:让你制作出令人眩目的内容展示效果(类似的还有reveal)

Threejs:3DWeb库

Hightopo:基于Html5的2D、3D可视化UI库

jQuery.dataTables.js:高度灵活的表格插件

Raphaël:js,canvas绘图库,后来发现百度指数的图形就是用它绘出来的

director.js:js路由模块,前端路由,Nodejs后端路由等,适合构造单页应用

pace.js:页面加载进度条

bower:Web包管理器

jsnice:有趣的js反编译工具,猜压缩后的变量名 http://www.jsnice.org/

D3.js: 是一个基于JavaScript数据展示库(类似的还有P5.js)

Zepto.js:移动端替代jQuery的东东,当然也可以使用jquery-mobile.

UI框架:Foundation,Boostrap,Pure,EasyUI,Polymer

前端UI设计师必去的几个网站:Dribbble,awwwards,unmatchedstyle,UIMaker

Mozilla 开发者中心:https://developer.mozilla.org/en-US/

图标资源:IcoMoon(我的最爱),Themify Icons,FreePik,Glyphiconsart

Dialog:非常漂亮的对话框

AdminLTE:github上的一个开源项目,基于Boostrap3的后台管理页面框架

Respond.js:让不懂爱的IE6-8支持响应式设计

require.js: js模块加载库

select2:比chosen具有更多特性的选择框替代库

AngularUI:集成angular.js的UI库

normalize.css: 采用了现代化标准让各浏览器渲染出的html保持一致的库

CreateJS:Html5游戏引擎Less,Compass:简化CSS开发

emojify.js:用于自动识别网页上的Emoji文字并将其显示为图像

simditor:一个不错的开源的html编辑器,简洁高效

Sencha: 基于html5的移动端开发框架

SuperScrollorama+TweenMax+skrollr:打造超酷的视差滚动效果网页动画

jquery-smooth-scroll:同上,平滑滚动插件

Animate.css:实现了各种动画效果的css库

Emmet:前端工程师必备,ZenCode的前身

MagicDraw:Uml图工具

大数据处理/数据分析/分布式工具

Hadoop:分布式的文件系统,结合其MapReduce编程模型可以用来做海量数据的批处理(Hive,Pig,HBase啥的就不说了),值得介绍的是Cloudera的Hadoop分支CDH5,基于YARN MRv2集成了Spark可直接用于生产环境的Hadoop,对于企业快速构建数据仓库非常有用。

Ceph:Linux分布式文件系统(特点:无中心)

Storm:实时流数据处理,可以看下IBM的一篇介绍 (还有个Yahoo的S4,也是做流数据处理的)

Spark:大规模流式数据处理(可以应付企业中常见的三种数据处理场景:复杂的批量数据处理(batch data processing);基于历史数据的交互式查询(interactive query);基于实时数据流的数据处理(streaming data processing)),CSND有篇文章介绍的不错

Spark Streaming:基于Spark的实时计算框架

Tachyon:分布式内存文件系统

Mesos:计算框架一个集群管理器,提供了有效的、跨分布式应用或框架的资源隔离和共享Impala:新一代开源大数据分析引擎,提供Sql语义,比- Hive强在速度上

SNAPPY:快速的数据压缩系统,适用于Hadoop生态系统中

Kafka:高吞吐量的分布式消息队列系统

ActiveMQ:是Apache出品,最流行的,能力强劲的开源消息总线

MQTT:Message Queuing Telemetry Transport,消息队列遥测传输)是IBM开发的一个即时通讯协议,有可能成为物联网的重要组成部分

RabbitMQ:记得OpenStack就是用的这个东西吧

ZeroMQ:宣称是将分布式计算变得更简单,是个分布式消息队列,可以看下云风的一篇文章的介绍开源的日志收集系统:scribe、chukwa、kafka、flume。这有一篇对比文章

Zookeeper:可靠的分布式协调的开源项目

Databus:LinkedIn 实时低延迟数据抓取系统

数据源获取:Flume、Google Refine、Needlebase、ScraperWiki、BloomReach

序列化技术:JSON、BSON、Thrift、Avro、Google Protocol Buffers

NoSql:Apache Hadoop、Apache Casandra、MongoDB、Apache CouchDB、Redis、BigTable、HBase、Hypertable、Voldemort、Neo4j

MapReduce相关:Hive、Pig、Cascading、Cascalog、mrjob、Caffeine、S4、MapR、Acunu、Flume、Kafka、Azkaban、Oozie、Greenplum

数据处理:R、Yahoo! Pipes、Mechanical Turk、Solr/ Lucene、ElasticSearch、Datameer、Bigsheets、TinkerpopNLP自然语言处理:Natural Language Toolkit、Apache OpenNLP、Boilerpipe、OpenCalais

机器学习:WEKA、Mahout、scikits.learn、SkyTree

可视化技术:GraphViz、Processing、Protovis、Google Fusion Tables、Tableau、Highcharts、EChats(百度的还不错)、Raphaël.js

Kettle:开源的ETL工具

Pentaho:以工作流为核心的开源BI系统

Mondrian:开源的Rolap服务器

Oozie:开源hadoop的工作流调度引擎

开源的数据分析可视化工具:Weka、Orange、KNIME

Cobar:阿里巴巴的MySql分布式中间件

C & C++

Thrift:用来进行可扩展且跨语言的服务的开发(类似的还有个Avro,Google protobuf)。

libevent:是一个事件触发的网络库,适用于windows、linux、bsd等多种平台,内部使用select、epoll、kqueue等系统调用管理事件机制。(对了还有个libev呢)

Boost:不多说了,准C++标准库

Ptmalloc\Valgrind\Purify

NetworkServer架构:acceptor->dispatcher->worker(这个不算工具哦)

breakpad:崩溃转储和分析模块,很多crashreport会用到

UI界面相关:MFC、BCG和QT这类的就不说了,高端一点的还有Html和DirectUI技术:libcef(基于chrome内核的,想想使用html5开发页面,还真有点小激动呢)、HtmlLayout、Duilib、Bolt,非C++的,还有node-webkit也不错,集成了node和webkit内核。

游戏开发相关

MINA:使用Java开发手游和页游服务器(对了还有Netty,也很猛的,都是基于NIO的)

HP-Socket:见有有些页游服务器使用这个构建的

云风的技术博客:http://blog.codingnow.com/

OGRE:大名鼎鼎的3D图形渲染引擎

OpenVDB:梦工厂C++的特效库,开源的

cocos2d:跨平台2D游戏引擎

unity3d:跨平台3D游戏引擎,很火的哦

Nodejs:也有不少使用它来开发手游和也有服务器(网易的Pomelo就是哦)

日志聚合,分布式日志收集

Scribe:Facebook的(nodejs + scribe + inotify 同步日志)

logstash:强大的日志收集系统,可以基于logstash+kibana+elasticsearch+redis开发强大的日志分析平台

log.io: nodejs开发的实时日志收集系统

RTP,实时传输协议与音视频

RTP,RTCP,RTSP-> librtp,JRTPLIB(遵循了RFC1889标准)

环形缓冲区,实时数据传输用

SDL,ffmpeg,live555,Speex

Red5:用Java开发开源的Flash流媒体服务器。它支持:把音频(MP3)和视频(FLV)转换成播放流; 录制客户端播放流(只支持FLV);共享对象;现场直播流发布;远程调用。

Python

Eric,Eclipse+pydev,比较不错的Python IDE

PyWin:Win32 api编程包

numpy:科学计算包,主要用来处理大型矩阵计算等,此外还有SciPy,Matplotlib

GUI相关:PyQt,PyQwt

supervisor:进程监控工具

Java相关

常用的IDE:IntelliJ IDEA,Eclipse,Netbeans

Web开发相关:Tomcat、Resin、Jetty、WebLogic等,常用的组件Struts,Spring

HibernateNetty: 异步事件驱动网络应用编程框架,用于高并发网络编程比较好(NIO框架)

MINA:简单地开发高性能和高可靠性的网络应用程序(也是个NIO框架),不少手游服务端是用它开发的

jOOQ:java Orm框架Activiti:工作流引擎,类似的还有jBPM、Snaker

Perfuse:是一个用户界面包用来把有结构与无结构数据以具有交互性的可视化图形展示出来.

Gephi:复杂网络分析软件, 其主要用于各种网络和复杂系统,动态和分层图的交互可视化与探测开源工具

Nutch:知名的爬虫项目,hadoop就是从这个项目中发展出来的

web-harvest:Web数据提取工具

POM工具:Maven+ArtifactoryNetflix

Curator:Netflix公司开源的一个Zookeeper client library,用于简化Zookeeper客户端编程

Akka:一款基于actor模型实现的 并发处理框架

EclEmma:覆盖测试工具

.net相关

Xilium.CefGlue:基于CEF框架的.NET封装,基于.NET开发Chrome内核浏览器

CefSharp:同上,有一款WebKit的封装,C#和Js交互会更简单

netz:免费的 .NET 可执行文件压缩工具

SmartAssembly:变态的.net代码优化混淆工具

NETDeob0:.net反混淆工具,真是魔高一尺道高一丈啊(还有个de4dot,在GitHub上,都是开源的)

ILMerge:将所有引用的DLL和exe文件打成一个exe文件

ILSpy:开源.net程序反编译工具

Javascript.NET:很不错的js执行引擎,对v8做了封装

NPOI: Excel操作

DotRAS:远程访问服务的模块

WinHtmlEditor: Winform下的html编辑器

SmartThreadPool:使用C#实现的,带高级特性的线程池

Snoop: WPF Spy Utility

Autofac: 轻量级IoC框架

HtmlAgilityPack:Html解析利器

Quartz.NET:Job调度

HttpLib:@CodePlex,简化http请求

SuperSocket:简化Socket操作,基于他的还有个SuperWebSocket,可以开发独立的WebSocket服务器了

DocX:未安装Office的情况下操作Word文件

Dapper:轻量级的ORM类,性能不错

HubbleDotNet:支持接入数据库的全文搜索系统

fastJSON:@CodeProject,高性能的json序列化类

ZXing.NET:@CodePlex,QR,条形码相关

Nancy:轻量级Http服务器,做个小型的Web应用可以摆脱IIS喽(Nancy.Viewengines.Razor,可以加入Razor引擎)

AntiXSS:微软的XSS防御库Microsoft Web Protection

LibraryJint:JavaScript解释器

CS-Script:将C#代码文件作为脚本执行

Jexus:Linux下 高性能、易用、免费的ASP.NET服务器

Clay:将dynamic发挥的更加灵活,像写js一样写C#

DynamicJSON:不必定义数据模型获取json数据

Antlr:开源的语法分析器(归到C#不太合适,其他语言也可以去用)

SharpPcap:C#版的WinPcap调用端,牛逼的网络包分析库(自带PacketNotNet用于包协议分析)

Roslyn:C#,VB编译器

ImageResizer: 服务端自由控制图片大小,真乃神器也,对手机端传小图,PC端传大图,CMS用它很方便

UI相关:DevExpress, Fluent(Office 07风格), mui(Modern UI for WPF)

NetSparkle:应用自动更新组件

ConfuserEx: 开源.net混淆工具

ServiceStack: 开源高性能Web服务框架,可用于构建高性能的REST服务Expression

Evaluator:Eval for C#,处理字符串表达式

http://nugetmusthaves.com/

常用工具

Fiddler:非常好用的Web前端调试工具,当然是针对底层http协议的,一般情况使用Chrome等自带的调试工具也足够了,特殊情况还得用它去处理

wireshark:知名的网络数据包分析工具

PowerCmd:替代Windows Cmd的利器

RegexBuddy:强大的正则表达式测试工具

Soure Insight:源代码阅读神器

SublimeText:程序员最爱的编辑器

Database.NET:一个通用的关系型数据库客户端,基于.NET 4.0开发的,做简单的处理还是蛮方便的

Navicat Premium:支持MySql、PostgreSQL、Oracle、Sqlite和SQL Server的客户端,通用性上不如

Database.NET,但性能方面比Database.NET好很多,自带备份功能也用于数据库定时备份。

Synergy : 局域网内一套键盘鼠标控制多台电脑

DameWare:远程协助工具集(我在公司主要控制大屏幕用)

Radmin: 远程控制工具,用了一段时间的

DameWare,还要破解,对Win7支持的不好,还是发现这个好用

Listary:能极大幅度提高你 Windows 文件浏览与搜索速度效率的「超级神器」

Clover:给资源管理器加上多标签

WinLaunch:模拟Mac OS的Launch工具

Fritzing:绘制电路图

LICEcap:gif教程制作git,

svn:版本控制系统Enigma Virtual Box(将exe,dll等封装成一个可执行程序)

Open DBDiff(针对SqlServer)数据库同步

SymmetricDS:数据库同步

BIEE,Infomatica,SPSS,weka,R语言:数据分析

CodeSmith,LightSwitch:代码生成

Pandoc:Markdown转换工具,出书用的。以前玩过docbook,不过现在还是Markdown盛行啊。

Window Magnet[Mac]:增强Mac窗口管理功能,想Win7一样具有窗口拖放到屏幕边缘自动调整的功能

log explorer:查看SqlServer日志dependency

walker:查询Windows应用程序dll依赖项

Shairport4w:将iPhone,iPad,iPod上的音频通过AirPlay协议传输到PC上

ngrok:内网穿透工具Axure:快速原型制作工具,还有个在线作图的工具国内的一个创业团队做的,用着很不错 http://www.processon.com

tinyproxy:(Linux)小型的代理服务器支持http和https协议EaseUS Partition

Master:超级简单的分区调整工具,速度还是蛮快的,C盘不够用了就用它从D盘划点空间吧,不用重装系统这么折腾哦。

CheatEngine:玩游戏修改内存值必备神器(记得我在玩轩辕剑6的时候就用的它,超级方便呢)

ApkIDE:Android反编译神器翻、墙工具(自|由|门、天行浏览器)

设计工具:Sketch、OmniGraffle

MindManger:思维导图 收起阅读 »

Hacker News:非常棒的针对编程的链接聚合网站

Programming reddit:同上

MSDN:微软相关的官方技术集中地,主要是文档类

infoq:企业级应用,关注软件开发领域

OSChina:开源技术社区,开源方面做的不错哦

cnblogs,51cto,csdn:常见的技术社区,各有专长

stackoverflow:IT技术问答网站

GitHub:全球最大的源代码管理平台,很多知名开源项目都在上面,如Linux内核,

OpenStack等免费的it电子书:http://it-ebooks.info/

DevStore:开发者服务商店

不错的书籍

人件

人月神话

代码大全2

计算机程序设计艺术

程序员的自我修养

程序员修炼之道

高效能程序员的修炼(成为一名杰出的程序员其实跟写代码没有太大关系)

深入理解计算机系统

软件随想录

算法导论(麻省理工学院出版社)

离线数学及其应用

设计模式

编程之美

黑客与画家

编程珠玑

C++ Prime

Effective C++

TCP/IP详解

Unix 编程艺术

《精神分析引论》弗洛伊德

搞定:无压力工作的艺术

平台工具(都是开源的好东东哦)

Redmine/Trac:项目管理平台

Jenkins/Jira(非开源):持续集成系统(Apache Continuum,这个是Apache下的CI系统,还没来得及研究)

Sonar:代码质量管理平台

git,svn:源代码版本控制系统

GitLib/Gitorious:构建自己的GitHub服务器

gitbook:https://www.gitbook.io/写书的好东西,当然用来写文档也很不错的

Travis-ci:开源项目持续集成必备,和GitHub相结合,https://travis-ci.org/

开源测试工具、社区(Selenium、OpenQA.org)

Puppet:一个自动管理引擎,可以适用于Linux、Unix以及Windows平台。所谓配置管理系统,就是管理机器里面诸如文件、用户、进程、软件包这些资源。无论是管理1台,还是上万台机器Puppet都能轻松搞定。

Nagios:系统状态监控报警,还有个Icinga(完全兼容nagios所有的插件,工作原理,配置文件以及方法,几乎一模一样。配置简单,功能强大)

Ganglia:分布式监控系统

fleet:分布式init系统

爬虫相关(好玩的工具)

Phantomjs

berserkJS(基于Phantomjs的改进版本)

SlimerJS

CasperJS

selenium

Web 服务器性能/压力测试工具/负载均衡器

http_load: 程序非常小,解压后也不到100K

webbench: 是Linux下的一个网站压力测试工具,最多可以模拟3万个并发连接去测试网站的负载能力

ab: ab是apache自带的一款功能强大的测试工具

Siege: 一款开源的压力测试工具,可以根据配置对一个WEB站点进行多用户的并发访问,记录每个用户所有请求过程的相应时间,并在一定数量的并发访问下重复进行。

squid(前端缓存),nginx(负载),nodejs(没错它也可以,自己写点代码就能实现高性能的负载均衡器):常用的负载均衡器

Piwik:开源网站访问量统计系统

ClickHeat:开源的网站点击情况热力图

HAProxy:高性能TCP /HTTP负载均衡器

ElasticSearch:搜索引擎基于Lucene

Page Speed SDK和YSLOW

HAR Viewer: HAR分析工具

protractor:E2E(end to end)自动化测试工具

Web 前端相关

GRUNT: js task runner

Sea.js: js模块化

knockout.js:MVVM开发前台,绑定技术

Angular.js: 使用超动感HTML & JS开发WEB应用!

Highcharts.js,Flot:常用的Web图表插件

Raw:非常不错的一款高级数据可视化工具

Rickshaw:时序图标库,可用于构建实时图表

JavaScript InfoVis Toolkit:另一款Web数据可视化插件

Pdf.js,在html中展现pdf

ACE,CodeMirror:Html代码编辑器(ACE甚好啊)

NProcess:绚丽的加载进度条

impress.js:让你制作出令人眩目的内容展示效果(类似的还有reveal)

Threejs:3DWeb库

Hightopo:基于Html5的2D、3D可视化UI库

jQuery.dataTables.js:高度灵活的表格插件

Raphaël:js,canvas绘图库,后来发现百度指数的图形就是用它绘出来的

director.js:js路由模块,前端路由,Nodejs后端路由等,适合构造单页应用

pace.js:页面加载进度条

bower:Web包管理器

jsnice:有趣的js反编译工具,猜压缩后的变量名 http://www.jsnice.org/

D3.js: 是一个基于JavaScript数据展示库(类似的还有P5.js)

Zepto.js:移动端替代jQuery的东东,当然也可以使用jquery-mobile.

UI框架:Foundation,Boostrap,Pure,EasyUI,Polymer

前端UI设计师必去的几个网站:Dribbble,awwwards,unmatchedstyle,UIMaker

Mozilla 开发者中心:https://developer.mozilla.org/en-US/

图标资源:IcoMoon(我的最爱),Themify Icons,FreePik,Glyphiconsart

Dialog:非常漂亮的对话框

AdminLTE:github上的一个开源项目,基于Boostrap3的后台管理页面框架

Respond.js:让不懂爱的IE6-8支持响应式设计

require.js: js模块加载库

select2:比chosen具有更多特性的选择框替代库

AngularUI:集成angular.js的UI库

normalize.css: 采用了现代化标准让各浏览器渲染出的html保持一致的库

CreateJS:Html5游戏引擎Less,Compass:简化CSS开发

emojify.js:用于自动识别网页上的Emoji文字并将其显示为图像

simditor:一个不错的开源的html编辑器,简洁高效

Sencha: 基于html5的移动端开发框架

SuperScrollorama+TweenMax+skrollr:打造超酷的视差滚动效果网页动画

jquery-smooth-scroll:同上,平滑滚动插件

Animate.css:实现了各种动画效果的css库

Emmet:前端工程师必备,ZenCode的前身

MagicDraw:Uml图工具

大数据处理/数据分析/分布式工具

Hadoop:分布式的文件系统,结合其MapReduce编程模型可以用来做海量数据的批处理(Hive,Pig,HBase啥的就不说了),值得介绍的是Cloudera的Hadoop分支CDH5,基于YARN MRv2集成了Spark可直接用于生产环境的Hadoop,对于企业快速构建数据仓库非常有用。

Ceph:Linux分布式文件系统(特点:无中心)

Storm:实时流数据处理,可以看下IBM的一篇介绍 (还有个Yahoo的S4,也是做流数据处理的)

Spark:大规模流式数据处理(可以应付企业中常见的三种数据处理场景:复杂的批量数据处理(batch data processing);基于历史数据的交互式查询(interactive query);基于实时数据流的数据处理(streaming data processing)),CSND有篇文章介绍的不错

Spark Streaming:基于Spark的实时计算框架

Tachyon:分布式内存文件系统

Mesos:计算框架一个集群管理器,提供了有效的、跨分布式应用或框架的资源隔离和共享Impala:新一代开源大数据分析引擎,提供Sql语义,比- Hive强在速度上

SNAPPY:快速的数据压缩系统,适用于Hadoop生态系统中

Kafka:高吞吐量的分布式消息队列系统

ActiveMQ:是Apache出品,最流行的,能力强劲的开源消息总线

MQTT:Message Queuing Telemetry Transport,消息队列遥测传输)是IBM开发的一个即时通讯协议,有可能成为物联网的重要组成部分

RabbitMQ:记得OpenStack就是用的这个东西吧

ZeroMQ:宣称是将分布式计算变得更简单,是个分布式消息队列,可以看下云风的一篇文章的介绍开源的日志收集系统:scribe、chukwa、kafka、flume。这有一篇对比文章

Zookeeper:可靠的分布式协调的开源项目

Databus:LinkedIn 实时低延迟数据抓取系统

数据源获取:Flume、Google Refine、Needlebase、ScraperWiki、BloomReach

序列化技术:JSON、BSON、Thrift、Avro、Google Protocol Buffers

NoSql:Apache Hadoop、Apache Casandra、MongoDB、Apache CouchDB、Redis、BigTable、HBase、Hypertable、Voldemort、Neo4j

MapReduce相关:Hive、Pig、Cascading、Cascalog、mrjob、Caffeine、S4、MapR、Acunu、Flume、Kafka、Azkaban、Oozie、Greenplum

数据处理:R、Yahoo! Pipes、Mechanical Turk、Solr/ Lucene、ElasticSearch、Datameer、Bigsheets、TinkerpopNLP自然语言处理:Natural Language Toolkit、Apache OpenNLP、Boilerpipe、OpenCalais

机器学习:WEKA、Mahout、scikits.learn、SkyTree

可视化技术:GraphViz、Processing、Protovis、Google Fusion Tables、Tableau、Highcharts、EChats(百度的还不错)、Raphaël.js

Kettle:开源的ETL工具

Pentaho:以工作流为核心的开源BI系统

Mondrian:开源的Rolap服务器

Oozie:开源hadoop的工作流调度引擎

开源的数据分析可视化工具:Weka、Orange、KNIME

Cobar:阿里巴巴的MySql分布式中间件

C & C++

Thrift:用来进行可扩展且跨语言的服务的开发(类似的还有个Avro,Google protobuf)。

libevent:是一个事件触发的网络库,适用于windows、linux、bsd等多种平台,内部使用select、epoll、kqueue等系统调用管理事件机制。(对了还有个libev呢)

Boost:不多说了,准C++标准库

Ptmalloc\Valgrind\Purify

NetworkServer架构:acceptor->dispatcher->worker(这个不算工具哦)

breakpad:崩溃转储和分析模块,很多crashreport会用到

UI界面相关:MFC、BCG和QT这类的就不说了,高端一点的还有Html和DirectUI技术:libcef(基于chrome内核的,想想使用html5开发页面,还真有点小激动呢)、HtmlLayout、Duilib、Bolt,非C++的,还有node-webkit也不错,集成了node和webkit内核。

游戏开发相关

MINA:使用Java开发手游和页游服务器(对了还有Netty,也很猛的,都是基于NIO的)

HP-Socket:见有有些页游服务器使用这个构建的

云风的技术博客:http://blog.codingnow.com/

OGRE:大名鼎鼎的3D图形渲染引擎

OpenVDB:梦工厂C++的特效库,开源的

cocos2d:跨平台2D游戏引擎

unity3d:跨平台3D游戏引擎,很火的哦

Nodejs:也有不少使用它来开发手游和也有服务器(网易的Pomelo就是哦)

日志聚合,分布式日志收集

Scribe:Facebook的(nodejs + scribe + inotify 同步日志)

logstash:强大的日志收集系统,可以基于logstash+kibana+elasticsearch+redis开发强大的日志分析平台

log.io: nodejs开发的实时日志收集系统

RTP,实时传输协议与音视频

RTP,RTCP,RTSP-> librtp,JRTPLIB(遵循了RFC1889标准)

环形缓冲区,实时数据传输用

SDL,ffmpeg,live555,Speex

Red5:用Java开发开源的Flash流媒体服务器。它支持:把音频(MP3)和视频(FLV)转换成播放流; 录制客户端播放流(只支持FLV);共享对象;现场直播流发布;远程调用。

Python

Eric,Eclipse+pydev,比较不错的Python IDE

PyWin:Win32 api编程包

numpy:科学计算包,主要用来处理大型矩阵计算等,此外还有SciPy,Matplotlib

GUI相关:PyQt,PyQwt

supervisor:进程监控工具

Java相关

常用的IDE:IntelliJ IDEA,Eclipse,Netbeans

Web开发相关:Tomcat、Resin、Jetty、WebLogic等,常用的组件Struts,Spring

HibernateNetty: 异步事件驱动网络应用编程框架,用于高并发网络编程比较好(NIO框架)

MINA:简单地开发高性能和高可靠性的网络应用程序(也是个NIO框架),不少手游服务端是用它开发的

jOOQ:java Orm框架Activiti:工作流引擎,类似的还有jBPM、Snaker

Perfuse:是一个用户界面包用来把有结构与无结构数据以具有交互性的可视化图形展示出来.

Gephi:复杂网络分析软件, 其主要用于各种网络和复杂系统,动态和分层图的交互可视化与探测开源工具

Nutch:知名的爬虫项目,hadoop就是从这个项目中发展出来的

web-harvest:Web数据提取工具

POM工具:Maven+ArtifactoryNetflix

Curator:Netflix公司开源的一个Zookeeper client library,用于简化Zookeeper客户端编程

Akka:一款基于actor模型实现的 并发处理框架

EclEmma:覆盖测试工具

.net相关

Xilium.CefGlue:基于CEF框架的.NET封装,基于.NET开发Chrome内核浏览器

CefSharp:同上,有一款WebKit的封装,C#和Js交互会更简单

netz:免费的 .NET 可执行文件压缩工具

SmartAssembly:变态的.net代码优化混淆工具

NETDeob0:.net反混淆工具,真是魔高一尺道高一丈啊(还有个de4dot,在GitHub上,都是开源的)

ILMerge:将所有引用的DLL和exe文件打成一个exe文件

ILSpy:开源.net程序反编译工具

Javascript.NET:很不错的js执行引擎,对v8做了封装

NPOI: Excel操作

DotRAS:远程访问服务的模块

WinHtmlEditor: Winform下的html编辑器

SmartThreadPool:使用C#实现的,带高级特性的线程池

Snoop: WPF Spy Utility

Autofac: 轻量级IoC框架

HtmlAgilityPack:Html解析利器

Quartz.NET:Job调度

HttpLib:@CodePlex,简化http请求

SuperSocket:简化Socket操作,基于他的还有个SuperWebSocket,可以开发独立的WebSocket服务器了

DocX:未安装Office的情况下操作Word文件

Dapper:轻量级的ORM类,性能不错

HubbleDotNet:支持接入数据库的全文搜索系统

fastJSON:@CodeProject,高性能的json序列化类

ZXing.NET:@CodePlex,QR,条形码相关

Nancy:轻量级Http服务器,做个小型的Web应用可以摆脱IIS喽(Nancy.Viewengines.Razor,可以加入Razor引擎)

AntiXSS:微软的XSS防御库Microsoft Web Protection

LibraryJint:JavaScript解释器

CS-Script:将C#代码文件作为脚本执行

Jexus:Linux下 高性能、易用、免费的ASP.NET服务器

Clay:将dynamic发挥的更加灵活,像写js一样写C#

DynamicJSON:不必定义数据模型获取json数据

Antlr:开源的语法分析器(归到C#不太合适,其他语言也可以去用)

SharpPcap:C#版的WinPcap调用端,牛逼的网络包分析库(自带PacketNotNet用于包协议分析)

Roslyn:C#,VB编译器

ImageResizer: 服务端自由控制图片大小,真乃神器也,对手机端传小图,PC端传大图,CMS用它很方便

UI相关:DevExpress, Fluent(Office 07风格), mui(Modern UI for WPF)

NetSparkle:应用自动更新组件

ConfuserEx: 开源.net混淆工具

ServiceStack: 开源高性能Web服务框架,可用于构建高性能的REST服务Expression

Evaluator:Eval for C#,处理字符串表达式

http://nugetmusthaves.com/

常用工具

Fiddler:非常好用的Web前端调试工具,当然是针对底层http协议的,一般情况使用Chrome等自带的调试工具也足够了,特殊情况还得用它去处理

wireshark:知名的网络数据包分析工具

PowerCmd:替代Windows Cmd的利器

RegexBuddy:强大的正则表达式测试工具

Soure Insight:源代码阅读神器

SublimeText:程序员最爱的编辑器

Database.NET:一个通用的关系型数据库客户端,基于.NET 4.0开发的,做简单的处理还是蛮方便的

Navicat Premium:支持MySql、PostgreSQL、Oracle、Sqlite和SQL Server的客户端,通用性上不如

Database.NET,但性能方面比Database.NET好很多,自带备份功能也用于数据库定时备份。

Synergy : 局域网内一套键盘鼠标控制多台电脑

DameWare:远程协助工具集(我在公司主要控制大屏幕用)

Radmin: 远程控制工具,用了一段时间的

DameWare,还要破解,对Win7支持的不好,还是发现这个好用

Listary:能极大幅度提高你 Windows 文件浏览与搜索速度效率的「超级神器」

Clover:给资源管理器加上多标签

WinLaunch:模拟Mac OS的Launch工具

Fritzing:绘制电路图

LICEcap:gif教程制作git,

svn:版本控制系统Enigma Virtual Box(将exe,dll等封装成一个可执行程序)

Open DBDiff(针对SqlServer)数据库同步

SymmetricDS:数据库同步

BIEE,Infomatica,SPSS,weka,R语言:数据分析

CodeSmith,LightSwitch:代码生成

Pandoc:Markdown转换工具,出书用的。以前玩过docbook,不过现在还是Markdown盛行啊。

Window Magnet[Mac]:增强Mac窗口管理功能,想Win7一样具有窗口拖放到屏幕边缘自动调整的功能

log explorer:查看SqlServer日志dependency

walker:查询Windows应用程序dll依赖项

Shairport4w:将iPhone,iPad,iPod上的音频通过AirPlay协议传输到PC上

ngrok:内网穿透工具Axure:快速原型制作工具,还有个在线作图的工具国内的一个创业团队做的,用着很不错 http://www.processon.com

tinyproxy:(Linux)小型的代理服务器支持http和https协议EaseUS Partition

Master:超级简单的分区调整工具,速度还是蛮快的,C盘不够用了就用它从D盘划点空间吧,不用重装系统这么折腾哦。

CheatEngine:玩游戏修改内存值必备神器(记得我在玩轩辕剑6的时候就用的它,超级方便呢)

ApkIDE:Android反编译神器翻、墙工具(自|由|门、天行浏览器)

设计工具:Sketch、OmniGraffle

MindManger:思维导图 收起阅读 »

python3 列表推导式 vs map 差别

(针对python3,因为python3的map返回的是一个map对象,属于生成器)

速度:

如果map里面是用的lambda,那么map速度会比列表推导式要慢,正常情况map速度稍微快那么一点点。

使用lambda

因为map返回的是生成器,所以map对于大容量的操作,不会导致内存爆掉。

而列表推导式则会爆内存,不过也有解决方案,就是使用()替代【】,这时返回的是生成器推导式

如果换成map就不会有问题

或者

原创文章,转载请注明:

http://30daydo.com/article/378

收起阅读 »

速度:

如果map里面是用的lambda,那么map速度会比列表推导式要慢,正常情况map速度稍微快那么一点点。

$ python -mtimeit -s'xs=range(10)' 'map(hex, xs)'可以看到map稍微快一些

100000 loops, best of 3: 4.86 usec per loop

$ python -mtimeit -s'xs=range(10)' '[hex(x) for x in xs]'

100000 loops, best of 3: 5.58 usec per loop

使用lambda

$ python -mtimeit -s'xs=range(10)' 'map(lambda x: x+2, xs)'列表推导式稍微快些。

100000 loops, best of 3: 4.24 usec per loop

$ python -mtimeit -s'xs=range(10)' '[x+2 for x in xs]'

100000 loops, best of 3: 2.32 usec per loop

因为map返回的是生成器,所以map对于大容量的操作,不会导致内存爆掉。

而列表推导式则会爆内存,不过也有解决方案,就是使用()替代【】,这时返回的是生成器推导式

>>> [str(n) for n in range(10**100)]谨慎运行上面的,你电脑会卡到爆如果换成map就不会有问题

>>> map(str, range(10**100))

<map object at 0x2201d50>

或者

>>> (str(n) for n in range(10**100))也不会有问题。

<generator object <genexpr> at 0xacbdef>

原创文章,转载请注明:

http://30daydo.com/article/378

收起阅读 »