转换很多逗号的,,,,,,,,, JS的数组为python列表

不知道JS的写法就是这样还是这样的,一个列表可以这么写

var arr = [,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,1,2,3,4,5] 前面的逗号就是没有数据,None或者0.

然后JS的代码可以不填充任何数据。python要把它转为list,要怎么做的?

有2个方法:

1. 最简单,因为,,的意思是0,0, 那么我们可以把两个逗号替换成0,0,

但是如果前面的逗号数是单数,比如是3个逗号,

arr=[,,,1,2,3]

直接替换2个逗号为0,0,的话,结果是0,0,,1,2,3

结果也不对。

多了一对逗号

然后可以直接再替换一次,, 把两个的地方替换为1个,

2. 使用finditer找出每个多余2个逗号的起始和结束,然后替换为0, 即可。

for m in re.finditer(',{2,}'):

start=m.start()

end=m.end()

收起阅读 »

var arr = [,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,1,2,3,4,5] 前面的逗号就是没有数据,None或者0.

然后JS的代码可以不填充任何数据。python要把它转为list,要怎么做的?

有2个方法:

1. 最简单,因为,,的意思是0,0, 那么我们可以把两个逗号替换成0,0,

但是如果前面的逗号数是单数,比如是3个逗号,

arr=[,,,1,2,3]

直接替换2个逗号为0,0,的话,结果是0,0,,1,2,3

结果也不对。

多了一对逗号

然后可以直接再替换一次,, 把两个的地方替换为1个,

2. 使用finditer找出每个多余2个逗号的起始和结束,然后替换为0, 即可。

for m in re.finditer(',{2,}'):

start=m.start()

end=m.end()

收起阅读 »

imgtu的设计有毛病吧? 垃圾路过图床

这个站点是不允许别人用梯子上传图片。

然后自己官方的联系方式里面放一个电报telegram的链接。

还有那个发送后台消息给官方邮件的验证码,也是一个谷歌的验证码,没有梯子哪有能耐发消息给你呀?

反正就是莫名其妙的被封禁了。 导致个人存放在上面的图片变成了死链接,主要要回去硬盘里面一张张图片找回来,补回去原来的博客文章里面,够呛的了。

这个垃圾网站就是一个坑逼,谁用谁傻逼!

还是老老实实用阿里云或者腾讯,七牛的空间,访问量不高的费用又不高。

主要是被人坑的感觉不爽。

免费图床虽然可以不花钱,但我悲观地认为,大多免费且赚不了钱的服务终究走不了长远,也许未来的某一天,你就会突然收到「XX 关停」的通知。 收起阅读 »

然后自己官方的联系方式里面放一个电报telegram的链接。

还有那个发送后台消息给官方邮件的验证码,也是一个谷歌的验证码,没有梯子哪有能耐发消息给你呀?

反正就是莫名其妙的被封禁了。 导致个人存放在上面的图片变成了死链接,主要要回去硬盘里面一张张图片找回来,补回去原来的博客文章里面,够呛的了。

这个垃圾网站就是一个坑逼,谁用谁傻逼!

还是老老实实用阿里云或者腾讯,七牛的空间,访问量不高的费用又不高。

主要是被人坑的感觉不爽。

免费图床虽然可以不花钱,但我悲观地认为,大多免费且赚不了钱的服务终究走不了长远,也许未来的某一天,你就会突然收到「XX 关停」的通知。 收起阅读 »

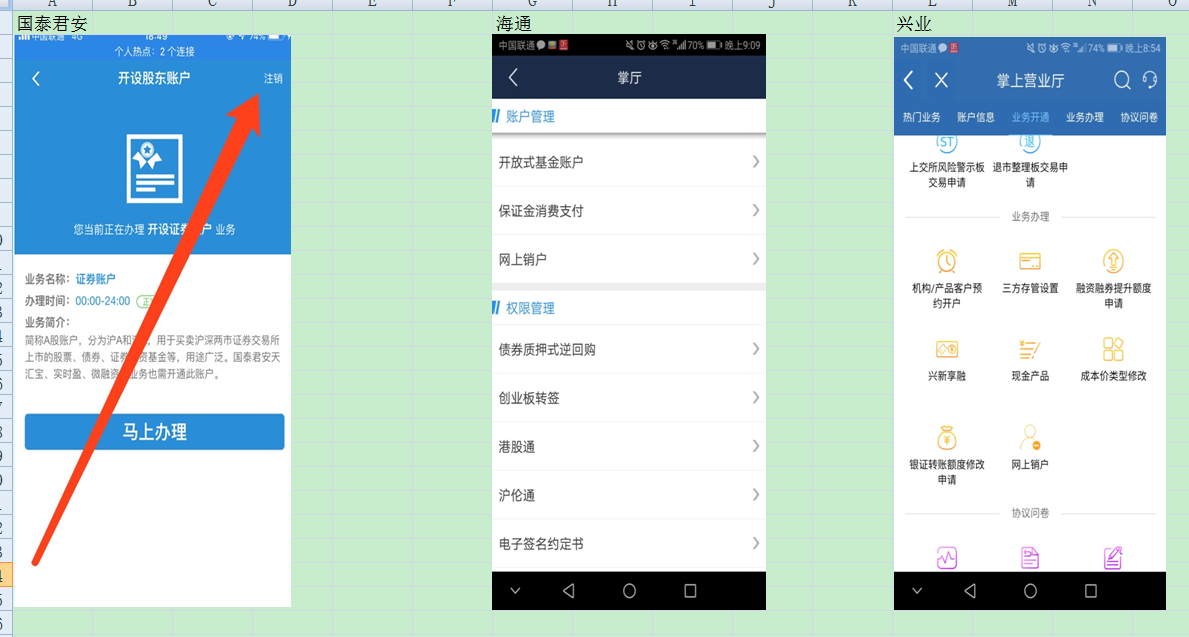

在2015年山顶5178点 开始定投所有大A股票 结果会是怎样?

对于定投,一般人印象是,如果你最终结果是亏损的,那么原因就是:耐心不够,跌的时候不够定力,不敢继续加仓。

而事实真的是这样吗?

笔者使用2015年6月12日上一轮全面牛市的高点5178点,作为定投的起始点。而定投标的股票为大A所有股票。

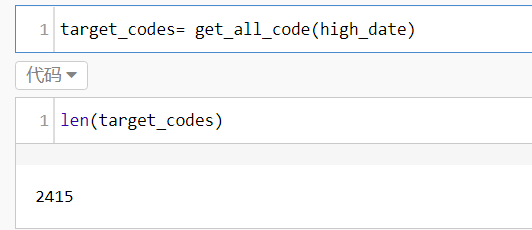

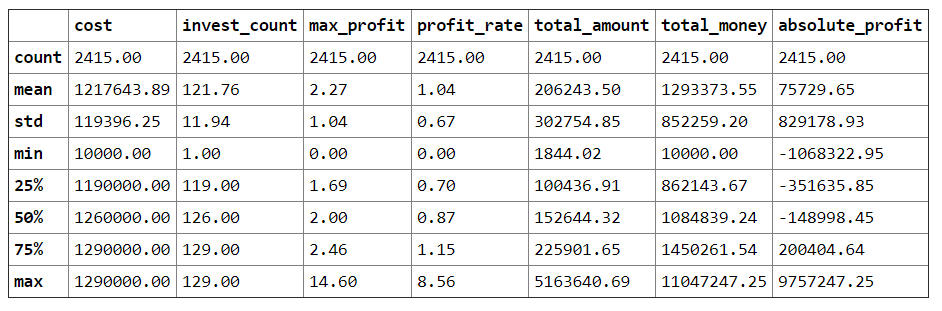

股票池为2015年6月12日没有停牌的股票,共 2415 只。使用的量化平台是优矿。

(没错,以前股票数就才两千多只,这几年股票数接近翻倍了)

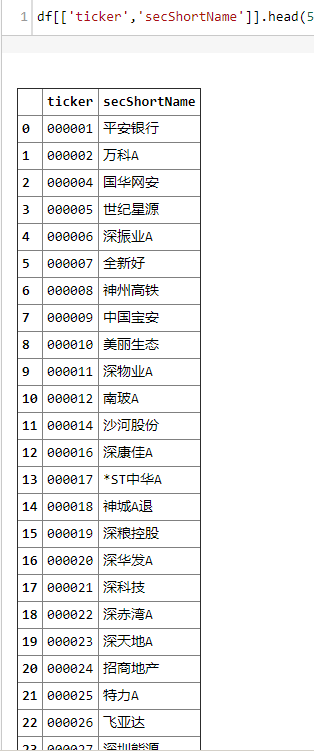

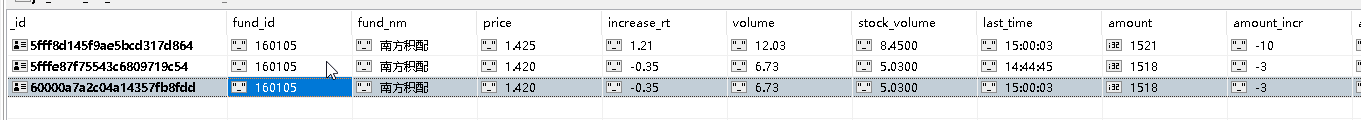

部分股票样本数据

接着从2015年6月12日开始定投,这里笔者按照一个月定投一次,也就是22个交易日定投一次。

每次定投金额10000元。定投到2021年3月28日。

如果定投当天遇到股票停牌,则顺势延续到复牌后继续定投。

这里定投采用净值法定投,为的是让数据更加准确。因为如果按照实际定投股票,10000元的金额可能连1手的茅台也买不进去,这里计算买入的份额为=10000元/股票股价, 比如茅台的股价是2000元,那么这里买入的份额就是5股,并没按照实际股票的1手来算。这样计算得到结果更加精准。

python计算代码如下:

最终得到的数据保存在stock_profit_list变量里面。在计算过程也记录里每一个股票当前一期定投阶段的阶段收益率,组合成一个列表。

为的是倒后镜看看,曾经的历史定投收益率,也可以看看曾经的历史定投收益率的最大值。便于和现在最后一期收益率的对比。

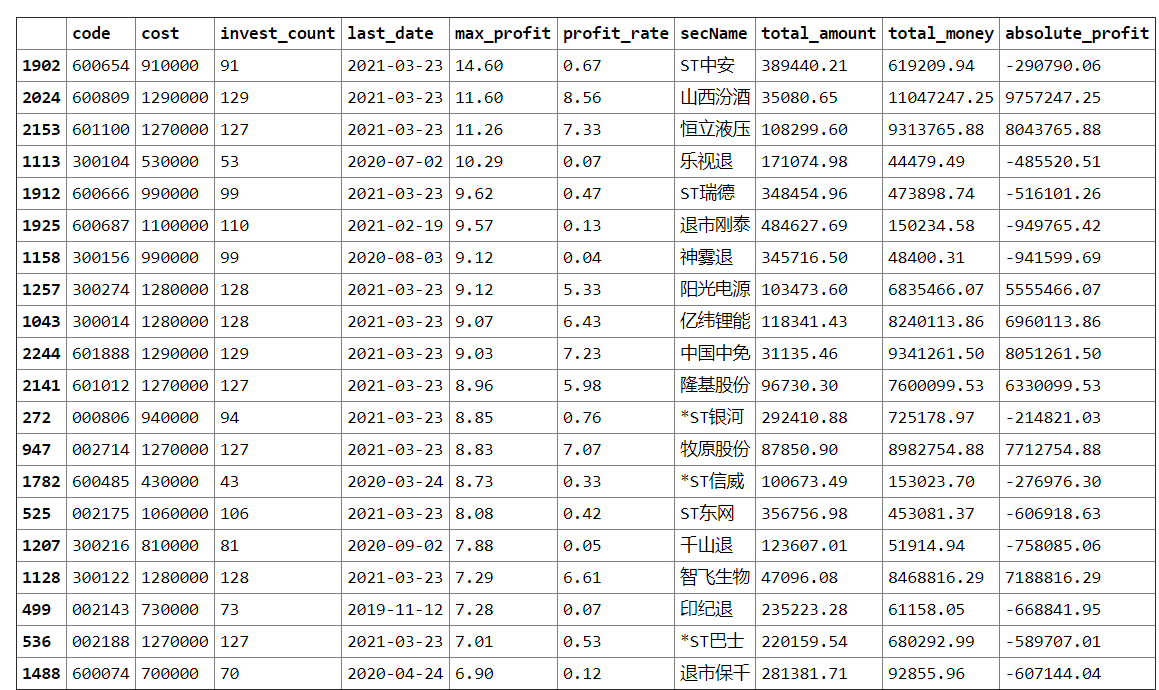

得到数据按照profit_rate收益率排个序:

得到下面的数据:

上面的股票熟悉不?基本都是年初那一批基金ikun们的抱团股。

定投收益率最高的是山西汾酒,收益率达到8.56,即856%,从股灾高点定投下来,到现在2021年3月28日,收益率是8倍!

其月K线如下:

牛气冲天的5年十倍股,股灾时山西汾酒的股价徘徊在21-26之间左右。如果股灾的时候采用一把梭,收益率是336/26=12.9 倍。

而采用定投方式的收益率也不差,8.56倍。

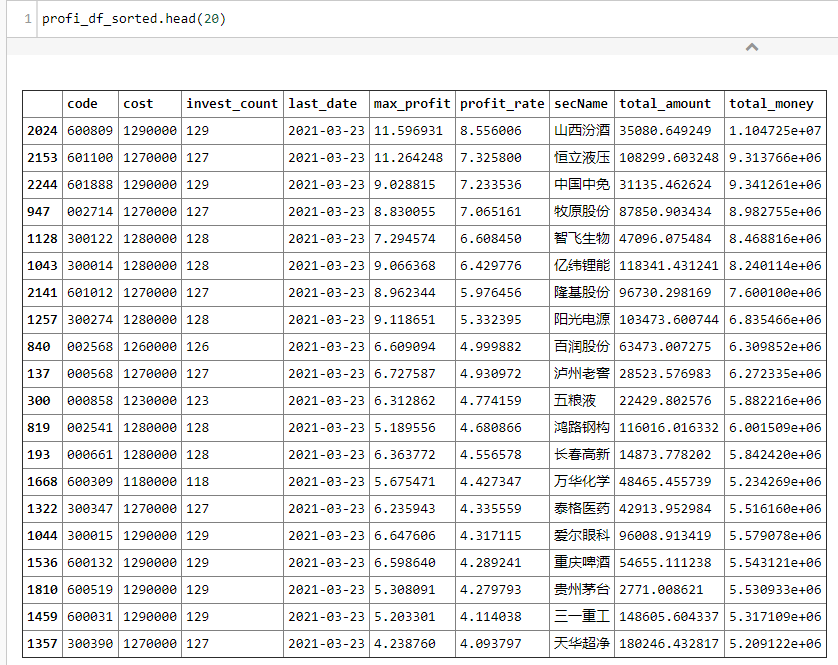

再继续看看定投收益排在倒数的

真是好家伙,亏得底裤都不见了。清一色的退市股,定投收益率基本在0.1以下,意味着投资了100元,最后就剩10元以下。

在前面计算的时候,特意加了一个数据列,定投期数和定投停止日期,也就是股票退市或者停牌导致无法交易的日子。

invest_count为定投期数,定投一次此值加1. last_date 为最后一个交易日期。倒数第一个国恒退,只交易1期,7月10日退市,等不来第2期的定投,不过也好,这样子只也不至于越陷越深。

国恒退日K

total_money 列是投资得到总金额,cost是投入的成本。投资期数越多,随着股价上涨,该金额会越高,而股价不断下跌,则该金额会越来越少。所以遇到国恒退这种股票,当期只投了10000元就无法继续投下去,还是运气比较好的。类似于止损操作了。

toal_money减去cost得到的是绝对收益。之前因为没有加这一列,可以通过以下公式计算得到:

按绝对收益计算,最多的还是前面那20位个股,赚最多的山西汾酒,129W的定投金额,盈利金额达到900W。

同样倒序排一下,绝对亏损最多的,肯定也是定投期数较多的。

[图片]

亏损最多的天夏退,目前还没有完全退市,定投了114期,总亏损金额达到100W,定投总金额是110W。额,只剩10W。

它的月K线是这样的。其跌到4元多的时候还放量了,可能一堆人冲进去抄底了,然后按亏损幅度,4元跌到0.22元,亏损幅度也是94.5%,这个亏损幅度其实和在山顶29元站岗的亏损率其实没什么区别了。高手死于抄底,呵呵。

接着看看上面所有股票的定投的平均收益率:

得到的收益率的平均值为:1.043,减去本金1,收益为1.043-1=0.043,也就是4.3%个点。

换句话说,如果在股票高点5178点定投全市场股票,5年多来的最后收益率为4.3%.

中位数是0.87-1=-0.13,= -13%,中位数是亏损13%,定投金额约126W,亏损金额为14W。

看到这里,笔者想要表述的是,即使是定投也需要挑选一个好标的股票或者基金,也就是择股择时能力。

如果在一个垃圾股或者基金上定投,只会让你越陷越深,亏损越来越多。假如你在定投康得新或者乐视,定投了100期,投入了不少的金额和时间,突然暴雷,然后ST,那么你会继续定投下去吗?

另外,定投也需要一定的择时能力,比如在前春节前,基金抱团股热度不减,对于大部分没有择股能力的人来说,当时是应该止盈离场的。当然,如果倒后镜看,如果有能力抓取上面的大牛股,也不一定能够把上面的8倍收益落袋而安。

上面数据有一列max_profit,total_money/cost, 也就是定投期间,获得的最大收益率。按此列排序:

在定投期间,最大收益率的是ST中安,最大收益率是14.6-1=13.6倍。最后到这个月最终定投收益率是0.67,亏损状态,0.67-1=-0.37,亏损为-37%,绝对收益absolute_profit为-29W.

排在第4是是乐视退,定投期间最大收益max_profit达到10倍,最后如果坚持定投,是亏损93%的。

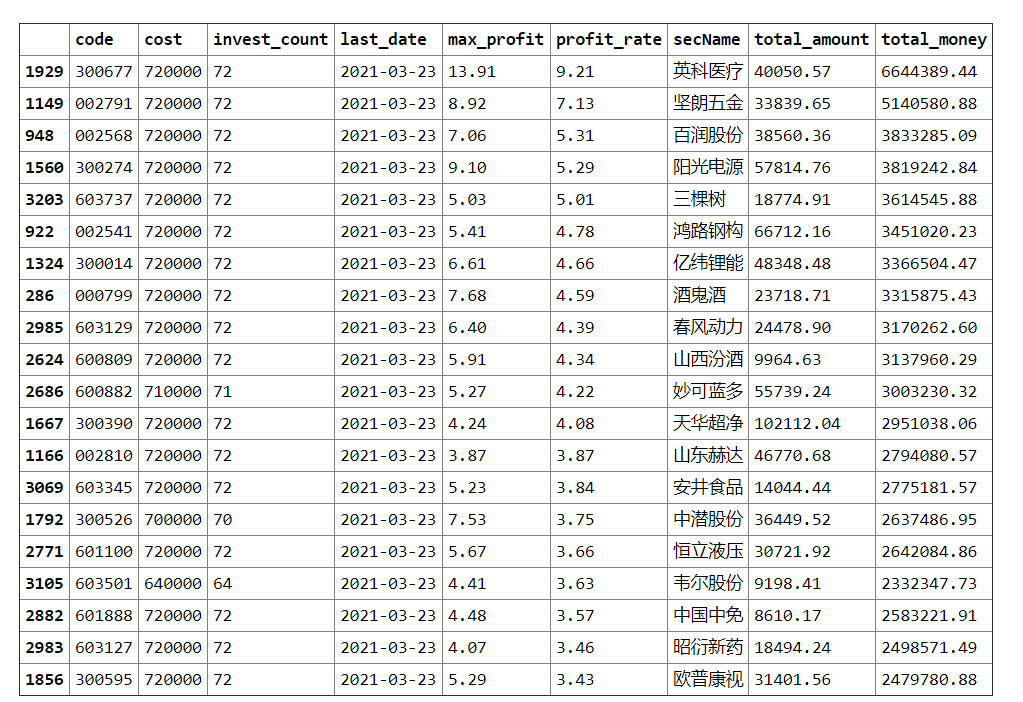

如果把定投时间放在2018年1月12日,那么得到的定投收益率排名前20名是这样的:

得到不一样的前20排名,定投收益率最高的是英科医疗,疫情手套涨了10倍的大牛股。而山西汾酒跌到第10,并且收益率也只有4倍左右。而茅台也没出现在前20的榜单上。

不同的定投时间,得到的是不一样的结果。当然择股能力强的大神,就不屑定投而采用一把梭了,大神向往的是英科医疗的一年十倍,而不是十年十倍(大V组合抱团,抱团基金的组合)。

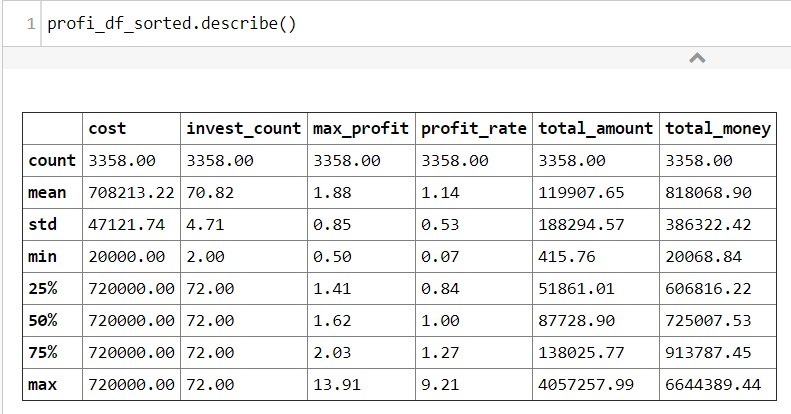

其改变定投时间的定投收益率的平均值以及中位数数据如下:

平均收益率达到了1.14-1=0.14=14%,也就是如果你在18年开始定投全市场股票,当前平均收益率是14%,不过中位数的收益率是1-1=0%,因为这两年股票大小票分化得太严重(24%的个股跌破2440的低点,指数涨41%),四分一分位的定投收益率为27%,到了中位数就为0%了。其定投收益率较2015年山顶定投也有了很大的区别。

今天就到这里吧,感觉文章太长了,本来还想把全市场的基金加进来比较的(不同时间点定投全市场所有基金),碍于篇幅原因,留在下一篇再写吧,敬请留意!

微信公众号:

可转债量化分析

收起阅读 »

而事实真的是这样吗?

笔者使用2015年6月12日上一轮全面牛市的高点5178点,作为定投的起始点。而定投标的股票为大A所有股票。

股票池为2015年6月12日没有停牌的股票,共 2415 只。使用的量化平台是优矿。

(没错,以前股票数就才两千多只,这几年股票数接近翻倍了)

def get_all_code(date):

'''

获取某天的股市运行的股票,排除停牌

'''

df=DataAPI.MktEqudAdjGet(secID=u"",ticker=u"",

tradeDate=date,

beginDate=u"",

endDate=u"",

isOpen="",

field=u"",

pandas="1")

df=df[df['turnoverValue']>0] # 停牌

return df['ticker'].tolist()

部分股票样本数据

接着从2015年6月12日开始定投,这里笔者按照一个月定投一次,也就是22个交易日定投一次。

每次定投金额10000元。定投到2021年3月28日。

如果定投当天遇到股票停牌,则顺势延续到复牌后继续定投。

这里定投采用净值法定投,为的是让数据更加准确。因为如果按照实际定投股票,10000元的金额可能连1手的茅台也买不进去,这里计算买入的份额为=10000元/股票股价, 比如茅台的股价是2000元,那么这里买入的份额就是5股,并没按照实际股票的1手来算。这样计算得到结果更加精准。

python计算代码如下:

1import time

2import datetime

3

4stock_profit_list=

5start=time.time()

6

7today=datetime.datetime.now().strftime('%Y-%m-%d')

8

9def get_trade_date():

10 df=DataAPI.TradeCalGet(exchangeCD=u"XSHG,XSHE",

11 beginDate=high_date,

12 endDate=today,isOpen=u"1",

13 field=u"",pandas="1")

14 return df['calendarDate'].tolist()

15

16def fixed_investment(code):

17 stock_profit_dict={}

18 stock_profit_dict['code']=code

19 df=DataAPI.MktEqudAdjGet(secID=u"",ticker=code,tradeDate=u'',beginDate=high_date,endDate=today,isOpen="1",field=u"",pandas="1")

20 total_amount=0

21 invest_count=0

22 every_invest_cash=10000

23 total_money_list=list()

24 last_date=None

25 for trade_date in trade_date_list_interval:

26 trade_df = df[df['tradeDate']==trade_date]

27 if len(trade_df)>0:

28 invest_count+=1

29 price=trade_df['closePrice'].iloc[0]

30 amount=every_invest_cash/price

31 cost=invest_count*every_invest_cash

32 profit=total_amount*price/cost

33 total_money_list.append(profit)

34 total_amount=total_amount+amount

35 total_money=price*total_amount

36 last_date=trade_date

37

38

39 stock_profit_dict['profit_rate']=profit

40 stock_profit_dict['last_date']=last_date

41 stock_profit_dict['invest_count']=invest_count

42 stock_profit_dict['total_amount']=total_amount

43 stock_profit_dict['total_money']=total_money

44 stock_profit_dict['profit_list']=total_money_list

45 stock_profit_dict['cost']=cost

46 return stock_profit_dict

47

48for code in target_codes:

49 profit_dict = fixed_investment(code)

50 stock_profit_list.append(profit_dict)

51

52print(time.time()-start)

最终得到的数据保存在stock_profit_list变量里面。在计算过程也记录里每一个股票当前一期定投阶段的阶段收益率,组合成一个列表。

为的是倒后镜看看,曾经的历史定投收益率,也可以看看曾经的历史定投收益率的最大值。便于和现在最后一期收益率的对比。

得到数据按照profit_rate收益率排个序:

profi_df_sorted = profit_df.sort_values(by='profit_rate',ascending=False)

得到下面的数据:

上面的股票熟悉不?基本都是年初那一批基金ikun们的抱团股。

定投收益率最高的是山西汾酒,收益率达到8.56,即856%,从股灾高点定投下来,到现在2021年3月28日,收益率是8倍!

其月K线如下:

牛气冲天的5年十倍股,股灾时山西汾酒的股价徘徊在21-26之间左右。如果股灾的时候采用一把梭,收益率是336/26=12.9 倍。

而采用定投方式的收益率也不差,8.56倍。

再继续看看定投收益排在倒数的

真是好家伙,亏得底裤都不见了。清一色的退市股,定投收益率基本在0.1以下,意味着投资了100元,最后就剩10元以下。

在前面计算的时候,特意加了一个数据列,定投期数和定投停止日期,也就是股票退市或者停牌导致无法交易的日子。

invest_count为定投期数,定投一次此值加1. last_date 为最后一个交易日期。倒数第一个国恒退,只交易1期,7月10日退市,等不来第2期的定投,不过也好,这样子只也不至于越陷越深。

国恒退日K

total_money 列是投资得到总金额,cost是投入的成本。投资期数越多,随着股价上涨,该金额会越高,而股价不断下跌,则该金额会越来越少。所以遇到国恒退这种股票,当期只投了10000元就无法继续投下去,还是运气比较好的。类似于止损操作了。

toal_money减去cost得到的是绝对收益。之前因为没有加这一列,可以通过以下公式计算得到:

profit_df['absolute_profit']=profit_df['total_money']-profit_df['cost']

按绝对收益计算,最多的还是前面那20位个股,赚最多的山西汾酒,129W的定投金额,盈利金额达到900W。

同样倒序排一下,绝对亏损最多的,肯定也是定投期数较多的。

[图片]

亏损最多的天夏退,目前还没有完全退市,定投了114期,总亏损金额达到100W,定投总金额是110W。额,只剩10W。

它的月K线是这样的。其跌到4元多的时候还放量了,可能一堆人冲进去抄底了,然后按亏损幅度,4元跌到0.22元,亏损幅度也是94.5%,这个亏损幅度其实和在山顶29元站岗的亏损率其实没什么区别了。高手死于抄底,呵呵。

接着看看上面所有股票的定投的平均收益率:

profi_df_sorted['profit_rate'].mean()得到的收益率的平均值为:1.043,减去本金1,收益为1.043-1=0.043,也就是4.3%个点。

换句话说,如果在股票高点5178点定投全市场股票,5年多来的最后收益率为4.3%.

中位数是0.87-1=-0.13,= -13%,中位数是亏损13%,定投金额约126W,亏损金额为14W。

看到这里,笔者想要表述的是,即使是定投也需要挑选一个好标的股票或者基金,也就是择股择时能力。

如果在一个垃圾股或者基金上定投,只会让你越陷越深,亏损越来越多。假如你在定投康得新或者乐视,定投了100期,投入了不少的金额和时间,突然暴雷,然后ST,那么你会继续定投下去吗?

另外,定投也需要一定的择时能力,比如在前春节前,基金抱团股热度不减,对于大部分没有择股能力的人来说,当时是应该止盈离场的。当然,如果倒后镜看,如果有能力抓取上面的大牛股,也不一定能够把上面的8倍收益落袋而安。

上面数据有一列max_profit,total_money/cost, 也就是定投期间,获得的最大收益率。按此列排序:

在定投期间,最大收益率的是ST中安,最大收益率是14.6-1=13.6倍。最后到这个月最终定投收益率是0.67,亏损状态,0.67-1=-0.37,亏损为-37%,绝对收益absolute_profit为-29W.

排在第4是是乐视退,定投期间最大收益max_profit达到10倍,最后如果坚持定投,是亏损93%的。

如果把定投时间放在2018年1月12日,那么得到的定投收益率排名前20名是这样的:

得到不一样的前20排名,定投收益率最高的是英科医疗,疫情手套涨了10倍的大牛股。而山西汾酒跌到第10,并且收益率也只有4倍左右。而茅台也没出现在前20的榜单上。

不同的定投时间,得到的是不一样的结果。当然择股能力强的大神,就不屑定投而采用一把梭了,大神向往的是英科医疗的一年十倍,而不是十年十倍(大V组合抱团,抱团基金的组合)。

其改变定投时间的定投收益率的平均值以及中位数数据如下:

平均收益率达到了1.14-1=0.14=14%,也就是如果你在18年开始定投全市场股票,当前平均收益率是14%,不过中位数的收益率是1-1=0%,因为这两年股票大小票分化得太严重(24%的个股跌破2440的低点,指数涨41%),四分一分位的定投收益率为27%,到了中位数就为0%了。其定投收益率较2015年山顶定投也有了很大的区别。

今天就到这里吧,感觉文章太长了,本来还想把全市场的基金加进来比较的(不同时间点定投全市场所有基金),碍于篇幅原因,留在下一篇再写吧,敬请留意!

微信公众号:

可转债量化分析

收起阅读 »

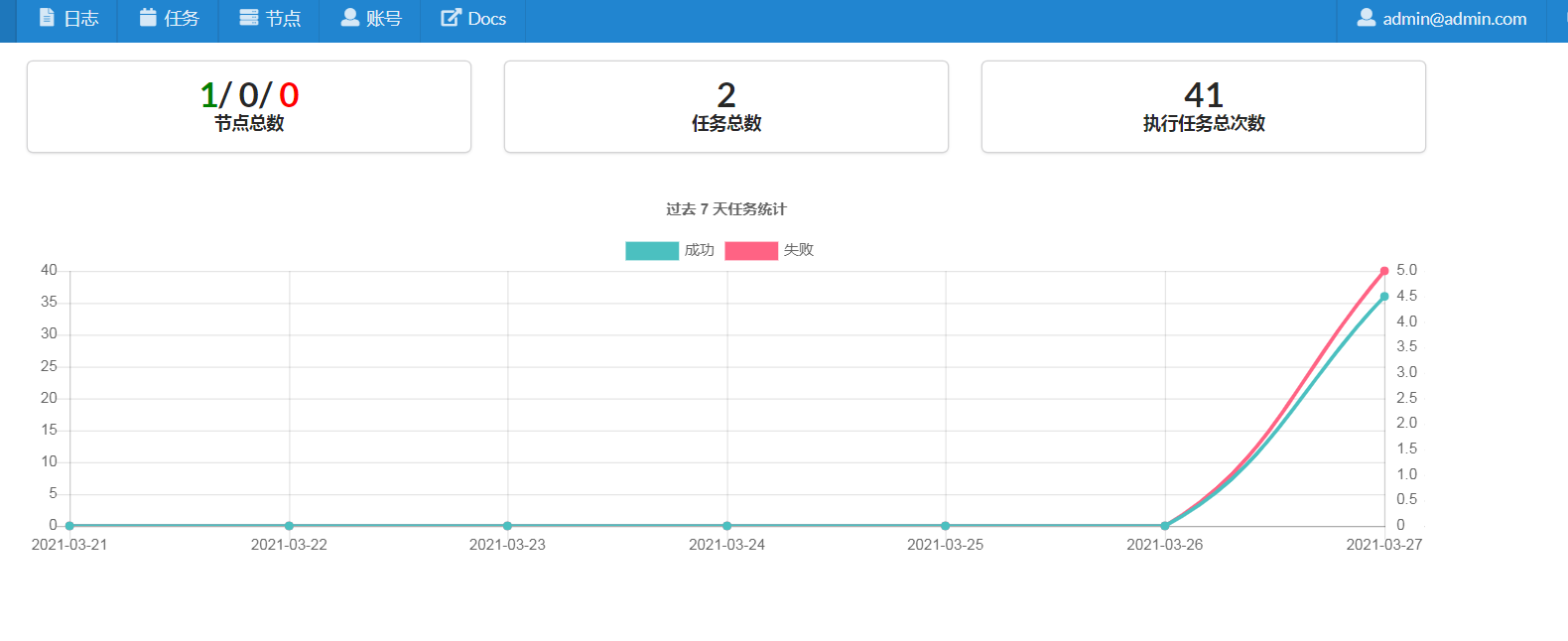

cronsun 执行计划任务是报错 exec format error

把执行的python命令写到shell里面,也给了+x权限,还是报这个错误

单独执行shell的脚本是没有问题的。

经过试验测试,是因为shell脚本的开头没有没有添加:

在shell脚本的第一行添加上后就没有问题了。

附一个脚本批量处理: 自动在首行添加 #!/bin/bash

fork/exec /root/crontab_script/hello.sh: exec format error

单独执行shell的脚本是没有问题的。

经过试验测试,是因为shell脚本的开头没有没有添加:

#!/bin/bash的标记。

在shell脚本的第一行添加上后就没有问题了。

附一个脚本批量处理: 自动在首行添加 #!/bin/bash

In [1]: folder='/root/crontab_script'收起阅读 »

In [2]: import os

In [3]: filelist=os.listdir(folder)

In [6]: def change_file(filename):

...: with open(filename,'r') as fp:

...: content=fp.read()

...: content=content.strip()

...: concat='#!/bin/bash\n'

...: content=concat+content

...: with open(filename,'w') as fp:

...: fp.write(content)

...:

In [7]: for file in filelist:

...: if file.endswith('.sh'):

...: full_path = os.path.join(folder,file)

...: change_file(full_path)

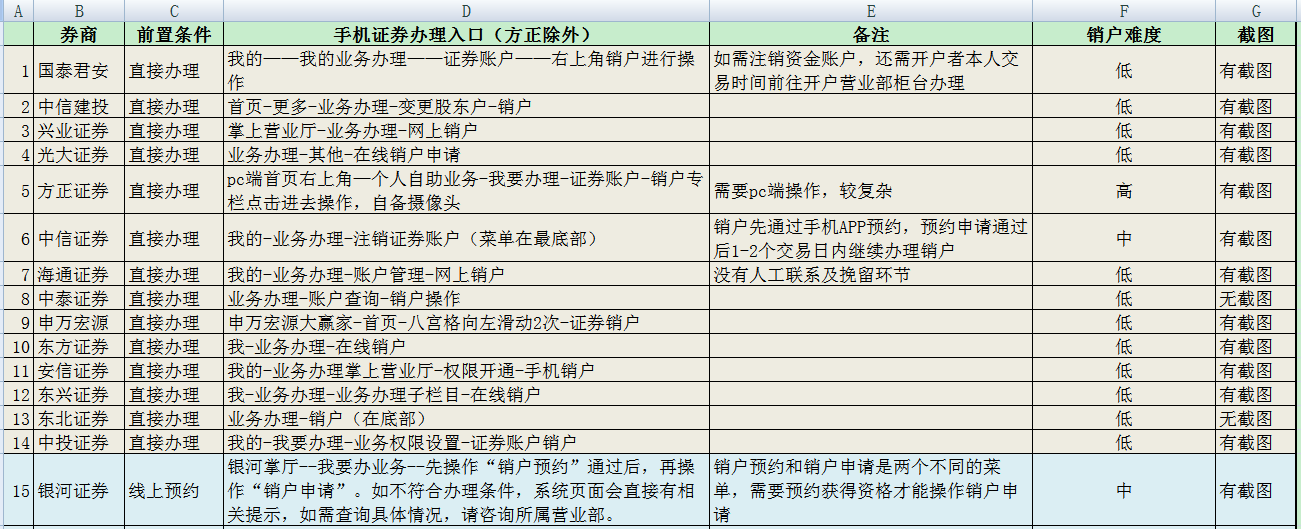

可转债费率最低5元 坑爹券商 -附市面上大部分主流券商的销户流程

最近看了家人的账户的交割单,没想到以前开的账户是这么坑的。 可转债的交易费率万2.5就算了,居然还没有免5。也就是买10张转债(1000元市值左右),就给了5元。。。。

新规后,现在转债费率沪深十万分5,而且没有最低5元这个坑。

所以果断销户,也不打算联系客服了。现在网上销户很简单。

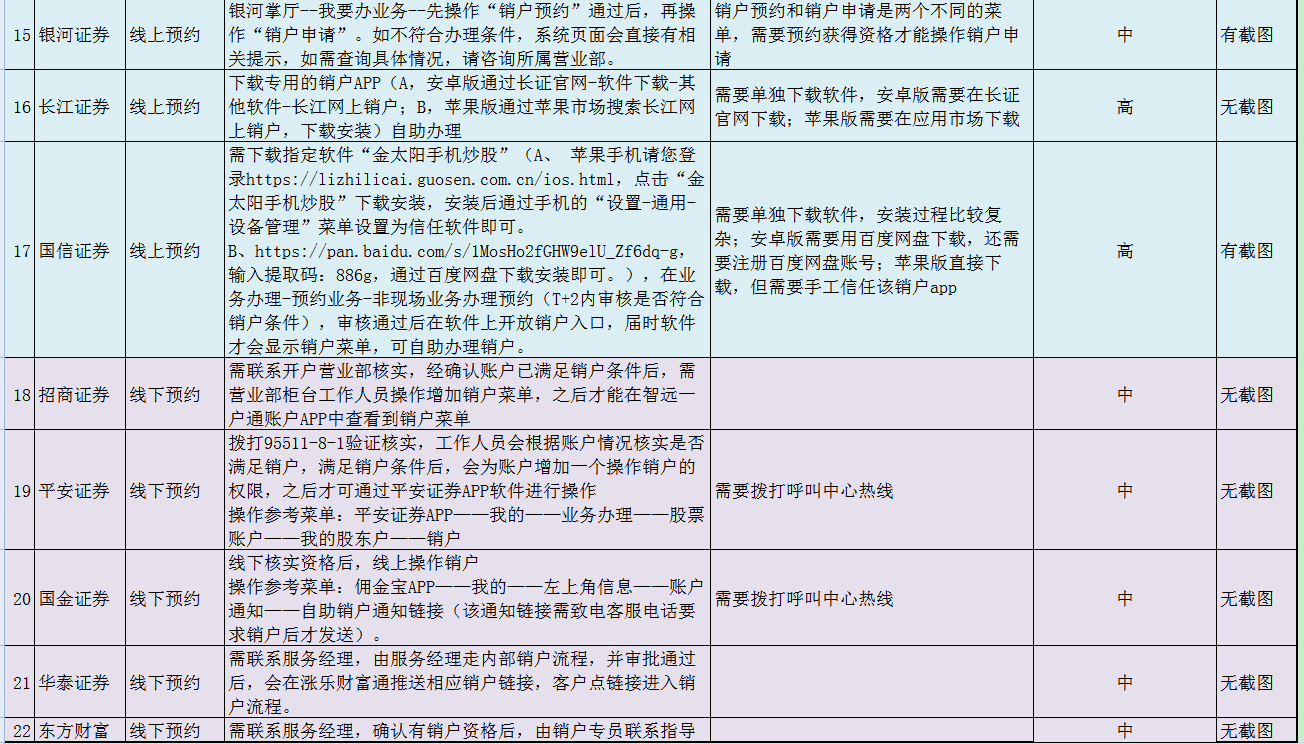

附一个22个券商的网上销户流程表。里面涵盖了每个券商的销户截图流程

涵盖的销户券商列表:

有具体每个券商的销户截图

可以到百度网盘下载这个excel表。

各大券商销户流程表

链接:https://pan.baidu.com/s/1VJMY5grLkghXZGktjpWupA

提取码:40ov

复制这段内容后打开百度网盘手机App,操作更方便哦

更多券商开户,请扫码联系:

可以在这里获取到更多券商的费率信息。

收起阅读 »

收起阅读 »

新规后,现在转债费率沪深十万分5,而且没有最低5元这个坑。

所以果断销户,也不打算联系客服了。现在网上销户很简单。

附一个22个券商的网上销户流程表。里面涵盖了每个券商的销户截图流程

涵盖的销户券商列表:

国泰君安

中信建投

兴业证券

光大证券

方正证券

中信证券

海通证券

中泰证券

申万宏源

东方证券

安信证券

东兴证券

东北证券

中投证券

银河证券

长江证券

国信证券

招商证券

平安证券

国金证券

华泰证券

东方财富

有具体每个券商的销户截图

可以到百度网盘下载这个excel表。

各大券商销户流程表

链接:https://pan.baidu.com/s/1VJMY5grLkghXZGktjpWupA

提取码:40ov

复制这段内容后打开百度网盘手机App,操作更方便哦

更多券商开户,请扫码联系:

可以在这里获取到更多券商的费率信息。

收起阅读 »

收起阅读 »

可转债投资体系

可转债投资体系

今天总结以前这段时间的经验,形成自己的一套可转债投资体系。

1. 买入价位决定成败。

在买入的那一刻,就可以知道这边买卖的胜算。不能买价格超过110以上的转债,切记。不要看标的,再好的标的,价格不美丽,买入也让自己陷入被动。不要说好公司的转债可以放宽买贵的,如果觉得是好公司,直接买正股。

2. 如果没有可以买的标的,一定要有耐心。 时刻未到而已。

2020年10月到12月,妖债横行,是个转债都被随便拉,无视正股涨跌,有些转债还涨破天际,一天100%+的涨幅。 把整体水位拉伸到一个120+的水平。 但是,这又如何? 2021年1月底,新债上市一只,破发一只。 最终满地90多元的转债,而且不断有跌破面值,跌破80多的。

记得当时自己的心态是贪心! 因为瞄定了鸿达转债,广汇转债,亚药转债,搜特转债,以为80多的转债要往70多,60多下移,事后看,当时没有及时大力加仓,错过了一个好价位。

所以设定的规则:跌破5元加仓一格,波动可以在-1到+1之间,也就是94-96之间加仓,89-91之间加仓,如此类推。

3. 110元以下,不能频繁做卖出操作

这个位置110以下卖出,会失去心理优势位置。比如90买的,105卖出,然后涨到115,跌到109,这个时候会有一种冲动要买回来,因为心理上怕后续涨到115或更高后的卖飞心态。 110以下尽量忍住不动。 130以后可以分批卖。所以这里要保证,100面值以下要尽量多买,不能经常做T把筹码给出掉了,失去心理优势价位。 因为如果你90卖的,95卖出,然后涨到98,这个时候你反而不会买,心理是想着它跌回到95以下才买入。从而造成后续该转债一飞冲天而你已经失去仓位了。

上面规则适合上班族,无时间看盘者。

如果有时间看盘,那么可以使用部分仓位进行市场风格的参与博弈。当然这部分是高波动部分,一般人不建议操作。

收起阅读 »

本站使用邀请制进站,注册后需要审核才可以发文字回复等操作

为了提供给需要的读者朋友交流使用需要确认的请发邮件 admin@30daydo.com

PTrade python 第三方模块被禁止使用

import os 回测运行失败, 错误码:3 错误信息: os被禁止使用

在研究/回测/交易中都被禁止了。 因为要做到系统隔离,不给删除,读取容器内的数据

PTrade使用教程 新手入门 收起阅读 »

在研究/回测/交易中都被禁止了。 因为要做到系统隔离,不给删除,读取容器内的数据

PTrade使用教程 新手入门 收起阅读 »

github无法push pull代码

如果只是想要下载代码,可以采用镜像下载

比如要下载的github地址为:

不过上面的方法只能下载代码,理论上应该不能push代码的。(本人没试过哈) 收起阅读 »

比如要下载的github地址为:

https://github.com/Toman5962/wannacry_easy.git那么把仓库名放入到镜像链接中即可:

https://github.91chifun.workers.dev//https://github.com/Toman5962/wannacry_easy.git上面的仓库名是 Toman5962/wannacry_easy.git

不过上面的方法只能下载代码,理论上应该不能push代码的。(本人没试过哈) 收起阅读 »

弘盈A套利总结的经验 --大幅度溢价的不能用拖拉机

轻松出货的券商:

华泰,招商

排队的:

华宝,银河

华泰,招商

排队的:

华宝,银河

PTrade使用教程 新手入门

# 更新 Ptrade API 接口文档: http://ptradeapi.com 这样就可以边打开网页,边写代码,不用在ptrade的代码编写和帮助页面来回切换了。

记录一下曾经的入门经验与使用心得:

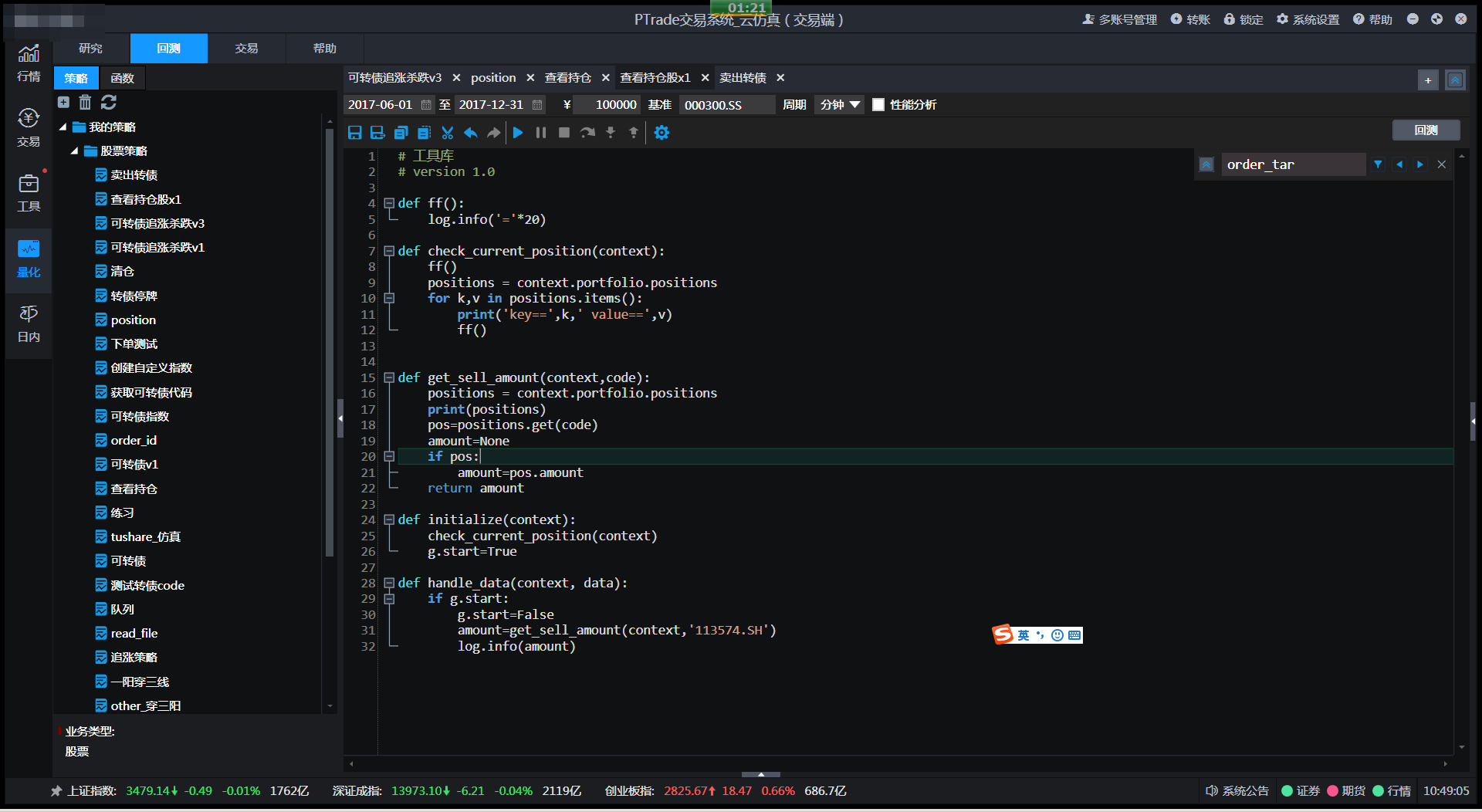

好像PTrade有几个版本,本人使用的界面如下,基于python写交易策略和回测:

1. 仿真系统的回测可以在交易时间运行,交易系统的回测无法在交易时间运行回测。

2. 在研究板块中,API函数带有研究字样的,可以直接使用,不需要import 导入任何库。比如:

而

没有带研究字样的,是无法直接在研究板块使用,只能在回测或者实盘使用。

3. 内置的python版本是:

'3.5.1 (default, Nov 1 2016, 01:53:03) \n[GCC 4.8.5 20150623 (Red Hat 4.8.5-4)]'

也就是无法使用fstring的方式格式化字符串

name='jack'

a=f'{name}'

4. log.debug log.error 等调试标记符不会有任何输出,bug!

只能使用log.info 或者print输出,还害我调试了半天,以为程序哪里的问题,导致我的输出不显示。

PTrade新手入门教程 二

需要开通Ptrade的朋友,可以扫描二维码开户,并可开通PTrade交易功能。

股票费率万分之一,转债十万分之二。

非诚勿扰。

原创文章,转载请注明出处

http://30daydo.com/article/44151

收起阅读 »

记录一下曾经的入门经验与使用心得:

好像PTrade有几个版本,本人使用的界面如下,基于python写交易策略和回测:

1. 仿真系统的回测可以在交易时间运行,交易系统的回测无法在交易时间运行回测。

2. 在研究板块中,API函数带有研究字样的,可以直接使用,不需要import 导入任何库。比如:

#获取当日的股票池可以自己使用。

g.stock_list = get_Ashares(g.current_date)

而

get_history(70, '1d', ['close','volume'], g.stock_list, fq='dypre', include=False)没有带研究字样的,是无法直接在研究板块使用,只能在回测或者实盘使用。

3. 内置的python版本是:

'3.5.1 (default, Nov 1 2016, 01:53:03) \n[GCC 4.8.5 20150623 (Red Hat 4.8.5-4)]'

也就是无法使用fstring的方式格式化字符串

name='jack'

a=f'{name}'

4. log.debug log.error 等调试标记符不会有任何输出,bug!

只能使用log.info 或者print输出,还害我调试了半天,以为程序哪里的问题,导致我的输出不显示。

PTrade新手入门教程 二

需要开通Ptrade的朋友,可以扫描二维码开户,并可开通PTrade交易功能。

股票费率万分之一,转债十万分之二。

非诚勿扰。

原创文章,转载请注明出处

http://30daydo.com/article/44151

收起阅读 »

requests使用断点续传时注意要加stream=True,不然你的硬盘可能会爆掉

res = requests.get(url, stream=True, headers=headers, verify=False)

with open(dst, "ab") as f:

dp = Down_progress(file_size, first_size, dst)

dp.start()

chunk_size = 1024

for chunk in res.iter_content(chunk_size = chunk_size):

if chunk:

f.write(chunk)

dp.update(chunk_size)

如果不加stream=True,那么你的硬盘很可能就不停被写入,文件会变得无比巨大,最后磁盘空间不够死机。

不要问我为什么知道。 收起阅读 »

a股券商开户 万1免五 没有最低消费

最近市场上貌似没有几家万一免5的了,之前的银河证券被举报了,免5的费率被取消了。

不过之前还找到一家万一免五的,没有最低费率,用多少算多少,比如买了1000元股票,那么费率只有1000*万分之一,等于1分钱,略等于不用钱哈。

优势杠杆的。

需要的点击下面链接即可开户: 注意:当前默认的免五已经取消了,需要开通量化交易权限后可以进行免五操作。

开通ptrade和qmt量化交易接口的条件,入金30万,过3天左右可以开通,开通后可以免五!

交割单:

心动不,赶紧心动吧。

该券商也支持同花顺客户端登录,做量化的使用easytrader也可以友好支持。

如果有疑问,可以扫码咨询。备注:开户

收起阅读 »

不过之前还找到一家万一免五的,没有最低费率,用多少算多少,比如买了1000元股票,那么费率只有1000*万分之一,等于1分钱,略等于不用钱哈。

优势杠杆的。

需要的点击下面链接即可开户: 注意:当前默认的免五已经取消了,需要开通量化交易权限后可以进行免五操作。

开通ptrade和qmt量化交易接口的条件,入金30万,过3天左右可以开通,开通后可以免五!

交割单:

心动不,赶紧心动吧。

该券商也支持同花顺客户端登录,做量化的使用easytrader也可以友好支持。

如果有疑问,可以扫码咨询。备注:开户

收起阅读 »

富途牛牛的模拟买入卖出无法生效

富途牛牛的模拟买入卖出无法生效

下图是富途美股的期权交易

后来咨询了客服,原来富途的模拟撮合系统需要真实有成交才能生效。

也就是你挂卖一价,比如10元,你挂一个买单10,是不会成交的,甚至挂一个12,13,也不会成交,需要在实盘交易中,其他人成交了一单,你的模拟才会真正成交。而且如果实盘别人成交的是100股,你模拟挂单的是200股,那么实际成交也只会是100股。

最近入手的期权模拟,先练练手。

港股,美股的账号默认就帮你开了期权和模拟账号,放心玩。不像股需要一定的资金体量还要考试等几天。

在上面拿来练手最好不过了,白天可以练港股,晚上可以练美股。

推荐开个富途玩玩,不需要入金也可以玩,注册账号分分钟的事情。

富途开户链接

一步一步注册即可。可以不入金就可以模拟。

收起阅读 »

下图是富途美股的期权交易

后来咨询了客服,原来富途的模拟撮合系统需要真实有成交才能生效。

也就是你挂卖一价,比如10元,你挂一个买单10,是不会成交的,甚至挂一个12,13,也不会成交,需要在实盘交易中,其他人成交了一单,你的模拟才会真正成交。而且如果实盘别人成交的是100股,你模拟挂单的是200股,那么实际成交也只会是100股。

最近入手的期权模拟,先练练手。

港股,美股的账号默认就帮你开了期权和模拟账号,放心玩。不像股需要一定的资金体量还要考试等几天。

在上面拿来练手最好不过了,白天可以练港股,晚上可以练美股。

推荐开个富途玩玩,不需要入金也可以玩,注册账号分分钟的事情。

富途开户链接

一步一步注册即可。可以不入金就可以模拟。

收起阅读 »

chrome secure shell插件无法上传下载文件

本来挺强大的一个插件,结果因为这个小功能导致鸡肋了,或者我不知道如何在下载文件??

后记:

只好用scp传输啦,还好windows平台的git客户端。

后记:

只好用scp传输啦,还好windows平台的git客户端。

python 转换excel数据,适配flourish数据格式

flourish可视化网站要求excel的时间是按列排的,也就是我有1000个数据,那么也就需要1000列,这个和dataframe的默认数据是转置的,也就是需要把dataframe的行变成列。

而在数据量很大的情况下,pandas的xlwt是不支持265行以上的,所以需要用xlsxwriter这个库,通过手动转换

把行列重新写入。

index就是列数,不断地写在第一行和第二行,就可以达到所要的需求了。

收起阅读 »

而在数据量很大的情况下,pandas的xlwt是不支持265行以上的,所以需要用xlsxwriter这个库,通过手动转换

import xlsxwriter #导入模块

workbook = xlsxwriter.Workbook('new_people.xlsx') #新建excel表

worksheet = workbook.add_worksheet('sheet1') #新建sheet(sheet的名称为"sheet1")

把行列重新写入。

for index,item in df.iterrows():

date=item['上市日期']

count=item['申购人数']

date=date.replace(' 00:00:00','')

worksheet.write(0,index,date)

worksheet.write(1,index,count)

workbook.close()

index就是列数,不断地写在第一行和第二行,就可以达到所要的需求了。

收起阅读 »

chrome浏览器右下加弹出广告

原因是你允许了部分网站的推送,地址栏打开chrome://settings/content/notifications

在提示通知里面,把所有允许的网站给移出就可以了

在提示通知里面,把所有允许的网站给移出就可以了

安装nodejs后新增的python把原来的python版本覆盖了

如果安装nodejs最后勾选了python环境,系统默认帮你装上最新的python版本,还自动把环境变量帮你加上,真是贴心。

解决办法:

win10: 打开环境变量,把第一个python39或者类似字样的环境变量往下移,最好移到最后。

解决办法:

win10: 打开环境变量,把第一个python39或者类似字样的环境变量往下移,最好移到最后。