通知设置 新通知

儿歌多多 下载全部儿歌视频文件

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 15871 次浏览 • 2017-09-28 23:44

http://30daydo.com/article/236

更新 ******** 2018-01-09*************

最近才发现以前曾经挖了这个坑,现在来完成它吧。

儿歌多多在爱奇艺的视频网站上也有全集,所以目标转为抓取iqiyi的儿歌多多视频列表。

github上有一个现成的下载iqiyi的第三方库,可以通过python调用这个库来实现下载功能。

代码使用python3来实现。

1. 打开网页 http://www.iqiyi.com/v_19rrkwcx6w.html#curid=455603300_26b870cbb10342a6b8a90f7f0b225685

这个是第一集的儿歌多多,url后面的curid只是一个随机的字符串,可以直接去掉。

url=“http://www.iqiyi.com/v_19rrkwcx6w.htm”

浏览器直接查看源码,里面直接包含了1-30集的视频url,那么要做的就是提取这30个url

先抓取网页内容:session = requests.Session()

def getContent(url):

try:

ret = session.get(url)

except:

return None

if ret.status_code==200:

return ret.text

else:

return None

然后提取内容中的url

点击查看大图

提取div标签中的属性 data-current-count=1的。然后选择子节点中的li标签,提取li中的a中的href链接即可。 content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

2. 有了url,就可以下载这个页面的中的内容了。

这里我使用的是一个第三方的视频下载库,you-get。(非常好用,fork到自己仓库研究 https://github.com/Rockyzsu/you-get)

使用方法:

python you-get -d --format=HD url

you-get 需要下载一个ffmpeg.exe的文件来解码视频流的,去官网就可以免费下载。

url就是你要下载的url地址,format可以选择高清还是其他格式的,我这里选择的是HD。

在python脚本里面调用另外一个python脚本,可以使用subprocess来调用。 p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

上面的song_url 就是接着最上面那个代码的。

完整代码如下:#-*-coding=utf-8-*-

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = session.get(url)

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

上面的是1-30集的,全部集数现在是120集,31-60的在url

http://www.iqiyi.com/v_19rrl2td7g.html

这个url只要你选择iqiyi视频的右边栏,就会自动变化。 同理也可以找到61-120的url,然后替换到上面代码中最开始的url就可以了。(这里因为页码少,所以就没有用循环去做)

最终的下载结果:

后面修改了下代码,判断文件是不是已经存在,存在的会就不下载,对于长时间下载100多个文件很有用,如果掉线了,重新下载就不会去下载那些已经下好的。#-*-coding=utf-8-*-

import sys,os

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = requests.get(url)

ret.encoding='utf-8'

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

if not content:

print "network issue, retry"

exit(0)

root = etree.HTML(content,parser=etree.HTMLParser(encoding='utf-8'))

elements=root.xpath('//div[@data-current-count="1"]//li')

for items in elements:

url_item=items.xpath('.//a/@href')[0]

song_url = url_item.replace('//','')

song_url=song_url.strip()

print(song_url)

# name=items.xpath('.//span[@class="item-num"]/text()')[0]

name=items.xpath('.//span[@class="item-num"]/text()')[0].encode('utf-8').strip()+\

' '+items.xpath('.//span[@class="item-txt"]/text()')[0].encode('utf-8').strip()+'.mp4'

name= '儿歌多多 '+name

name=name.decode('utf-8')

filename=os.path.join(os.getcwd(),name)

print filename

if os.path.exists(filename):

continue

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

下载下来大概300多集,直接拷贝到平板上离线播放,再也不卡了。

原创地址:http://30daydo.com/article/236

转载请注明出处

查看全部

http://30daydo.com/article/236

更新 ******** 2018-01-09*************

最近才发现以前曾经挖了这个坑,现在来完成它吧。

儿歌多多在爱奇艺的视频网站上也有全集,所以目标转为抓取iqiyi的儿歌多多视频列表。

github上有一个现成的下载iqiyi的第三方库,可以通过python调用这个库来实现下载功能。

代码使用python3来实现。

1. 打开网页 http://www.iqiyi.com/v_19rrkwcx6w.html#curid=455603300_26b870cbb10342a6b8a90f7f0b225685

这个是第一集的儿歌多多,url后面的curid只是一个随机的字符串,可以直接去掉。

url=“http://www.iqiyi.com/v_19rrkwcx6w.htm”

浏览器直接查看源码,里面直接包含了1-30集的视频url,那么要做的就是提取这30个url

先抓取网页内容:

session = requests.Session()

def getContent(url):

try:

ret = session.get(url)

except:

return None

if ret.status_code==200:

return ret.text

else:

return None

然后提取内容中的url

点击查看大图

提取div标签中的属性 data-current-count=1的。然后选择子节点中的li标签,提取li中的a中的href链接即可。

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

2. 有了url,就可以下载这个页面的中的内容了。

这里我使用的是一个第三方的视频下载库,you-get。(非常好用,fork到自己仓库研究 https://github.com/Rockyzsu/you-get)

使用方法:

python you-get -d --format=HD url

you-get 需要下载一个ffmpeg.exe的文件来解码视频流的,去官网就可以免费下载。

url就是你要下载的url地址,format可以选择高清还是其他格式的,我这里选择的是HD。

在python脚本里面调用另外一个python脚本,可以使用subprocess来调用。

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()上面的song_url 就是接着最上面那个代码的。

完整代码如下:

#-*-coding=utf-8-*-

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = session.get(url)

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

root = etree.HTML(content)

elements=root.xpath('//div[@data-current-count="1"]//li/a/@href')

for items in elements:

song_url = items.replace('//','')

song_url=song_url.strip()

print(song_url)

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

上面的是1-30集的,全部集数现在是120集,31-60的在url

http://www.iqiyi.com/v_19rrl2td7g.html

这个url只要你选择iqiyi视频的右边栏,就会自动变化。 同理也可以找到61-120的url,然后替换到上面代码中最开始的url就可以了。(这里因为页码少,所以就没有用循环去做)

最终的下载结果:

后面修改了下代码,判断文件是不是已经存在,存在的会就不下载,对于长时间下载100多个文件很有用,如果掉线了,重新下载就不会去下载那些已经下好的。

#-*-coding=utf-8-*-

import sys,os

import requests

from lxml import etree

import subprocess

session = requests.Session()

def getContent(url):

# url='http://www.iqiyi.com/v_19rrkwcx6w.html'

try:

ret = requests.get(url)

ret.encoding='utf-8'

# except Exception,e:

except:

# print e

return None

if ret.status_code==200:

return ret.text

else:

return None

def getUrl():

url='http://www.iqiyi.com/v_19rrkwcx6w.html'

url2='http://www.iqiyi.com/v_19rrl2td7g.html' # 31-61

content = getContent(url)

if not content:

print "network issue, retry"

exit(0)

root = etree.HTML(content,parser=etree.HTMLParser(encoding='utf-8'))

elements=root.xpath('//div[@data-current-count="1"]//li')

for items in elements:

url_item=items.xpath('.//a/@href')[0]

song_url = url_item.replace('//','')

song_url=song_url.strip()

print(song_url)

# name=items.xpath('.//span[@class="item-num"]/text()')[0]

name=items.xpath('.//span[@class="item-num"]/text()')[0].encode('utf-8').strip()+\

' '+items.xpath('.//span[@class="item-txt"]/text()')[0].encode('utf-8').strip()+'.mp4'

name= '儿歌多多 '+name

name=name.decode('utf-8')

filename=os.path.join(os.getcwd(),name)

print filename

if os.path.exists(filename):

continue

p=subprocess.Popen('python you-get -d --format=HD {}'.format(song_url),stderr=subprocess.PIPE,stdout=subprocess.PIPE,shell=True)

output,error = p.communicate()

print(output)

print(error)

p.wait()

def main():

getUrl()

if __name__ == '__main__':

main()

下载下来大概300多集,直接拷贝到平板上离线播放,再也不卡了。

原创地址:http://30daydo.com/article/236

转载请注明出处

蓝灯邀请码 KVJN7M

网络 • 李魔佛 发表了文章 • 0 个评论 • 11626 次浏览 • 2017-09-27 22:51

好友购买两年套餐后,会赠送双方3个月专业版;好友购买一年套餐后,则赠送双方1个月

用着感觉还不错,顺便推广下.

用不用邀请码随意, 只是用了后你会获得多一个月或者3个月的使用时间.

我当时也是在网上随意找了一个邀请码来用, 结果是无效的...... 目前这个邀请码KVJN7M 10年内有效. 查看全部

win7 修改mysql my.ini配置文件出错,提示文件被其他应用程序占用

网络安全 • 李魔佛 发表了文章 • 5 个评论 • 3382 次浏览 • 2017-09-24 15:58

select * from tb_advertiser.tb_advertiser into outfile 'tbads.xls';

结果出现了错误: The MySQL server is running with the --secure-file-priv option

于是按照网上的教程去修改my.ini的配置文件, 添加这一行:

secure_file_priv=' ' #-- 不对mysqld 的导入 导出做限制

结果保存的时候一直提示我的my.ini配置文件被占用, 当然理所当然的, 因为mysql正在运行着呢. 于是手工把mysql的所有的服务都关掉, 再重新编辑并保存,

不过这个报错还是照样出错.

折腾一番, 踩了写坑后, 尝试把myini的权限给修改成完全控制后, my.ini文件就可以被修改并保存了.

问题症结: 文件默认权限只能是user的. 需要把其他用户的权限给到my.ini配置文件 查看全部

select * from tb_advertiser.tb_advertiser into outfile 'tbads.xls';

结果出现了错误: The MySQL server is running with the --secure-file-priv option

于是按照网上的教程去修改my.ini的配置文件, 添加这一行:

secure_file_priv=' ' #-- 不对mysqld 的导入 导出做限制

结果保存的时候一直提示我的my.ini配置文件被占用, 当然理所当然的, 因为mysql正在运行着呢. 于是手工把mysql的所有的服务都关掉, 再重新编辑并保存,

不过这个报错还是照样出错.

折腾一番, 踩了写坑后, 尝试把myini的权限给修改成完全控制后, my.ini文件就可以被修改并保存了.

问题症结: 文件默认权限只能是user的. 需要把其他用户的权限给到my.ini配置文件

30天学会django

python • 李魔佛 发表了文章 • 0 个评论 • 3442 次浏览 • 2017-09-17 23:40

先放个标题出来。 每天不定时更新。

我用的视频教程是cstv的那一个系列教程。

不推荐那个django中文手册的,因为文档比较旧,很多命令或者代码是无法再新版的django上运行通过的。 这个会比较打击人。

查看全部

先放个标题出来。 每天不定时更新。

我用的视频教程是cstv的那一个系列教程。

不推荐那个django中文手册的,因为文档比较旧,很多命令或者代码是无法再新版的django上运行通过的。 这个会比较打击人。

批量下载懒人听书mp3文件

python爬虫 • 李魔佛 发表了文章 • 7 个评论 • 32689 次浏览 • 2017-09-14 01:09

只有安装app后才能下载。

装了app也只能一个一个地去下载,所以索性一次过下载全部的音频吧。

方法很简单,代码很短。 你也可以看得懂。

以财经郎眼的节目音频为例。 其他的节目内容方法差不多的。

浏览器打开页面:

http://www.lrts.me/book/32551

然后按F12打开调试窗口,我用的是chrome

然后看到网页底下有下一页的按钮,点击下一页,看看每一页的url. 就能找到具体的下一页的url.

(待续)

python代码:# coding: utf-8

# http://30daydo.com

import urllib

import os

import requests

import time

from lxml import etree

from header_toolkit import getheader

def spider():

curr=os.getcwd()

target_dir=os.path.join(curr,'data')

if not os.path.exists(target_dir):

os.mkdir(target_dir)

for i in range(1, 100, 10):

url = 'http://www.lrts.me/ajax/playlist/2/32551/%d' % i

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

s = requests.get(url=url, headers=headers)

tree = etree.HTML(s.text)

nodes = tree.xpath('//*[starts-with(@class,"clearfix section-item section")]')

print len(nodes)

for node in nodes:

filename = node.xpath('.//div[@class="column1 nowrap"]/span/text()')[0]

link = node.xpath('.//input[@name="source" and @type="hidden"]/@value')[0]

print link

post_fix=link.split('.')[-1]

full_path= filename+'.'+post_fix

urllib.urlretrieve(link, filename=os.path.join(target_dir,full_path))

time.sleep(1)

if __name__ == '__main__':

spider()

抓取的内容:

原创文章,转载请注明出处:

http://30daydo.com/article/231

需要下载的打包数据可以留下邮箱或者私信。

查看全部

只有安装app后才能下载。

装了app也只能一个一个地去下载,所以索性一次过下载全部的音频吧。

方法很简单,代码很短。 你也可以看得懂。

以财经郎眼的节目音频为例。 其他的节目内容方法差不多的。

浏览器打开页面:

http://www.lrts.me/book/32551

然后按F12打开调试窗口,我用的是chrome

然后看到网页底下有下一页的按钮,点击下一页,看看每一页的url. 就能找到具体的下一页的url.

(待续)

python代码:

# coding: utf-8

# http://30daydo.com

import urllib

import os

import requests

import time

from lxml import etree

from header_toolkit import getheader

def spider():

curr=os.getcwd()

target_dir=os.path.join(curr,'data')

if not os.path.exists(target_dir):

os.mkdir(target_dir)

for i in range(1, 100, 10):

url = 'http://www.lrts.me/ajax/playlist/2/32551/%d' % i

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

s = requests.get(url=url, headers=headers)

tree = etree.HTML(s.text)

nodes = tree.xpath('//*[starts-with(@class,"clearfix section-item section")]')

print len(nodes)

for node in nodes:

filename = node.xpath('.//div[@class="column1 nowrap"]/span/text()')[0]

link = node.xpath('.//input[@name="source" and @type="hidden"]/@value')[0]

print link

post_fix=link.split('.')[-1]

full_path= filename+'.'+post_fix

urllib.urlretrieve(link, filename=os.path.join(target_dir,full_path))

time.sleep(1)

if __name__ == '__main__':

spider()

抓取的内容:

原创文章,转载请注明出处:

http://30daydo.com/article/231

需要下载的打包数据可以留下邮箱或者私信。

怎么判断你用的代理是高度匿名还是透明的

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 9100 次浏览 • 2017-09-06 20:42

你用透明代理上QQ,对方还是能看到你的本来的IP

只有用匿名和高匿名才不会被对方看到IP.

详细的说:

匿名代理:

如果从隐藏使用代理用户的级别上划分,代理可以分为三种,即高度匿名代理、普通匿名代理和透明代理。

(1)高度匿名代理不改变客户机的请求,这样在服务器看来就像有个真正的客户浏览器在访问它,这时客户的真实IP是隐藏的,服务器端不会认为我们使用了代理。

(2)普通匿名代理能隐藏客户机的真实IP,但会改变我们的请求信息,服务器端有可能会认为我们使用了代理。不过使用此种代理时,虽然被访问的网站不能知道你的ip地址,但仍然可以知道你在使用代理,当然某些能够侦测ip的网页仍然可以查到你的ip。

(3)透明代理,它不但改变了我们的请求信息,还会传送真实的IP地址。

三者隐藏使用代理者身份的级别依次为高度匿名代理最隐蔽,其次是普通匿名代理,最差的是透明代理。

把你找到的代理iP,在你的浏览器里设置一下, 具体可以百度谷歌, 不难.

然后用浏览器打开这个网站:

http://members.3322.org/dyndns/getip

网站返回很简单, 就是你当前的iP地址. 据目前使用那么多的检测iP地址的网站来看,这个网站最准.

用代理打开这个网站,如果网站显示的是你代理IP,那么说明你的ip是高度匿名的.

如果网站显示的是有2个ip,那么你的代理是透明的, 第一个ip是你的原始ip,而第二个ip是你用的代理ip.

查看全部

你用透明代理上QQ,对方还是能看到你的本来的IP

只有用匿名和高匿名才不会被对方看到IP.

详细的说:

匿名代理:

如果从隐藏使用代理用户的级别上划分,代理可以分为三种,即高度匿名代理、普通匿名代理和透明代理。

(1)高度匿名代理不改变客户机的请求,这样在服务器看来就像有个真正的客户浏览器在访问它,这时客户的真实IP是隐藏的,服务器端不会认为我们使用了代理。

(2)普通匿名代理能隐藏客户机的真实IP,但会改变我们的请求信息,服务器端有可能会认为我们使用了代理。不过使用此种代理时,虽然被访问的网站不能知道你的ip地址,但仍然可以知道你在使用代理,当然某些能够侦测ip的网页仍然可以查到你的ip。

(3)透明代理,它不但改变了我们的请求信息,还会传送真实的IP地址。

三者隐藏使用代理者身份的级别依次为高度匿名代理最隐蔽,其次是普通匿名代理,最差的是透明代理。

把你找到的代理iP,在你的浏览器里设置一下, 具体可以百度谷歌, 不难.

然后用浏览器打开这个网站:

http://members.3322.org/dyndns/getip

网站返回很简单, 就是你当前的iP地址. 据目前使用那么多的检测iP地址的网站来看,这个网站最准.

用代理打开这个网站,如果网站显示的是你代理IP,那么说明你的ip是高度匿名的.

如果网站显示的是有2个ip,那么你的代理是透明的, 第一个ip是你的原始ip,而第二个ip是你用的代理ip.

mongodb中$sum:1 后面的1是什么意思

python • 李魔佛 发表了文章 • 0 个评论 • 10392 次浏览 • 2017-09-05 23:32

{

"_id" : "GuqXmAkkARqhBDqhy",

"beatmapset_id" : "342537",

"version" : "MX",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "3.5552737712860107"

}

{

"_id" : "oHLT7KqsB7bztBGvu",

"beatmapset_id" : "342537",

"version" : "HD",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "2.7515676021575928"

}

{

"_id" : "GbotZfrPEwW69FkGD",

"beatmapset_id" : "342537",

"version" : "NM",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "0"

}

然后运行以下的命令:

db.getCollection('dup_case').aggregate(

[

{$group:{

_id:{diff_approach:'$diff_approach'},

count:{$sum:2}

}},

{$match:{count:{$gt:1}}}

]

)

返回的count是6

所以

$sum:1 的含义:

如果前面的情况出现一次,就加1, 如果后面$sum:2 那么每次前面条件满足一次就加2

查看全部

{

"_id" : "GuqXmAkkARqhBDqhy",

"beatmapset_id" : "342537",

"version" : "MX",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "3.5552737712860107"

}

{

"_id" : "oHLT7KqsB7bztBGvu",

"beatmapset_id" : "342537",

"version" : "HD",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "2.7515676021575928"

}

{

"_id" : "GbotZfrPEwW69FkGD",

"beatmapset_id" : "342537",

"version" : "NM",

"diff_approach" : "5",

"artist" : "Yousei Teikoku",

"title" : "Kokou no Sousei",

"difficultyrating" : "0"

}然后运行以下的命令:

db.getCollection('dup_case').aggregate(

[

{$group:{

_id:{diff_approach:'$diff_approach'},

count:{$sum:2}

}},

{$match:{count:{$gt:1}}}

]

) 返回的count是6

所以

$sum:1 的含义:

如果前面的情况出现一次,就加1, 如果后面$sum:2 那么每次前面条件满足一次就加2

python print 打印 % 百分号

python • 李魔佛 发表了文章 • 0 个评论 • 16987 次浏览 • 2017-09-05 21:27

当时的解决方式是这样的:

a = 1

print "a values is ", a, "%"

把百分号切割开来.

后来才知道,正确显示百分号的方法:

print 'a values is %d%%' %a

用2个百分号来标示.

查看全部

当时的解决方式是这样的:

a = 1

print "a values is ", a, "%"

把百分号切割开来.

后来才知道,正确显示百分号的方法:

print 'a values is %d%%' %a

用2个百分号来标示.

Python 学习笔记2.1 ——数据类型和结构

python • sicily02 发表了文章 • 2 个评论 • 3114 次浏览 • 2017-08-29 13:22

Python版本:3.6.0

学习内容: 量化分析师的Python日记【第1天:谁来给我讲讲Python?】 以下为转载加自己的笔记

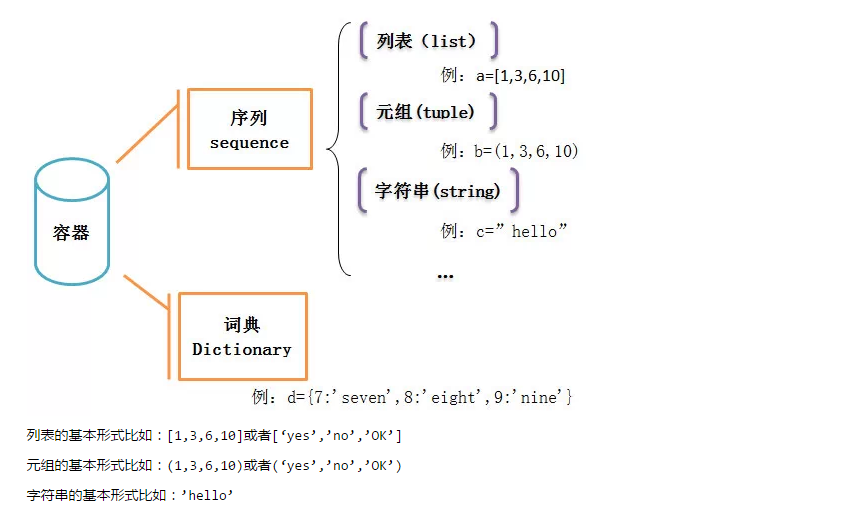

一、容器

1,什么是容器

Python中有一种名为容器的数据结构,包括序列和字典,序列又包括列表、元组、字符串等

列表的基本形式比如:[1,3,6,10]或者[‘yes’,’no’,’OK’]

元组的基本形式比如:(1,3,6,10)或者(‘yes’,’no’,’OK’)

字符串的基本形式比如:’hello’

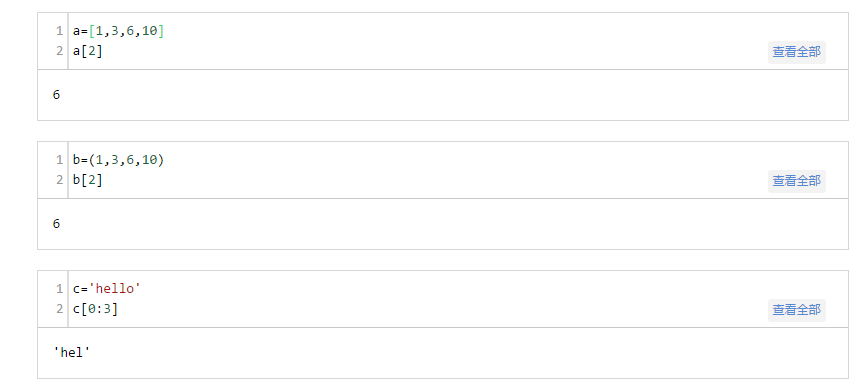

以上几种属于序列,序列中的每一个元素都被分配一个序号——即元素的位置,也称为“索引”,第一个索引,即第一个元素的位置是0,第二个是1,依次类推。列表和元组的区别主要在于,列表可以修改,而元组不能(注意列表用中括号而元组用括号)。

索引是从0开始的

2. 序列的一些通用操作

除了上面说到的索引,列表、元组、字符串等这些序列还有一些共同的操作。

(1)索引(补充上面)

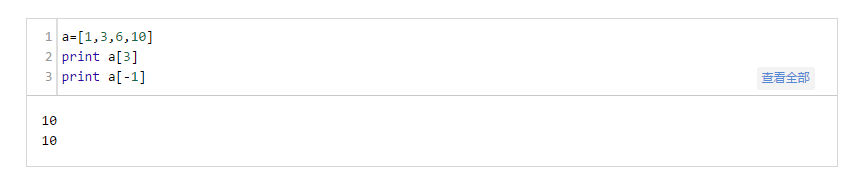

序列的最后一个元素的索引,也可以是-1,倒数第二个也可以用-2,依次类推:

(2)分片

使用分片操作来访问一定范围内的元素,它的格式为:

a[开始索引:结束索引:步长]

那么访问的是,从开始索引号的那个元素,到结束索引号-1的那个元素,每间隔步长个元素访问一次,步长可以忽略,默认步长为1。

查看全部

Python版本:3.6.0

学习内容: 量化分析师的Python日记【第1天:谁来给我讲讲Python?】 以下为转载加自己的笔记

一、容器

1,什么是容器

Python中有一种名为容器的数据结构,包括序列和字典,序列又包括列表、元组、字符串等

列表的基本形式比如:[1,3,6,10]或者[‘yes’,’no’,’OK’]

元组的基本形式比如:(1,3,6,10)或者(‘yes’,’no’,’OK’)

字符串的基本形式比如:’hello’

以上几种属于序列,序列中的每一个元素都被分配一个序号——即元素的位置,也称为“索引”,第一个索引,即第一个元素的位置是0,第二个是1,依次类推。列表和元组的区别主要在于,列表可以修改,而元组不能(注意列表用中括号而元组用括号)。

索引是从0开始的

2. 序列的一些通用操作

除了上面说到的索引,列表、元组、字符串等这些序列还有一些共同的操作。

(1)索引(补充上面)

序列的最后一个元素的索引,也可以是-1,倒数第二个也可以用-2,依次类推:

(2)分片

使用分片操作来访问一定范围内的元素,它的格式为:

a[开始索引:结束索引:步长]

那么访问的是,从开始索引号的那个元素,到结束索引号-1的那个元素,每间隔步长个元素访问一次,步长可以忽略,默认步长为1。

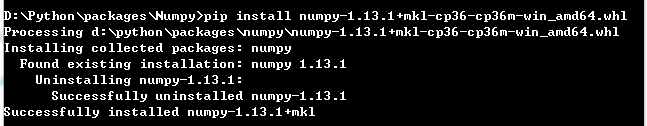

Python 学习笔记1.2——第三方库安装

python • sicily02 发表了文章 • 0 个评论 • 2451 次浏览 • 2017-08-27 18:23

python版本:3.6.0

一、前往第三方网站下载所需要的包

http://www.lfd.uci.edu/~gohlke/pythonlibs/

二、使用pip安装

pip install xxx

查看全部

python版本:3.6.0

一、前往第三方网站下载所需要的包

http://www.lfd.uci.edu/~gohlke/pythonlibs/

二、使用pip安装

pip install xxx

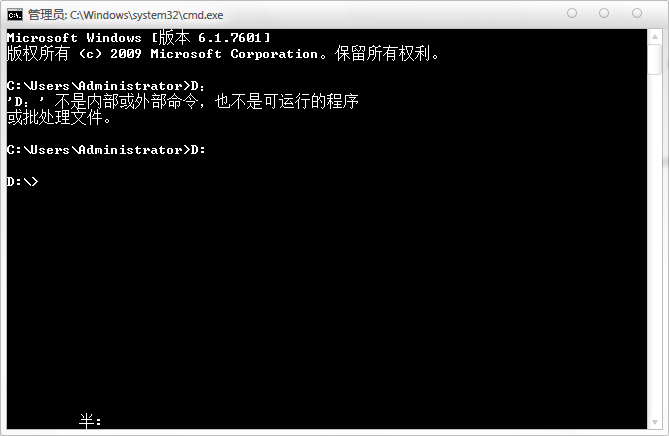

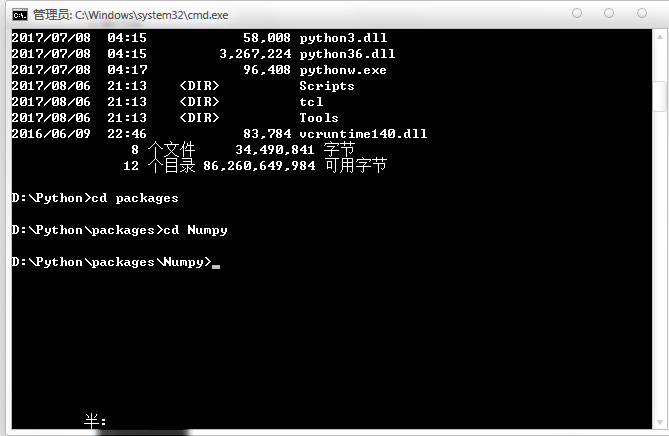

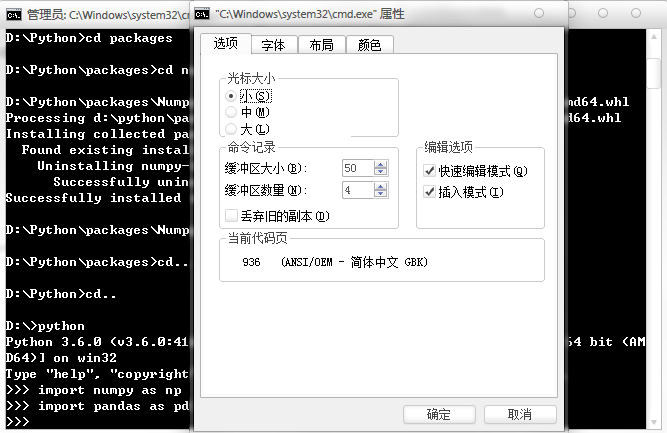

Python 学习笔记 1.1——cmd操作

python • sicily02 发表了文章 • 2 个评论 • 2920 次浏览 • 2017-08-27 15:21

安装的python版本:3.6.0

一、目录切换

1、如果要访问D盘,先输入D:

2、如果要进入D盘里某一个文件夹,再输入cd Python(比如我要进入D盘下的Python文件夹)

如果还要再往里 继续cd XXX

3、返回上级目录 cd..

二、如何在cmd中使用复制粘贴

右键cmd窗口的标题栏,点击属性,勾选快速编辑模式,再确定

粘贴时,按 Alt space E P

查看全部

python redis 笔记

python • 李魔佛 发表了文章 • 0 个评论 • 2615 次浏览 • 2017-08-24 20:33

踩坑也不是什么坏事,不过浪费点时间而已。

1. 配置文件redis.config

如果你要远程访问你的redis服务器,那么里面有一行你一定要注释掉:

# bind 127.0.0.1

解释:

# 指定 redis 只接收来自于该 IP 地址的请求,如果不进行设置,那么将处理所有请求

# bind 192.168.1.100 10.0.0.1

# bind 127.0.0.1

当时调了半天没连上去,就是被这个参数给害的。

2. redis-cli 连接本地redis服务器。 本地服务器端口已经改变。

开始使用redis-cli 127.0.0.1:8888 结果是一直都出错。

然后在某个配置文档看到测试本地端口,使用的命令是 redis-cli -p 8888

不然上面的永远都会连着6379.

待续。 不定期更新。

查看全部

踩坑也不是什么坏事,不过浪费点时间而已。

1. 配置文件redis.config

如果你要远程访问你的redis服务器,那么里面有一行你一定要注释掉:

# bind 127.0.0.1

解释:

# 指定 redis 只接收来自于该 IP 地址的请求,如果不进行设置,那么将处理所有请求

# bind 192.168.1.100 10.0.0.1

# bind 127.0.0.1

当时调了半天没连上去,就是被这个参数给害的。

2. redis-cli 连接本地redis服务器。 本地服务器端口已经改变。

开始使用redis-cli 127.0.0.1:8888 结果是一直都出错。

然后在某个配置文档看到测试本地端口,使用的命令是 redis-cli -p 8888

不然上面的永远都会连着6379.

待续。 不定期更新。

lxml.etree._ElementUnicodeResult 转为字符

python爬虫 • 李魔佛 发表了文章 • 0 个评论 • 21919 次浏览 • 2017-08-14 15:57

address=each.xpath('.//address/text()')[0].strip()

结果用address与一般的字符进行拼接时,总是出现

UnicodeDecodeError: 'ascii' codec can't decode byte 0xe4 in position 0: ordinal not in range(128)

这种错误。

主要因为python2的蛋疼的编码原因。

解决办法:

根据lxml的官方文档:http://lxml.de/api/lxml.etree._ElementUnicodeResult-class.html

object --+ | basestring --+ | unicode --+ | _ElementUnicodeResult

_ElementUnicodeResult 是unicode的一个子类。

那么可以直接将它转为unicode

address.encode('utf-8') 就可以了。

查看全部

address=each.xpath('.//address/text()')[0].strip()

结果用address与一般的字符进行拼接时,总是出现

UnicodeDecodeError: 'ascii' codec can't decode byte 0xe4 in position 0: ordinal not in range(128)

这种错误。

主要因为python2的蛋疼的编码原因。

解决办法:

根据lxml的官方文档:http://lxml.de/api/lxml.etree._ElementUnicodeResult-class.html

object --+ | basestring --+ | unicode --+ | _ElementUnicodeResult

_ElementUnicodeResult 是unicode的一个子类。

那么可以直接将它转为unicode

address.encode('utf-8') 就可以了。

修改python的默认最大递归层数

python • 李魔佛 发表了文章 • 0 个评论 • 5359 次浏览 • 2017-08-10 16:00

运行下面的代码:

def recursion(n):

if(n <= 0):

print n

return

print n

recursion(n - 1)

if __name__ == "__main__":

recursion(1200)

返回下面的错误:

File "C:/Git/base_function/resursion_usage.py", line 7, in recursion

recursion(n - 1)

RuntimeError: maximum recursion depth exceeded

解决办法: 修改python默认的递归层数。

在程序开头的地方添加以下语句:

import sys

sys.setrecursionlimit(1500)

然后再次运行,就不会有上面的错误信息了。

查看全部

运行下面的代码:

def recursion(n):

if(n <= 0):

print n

return

print n

recursion(n - 1)

if __name__ == "__main__":

recursion(1200)

返回下面的错误:

File "C:/Git/base_function/resursion_usage.py", line 7, in recursion

recursion(n - 1)

RuntimeError: maximum recursion depth exceeded

解决办法: 修改python默认的递归层数。

在程序开头的地方添加以下语句:

import sys

sys.setrecursionlimit(1500)

然后再次运行,就不会有上面的错误信息了。

apt-get安装软件时 需要依赖更低版本的依赖库 通用解决办法

Linux • 李魔佛 发表了文章 • 0 个评论 • 6421 次浏览 • 2017-08-08 23:35

xda@xda-dt:~$ sudo apt-get install sqlite3 libsqlite3-0=3.7.9-2ubuntu1.1

Reading package lists... Done

Building dependency tree

Reading state information... Done

libsqlite3-0 is already the newest version.

Some packages could not be installed. This may mean that you have

requested an impossible situation or if you are using the unstable

distribution that some required packages have not yet been created

or been moved out of Incoming.

The following information may help to resolve the situation:

The following packages have unmet dependencies:

sqlite3 : Depends: libsqlite3-0 (= 3.7.9-2ubuntu1) but 3.7.9-2ubuntu1.1 is to be installed

E: Unable to correct problems, you have held broken packages.

会出现上面的问题。

方法1,使用aptitude 安装。

xda@xda-dt:~$ sudo aptitude install sqlite3

The following NEW packages will be installed:

sqlite3{b}

0 packages upgraded, 1 newly installed, 0 to remove and 0 not upgraded.

Need to get 26.9 kB of archives. After unpacking 174 kB will be used.

The following packages have unmet dependencies:

sqlite3 : Depends: libsqlite3-0 (= 3.7.9-2ubuntu1) but 3.7.9-2ubuntu1.1 is installed.

The following actions will resolve these dependencies:

Keep the following packages at their current version:

1) sqlite3 [Not Installed]

Accept this solution? [Y/n/q/?] n

The following actions will resolve these dependencies:

Downgrade the following packages:

1) libsqlite3-0 [3.7.9-2ubuntu1.1 (now) -> 3.7.9-2ubuntu1 (precise)]

Accept this solution? [Y/n/q/?] Y

The following packages will be DOWNGRADED:

libsqlite3-0

The following NEW packages will be installed:

sqlite3

0 packages upgraded, 1 newly installed, 1 downgraded, 0 to remove and 0 not upgraded.

Need to get 375 kB of archives. After unpacking 174 kB will be used.

Do you want to continue? [Y/n/?] Y

Get: 1 http://hk.archive.ubuntu.com/ubuntu/ precise/main libsqlite3-0 amd64 3.7.9-2ubuntu1 [348 kB]

Get: 2 http://hk.archive.ubuntu.com/ubuntu/ precise/main sqlite3 amd64 3.7.9-2ubuntu1 [26.9 kB]

Fetched 375 kB in 1s (306 kB/s)

dpkg: warning: downgrading libsqlite3-0 from 3.7.9-2ubuntu1.1 to 3.7.9-2ubuntu1.

(Reading database ... 162912 files and directories currently installed.)

Preparing to replace libsqlite3-0 3.7.9-2ubuntu1.1 (using .../libsqlite3-0_3.7.9-2ubuntu1_amd64.deb) ...

Unpacking replacement libsqlite3-0 ...

Selecting previously unselected package sqlite3.

Unpacking sqlite3 (from .../sqlite3_3.7.9-2ubuntu1_amd64.deb) ...

Processing triggers for man-db ...

Setting up libsqlite3-0 (3.7.9-2ubuntu1) ...

Setting up sqlite3 (3.7.9-2ubuntu1) ...

Processing triggers for libc-bin ...

ldconfig deferred processing now taking place

xda@xda-dt:~$ sqlite3

SQLite version 3.7.9 2011-11-01 00:52:41

Enter ".help" for instructions

Enter SQL statements terminated with a ";"

sqlite> .exit

查看全部

xda@xda-dt:~$ sudo apt-get install sqlite3 libsqlite3-0=3.7.9-2ubuntu1.1

Reading package lists... Done

Building dependency tree

Reading state information... Done

libsqlite3-0 is already the newest version.

Some packages could not be installed. This may mean that you have

requested an impossible situation or if you are using the unstable

distribution that some required packages have not yet been created

or been moved out of Incoming.

The following information may help to resolve the situation:

The following packages have unmet dependencies:

sqlite3 : Depends: libsqlite3-0 (= 3.7.9-2ubuntu1) but 3.7.9-2ubuntu1.1 is to be installed

E: Unable to correct problems, you have held broken packages.

会出现上面的问题。

方法1,使用aptitude 安装。

xda@xda-dt:~$ sudo aptitude install sqlite3

The following NEW packages will be installed:

sqlite3{b}

0 packages upgraded, 1 newly installed, 0 to remove and 0 not upgraded.

Need to get 26.9 kB of archives. After unpacking 174 kB will be used.

The following packages have unmet dependencies:

sqlite3 : Depends: libsqlite3-0 (= 3.7.9-2ubuntu1) but 3.7.9-2ubuntu1.1 is installed.

The following actions will resolve these dependencies:

Keep the following packages at their current version:

1) sqlite3 [Not Installed]

Accept this solution? [Y/n/q/?] n

The following actions will resolve these dependencies:

Downgrade the following packages:

1) libsqlite3-0 [3.7.9-2ubuntu1.1 (now) -> 3.7.9-2ubuntu1 (precise)]

Accept this solution? [Y/n/q/?] Y

The following packages will be DOWNGRADED:

libsqlite3-0

The following NEW packages will be installed:

sqlite3

0 packages upgraded, 1 newly installed, 1 downgraded, 0 to remove and 0 not upgraded.

Need to get 375 kB of archives. After unpacking 174 kB will be used.

Do you want to continue? [Y/n/?] Y

Get: 1 http://hk.archive.ubuntu.com/ubuntu/ precise/main libsqlite3-0 amd64 3.7.9-2ubuntu1 [348 kB]

Get: 2 http://hk.archive.ubuntu.com/ubuntu/ precise/main sqlite3 amd64 3.7.9-2ubuntu1 [26.9 kB]

Fetched 375 kB in 1s (306 kB/s)

dpkg: warning: downgrading libsqlite3-0 from 3.7.9-2ubuntu1.1 to 3.7.9-2ubuntu1.

(Reading database ... 162912 files and directories currently installed.)

Preparing to replace libsqlite3-0 3.7.9-2ubuntu1.1 (using .../libsqlite3-0_3.7.9-2ubuntu1_amd64.deb) ...

Unpacking replacement libsqlite3-0 ...

Selecting previously unselected package sqlite3.

Unpacking sqlite3 (from .../sqlite3_3.7.9-2ubuntu1_amd64.deb) ...

Processing triggers for man-db ...

Setting up libsqlite3-0 (3.7.9-2ubuntu1) ...

Setting up sqlite3 (3.7.9-2ubuntu1) ...

Processing triggers for libc-bin ...

ldconfig deferred processing now taking place

xda@xda-dt:~$ sqlite3

SQLite version 3.7.9 2011-11-01 00:52:41

Enter ".help" for instructions

Enter SQL statements terminated with a ";"

sqlite> .exit

编译cmake到更新的版本 【ubuntu】

Linux • 李魔佛 发表了文章 • 0 个评论 • 5974 次浏览 • 2017-08-05 23:31

如果只是使用命令:

sudo apt-get install cmake 或者sudo apt-get upgrade cmake

获取到的版本还是2.8.7

正确的做法:

cd ~/Downloads/

wget http://www.cmake.org/files/v2. ... ar.gz

tar xzvf cmake-2.8.10.tar.gz

cd cmake-2.8.10

./configure

make -j4

sudo make install

关闭命令行后重新开一个命令行,然后运行 cmake --version, 就可以看到你的cmake已经更新到你要的版本。 查看全部

如果只是使用命令:

sudo apt-get install cmake 或者sudo apt-get upgrade cmake

获取到的版本还是2.8.7

正确的做法:

cd ~/Downloads/

wget http://www.cmake.org/files/v2. ... ar.gz

tar xzvf cmake-2.8.10.tar.gz

cd cmake-2.8.10

./configure

make -j4

sudo make install

关闭命令行后重新开一个命令行,然后运行 cmake --version, 就可以看到你的cmake已经更新到你要的版本。

斐讯路由器强制推送广告

网络安全 • 李魔佛 发表了文章 • 2 个评论 • 4730 次浏览 • 2017-08-05 21:58

后面方法,居然在我这个网站上都出现,于是上网一搜。 果然发现斐讯被扒的文章。

http://www.right.com.cn/forum/thread-227504-1-1.html

查看全部

后面方法,居然在我这个网站上都出现,于是上网一搜。 果然发现斐讯被扒的文章。

http://www.right.com.cn/forum/thread-227504-1-1.html

在uefi主板上安装ubuntu,grub一直无法写入

Linux • 李魔佛 发表了文章 • 0 个评论 • 8531 次浏览 • 2017-08-05 19:57

因为要安装ubuntu,所以使用ultraISO烧录的启动u盘,然后u盘启动。

重启后,顺利进入安装界面,一路下去后。 最后卡在 grub安装出错的界面处。

因为用的是最新的ubuntu16.04,所以开始以为是系统兼容性问题,所以就降级到12.04。 用ultraISO重新烧录可启动U盘。

结果问题依然存在,所以排除系统问题,因为以前在其他机子上装过很多次12.04了。

于是到ubuntu官网上搜了一下,发现这个很多人遇到问题。

解决方案无非有2个,一个是禁用uefi模式,一个是创建efi分区。

然后自己自己折腾自己的bios设置。 技嘉的板子没有直接禁用uefi的选项,百度之。 原来一部分主板bios的uefi的设置选项,是CSM, 这个选项默认是开启的了,然后把个功能关闭, 然后重新安装,问题还是出现。

而此之后,启动设备的优先级里面,一直会出现一个ubuntu的选项。

重置bios设置,这个选项会一直都在。

然后无解,只能用第二种方法。 启动uefi,在安装ubuntu过程中,分区选项里面,选择手工分区,分了以下分区:

/

/boot

/home

swap

/efi (一定要这个分区)

划分上面分区,系统不再出现grub安装失败的错误。 可是,系统重启后,系统就会挂掉,很不稳定。

后来重试了几次,没办法,重试第一次的方法。 这一次,我把主板的电池扣掉,放电几分钟。 然后进bios,重新禁用CSM, 重装。 使用默认的分区方法, 然后重要成功了。

查看全部

因为要安装ubuntu,所以使用ultraISO烧录的启动u盘,然后u盘启动。

重启后,顺利进入安装界面,一路下去后。 最后卡在 grub安装出错的界面处。

因为用的是最新的ubuntu16.04,所以开始以为是系统兼容性问题,所以就降级到12.04。 用ultraISO重新烧录可启动U盘。

结果问题依然存在,所以排除系统问题,因为以前在其他机子上装过很多次12.04了。

于是到ubuntu官网上搜了一下,发现这个很多人遇到问题。

解决方案无非有2个,一个是禁用uefi模式,一个是创建efi分区。

然后自己自己折腾自己的bios设置。 技嘉的板子没有直接禁用uefi的选项,百度之。 原来一部分主板bios的uefi的设置选项,是CSM, 这个选项默认是开启的了,然后把个功能关闭, 然后重新安装,问题还是出现。

而此之后,启动设备的优先级里面,一直会出现一个ubuntu的选项。

重置bios设置,这个选项会一直都在。

然后无解,只能用第二种方法。 启动uefi,在安装ubuntu过程中,分区选项里面,选择手工分区,分了以下分区:

/

/boot

/home

swap

/efi (一定要这个分区)

划分上面分区,系统不再出现grub安装失败的错误。 可是,系统重启后,系统就会挂掉,很不稳定。

后来重试了几次,没办法,重试第一次的方法。 这一次,我把主板的电池扣掉,放电几分钟。 然后进bios,重新禁用CSM, 重装。 使用默认的分区方法, 然后重要成功了。

树莓派上安装redis-server 亲测

树莓派 • 李魔佛 发表了文章 • 0 个评论 • 6216 次浏览 • 2017-07-17 23:47

1. 下载源码压缩包:

官方网址: https://redis.io/download

下载下来的格式为tar.gz

通过命令行解压: tar xvfz xxxxxx.tar.gz

2. 解压后进入 redis-4.0.0的目录,然后执行命令: make

3. 等待源码编译(树莓派上有点久), 见到这一行:Hint: It's a good idea to run 'make test' ;)

说明你安装成功了

4. 编译成功后, 记得运行命令 sudo src/redis-server

来启动redis server。

成功运行后的文字界面:

12718:C 17 Jul 23:09:24.447 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

12718:C 17 Jul 23:09:24.448 # Redis version=4.0.0, bits=64, commit=00000000, modified=0, pid=12718, just started

12718:C 17 Jul 23:09:24.448 # Warning: no config file specified, using the default config. In order to specify a config file use src/redis-server /path/to/redis.conf

12718:M 17 Jul 23:09:24.450 * Increased maximum number of open files to 10032 (it was originally set to 256).

_._

_.-``__ ''-._

_.-`` `. `_. ''-._ Redis 4.0.0 (00000000/0) 64 bit

.-`` .-```. ```\/ _.,_ ''-._

( ' , .-` | `, ) Running in standalone mode

|`-._`-...-` __...-.``-._|'` _.-'| Port: 6379

| `-._ `._ / _.-' | PID: 12718

`-._ `-._ `-./ _.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' | http://redis.io

`-._ `-._`-.__.-'_.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' |

`-._ `-._`-.__.-'_.-' _.-'

`-._ `-.__.-' _.-'

`-._ _.-'

`-.__.-'

12718:M 17 Jul 23:09:24.451 # Server initialized

12718:M 17 Jul 23:09:24.451 * Ready to accept connections 查看全部

1. 下载源码压缩包:

官方网址: https://redis.io/download

下载下来的格式为tar.gz

通过命令行解压: tar xvfz xxxxxx.tar.gz

2. 解压后进入 redis-4.0.0的目录,然后执行命令: make

3. 等待源码编译(树莓派上有点久), 见到这一行:Hint: It's a good idea to run 'make test' ;)

说明你安装成功了

4. 编译成功后, 记得运行命令 sudo src/redis-server

来启动redis server。

成功运行后的文字界面:

12718:C 17 Jul 23:09:24.447 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

12718:C 17 Jul 23:09:24.448 # Redis version=4.0.0, bits=64, commit=00000000, modified=0, pid=12718, just started

12718:C 17 Jul 23:09:24.448 # Warning: no config file specified, using the default config. In order to specify a config file use src/redis-server /path/to/redis.conf

12718:M 17 Jul 23:09:24.450 * Increased maximum number of open files to 10032 (it was originally set to 256).

_._

_.-``__ ''-._

_.-`` `. `_. ''-._ Redis 4.0.0 (00000000/0) 64 bit

.-`` .-```. ```\/ _.,_ ''-._

( ' , .-` | `, ) Running in standalone mode

|`-._`-...-` __...-.``-._|'` _.-'| Port: 6379

| `-._ `._ / _.-' | PID: 12718

`-._ `-._ `-./ _.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' | http://redis.io

`-._ `-._`-.__.-'_.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' |

`-._ `-._`-.__.-'_.-' _.-'

`-._ `-.__.-' _.-'

`-._ _.-'

`-.__.-'

12718:M 17 Jul 23:09:24.451 # Server initialized

12718:M 17 Jul 23:09:24.451 * Ready to accept connections

python matplotlib 中的plot legend的用法

python • 李魔佛 发表了文章 • 0 个评论 • 22938 次浏览 • 2017-07-13 11:59

不过对于大部分人来说,英文教程,加上上面的例子有点晦涩。

所以以个人的理解,简单地用代码介绍下。 import matplotlib.pyplot as plt

import numpy as np

x = np.arange(10)

print x

fig = plt.figure()

ax = plt.subplot(111)

for i in xrange(5):

#ax.plot(x, i * x, label='y=%dx' %i)

ax.plot(x, i * x, label='$y = %ix$' % i)

ax.legend()

plt.show()

运行上面的代码后,得到的结果是:

如果把那句legend() 的语句去掉,那么图形上的图例也就会消失了。

所以legend()的主要只用就是用于在图上标明一个图例,用于说明每条曲线的文字显示。 你也可以把图例控制在左边,右边,底下等等。

实际使用中,legend()有一个loc参数,用于控制图例的位置。 比如 plot.legend(loc=2) , 这个位置就是4象项中的第二象项,也就是左上角。 loc可以为1,2,3,4 这四个数字。

原文连接:

http://30daydo.com/article/215

转载请注明出处 查看全部

不过对于大部分人来说,英文教程,加上上面的例子有点晦涩。

所以以个人的理解,简单地用代码介绍下。

import matplotlib.pyplot as plt

import numpy as np

x = np.arange(10)

print x

fig = plt.figure()

ax = plt.subplot(111)

for i in xrange(5):

#ax.plot(x, i * x, label='y=%dx' %i)

ax.plot(x, i * x, label='$y = %ix$' % i)

ax.legend()

plt.show()

运行上面的代码后,得到的结果是:

如果把那句legend() 的语句去掉,那么图形上的图例也就会消失了。

所以legend()的主要只用就是用于在图上标明一个图例,用于说明每条曲线的文字显示。 你也可以把图例控制在左边,右边,底下等等。

实际使用中,legend()有一个loc参数,用于控制图例的位置。 比如 plot.legend(loc=2) , 这个位置就是4象项中的第二象项,也就是左上角。 loc可以为1,2,3,4 这四个数字。

原文连接:

http://30daydo.com/article/215

转载请注明出处

为什么使用dataframe自带的plot函数绘图 没有输出图像?

python • 李魔佛 发表了文章 • 0 个评论 • 8555 次浏览 • 2017-07-11 18:32

df=pd.read_csv('LoanStats_2017Q1.csv',header=0)

print df.head(10)

print df.describe()

analysis_columns = ['issue_d','term','int_rate','emp_title','grade','home_ownership','verification_status','purpose','loan_amnt','total_pymnt','out_prncp','total_rec_int','total_rec_prncp','installment','annual_inc','dti','fico_range_low','fico_range_high','last_fico_range_low','last_fico_range_high','open_acc','loan_status','delinq_amnt','acc_now_delinq','tot_coll_amt']

deal_data = df.loc[:,analysis_columns]

print deal_data

deal_data.groupby('issue_d').agg({'loan_amnt':'sum'}).plot(kind="bar")

deal_data.groupby('issue_d').agg({'issue_d':'count'}).plot(kind = 'bar')

在pycharm中程序运行完了就直接退出,没有输出任何的图像。

然后看了下源码后,需要在后面手工添加一句 plt.show()

这样就能够正常显示图像了。 查看全部

df=pd.read_csv('LoanStats_2017Q1.csv',header=0)

print df.head(10)

print df.describe()

analysis_columns = ['issue_d','term','int_rate','emp_title','grade','home_ownership','verification_status','purpose','loan_amnt','total_pymnt','out_prncp','total_rec_int','total_rec_prncp','installment','annual_inc','dti','fico_range_low','fico_range_high','last_fico_range_low','last_fico_range_high','open_acc','loan_status','delinq_amnt','acc_now_delinq','tot_coll_amt']

deal_data = df.loc[:,analysis_columns]

print deal_data

deal_data.groupby('issue_d').agg({'loan_amnt':'sum'}).plot(kind="bar")

deal_data.groupby('issue_d').agg({'issue_d':'count'}).plot(kind = 'bar')在pycharm中程序运行完了就直接退出,没有输出任何的图像。

然后看了下源码后,需要在后面手工添加一句 plt.show()

这样就能够正常显示图像了。

numpy/dataframe 中cumsum 的用法

python • 李魔佛 发表了文章 • 0 个评论 • 6893 次浏览 • 2017-07-11 17:54

例子:

x=np.arange(101)

y=x.cumsum()

print y

print len(y)

x为一个0到100的array, 那么对这个array进行cumsum操作后

y现在的值为:

[ 0 1 3 6 10 15 21 28 36 45 55 66 78 91 105

120 136 153 171 190 210 231 253 276 300 325 351 378 406 435

465 496 528 561 595 630 666 703 741 780 820 861 903 946 990

1035 1081 1128 1176 1225 1275 1326 1378 1431 1485 1540 1596 1653 1711 1770

1830 1891 1953 2016 2080 2145 2211 2278 2346 2415 2485 2556 2628 2701 2775

2850 2926 3003 3081 3160 3240 3321 3403 3486 3570 3655 3741 3828 3916 4005

4095 4186 4278 4371 4465 4560 4656 4753 4851 4950 5050]

从结果很明显看到 cumsum是将样本逐渐累加,第一个是0,第二个是0+1,第三个是0+1+2,所以第三个是3,第4个是0+1+2+3=6,如此类推,最后一个就是这101个数的累加和,5050

查看全部

例子:

x=np.arange(101)

y=x.cumsum()

print y

print len(y)

x为一个0到100的array, 那么对这个array进行cumsum操作后

y现在的值为:

[ 0 1 3 6 10 15 21 28 36 45 55 66 78 91 105

120 136 153 171 190 210 231 253 276 300 325 351 378 406 435

465 496 528 561 595 630 666 703 741 780 820 861 903 946 990

1035 1081 1128 1176 1225 1275 1326 1378 1431 1485 1540 1596 1653 1711 1770

1830 1891 1953 2016 2080 2145 2211 2278 2346 2415 2485 2556 2628 2701 2775

2850 2926 3003 3081 3160 3240 3321 3403 3486 3570 3655 3741 3828 3916 4005

4095 4186 4278 4371 4465 4560 4656 4753 4851 4950 5050]

从结果很明显看到 cumsum是将样本逐渐累加,第一个是0,第二个是0+1,第三个是0+1+2,所以第三个是3,第4个是0+1+2+3=6,如此类推,最后一个就是这101个数的累加和,5050

有道云笔记注销了某台设备后无法在该设备登录

网络 • 绫波丽 发表了文章 • 0 个评论 • 6578 次浏览 • 2017-07-06 12:29

然后拿回设备后,准备重新登录有道云笔记,结果界面一直在删除数据,接着重新登录后,会一直弹出一个信息,远程注销了给设备,需要重新登录。

最后折腾了一番后,直接把有道云笔记卸载掉,然后重新安装,重新登录,结果问题就解决了。 查看全部

然后拿回设备后,准备重新登录有道云笔记,结果界面一直在删除数据,接着重新登录后,会一直弹出一个信息,远程注销了给设备,需要重新登录。

最后折腾了一番后,直接把有道云笔记卸载掉,然后重新安装,重新登录,结果问题就解决了。

python uiautomator 安卓自动化测试

python • 再坚持一下就好了 发表了文章 • 0 个评论 • 4663 次浏览 • 2017-06-18 16:46

1. 安装uiautomator 同pip install uiautomator

时确保你的手机连上电脑后,adb可以正常使用, 在命令行运行adb devices,能够有设备的id输出

2. 获取手机的基本信息:

导入uiautomator包:

from uiautomator import device as d

这样子就可以使用d操作手机,获取手机信息。info= d.info

print info

print type(info)

for i in info:

print i,info[i]

输出的内容:

{u'displayRotation': 0, u'displaySizeDpY': 640, u'displaySizeDpX': 360, u'screenOn': False, u'currentPackageName': u'com.smartisanos.keyguard', u'productName': u'icesky_msm8992', u'displayWidth': 1080, u'sdkInt': 22, u'displayHeight': 1920, u'naturalOrientation': True}

<type 'dict'>

displayRotation 0

displaySizeDpY 640

displaySizeDpX 360

screenOn False

currentPackageName com.smartisanos.keyguard

productName icesky_msm8992

displayWidth 1080

sdkInt 22

displayHeight 1920

naturalOrientation True

手机的分辨率

displayWidth 1080

displayHeight 1920

当前打开的包名: currentPackageName com.smartisanos.keyguard

3.d.press.home()

result=d(text=u'设置').wait.exists(timeout=10000)

#单位是毫秒, 如果timeout还没有找到,就返回false

print "next"

if result:

print "You press setting"

else:

print "You don't touch any thing"

打开home主界面,然后查看时候有设置这个选项或者图标文字。

d(text=u'设置').wait.exists(timeout=10000)

如果在10s内找到这个字符,那么这一行就返回True, 否则返回False

查看全部

1. 安装uiautomator 同

pip install uiautomator

时确保你的手机连上电脑后,adb可以正常使用, 在命令行运行adb devices,能够有设备的id输出

2. 获取手机的基本信息:

导入uiautomator包:

from uiautomator import device as d

这样子就可以使用d操作手机,获取手机信息。

info= d.info

print info

print type(info)

for i in info:

print i,info[i]

输出的内容:

{u'displayRotation': 0, u'displaySizeDpY': 640, u'displaySizeDpX': 360, u'screenOn': False, u'currentPackageName': u'com.smartisanos.keyguard', u'productName': u'icesky_msm8992', u'displayWidth': 1080, u'sdkInt': 22, u'displayHeight': 1920, u'naturalOrientation': True}

<type 'dict'>

displayRotation 0

displaySizeDpY 640

displaySizeDpX 360

screenOn False

currentPackageName com.smartisanos.keyguard

productName icesky_msm8992

displayWidth 1080

sdkInt 22

displayHeight 1920

naturalOrientation True手机的分辨率

displayWidth 1080

displayHeight 1920

当前打开的包名: currentPackageName com.smartisanos.keyguard

3.

d.press.home()

result=d(text=u'设置').wait.exists(timeout=10000)

#单位是毫秒, 如果timeout还没有找到,就返回false

print "next"

if result:

print "You press setting"

else:

print "You don't touch any thing"

打开home主界面,然后查看时候有设置这个选项或者图标文字。

d(text=u'设置').wait.exists(timeout=10000)

如果在10s内找到这个字符,那么这一行就返回True, 否则返回False

为什么 2017 年 6 月 京东很多显卡断货

量化交易 • 李魔佛 发表了文章 • 0 个评论 • 3448 次浏览 • 2017-06-15 22:40

以太坊一个月内4倍,现在显卡挖以太坊,3个月以内回本。还有做什么生意比这好的吗?各路资本都涌入了,显卡自然涨价。

显卡芯片生产速度完全跟不上显卡需求增长速度,A卡更是难买。

挖以太坊优先考虑RX470、RX480、RX570、RX580,A卡买不到才用N卡。

N卡挖以太坊用GTX1060和GTX1070,GTX1050、GTX1050Ti、GTX1080、GTX1080Ti挖以太坊效率太低,不适合用。

不仅显卡涨价了,连四川水电都涨价了。以前四川有很多矿场用水电站直供电,用电价格0.2元多一点,现在四川水电价格都涨起来了。新建矿场都去新疆和云南了。

也不能说显卡完全断货,只要愿意出价高,还是能买到。

链接:https://www.zhihu.com/question ... 47044

来源:知乎

查看全部

以太坊一个月内4倍,现在显卡挖以太坊,3个月以内回本。还有做什么生意比这好的吗?各路资本都涌入了,显卡自然涨价。

显卡芯片生产速度完全跟不上显卡需求增长速度,A卡更是难买。

挖以太坊优先考虑RX470、RX480、RX570、RX580,A卡买不到才用N卡。

N卡挖以太坊用GTX1060和GTX1070,GTX1050、GTX1050Ti、GTX1080、GTX1080Ti挖以太坊效率太低,不适合用。

不仅显卡涨价了,连四川水电都涨价了。以前四川有很多矿场用水电站直供电,用电价格0.2元多一点,现在四川水电价格都涨起来了。新建矿场都去新疆和云南了。

也不能说显卡完全断货,只要愿意出价高,还是能买到。

链接:https://www.zhihu.com/question ... 47044

来源:知乎

dataframe读取excel文件第一行是列名如何跳过

python • 李魔佛 发表了文章 • 0 个评论 • 13393 次浏览 • 2017-06-13 01:15

股票代码 股票简称 涨跌幅(%) 现价(元) 收盘价:前复权(元) 区间涨跌幅:前复权(%) 交易状态

2016.07.13 2016.07.13 2016.07.13

300501.SZ 海顺新材 10.00 144.65 131.50 3.06 交易

300384.SZ 三联虹普 -0.67 57.63 58.02 5.97 交易

300506.SZ 名家汇 5.98 60.98 57.54 5.52 交易

002572.SZ 索菲亚 1.03 56.80 56.22 -0.65 交易

600419.SH 天润乳业 4.66 57.10 54.56 0.06 交易

300494.SZ 盛天网络 4.86 54.19 51.68 2.64 交易

300369.SZ 绿盟科技 2.36 45.50 44.45 -0.96 交易

002113.SZ 天润数娱 -1.89 43.55 44.39 7.14 交易

002190.SZ 成飞集成 10.01 47.17 42.88 10.01 交易

600391.SH 成发科技 3.39 43.56 42.13 1.54 交易

002699.SZ 美盛文化 3.25 40.99 39.70 9.97 交易

603027.SH 千禾味业 3.70 40.39 38.95 -1.77 交易

600893.SH 中航动力 2.03 39.29 38.51 0.44 交易

603005.SH 晶方科技 4.34 40.16 38.49 2.89 交易

300339.SZ 润和软件 2.50 36.98 36.08 1.32 交易

300246.SZ 宝莱特 3.92 37.42 36.01 -0.91 交易

002368.SZ 太极股份 4.23 37.50 35.98 1.75 交易

000555.SZ 神州信息 0.35 34.66 34.54 -0.75 交易

002745.SZ 木林森 9.15 37.10 33.99 -0.23 交易

002589.SZ 瑞康医药 -1.49 33.00 33.50 4.82 交易

002007.SZ 华兰生物 3.31 33.36 32.29 -0.89 交易

002456.SZ 欧菲光 0.32 31.60 31.50 7.88 交易

002759.SZ 天际股份 9.99 34.01 30.92 0.00 重大事项,停牌自2016-07-12起连续停牌

那么怎样不把第一行的数据读入呢? 或者说把第一行的数据给忽略掉呢?

sheet1 = pd.read_excel('test.xls', header=0, skiprows=[0] )

原文链接:http://30daydo.com/article/209

欢迎转载,转载请注明出处。 查看全部

股票代码 股票简称 涨跌幅(%) 现价(元) 收盘价:前复权(元) 区间涨跌幅:前复权(%) 交易状态

2016.07.13 2016.07.13 2016.07.13

300501.SZ 海顺新材 10.00 144.65 131.50 3.06 交易

300384.SZ 三联虹普 -0.67 57.63 58.02 5.97 交易

300506.SZ 名家汇 5.98 60.98 57.54 5.52 交易

002572.SZ 索菲亚 1.03 56.80 56.22 -0.65 交易

600419.SH 天润乳业 4.66 57.10 54.56 0.06 交易

300494.SZ 盛天网络 4.86 54.19 51.68 2.64 交易

300369.SZ 绿盟科技 2.36 45.50 44.45 -0.96 交易

002113.SZ 天润数娱 -1.89 43.55 44.39 7.14 交易

002190.SZ 成飞集成 10.01 47.17 42.88 10.01 交易

600391.SH 成发科技 3.39 43.56 42.13 1.54 交易

002699.SZ 美盛文化 3.25 40.99 39.70 9.97 交易

603027.SH 千禾味业 3.70 40.39 38.95 -1.77 交易

600893.SH 中航动力 2.03 39.29 38.51 0.44 交易

603005.SH 晶方科技 4.34 40.16 38.49 2.89 交易

300339.SZ 润和软件 2.50 36.98 36.08 1.32 交易

300246.SZ 宝莱特 3.92 37.42 36.01 -0.91 交易

002368.SZ 太极股份 4.23 37.50 35.98 1.75 交易

000555.SZ 神州信息 0.35 34.66 34.54 -0.75 交易

002745.SZ 木林森 9.15 37.10 33.99 -0.23 交易

002589.SZ 瑞康医药 -1.49 33.00 33.50 4.82 交易

002007.SZ 华兰生物 3.31 33.36 32.29 -0.89 交易

002456.SZ 欧菲光 0.32 31.60 31.50 7.88 交易

002759.SZ 天际股份 9.99 34.01 30.92 0.00 重大事项,停牌自2016-07-12起连续停牌

那么怎样不把第一行的数据读入呢? 或者说把第一行的数据给忽略掉呢?

sheet1 = pd.read_excel('test.xls', header=0, skiprows=[0] ) 原文链接:http://30daydo.com/article/209

欢迎转载,转载请注明出处。

请教您,为什么把您的语句用来出错了?

python • 苦竹居士 回复了问题 • 2 人关注 • 2 个回复 • 4760 次浏览 • 2017-06-04 23:02

pycharm当前使用的换行是windows模式还是mac OSX模式 ?

Linux • 李魔佛 发表了文章 • 0 个评论 • 8986 次浏览 • 2017-05-31 11:40

在pycharm的右下角,有一个状态栏,上面显示

如果显示的是: CRLF,说明当前文档用的是windows的换行,占用的是2个字符 \n\r

而对于Mac OSX 系统,显示的则是CR, 换行则是 \r

而Linux下的换行,显示的是LR, 字符为\n 查看全部

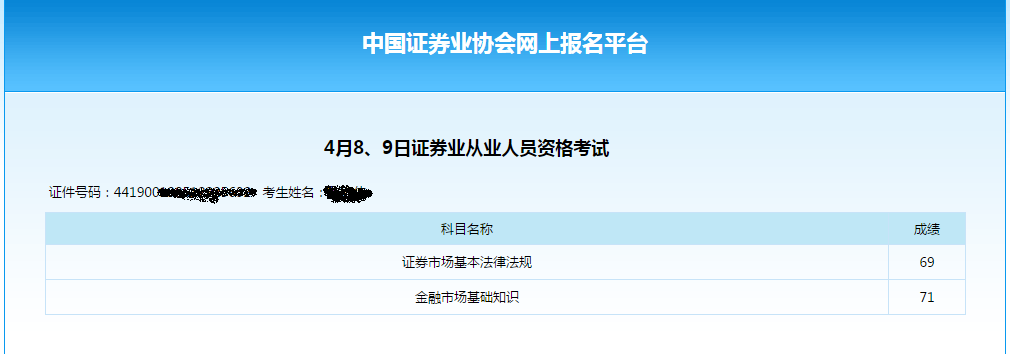

30天获取证券从业资格证和基金从业资格证

30天新尝试 • 绫波丽 发表了文章 • 0 个评论 • 4542 次浏览 • 2017-05-31 10:58

证券从业资格考试

基金从业资格考试

这两门都是从业考试,所以难度不会太大。只要你能够大概把书翻一遍,或者看网上的视频教程,然后刷下题库,正常来说,通过是没问题的。

(网上说基金从业的基础知识通过率才30%都不到。这也让我觉得不可思议,怀疑不少人是去裸考的吧)

这里只是想跟大家分享一下30天内让自己完成一个时间的一个心理过程和行为过程。

首先要强迫自己去做,那么就让自己投入一些沉没成本。

报考证券从业资格和基金从业资格这两门考试,每一门需要120块的考试费用,考试费用交了后,无论你去不去考试钱都没得退回来。 因为前期投入了金钱,后期心里就不甘心让自己钱打水漂了,学习的动力会更加充足。

对于能够见得着的金钱成本,很多人都很精明,能够看得到,且能够量化到具体数额。

可是,平时我们投入的时间成本,有多少人能够精确的量化出来? 计划了3个月内学会一门语言,制定了相应的学习计划,然后执行了3周后, 因为各种原因,比如公司年会准备,周末team building等,让你的学习计划中断了。 而后,因为年会或者team building之后身体太累,你就把学习新语言的计划往后挪。就是因为这一挪,破坏了你的计划的连贯性,而且,有了第一次,肯定就会有第二次,第三次。 最后很可能的结果就是没能在3个月完成你学会一门新语言的计划。

在这里,你能够算出你因为前期投入的时间,而沉没的成本吗?

所以,换一本漂亮昂贵的日记本,买一套好的运动服,你坚持写日记,跑步的动力就会比随意拿个本子或穿件山寨耐克要充足好多。

当然,上面是对那些本来计划容易被随意打断的人而言。 对于那些自律成魔的人, 或者兴趣爱好所致,一般不需要像上面说的那样强制自己投入大量沉没成本。 查看全部

证券从业资格考试

基金从业资格考试

这两门都是从业考试,所以难度不会太大。只要你能够大概把书翻一遍,或者看网上的视频教程,然后刷下题库,正常来说,通过是没问题的。

(网上说基金从业的基础知识通过率才30%都不到。这也让我觉得不可思议,怀疑不少人是去裸考的吧)

这里只是想跟大家分享一下30天内让自己完成一个时间的一个心理过程和行为过程。

首先要强迫自己去做,那么就让自己投入一些沉没成本。

报考证券从业资格和基金从业资格这两门考试,每一门需要120块的考试费用,考试费用交了后,无论你去不去考试钱都没得退回来。 因为前期投入了金钱,后期心里就不甘心让自己钱打水漂了,学习的动力会更加充足。

对于能够见得着的金钱成本,很多人都很精明,能够看得到,且能够量化到具体数额。

可是,平时我们投入的时间成本,有多少人能够精确的量化出来? 计划了3个月内学会一门语言,制定了相应的学习计划,然后执行了3周后, 因为各种原因,比如公司年会准备,周末team building等,让你的学习计划中断了。 而后,因为年会或者team building之后身体太累,你就把学习新语言的计划往后挪。就是因为这一挪,破坏了你的计划的连贯性,而且,有了第一次,肯定就会有第二次,第三次。 最后很可能的结果就是没能在3个月完成你学会一门新语言的计划。

在这里,你能够算出你因为前期投入的时间,而沉没的成本吗?

所以,换一本漂亮昂贵的日记本,买一套好的运动服,你坚持写日记,跑步的动力就会比随意拿个本子或穿件山寨耐克要充足好多。

当然,上面是对那些本来计划容易被随意打断的人而言。 对于那些自律成魔的人, 或者兴趣爱好所致,一般不需要像上面说的那样强制自己投入大量沉没成本。

比特币居然在25号那天突破过30000!

量化交易 • 李魔佛 发表了文章 • 0 个评论 • 3180 次浏览 • 2017-05-31 07:39